Softmax函数介绍

发布时间:2024年01月21日

Softmax函数是一种常用的激活函数,用于将一组实数值转换为概率分布。它常用于多类别分类问题中,将输入向量映射为各个类别的概率。

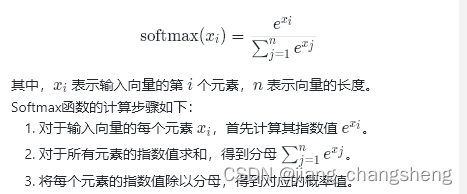

Softmax函数的公式如下:

其中,示输入向量的第?�i?个元素,�n?表示向量的长度。

Softmax函数的计算步骤如下:

- 对于输入向量的每个元素,首先计算其指数值?

- 对于所有元素的指数值求和,得到分母?

- 将每个元素的指数值除以分母,得到对应的概率值。

Softmax函数的输出是一个概率分布,其中每个元素代表对应类别的概率。由于Softmax函数的性质,输出的概率值总和为1,且每个概率值介于0和1之间。

Softmax函数在多类别分类问题中的应用非常广泛。在训练神经网络时,通常将Softmax函数应用于网络的最后一层,将网络的输出转换为类别概率。然后,可以使用交叉熵损失函数来比较预测概率分布与真实标签之间的差异,从而进行模型的训练和优化。

当使用Python和PyTorch来实现Softmax函数时,可以使用PyTorch提供的torch.nn.functional模块中的softmax函数来实现。下面是一个详细的代码示例:

import torch

import torch.nn.functional as F

# 定义输入向量

input_vector = torch.tensor([2.0, 1.0, 0.5])

# 使用softmax函数进行转换

output_probs = F.softmax(input_vector, dim=0)

print(output_probs)在这个示例中,我们首先导入了torch和torch.nn.functional模块。然后,我们定义了一个输入向量input_vector,它包含了3个元素。

接下来,我们使用F.softmax函数对input_vector进行Softmax转换。dim=0参数指定了在哪个维度上进行Softmax计算。在本例中,我们将在维度0上进行Softmax计算,即对输入向量的每个元素进行Softmax。

最后,我们打印输出的概率分布output_probs,它包含了Softmax函数计算后得到的每个类别的概率。

这个示例展示了如何使用PyTorch中的函数来实现Softmax函数。可以根据自己的需求进行修改和扩展。

文章来源:https://blog.csdn.net/jiang_changsheng/article/details/135717392

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- ME8206 电流模式准谐振 PWM 控制器 输出功率可达100W

- Jenkins安装及使用

- OJ刷题 第十七篇()

- 从头开始的head

- 前端开发_JavaScript基础

- 基于SpringBoot的计算机学习系统

- matlab|基于VMD-SSA-LSTM的多维时序光伏功率预测

- 实现高效、透明、公正的采购寻源——鸿鹄电子招投标系统

- linux环境下实现fbx、stp、glb、ifc转obj以及Java转换思路

- 202401读书笔记|《诗酒趁年华:苏轼传》——竹杖芒鞋轻胜马,谁怕,一蓑烟雨任平生