开源项目汇总:机器学习前沿探索 | 开源专题 No.60

发布时间:2024年01月15日

facebookresearch/xformers

Stars: 6.0k License: NOASSERTION

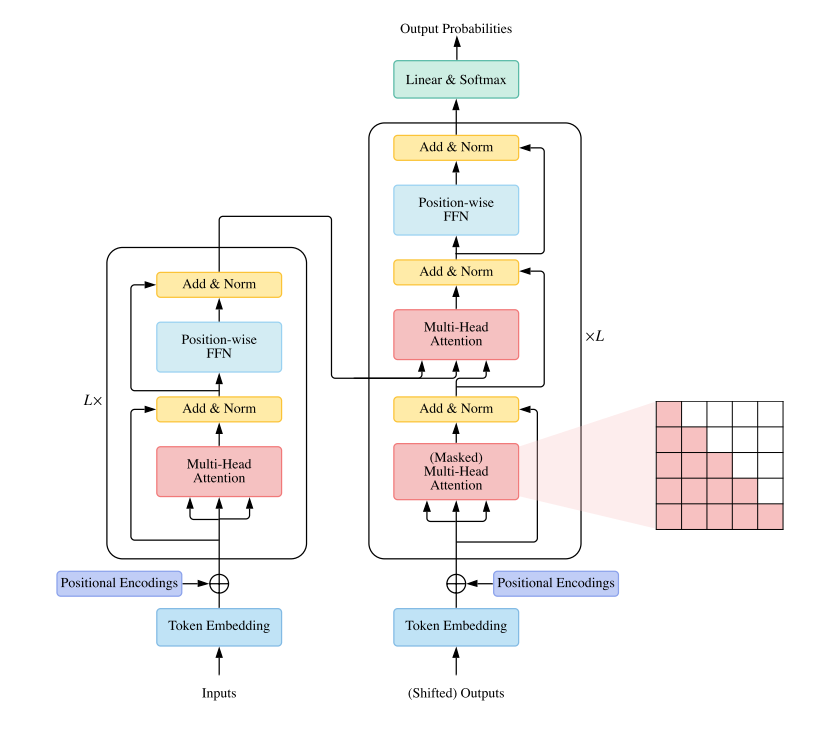

xFormers 是一个加速 Transformer 研究的工具包,主要功能如下:

- 可自定义构建模块:无需样板代码即可使用的独立/可定制化构建模块。这些组件与领域无关,被视觉、NLP 等领域的研究人员广泛使用。

- 以研究为先导:xFormers 包含在 pytorch 等主流库中还不可用的尖端组件。

- 注重效率:因为迭代速度很重要,所以组件尽可能快速和内存高效。xFormers 包含了自己的 CUDA 核心,并在相关时候调用其他库。

google-research/tuning_playbook

Stars: 22.9k License: NOASSERTION

Deep Learning Tuning Playbook 是一个旨在帮助工程师和研究人员最大化深度学习模型性能的项目。该项目提供了一系列指导,重点关注超参数调优过程,并涵盖了其他与深度学习训练相关的重要问题。其核心优势和主要功能包括:

- 提供选择合适模型架构、优化器和批次大小等方面的指南。

- 强调科学方法来改进模型性能。

- 探索与开发之间权衡 (exploration vs exploitation) 以及确定下一轮实验目标时需要考虑的因素。

- 设计下一轮实验并决定是否采用训练流水线变更或超参数配置变更。

huggingface/transformers

Stars: 113.5k License: Apache-2.0

这个项目是一个名为 Transformers 的开源机器学习项目,它提供了数千种预训练模型,用于在文本、视觉和音频等不同领域执行任务。该项目主要功能包括:

- 文本处理:支持超过 100 种语言的文本分类、信息抽取、问答、摘要生成和翻译等任务。

- 图像处理:支持图像分类、目标检测和分割等任务。

- 音频处理:支持语音识别和音频分类等任务。

此外,Transformer 模型还可以对多个领域进行联合操作,例如表格问答、光学字符识别以及从扫描文件中提取信息等。该项目具有以下关键特点和核心优势:

- 提供 API 快速下载并使用预训练模型,可根据自己的数据集进行微调,并与社区共享。

- 支持 Jax,PyTorch 和 TensorFlow 三大流行深度学习库之间无缝集成,在加载推理前轻松地训练您的模型。

stas00/ml-engineering

Stars: 1.0k License: CC-BY-SA-4.0

这个项目是一个开放的方法论集合,旨在帮助成功训练大型语言模型和多模态模型。

- 提供了调试软件和硬件故障、容错性、性能优化等方面的指导

- 支持多节点网络通信和模型并行计算

- 包含有关张量精度/数据类型、训练超参数和初始化以及可重现性等内容的信息

facebookresearch/detectron2

Stars: 26.4k License: Apache-2.0

Detectron2 是 Facebook AI Research 的下一代库,提供了最先进的检测和分割算法。它是 Detectron 和 maskrcnn-benchmark 的继任者,在 Facebook 中支持许多计算机视觉研究项目和生产应用程序。

- 包括全景分割、Densepose、级联 R-CNN、旋转边界框等新功能

- 作为一个库来支持构建在其之上的研究项目

- 模型可以导出到 TorchScript 格式或 Caffe2 格式进行部署

- 训练速度更快

mlflow/mlflow

Stars: 15.4k License: Apache-2.0

MLflow 是一个机器学习生命周期平台,主要功能包括跟踪实验、将代码打包成可复现的运行环境以及分享和部署模型。其核心优势和特点如下:

- MLflow Tracking:记录参数、代码和结果,并提供交互式 UI 进行比较。

- MLflow Projects:使用 Conda 和 Docker 对代码进行打包,实现可复现性,并与他人共享。

- MLflow Models:提供模型打包格式和工具,可以轻松地在批处理和实时评分等平台上部署相同的模型 (来自任何机器学习库)。

- MLflow Model Registry:集中管理 ML 流程中完整生命周期所需的模型存储、APIs 和用户界面。

文章来源:https://blog.csdn.net/osguider/article/details/135592295

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Django 图片上传与下载

- 深入理解通用的HTTP POST请求发送方法

- C语言入门到精通之练习十九:一个数如果恰好等于它的因子之和,这个数就称为“完数“。例如6=1+2+3.编程找出1000以内的所有完数。

- 【模拟电路】模拟集成电路之神-NE555

- java 图片水印、压缩图片、宽和高等比缩放的率

- vue3用户权限管理(路由控制等)

- 使用 GBASE南大通用GBase 8s数据库服务器来备份和记录日志

- Windows环境检验NodeJs安装是否成功

- 低功耗全功能蓝牙5.1与2.4GHz私有协议的双模无线连接芯片OM6621FB 无线键鼠应用领域

- stable diffusion 基础教程-图生图