2万字揭秘阿里巴巴数据治理平台建设经验(下),附推荐系统完整源码

原文链接

六、数据成本治理

最后终于讲到了成本治理,其实如果有仔细看前面几个场景的实践的话,会发现多多少少也有很多成本治理的事情或者效果在里面。就像我们在前面梳理企业大数据发展阶段的时候说过,降本的需求往往在成熟阶段产生,并且同时包含了前面几个阶段需要做的事情,企业在有降本需求的时候,不妨可以先回顾下前面几个阶段,我们是否做的足够充分,例如当前的成本高企,或许是因为第一阶段堆叠了过多的人肉,又或许是因为第二阶段各种人员无序使用资源。

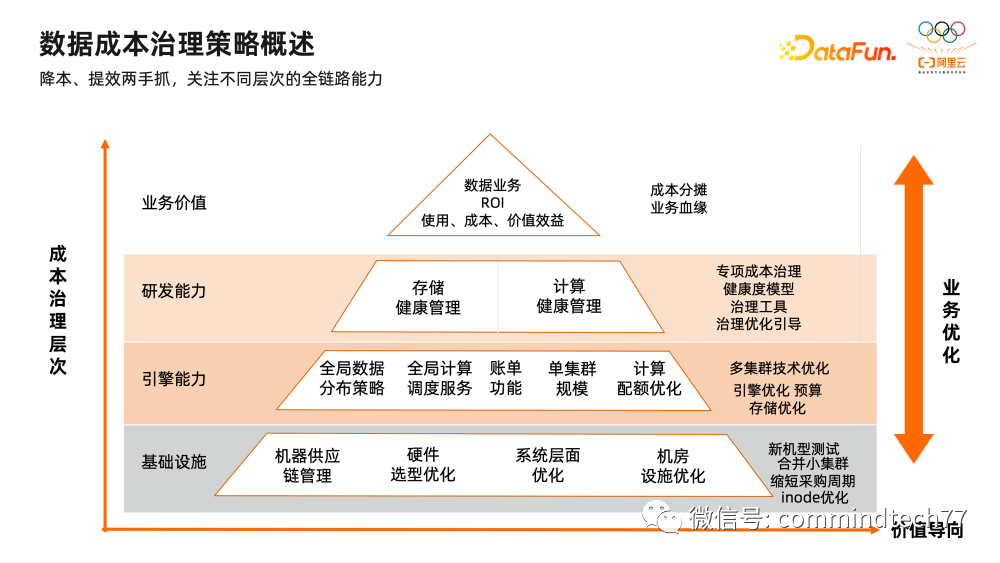

从我们的观点来看,成本治理的方案核心主要包含了以下三个部分。

-

治技合一

这里的“技”包含了技术平台与技术人员,成本治理的目标绝不仅仅是下线几台机器,通用技术平台的构建至关重要。例如DataWorks这种工具型产品,主要是服务技术人员,提升工作效率。这里的“降本”,可以把它等同于“提效”,让1个人能做更多的工作,也是降本的一种方式。关于成本治理的理念、方法、流程,我们都通过产品技术平台的方式内置,将用户关注的各项维度的治理方法流程化提供,在研发同学完成数据开发的过程时,就完成了数据治理,并且能提升各个环节参与治理的研发同学的治理技能与治理效率。所以,我们的治理一定要沉淀成企业通用的技术资产,从而提升技术人员的治理能力与效率,达到治技合一。

-

全链路数据治理

基于平台之上,我们构建全链路的数据治理能力,从数据生产到数据消费的每个环节,我们都会针对每个环节的具体问题进行相应维度、相应问题项的定义,完成针对性的成本治理优化。每个链路上微小的优化,才能实现整体成本的不断降低。

-

组织设计与常态运营

最后我们需要各类组织架构、规章制度、运营活动来不断推动数据治理工作在内部落地。在阿里巴巴内部,我们常用存储健康分、计算健康分等指标,发起集团各团队数据治理战役,围绕健康分为核心指标,推动人做数据治理和管理。大家在各类培训、比武中,不断展示、学习各类不同的数据治理场景,让我们的数据治理工作可量化,持续化进行。

成本治理策略分析

成本治理大的目的都是推动以“更低成本”换取“更高”的最终业务价值。这里的成本同时包含了人与机器,这也是我们一直在强调的成本治理不要仅仅关注机器的成本,例如我们用3个人,能完成原本5个人的工作,这种提效也是一种降本的形态。回到技术人员关心的具体要做的事情上,成本治理的策略主要可以关注三个层面,

-

基础设施

主要指传统的机房形式,涉及硬件的采购、选型、优化等等,这里大部分工作一般由阿里云负责,不需要我们投入太多精力。

-

引擎能力

主要涉及存储与计算能力的优化,例如提高存储的效率,压缩比,提高单位计算的能力,提高分布式调度的能力等等。

-

平台能力

主要涉及工具平台,例如高效地进行数据开发,将各类治理策略平台化,快速发现、解决、量化各类数据治理的问题。

这些动作最终是为了实现我们成本治理的业务价值,例如整体集团节省了多少成本,某个事业部达成了多少的降本目标,某个业务板块的ROI等等,接下来,我们将重点针对引擎能力和平台能力做详细的介绍。

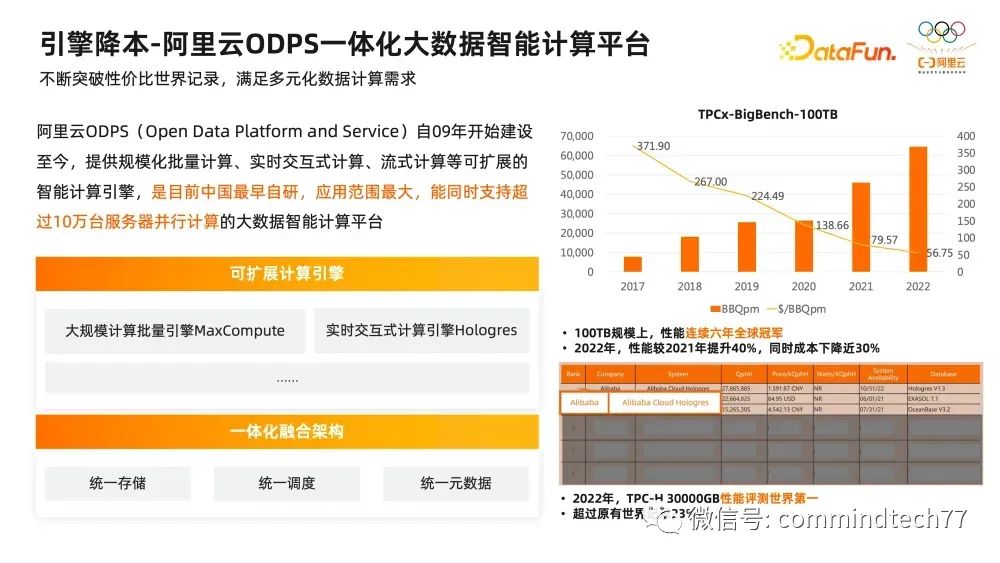

引擎降本-MaxCompute&Hologres

首先我们提到对于引擎侧的降本,是要向核心技术要红利。DataWorks在阿里巴巴集团结合阿里云ODPS一体化大数据智能计算平台能力,不断突破性价比世界记录,满足多元化数据计算需求。阿里云ODPS(OpenData Platform and Service)自2009年开始建设至今,提供规模化批量计算、实时交互式计算、流式计算等可扩展的智能计算引擎,是目前中国最早自研,应用范围最大,能同时支持超过10万台服务器并行计算的大数据智能计算平台。其中大规模计算批量引擎MaxCompute在TPCx-BigBench-100TB测试中,连续6年稳定全球冠军,2022年,MaxCompute评测结果性能较2021年提升40%,同时成本下降近30%。实时交互式计算引擎Hologres在2022年TPC-H 30000GB性能评测中,获得世界第一,超过原世界记录23%。

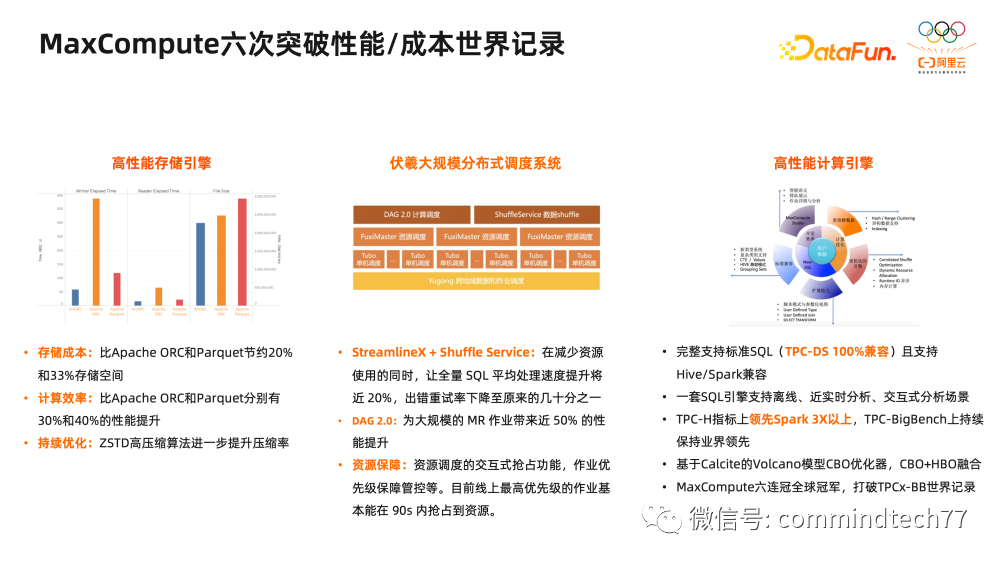

这些记录背后是ODPS持续13年深耕自研技术的成果,ODPS-MaxCompute基于盘古存储,提供高性能的存储引擎,存储成本比Apache ORC和Parquet节约20%和33%存储空间,计算效率对比Apache ORC和Parquet分别有30%和40%的性能提升。伏羲大规模分布式调度系统在全区域数据排布、去中心化调度、在线离线混合部署、动态计算等方面全方位满足新业务场景下的调度需求,在单日任务量千万级、单日计算量EB级的压力下,保障了基线全部按时产出。强大的高性能SQL计算引擎完整支持标准SQL(TPC-DS 100%兼容)且支持Hive/Spark兼容,一套SQL引擎支持离线、近实时分析、交互式分析场景,TPC-H指标上领先Spark 3X以上。ODPS-MaxCompute连续六次突破性能/成本世界记录,也是释放云上技术红利的最佳诠释之一。

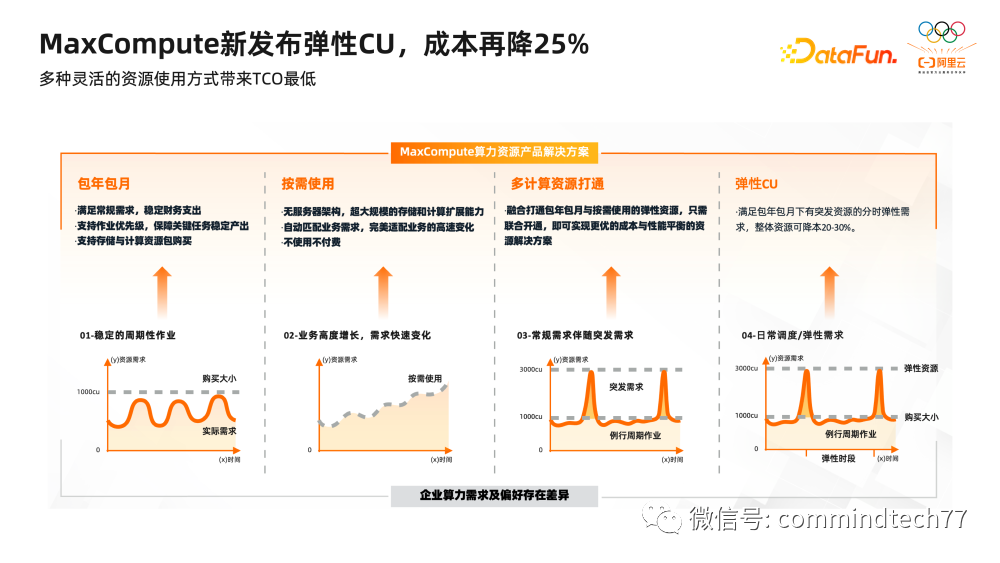

ODPS-MaxCompute在2022年全新发布了弹性CU能力,在过去预留 CU 的基础上,可以设置不同的弹性策略,选择指定时间段的弹性规格。一方面降低使用成本,避免过去为了高峰期的执行效率,预留较多 CU,在低峰期浪费资源的情况,通过弹性实现削峰填谷。例如原先为了保障资源稳定性,购买100CU包年包月资源,但是这100CU使用效率是不一样的,凌晨高峰期使用率高,白天使用率低,资源有一定浪费。弹性CU的方式可以购买更多的分时弹性CU资源,例如高峰期300CU,低峰期50CU,实现资源的弹性分配。基于原先按量付费以及包年包月形式,ODPS-MaxCompute弹性CU可以让整体成本再降低25%,多种灵活的资源使用方式带来TCO的最低。

在传统的数据架构中,分为离线、实时、在线三种链路。

通过如Hive,Spark,MaxCompute等离线加工引擎处理大规模数据

通过如Flink、Spark Streaming等流式加工技术来实现计算前置,并将计算结果保存在HBase、Redis等系统提供快速访问

通过Clickhouse、Druid等实时系统,计算规模不如离线,但交互式分析能力比离线统计更灵活,支持数据的实时写入,以数据接近源时的状态直接灵活分析。这种纷繁芜杂的复杂架构带来的是极高的维护成本与技术成本。

这三种链路对应不同的技术架构及存储引擎,数据产生了割裂,割裂之后还需要补充联邦查询技术,对外提供一个统一的查询入口,但是数据散布在不同的系统里面,也许可以解决统一数据界面的问题,但性能和一致性很难保证,性能上联邦查询是和最慢的执行过程对齐,一致性上一个源头多条链路,加工逻辑很难保证处处一致,日常数据偏差和核对工作量很大。

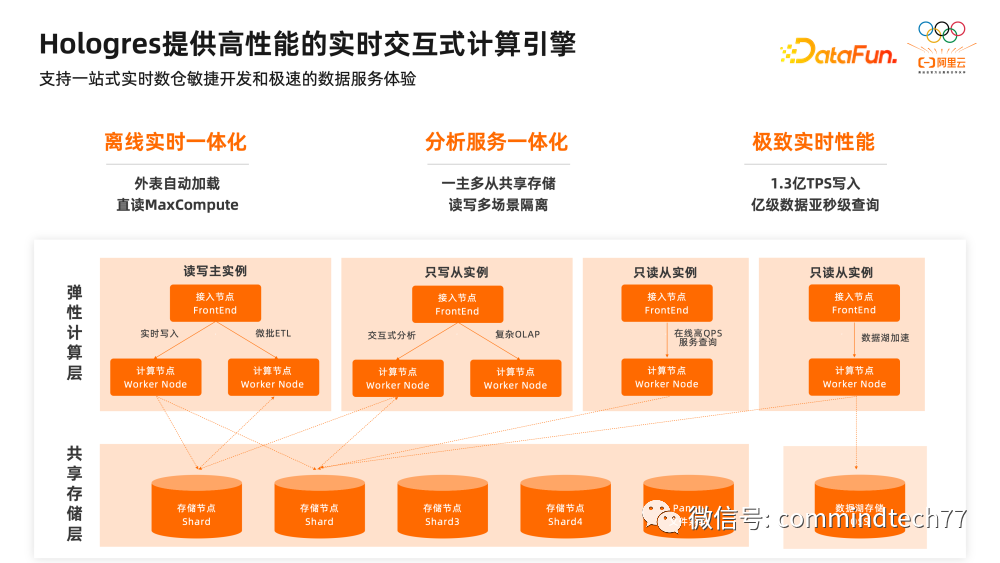

ODPS-Hologres提供高性能的实时交互式计算引擎,基于一站式实时数仓的HSAP(Hybrid Serving & Analytical Processing,分析服务一体化)理念,同时满足OLAP分析、点查、交互式查询等多种实时需求。

-

在离线方面,通过统一存储,统一调度、统一元数据、和MaxCompute无缝打通,数据无需导出至Hologres,实现离线实时一体化架构。

-

在实时与在线部分,Hologres在存储层,既支持批量数据的导入,也支持在线的实时写入与更新,不管是离线的数据还是实时的数据都可以存储在一个系统,在服务层,支持多种负载,保证了高性能的在线点查应用,也支持灵活的多维分析,提供统一数据服务层,减少数据割裂。

通过这种全新的方式,Hologres将传统的离线、实时、在线三种链路进行最大的简化,通过1.3亿TPS写入,亿级数据亚秒级查询,打破TPC-H世界记录的极致性能,实现成本与性能的平衡。

2022年,Hologres发布一主多从的模式,通过共享存储再次降低实时数仓的成本,共享存储实时高可用,多Region部署数据自动复制,秒级灾备,当指定一个实例是写实例时,其他实例就是读实例,当写实例写好之后,其他实例实时可见做到了数据一致性。并且弹性计算层的实例实现物理隔离,当写入实例宕机后,不会影响只读实例。

▌小结

引擎降本核心是向技术要红利,不断突破技术的极限。阿里云ODPS(OpenData Platform and Service)自2009年开始建设至今,提供规模化批量计算、实时交互式计算、流式计算等可扩展的智能计算引擎,是目前中国最早自研,应用范围最大,能同时支持超过10万台服务器并行计算的大数据智能计算平台。

平台降本-DataWorks数据治理中心

有了良好的基础设施和引擎体系,再往研发平台和研发过程走一层,就是面向我们的成本治理目标的治理策略的落地,其实就是围绕着我们实际多角色、多业务、持续增长的数据需求带来的数据治理工作了。

-

业务高速增长往往配套着计算存储成本的增长,而当面对计算存储的扩容需求时,数据治理组、业务数据治理组、财务等多个团队,需要有一个通用的衡量标准,来判断是否是满足正常业务需求增长所需的资源消耗,还是存在大量资源使用不合理和浪费现象。

-

而对于技术团队来说,如果要进行面向成本领域的数据治理工作,那到底是业务领域的研发团队需要重点投入,哪些团队来负责治理效果,具体落实治理动作的责任人是谁,通过哪些措施和动作真正最大程度地提升了治理效果,获取了更高的业务ROI,这也需要有一个衡量标准来定义治理的效果。

DataWorks数据治理中心提供了数据治理的量化评估、数据治理问题自动发现和预防,数据治理问题快速处理等能力,将书面的数据治理规范落地成平台化的产品能力,让数据治理不再一个 “阶段性项目”,而是一个“可持续的运营项目”。

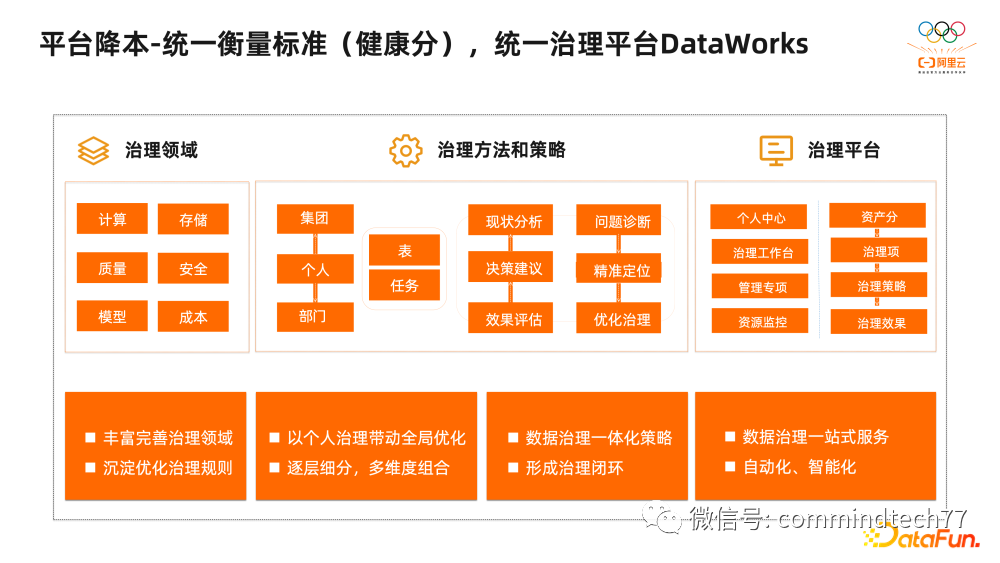

在阿里巴巴内部,我们做数据治理的时候,经常会参考一个健康分的概念。对于某个BU来说,比如我们今年的目标之一,就是把健康分从60分干到80分。健康分涉及的治理领域有计算、存储、研发、质量、安全等各个方面,围绕这些领域会形成具体的治理策略与方法,这些策略和方法有些事集团统一的规定,有些是部门基于自己的业务情况自己制定的,但基本也都是围绕分析、诊断、定位、优化、评估、建议等流程来进行。

这里面如果涉及产品化的需求就会提给DataWorks团队,例如治理中心、治理工作台、健康分等等。大家一起共同建设治理平台,DataWorks上很多数据治理的能力,也离不开我们这么多兄弟团队给我们提供的建议。围绕健康分这种考核指标,各个团队就会有一个统一的衡量标准,大家可以往一个目标共同努力,从组织层面,这也是健康分非常重要的价值。

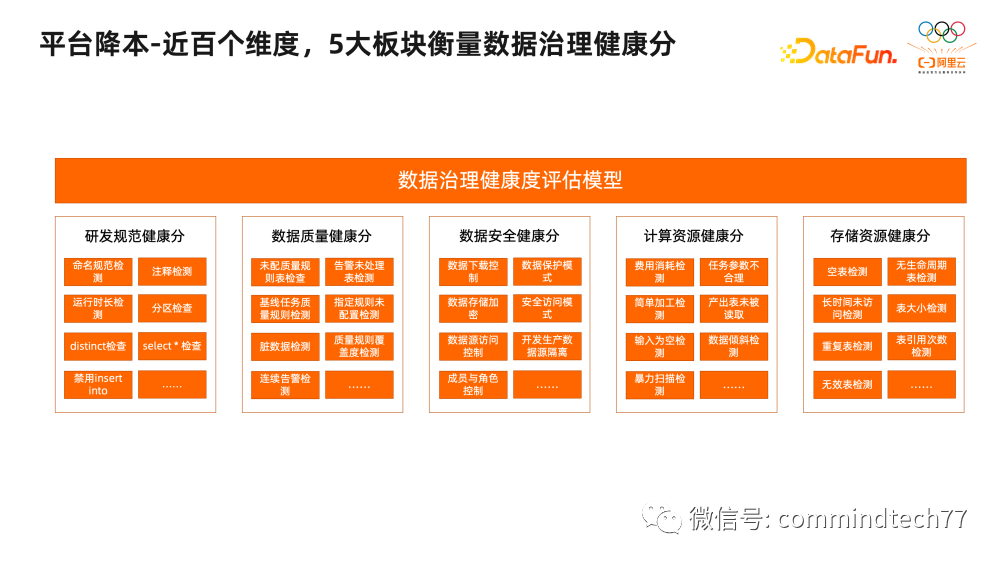

DataWorks数据治理中心的健康分是依据数据资产在数据生产、数据流通及数据管理中的用户行为、数据特性、任务性质等元数据,用数据处理及机器学习等技术,对各类型数据进行综合处理和评估,在个人、工作空间的维度客观呈现数据资产状态的综合分值。健康分体系,以元数据建设为依托,建设集“存储、计算、研发、质量和安全”的五大健康度领域,构建“存储健康分、计算健康分、研发健康分、质量健康分和安全健康分”五大健康分指标。

健康分的分值范围为0至100,分值越大代表数据资产的健康度越好,较高的健康度可以帮助用户更放心、更高效、更稳定的使用数据,保障数据生产和业务运转。

。。。。。。。。。。更多内容,关注WX公众号,点击原文链接:

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!