数据采集:获取有价值信息的关键步骤

在当今数据驱动的时代,数据已成为企业、组织和个人做出明智决策的重要依据。而数据采集作为数据分析和应用的第一步,其重要性不言而喻。本文将探讨数据采集的概念意义、方法工具、面临的挑战和应对策略以及注意事项。

一、数据采集的定义和重要性

(一)定义

数据采集是指从各种来源收集数据,并将其转换为可用格式的过程。这些数据可以来自于传感器、互联网、数据库、文件等多种渠道。通过数据采集,我们能够获取有关市场趋势、用户行为、产品性能等方面的信息,为后续的数据分析和决策提供支持。

(二)重要性

1、决策支持

数据采集可以为企业和组织提供决策支持。通过对采集到的数据进行分析,可以了解市场需求、客户行为、产品性能等信息,从而制定更加科学合理的决策。

2、优化业务流程

数据采集可以帮助企业和组织优化业务流程。通过对业务流程中的数据进行采集和分析,可以发现流程中的瓶颈和问题,从而进行优化和改进。

3、提高竞争力

数据采集可以帮助企业和组织提高竞争力。通过对竞争对手的数据进行采集和分析,可以了解竞争对手的优势和劣势,从而制定更加有效的竞争策略。

二、数据采集的方法和工具

(一)数据采集的方法

数据采集是从各种来源获取数据的过程,它是数据分析和应用的基础。以下是一些常见的数据采集方法:

1、手动输入:通过人工输入数据到电子表格或数据库中。这种方法适用于小规模数据采集,但可能存在输入错误的风险。

2、网络爬虫:使用编程语言编写的脚本或工具,从互联网上自动抓取数据。网络爬虫可以爬取网站的结构和内容,提取出有用的数据。

3、API 调用:利用应用程序编程接口(API)从第三方平台获取数据。许多在线服务提供 API,允许开发者获取其平台上的数据。

4、传感器:利用物理传感器来收集数据,如温度传感器、湿度传感器、压力传感器等。这些传感器可以将物理量转换为电信号,并将其传输到数据采集设备。

5、调查问卷:通过在线或离线方式发放调查问卷,收集用户的反馈和意见。调查问卷可以帮助企业了解客户需求、市场趋势等信息。

6、数据库查询:从现有的数据库中提取数据,例如企业内部的数据库、公共数据库等。这种方法需要对数据库结构和查询语言有一定的了解。

7、合作伙伴数据共享:与合作伙伴进行数据交换或共享,以获取更多的数据资源。这种方法需要建立合作关系并确保数据的合法性和安全性。

(二)数据采集的工具

在进行数据采集的过程中,使用适当的工具可以提高效率和准确性。以下是一些常用的数据采集工具:

1、网络爬虫:网络爬虫是一种自动从网站获取数据的工具。它可以按照预设的规则和算法,遍历网站的页面,提取需要的数据。网络爬虫常用于数据挖掘、搜索引擎优化等领域。

2、API接口工具:API(应用程序编程接口)是一种允许不同应用程序之间进行数据交换的接口。许多网站和服务提供 API,使得开发者可以通过编程方式获取数据。例如,社交媒体平台通常提供 API 来获取用户数据、帖子等信息。

3、数据抓取软件:数据抓取软件是专门用于从网站或其他数据源提取数据的工具。它们通常提供用户友好的界面和功能,例如自动化抓取、数据筛选和导出等。一些常用的数据抓取软件包括 Web Harvy、Octoparse 和 Parse Hub 等。

4、数据库管理系统(DBMS):DBMS 是用于存储、管理和查询数据的软件系统。常见的 DBMS 包括 MySQL、Oracle、SQL Server 等。通过使用 SQL(结构化查询语言),可以从数据库中获取所需的数据。

5、数据可视化工具:数据可视化工具用于将数据以图形化的方式呈现,帮助用户更好地理解和分析数据。常见的数据可视化工具包括 Tableau、PowerBI 和 QlikView 等。这些工具通常提供各种图表、图形和交互式界面,使用户能够直观地探索和分析数据。

6、数据采集设备:对于物理世界的数据采集,可能需要使用特定的设备。例如,传感器可以用于采集温度、湿度、光照等环境数据;RFID(射频识别)标签和读写器可以用于追踪物体的位置和状态;GPS(全球定位系统)设备可以用于采集地理位置数据。

三、数据采集的挑战和应对策略

(一)数据采集的挑战

1、数据质量

数据质量是数据采集的关键。低质量的数据可能导致错误的决策。因此,企业和组织需要采取措施确保数据的准确性、完整性和一致性。

2、数据安全

数据采集涉及到大量敏感信息的处理,如客户信息、财务数据等。因此,数据安全是一个重要的挑战。企业和组织需要采取措施保护数据不被未经授权的人访问、篡改或泄露。

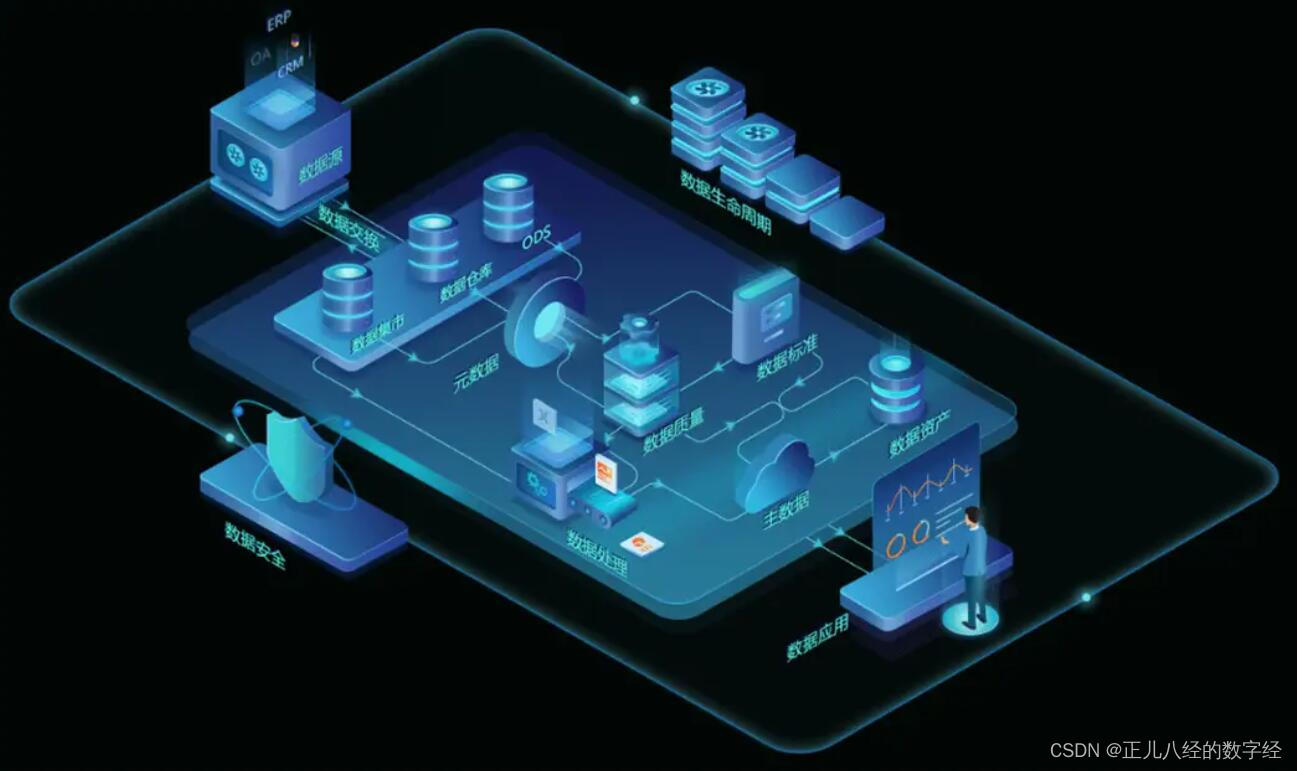

3、数据整合

企业和组织通常从多个渠道采集数据,如内部系统、第三方数据源等。这些数据可能存在格式不一致、语义不明确等问题,需要进行整合和清洗,以确保数据的可用性。

(二)应对策略

1、建立数据管理体系

企业和组织应建立完善的数据管理体系,包括数据质量管理、数据安全管理、数据整合管理等方面。通过制定相应的规章制度和流程,确保数据采集的准确性、完整性和一致性。

2、采用先进技术手段

企业和组织应采用先进的技术手段,如数据挖掘、机器学习等,提高数据采集和分析的效率和准确性。同时,应加强对数据安全的保护,采用加密、身份验证等技术手段,防止数据泄露和篡改。

3、培养数据专业人才

企业和组织应培养专业的数据人才,包括数据分析师、数据工程师等。这些人才可以帮助企业和组织更好地理解和利用数据,从而提高决策的科学性和准确性。

四、数据采集的注意事项

1. 合法性:确保采集数据的方式符合法律法规和道德规范。

2. 准确性:尽量确保采集到的数据准确无误,避免误差和偏差。

3. 完整性:采集的数据应具备足够的完整性,以满足分析需求。

4. 时效性:关注数据的时间性,确保采集到的是最新的数据。

五、结论

数据采集是获取有价值信息的关键步骤,为数据分析和应用提供了基础,只有准确、全面、及时地采集到所需的数据,才能进行有效的数据分析和应用。在进行数据采集时,我们需要关注合法性、数据质量、采样偏差和数据安全等问题,以确保采集到的数据准确、可靠且具有实际应用价值。随着技术的不断发展和创新,数据采集将变得更加高效和精确,为我们提供更多深入了解世界的机会。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 以源码为驱动:Java版工程项目管理系统平台助力工程企业迈向数字化管理的巅峰

- 40-特殊运算符delete,new,.getDate,.setDate,运算符优先级

- 长安怒怼华为,车圈这个矛盾终于藏不住了

- helm(一键式部署chart资源)

- GEC6818传感器模块(烟雾+GY39+RFID)——使用文字取模的方式实现数据显示

- 【接口测试】Postman(一)--接口测试知识准备 _

- 算法进阶——求二叉树的层序遍历

- 12、JVM高频面试题

- Web知识点复习

- 分支和循环语句