Flink电商实时数仓项目部署上线

发布时间:2024年01月05日

Flink实时数仓部署

- 将common作为一个自定义的依赖部署到maven中

- 使用maven将各个子模块打包

- 可以使用FLink框架进行jar包的提交运行。

StreamPark

一个易于使用的流处理应用开发框架和一站式流处理操作平台和管理流应用。它提供了Flink和Spark编写流的脚手架。

- Core:可以使用FlinkSQL来编写简单的业务逻辑

- pump:提供各种连接器

- console:控制台,集成了项目编译、发布、参数配置、启动、保存点、火焰图、监控等功能(重点)

安装StreamPark

- 安装Linux的maven, 可以去检查一下版本目前是否还存在。

- 解压到/opt/moduel目录下

- 创建软链接,连接bin/mvn 和/usr/bin/mvn这两个目录

- 修改镜像源为国内的阿里镜像

- 上传streamPark的jar包

- 将mysql目录下的conncector连接器jar包复制到到streamPark的lib目录下

- 运行建库和建表的脚本

- 修改配置文件application.yml

- profiles.actives: mysql 改为mysql

- 工作目录

- local:/opt/module/stream_park_workspace

- remote: HDFS路径

- 配置mysql.yml

项目部署

- 打开Gitee或gitLab,复制仓库地址

- 复制到仓库地址到StreamPark中,点击构建项目,此时会下载各种依赖jar包,需要等待一会

- 上传common模块的jar包到HDFS中

- 添加作业,使用自定义代码,配置一些常用的参数

- 启动hadoop, yarn, zookeeper,redis等框架

- 发布作业

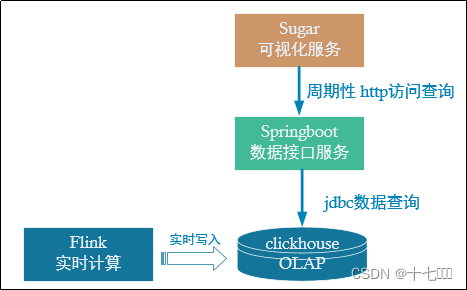

数据接口可视化

dws层已经把轻度聚合的结果保存到了Doris中,后续只要从Doris读取数据再做简单聚合即可。数据可视化主要看面向两种客户:

- 数据开发人员

- 普通客户

Suglar可视化

- 登录百度云,即可免费试用一个月

- 创建空白大屏

- 在数据->静态Json可以查看一下数据展示所需的格式

- 创建gmall-publisher项目,Spring boot架构

- 确定对外的服务端口号为8070,读取Doris数据的端口号为9030

文章来源:https://blog.csdn.net/qq_44273739/article/details/135400896

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 谷粒商城-缓存使用&分布式锁&SpringCache(5天)

- 【Spring】19 AOP介绍及实例详解

- Pygame飞机大战小游戏

- 乳腺癌治疗创新:特征权重分配引领精准医学

- 5.5 函数-二维数组

- 全面了解网络性能监测:从哪些方面进行监测?

- message: 没有找到可以构建的 NPM 包,请确认需要参与构建的 npm 都在 `miniprogra

- 在Excel中,如何简单快速地删除重复项,这里提供详细步骤

- python强大的hook函数

- Java:获取当前线程组的父线程组