hf-mirror 使用

发布时间:2024年01月15日

根据这篇文章:

大模型下载使我痛苦

得知 Huggingface 镜像站 https://hf-mirror.com

命令下载

网站首页会介绍下载方法

更多用法(多线程加速等)详见这篇文章。简介:

方法一:使用huggingface 官方提供的 huggingface-cli 命令行工具。

(1) 安装依赖

pip install -U huggingface_hubCopy

(2) 基本命令示例:

export HF_ENDPOINT=https://hf-mirror.comCopy

huggingface-cli download --resume-download --local-dir-use-symlinks False bigscience/bloom-560m \

--local-dir bloom-560mCopy

- 这里模型名称为

bigscience/bloom-560m

保存的文件夹为bloom-560mCopy

(3) 下载需要登录的模型(Gated Model)

请添加 --token hf_*** 参数,其中 hf_*** 是 access token,请在 huggingface官网这里获取。示例:

huggingface-cli download --token hf_*** \

--resume-download --local-dir-use-symlinks False meta-llama/Llama-2-7b-hf \

--local-dir Llama-2-7b-hfCopy

方法二:使用url直接下载时,将 huggingface.co 直接替换为本站域名hf-mirror.com。

使用浏览器或者 wget -c、curl -L、aria2c 等命令行方式即可。

下载需登录的模型需命令行添加 --header hf_*** 参数,token 获取具体参见上文。

方法三:(非侵入式,能解决大部分情况)huggingface 提供的包会获取系统变量,所以可以使用通过设置变量来解决。

HF_ENDPOINT=https://hf-mirror.com python your_script.pyCopy

不过有些数据集有内置的下载脚本,那就需要手动改一下脚本内的地址来实现了

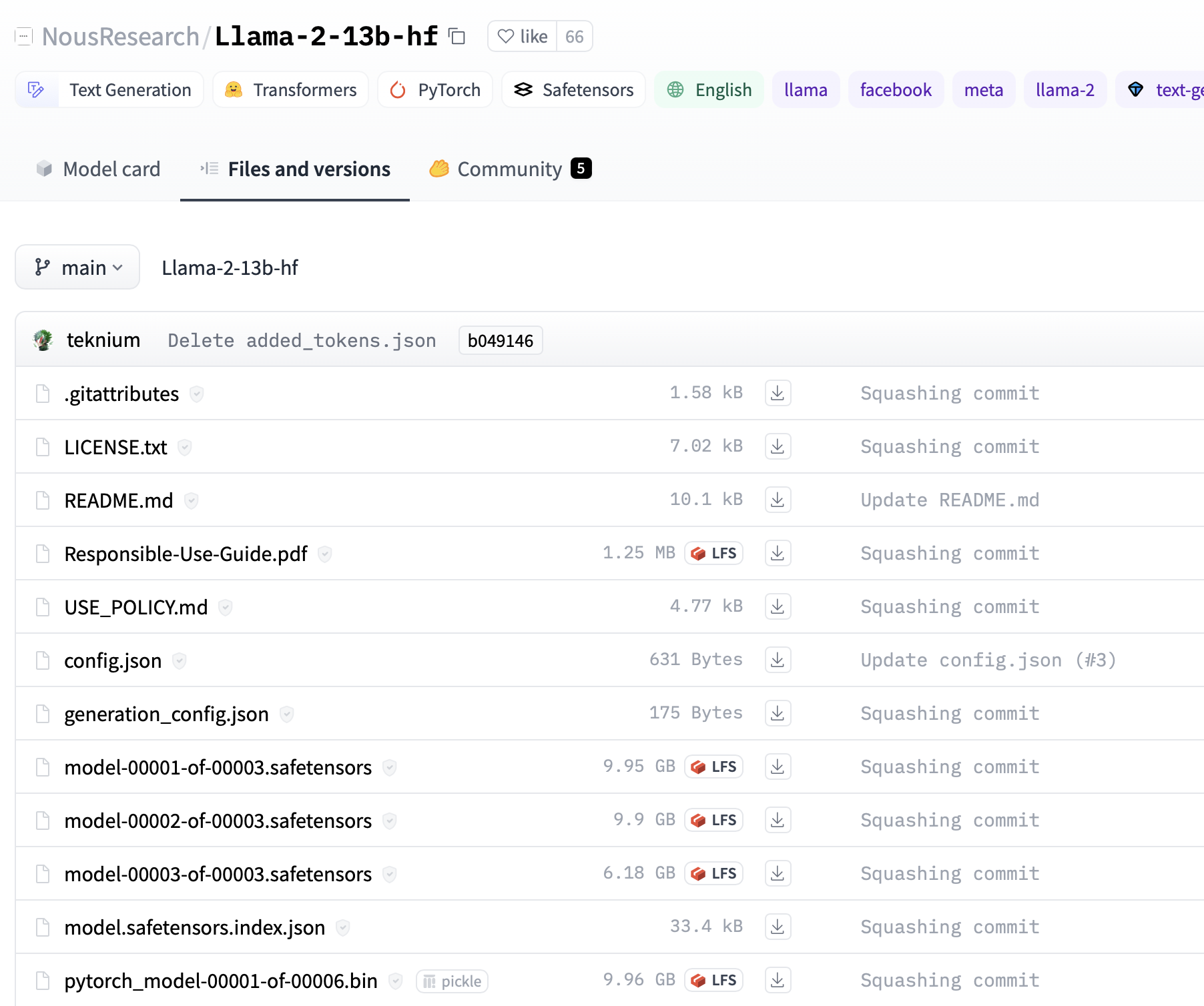

搜索下载

你也可以通过搜索,下载 需要的模型,比如

https://hf-mirror.com/NousResearch/Llama-2-13b-hf

文章来源:https://blog.csdn.net/weixin_45390999/article/details/135600805

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Vue学习计划-Vue3--核心语法(五)生命周期、自定义Hook

- IPv6测试指标包括哪些方面?如何去测试IPv6?(国科云)

- dBSPL换算实例

- 二值图像的游程编码

- 树莓派,mediapipe,Picamera2利用舵机云台追踪人手(PID控制)

- Ethercat“APWR配置从站地址”报文分析(0x0010:0x0011)

- Visual Studio 与 SQL Server 常见报错解决方案(工作向)

- MySQL修炼手册7:数据修改基础:INSERT、UPDATE、DELETE语句详解

- C++ continue语句

- 【小沐学Python】Python实现语音识别(SpeechRecognition)