SmartX 超融合和分布式存储支持哪些信创硬件?如何选型配置?

为了推动 IT 基础架构国产化转型,不少用户都使用 SmartX 超融合和分布式存储构建信创云基础设施。其中,信创硬件的选型与配置往往是用户在规划与部署环节关注的重点:国产 CPU/存储怎么选?哪个系列/型号的性价比最高?如何基于信创硬件构建高性能资源池?……

本文,我们将结合实践经验与测试数据,为用户提供基于 SmartX 产品的信创服务器、服务器部件(包括 CPU、SSD、HDD、RAID、网卡等)和交换机硬件的选型与配置建议。最后,我们将针对包括高性能资源池在内的 4 种业务场景,为用户提供信创硬件的整体配置方案参考。

如何基于 SmartX 超融合和分布式存储构建信创云平台

SmartX 以超融合软件 SMTX OS 为核心,提供自研、解耦、生产就绪的超融合信创云基础设施产品组合。欲深入了解 SmartX 超融合信创云基础设施解决方案,请阅读:一文了解超融合信创云基础设施。

SmartX 超融合信创云基础设施

?

SmartX 超融合软件 SMTX OS 可以直接安装在搭载了海光、鲲鹏或者飞腾芯片平台的信创通用服务器上,存储网络可以使用 10GbE、25GbE、100GbE 高速以太网网络互联,同时支持 RDMA 协议。

在整体网络方面,推荐使用典型的 SMTX OS 网络架构部署。该网络架构中从 OVS、物理网卡、交换机实现了管理网络、存储网络和虚拟机业务网络的完全隔离,运维复杂度低,且安全合规。

同时,针对部分用户存算分离部署的需求,SmartX 也支持用户基于自主研发的分布式块存储软件 SMTX ZBS 构建信创分布式存储资源池。

基于 SMTX ZBS 构建信创云平台

SMTX ZBS 分布式块存储支持独立部署,支持的服务器、存储网络和整体网络架构与基于 SMTX OS 的部署方案一致。区别在于,SMTX ZBS 不提供虚拟化服务,只提供分布式存储服务,因此对于 CPU、内存的需求可进一步降低。目前,SMTX ZBS 支持 iSCSI、NVMe over RDMA(RoCE v2)和 NVMe over TCP 协议,支持 VMware vSphere/KVM 虚拟化平台、OpenStack 云平台、Kubernetes 容器云平台、物理机等多种平台。

SmartX 超融合与分布式存储的的信创硬件选型建议

服务器整机选型

对于服务器整机,得益于 SmartX 超融合与分布式存储软硬件解耦的优势,用户可选择 SmartX 与服务器厂商联合认证服务器,或者采用一体机进行软硬件一体化的形式进行交付,同时也可以根据信创云平台建设的需求,自行准备满足 SmartX 硬件兼容性列表(HCL)兼容要求的服务器以及硬件,SmartX 产品采用纯软件的方式进行交付。

- 一体机形式交付:目前,SmartX 超融合与分布式存储已与海光与鲲鹏主流国产 CPU 的部分产品进行了深度适配,用户不用担心适配、调优等操作,开箱即可使用。

- 信创服务器自行选配:SmartX 超融合与分布式存储适配浪潮、中科可控、紫光恒越、联想、H3C、超聚变、Huawei TaiShan、神州鲲泰、华鲲振宇、宝德、五舟、百信恒山等国内主流品牌中的信创通用服务器,涵盖海光、鲲鹏以及飞腾芯片构架硬件,支持用户使用已有或自行采购的服务器灵活配置。用户还可使用不同品牌的服务器搭建异构超融合/分布式存储集群,便于扩容和持续推进数字化转型。欲深入了解服务器利旧方案与用户实践,请阅读:4 个超融合利旧用户实践,揭秘如何以更低成本实现架构转型。

信创服务器整机适配概览(部分)

服务器部件选型

信创服务器部件选型主要参考部件目前信创服务器的整体硬件性能较 Intel、AMD 等传统 x86 平台存在一定的差异,各零部件品牌和型号众多,因此用户在服务器部件选型时(CPU、内存、SSD、HDD、RAID 卡、网卡)可以参考如下建议*。

*注:对于部分部件,信创产品可满足大多数使用场景,但在一些对性能与延时要求较高的信创场景,国外品牌产品仍为常见使用,且可通过信创验收,因此列出供读者参考。

CPU 选型参考

使用 SMTX OS 构建高性能集群时,建议选择海光 3 代 7390 或 7380 CPU,或鲲鹏 920 64 核 CPU 2 路标准服务器,用于承载 CPU 敏感型应用,如数据库、核心应用、高性能前端、数据分析、高性能计算等。

这里海光和鲲鹏 CPU 最大的区别是,海光 CPU 具备完整的 x86 指令集,且支持开启超线程,能够分发的虚拟核更多;而鲲鹏 CPU 由于其自身不支持超线程,为了实现最佳实践,建议使用 64 核。

使用 SMTX ZBS 构建高性能集群时,由于分布式块存储集群不对外提供计算虚拟化服务,资源占用量更低,因此用户可选择海光三号 5380 / 5390 两款主频相对较高的 CPU 或鲲鹏 920 32/48 核 CPU 单路服务器,即可满足高性能存储的 CPU 需求,同时降低 CPU 硬件成本。

内存选型参考

内存的选型比较简单,为了保证信创资源池场景下的整体性能,建议在规划时对每个业务系统使用的内存资源做适量增加(留出余额),同时建议用户先确认服务器内存的当前容量和最大扩容量,这样后续业务量增长,内存也方便随之扩展。

SSD 选型参考

- Boot 盘我们推荐使用 2 块容量 ≧ 480GB 的企业级 SSD 做硬件 RAID 1,以确保可靠性、使用寿命和启动速度。目前 SmartX 支持绝大多数市场上主流的 RAID 卡或 M.2 Raid 卡来对 Boot 盘构建硬件 RAID 1。

- 缓存盘/数据盘我们推荐使用不少于 4 块的企业级读写混合型(DWPD ≧ 3)SATA / SAS / NVMe SSD 作为缓存盘,进行分层部署,此时缓存盘与数据盘的配比比例应在 10% 以上。如用于构建高性能资源池,推荐使用 NVMe 全闪,并采用不分层的部署方式。

以上建议均适用于 SMTX OS 和 SMTX ZBS。

下图表展示了部分 SmartX 兼容适配的主流品牌和主流型号 SSD,标绿的为推荐型号(读写混合型,寿命更长,PCIe 4.0 起步)。当然,用户也可以选择读取密集型 SSD,但此类 SSD 在长时间的高负载、大块 I/O 场景下可能会出现增加延迟或者带宽降低等影响集群整体性能情况,需要用户结合实际情况考虑。

HDD 选型参考

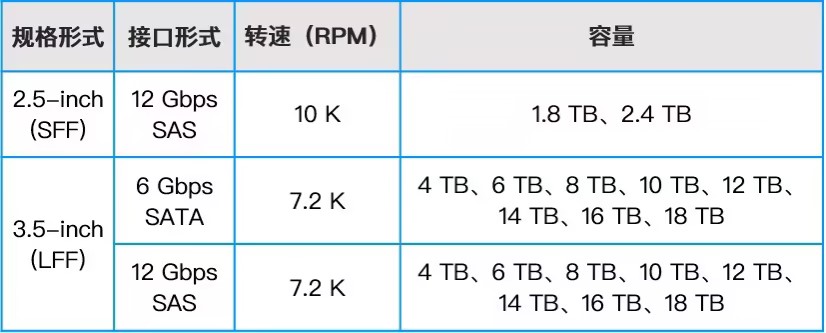

目前,SMTX OS 和 SMTX ZBS 均支持主流品牌、主流规格的 512n / 512e 格式的 HDD(仅列举市场中常见 HDD 尺寸规格以及容量节点)。

HDD 的选择主要集中在 2.5 英寸 SAS 机械盘和 3.5 英寸 SATA 机械盘上。从使用性能上来讲,在缓存盘不击穿的情况下,2.5 英寸 SAS 机械盘和 3.5 英寸 SATA 机械盘的使用效果没有太大区别,业务系统也没有明显的感知。不过在生产环境中(尤其是混闪架构),如果硬盘需要更换,硬盘上存放的持久化数据越多,重构时间越长,这时 2.5 英寸 SAS 机械盘重构速度就会比 3.5 英寸 SATA 机械盘要快。如果存储资源使用量很大,需要使用 3.5 英寸盘,用户也可以有很多种选择,但结合可维护性与成本考虑,建议用户使用 10TB 及以下容量的 3.5 英寸盘。

总结一下,根据最佳实践经验,推荐集群服务器配置 2.5 英寸 SAS HDD,对硬件成本敏感或对性能不敏感的业务系统(如日志归档、镜像归档等场景),可以考虑使用单盘 10TB 及以下容量的 SATA HDD。

存储控制器选型参考

- Boot 盘推荐使用两张 M.2 SSD 并通过 RAID 套件组硬件 RAID 1。若无法满足上述最佳方案,则可通过使用独占一块支持硬件 RAID 1 的存储控制器与两张后置 SATA SSD 组成硬件 RAID 1 以保证 Boot 盘的高可用。

- SSD 缓存盘/全闪数据盘推荐独占使用 1 块或多块支持 JBOD 模式的存储控制器。选用存储控制器时建议通道数大于等于磁盘数,以获得更好的整体性能。另外,使用 NVMe?高速闪存介质做为缓存盘或全闪数据盘时,通常会配置 NVMe CPU 直通卡(Switch / Retimer)以获得更好的 NVMe 的支持性, NVMe SSD 无需额外的存储控制器。

网卡选型参考

网卡适配概览

- Intel

- i350

- 基于 82599 芯片 OEM 品牌?

- X500 系列 X520/X540/X550

- X700 系列 X722/XL710/X710

- E810

- Mellanox

- CX-3

- CX-4

- CX-5

- Solarflare

- X2、8000

- Broadcom/HP/QLogic

- 中兴

- I-210/NS-212

- H3C

- 530F/560F/620F

- Huawei

- TM210

- TM280

- 中科可控/紫光恒越/宝德/联想/天宫/百信恒山/五舟

- 以 OEM Intel/Mellanox 为主

高性能集群推荐

SMTX OS 和 SMTX ZBS 在网卡层面也适配了众多市面主流品牌的主流型号网卡和网卡芯片,如 Intel、Mellanox、Solarflare、Broadcom、中兴、H3C、Huawei 等。在构建高性能资源池时,推荐选用支持 SR-IOV、RDMA 的网卡,如果要启用 RDMA 模式建议选用Mellanox CX-5 网卡。

- RDMA

- Mellanox CX-5 25GbE

- SR-IOV

- Intel X722

- Mellanox CX-4/5?

- Solarflare X2、8000

交换机选型

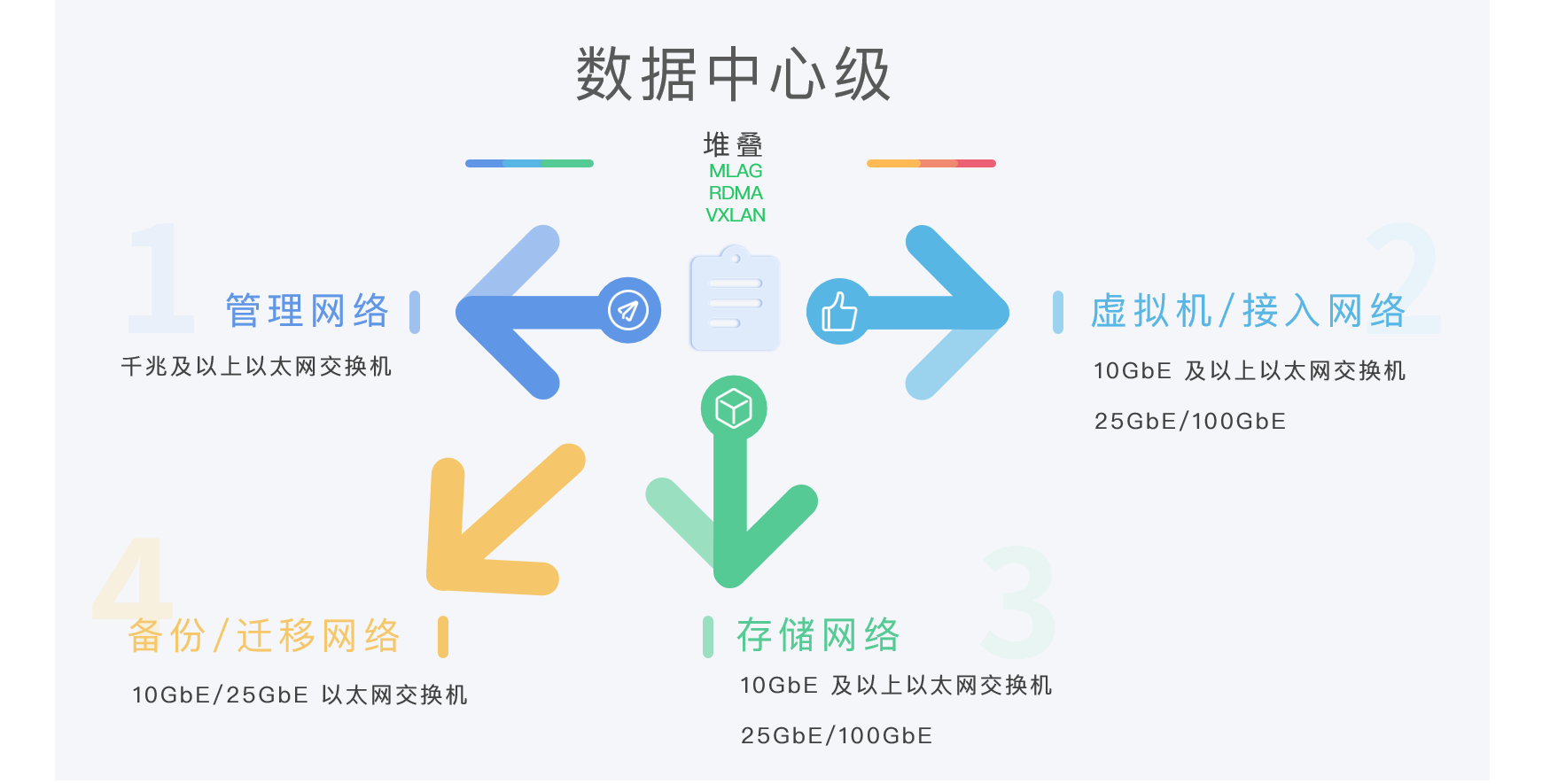

使用 SmartX 超融合和分布式存储,推荐使用典型网络拓扑架构进行网络规划,存储网络、管理网络、虚拟机业务网络/存储接入网络推荐选择支持 MLAG 高可用组网特性的数据中心级交换机,以获得更好的网络质量。

存储网络推荐使用 10GbE 及以上的以太网交换机。如使用 NVMe 作缓存盘,或使用 SATA 全闪磁盘,推荐使用 25GbE 以太网交换机;如要构建高性能集群,建议使用支持 RDMA L3 流控的交换机。

存储接入网络通常在分布式块存储分离部署场景中使用,建议采用 10GbE 及以上以太网交换机。如果接入端(虚拟化、物理服务器、OpenStack、Kubernetes 容器平台)希望使用RDMA 特性,推荐使用 25GbE 及更高速率且支持 RDMA L3 流控的以太网交换机。

管理网络使用千兆网络即可满足网络要求,如要获得更好的网络体验,管理网络也可以使用 10GbE 或更高速的以太网交换机。

虚拟机业务网络对交换机没有具体的限制和要求,通常根据业务系统负载进行选择。如果现有千兆网络能满足业务系统需求,使用千兆网络也是可以的,如要获得更好的网络服务质量,推荐使用 10GbE 及以上以太网交接机。

另外,我们为用户提供一组信创交换机 RDMA 打流测试数据作为参考。目前 RDMA 在以太网网络上的主流传输方式是 RoCEv2,该协议是基于无连接服务的 UDP 协议,相比面向连接服务的 TCP 协议,UDP 协议传输速度更快、CPU 资源占用更少,但传输质量是不可靠的。RDMA 接收方网卡发现丢包时,会丢弃后续接收到的数据包,发送方需要重发之后的所有数据包,这会导致性能大幅下降。所以要想 RDMA 发挥出其性能,需要为其搭建一套不丢包的无损网络环境。

通俗的说,如果要构建 RDMA 无损网络,就需要流量控制和拥塞管理等流控机制,以确保RDMA 网络的服务质量。如图中 RDMA 打流测试为例,同一红框内左右两端网络流量数据误差越小,表示 RDMA 网络质量越好。

RDMA 交换机打流测试数据

(注:在国产交换机 RDMA 打流测试过程中,使用的是同一套 SmartX 超融合集群。)

从以上数据可以看出,华为、H3C 的信创交换机对 RDMA 场景的支持能力较强,完全能够满足构建高性能资源池的要求。

典型应用场景配置实践

场景一:要求“高性能、低延时”的重要业务系统

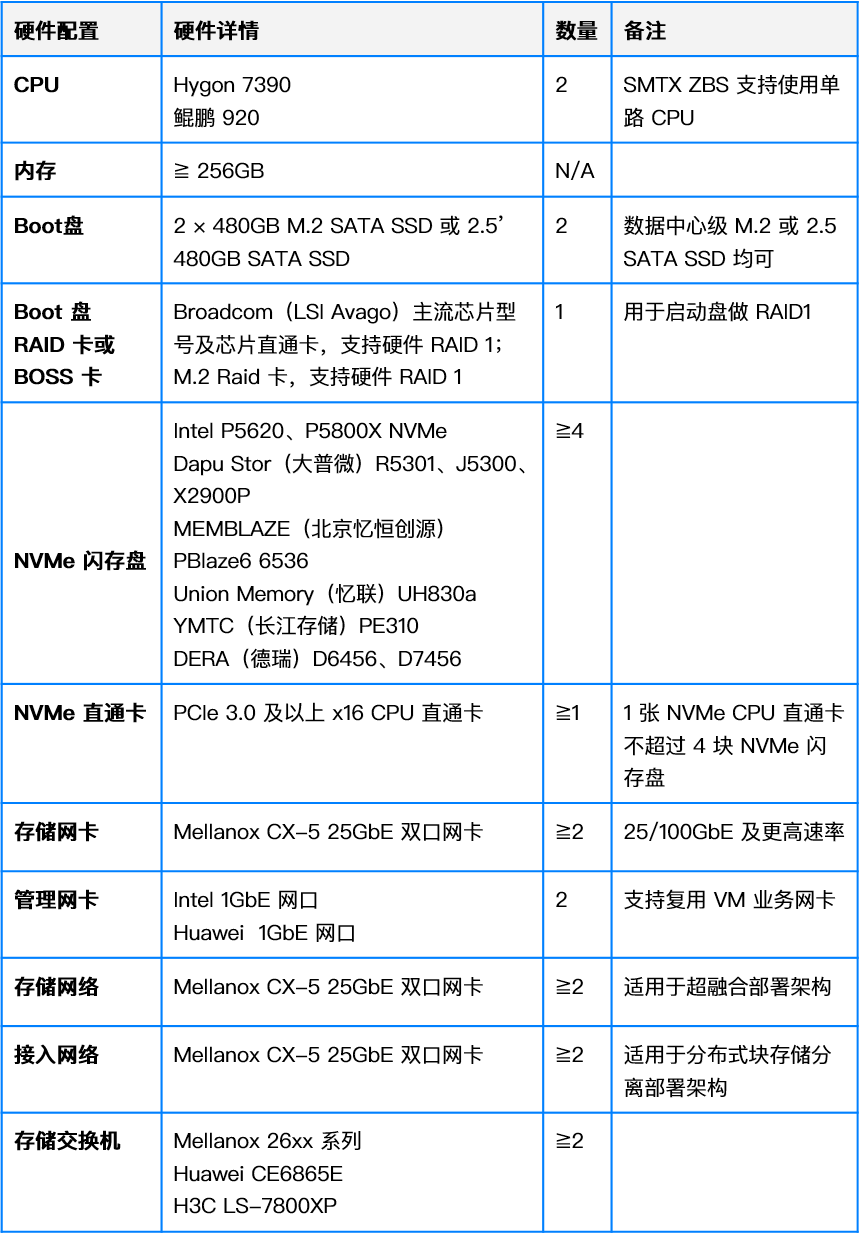

对于各种具有高性能、低延时需求的重要业务系统,如交易类业务系统、中间业务系统、数据库等,建议用户构建 NVMe 全闪资源池。整套架构的信创硬件配置,我们结合上述分析整理了以下方案,供用户参考。

场景二:性能敏感型业务系统

对于对性能相对敏感的业务系统,如重要业务系统的开发测试场景、数据分析业务、生产等,建议用户构建 NVMe + SATA SSD 分层全闪高性能资源池。整套架构的信创硬件配置可参考以下方案。

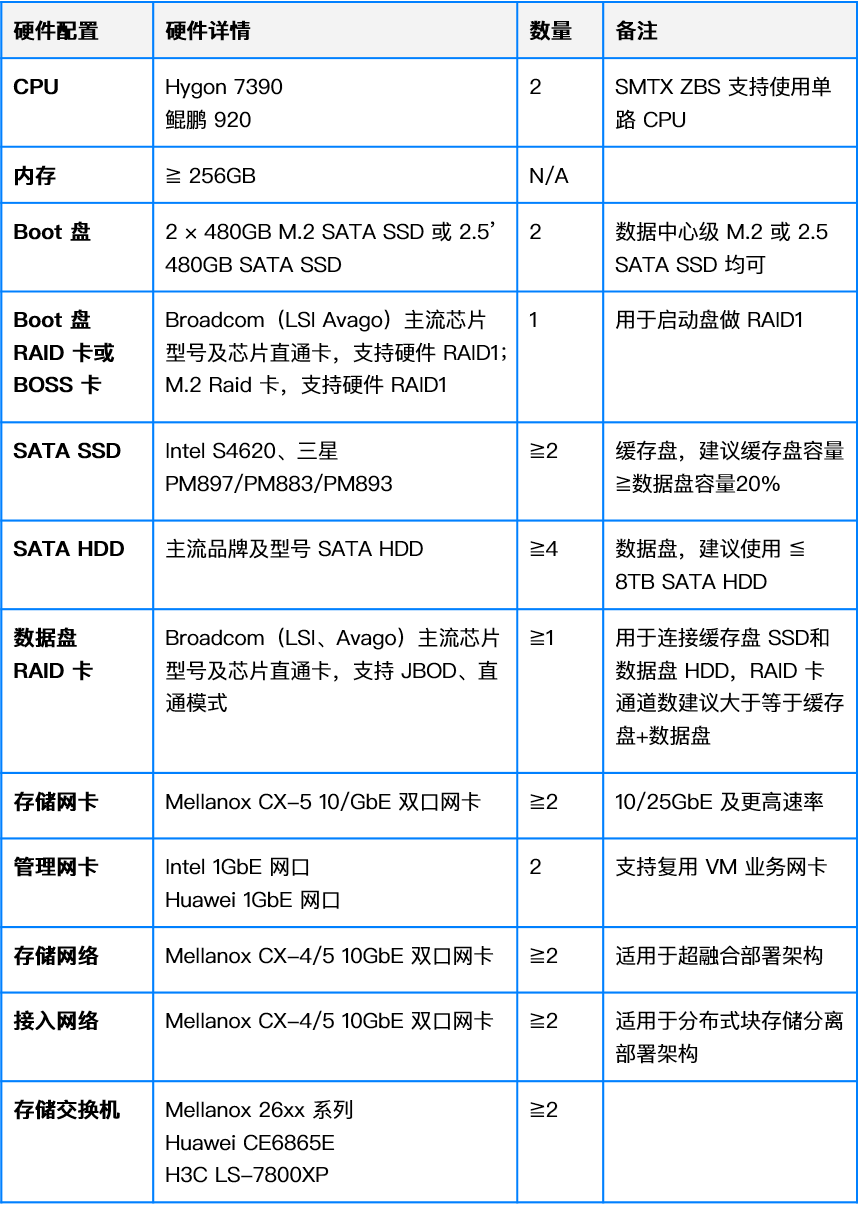

场景三:一般生产业务系统

对于一般生产业务系统、开发测试环境、一般业务系统容灾/备份等场景,建议用户构建 SATA SSD + SAS HDD 混闪分层存储资源池。整套架构的信创硬件配置可参考以下方案。

场景四:一般业务系统

对于边缘业务系统、管理类业务系统、一般开发测试环境、归档存储类等,建议用户构建 SATA SSD + SATA HDD 混闪存储资源池。整套架构的信创硬件配置可参考以下方案。

更多超融合信创云基础设施能力特性与用户实践,请阅读《信创云转型合集:技术路线、厂商评估与用户实践》。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Redis 高可用之主从复制

- APP端网络测试与弱网模拟!

- 什么?发票合并还在开会员?不如看看这个小程序【发票合并】【PDF合并】

- INS 时间更新

- MySQL、Oracle 生成随机ID、随机数、随机字符串

- 说说百度大模型算法工程师经历,整体效果还行

- Spring之AOP大体流程

- 快速排序:高效分割与递归,排序领域的王者算法

- 前端对接电子秤、扫码枪设备serialPort 串口使用教程

- Mybatis集成MySQL使用游标查询处理大批量数据