03.用于LLMs不同的任务-transformer 架构

发布时间:2024年01月11日

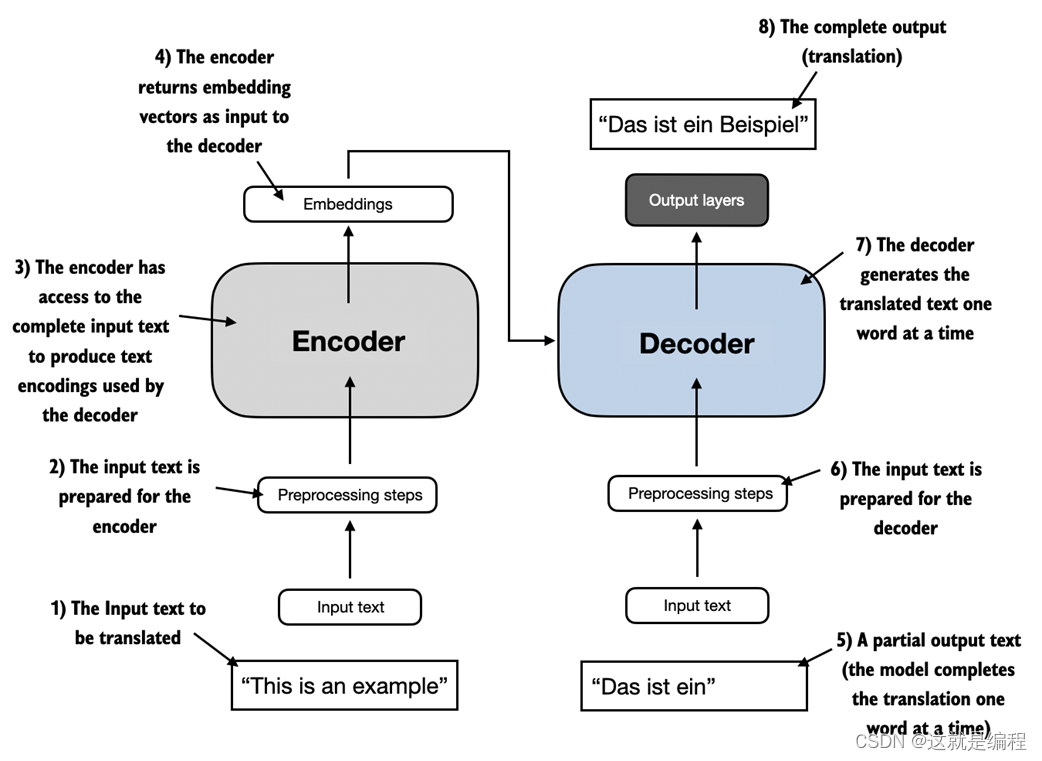

大多数现代LLMs都依赖于 transformer 架构,这是 2017 年论文 Attention Is All You Need 中介绍的深度神经网络架构。要理解LLMs,我们必须简要回顾一下最初的转换器,它最初是为机器翻译而开发的,将英语文本翻译成德语和法语。变压器架构的简化版本如图 1.4 所示。

图 1.4 原始 Transformer 架构的简化描述,该架构是用于语言翻译的深度学习模型。转换器由两部分组成,一个编码器,用于处理输入文本并生成文本的嵌入表示(一种在不同维度捕获许多不同因素的数字表示),解码器可以使用该表示一次生成一个单词的翻译文本。请注意,此图显示了翻译过程的最后阶段,解码器只需生成最后一个单词(“Beispiel”),给定原始输入文本(“This is an example”)和部分翻译的句子(“Das ist ein”),即可完成翻译。图编号表示处理数据的顺序,并提供有关读取图的最佳顺序的指导。

图 1.4 中描述的 transformer 架构由两个子模块组成,一个编码器和一个解码器。编码器模块处理输入文本并将其编码为一系列数字表示或向量,以捕获输入的上下文信息。然后,解码器模块获取这些编码的向量并从中生成输出文本

文章来源:https://blog.csdn.net/cq20110310/article/details/135503536

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- B+树的插入删除

- 当项目编译出现default language之类的错误时,修改C++语言标准

- 前缀和算法 -- [模版]二维前缀和

- linux centos环境下chfs文件服务器搭建详细记录

- 【已解决】C语言实现多线程检索数据

- Python元组tuple“删除”元素的两种函数代码设计

- 数据压缩入门-读书笔记

- 24年第一期工信部报道,本田400系列更新,CLC单座上市

- 线上购买电影票平台软件源码快速搭建

- mysql的redolog、undo、binlog的作用