目标检测-Two Stage-Faster RCNN

文章目录

前言

前文提到了目标检测-Two Stage-Fast RCNN提到了Fast RCNN主要缺点是:

- 通过手工方法(Selective Search)寻找的候选框,非常耗时。

Faster RCNN针对上述缺点做了改进

提示:以下是本篇文章正文内容,下面内容可供参考

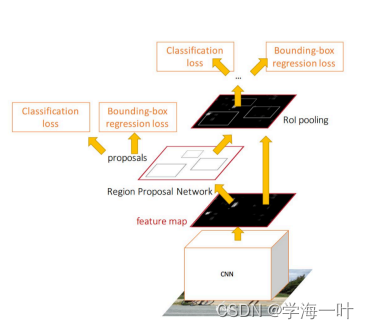

一、Faster RCNN的网络结构和流程

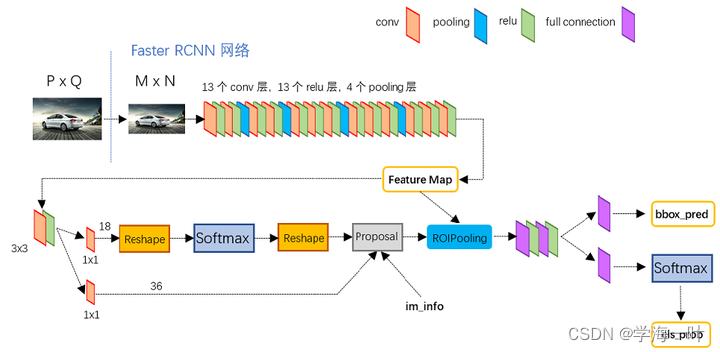

- 利用backbone网络提取特征,获得共享卷积特征图(Feature Map)

近些年来随着深度学习特征提取网络的成熟,将这类特征提取网络称为骨干网(backbone)

- 利用RPN(Region Proposal Network)网络生成候选框,进行分类和第一次边框修正

使用RPN网络取代手工方法生成候选框,RPN网络的流程是:

- 使用3×3的卷积核窗口对共享卷积特征图(Feature Map)进行卷积,获得通道(channel)为256的输出:256 x H x W

- 使用两个1×1卷积分别对每个锚点的锚框进行卷积,获得(2 x k) x H x W个类别分数和(4 x k) x H x W个目标框参数

ps:特征图的每个像元都预先设置以该像元为中心(锚点)的k(k=9)个相同大小的锚框(anchor boxes)- 将类别分数和目标框参数合并得到k x H x W个候选框:k x H x W x 5

- 将生成的Region Proposal和共享特征图(Feature Map)输入RoI pooling和全连接层进行分类和第二次边框修正

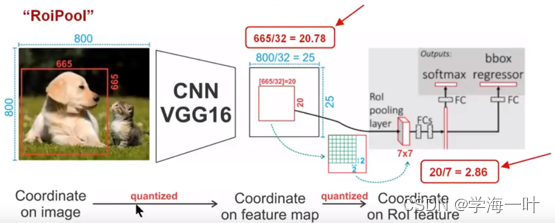

RoI pooling:

- 将共享卷积特征图输入到池化层,获取共享池化特征图

- 将候选框在原图的位置映射到共享特征图,以获取每个候选框的卷积特征图

- 将将候选框在卷积特征图的位置映射到共享池化特征图,以获取每个候选框的池化特征图

ps:将候选框在原图的位置映射到共享池化特征图时,为了和图像像元对齐,使用了两次量化操作(不能整除时取整对齐)

Faster R-CNN的流程图

Faster R-CNN网络结构图(以VGG为backbone):

二、Faster RCNN的创新点

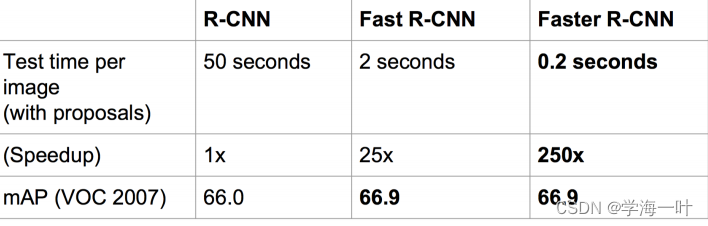

- Faster R-CNN的主要贡献就是设计了提取候选区域的网络RPN,代替了费时的选择性搜索selective search,使得检测速度大幅提高(5-17 fps),并使得整个过程变成完全的端到端。

三、Faster RCNN的训练过程

非极大值抑制(Non-Maximum Suppression,NMS)

- 一些anchors是高度重叠的,为了减少冗余,提高速度,Faster R-CNN采用非极大值抑制(Non-Maximum Suppression,NMS)去除了IoU在0.7以上的冗余框,这样每张影像大概有2k个候选框参与训练。

NMS:

先假设有6个矩形框,根据分类器的类别分类概率做排序,假设从小到大属于人脸的概率 分别为A、B、C、D、E、F。

- 从最大概率矩形框F开始,分别判断A~E与F的重叠度IoU是否大于某个设定的阈值;

- 假设B、D与F的重叠度超过阈值,那么就扔掉B、D;并标记第一个矩形框F,是我们保留下来的。

- 从剩下的矩形框A、C、E中,选择概率最大的E,然后判断E与A、C的重叠度,重叠度大于一定的阈值,那么就扔掉;并标记E是我们保留下来的第二个矩形框。

- 就这样一直重复,找到所有被保留下来的矩形框。

IoU:IoU 的全称为交并比(Intersection over Union),通过IoU的值可以判断边框间的重叠度,计算方式为两个框的交集和并集的比值

损失函数

一种网络,四个损失函数:

? RPN classification(anchor good.bad):SoftmaxLoss

? RPN regression(anchor->propoasal):SmoothL1Loss

? Fast R-CNN classification(over classes):SoftmaxLoss

? Fast R-CNN regression(proposal ->box):SmoothL1Loss

![![[Pasted image 20231128145148.png]]](https://img-blog.csdnimg.cn/direct/7286a8ab4b224e7d84f156fe523b49b9.png)

边框修正主要由4个值完成,(tx,ty,th,tw),表示x和y方向上做出平移(由tx和ty决定),并且长宽各自放大一定的倍数(由th和ty决定)

训练过程

Faster R-CNN的训练方式有三种:

- RPN和Fast R-CNN交替训练,这种方式也是作者采用的方式。

- 近似联合RPN和Fast R-CNN的训练,在训练时忽略掉RoI边框修正的误差,也就是说只对anchor做了边框修订,这也是为什么叫"近似联合"的原因。

- 联合RPN和Fast R-CNN的训练。

对于作者采用的交替训练的方式,步骤如下:

- 使用在ImageNet上预训练的模型初始化共享卷积层并训练RPN。

- 使用上一步得到的RPN参数生成RoI proposal。再使用ImageNet上预训练的模型初始化共享卷积层,训练Fast R-CNN部分(分类器和RoI边框修订)。

- 将训练后的共享卷积层参数固定,同时将Fast R-CNN的参数固定,训练RPN。(从这一步开始,共享卷积层的参数真正被两大块网络共享)

- 同样将共享卷积层参数固定,并将RPN的参数固定,训练Fast R-CNN部分。

测试过程

Faster R-CNN的测试流程和训练流程相似,描述如下:

- 首先通过RPN生成约20k个anchor(40×60×9)

- 对20k个anchor进行第一次边框修正,得到修订边框后的proposal

- 对超过图像边界的proposal的边进行clip,使得该proposal不超过图像范围

- 忽略掉长或者宽太小的proposal

- 将所有proposal按照前景分数从高到低排序,选取前6k个proposal

- 使用阈值为0.7的NMS算法排除掉重叠的proposal

- 针对上一步剩下的proposal,选取前300个proposal进行分类和第二次边框修正

总结

相比于之前的算法,Faster RCNN由于其端到端的特性得到广泛应用,但是受Two Stage算法思想的影响,速度仍不够快,

并且ROI Pooling有两次量化操作,会引入误差影响精度。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 基于Python3.7实现的双时相遥感影像变化检测(PaddlePaddle框架和AI Studio平台)

- Python Web框架FastAPI——一个比Flask和Tornada更高性能的API框架

- ACL16_S 系列 低成本物联网安全芯片,可应用物联网认证、 SIM、防抄板和设备认证等产品上

- 怎么快速去除图片水印?这些快速去除的工具赶紧码住

- UG装配-镜像装配

- Java web汽车销售管理系统JavaServelet Jsp(Java毕业设计)

- 处理HTTP错误响应:Go语言中的稳健之道

- python安装dlib报ERROR: Failed building wheel for dlib

- Linux 有哪些搜索方式?5分钟带你搞懂!

- DSMM认证办理流程是什么?