datawhale 大模型理论基础 引言

发布时间:2024年01月15日

学习地址:大模型理论基础

一、什么是语言模型(Language Model)

语言模型其实是一个概率模型,给每一个句子列表计算一个概率值:

? ? ? ????????? p(x1?,…,xL?)????????

?例如:

p(the,?mouse,?ate,?the,?cheese)=0.02,

p(the,?cheese?ate,?the,?mouse)=0.01,p(the,?cheese?ate,?the,?mouse)=0.01

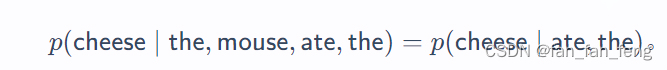

自回归语言模型(Autoregressive language models)

将一个句子的概率的表示成多个条件概率的相乘

二、信息理论、英语的熵、n-gram模型

2.1 信息熵:

信息熵也叫香侬熵,在物理上表示不确定性,熵越大,不确定性越高,包含的信息就越多。

2.2 交叉熵:

用来评估真实数据分布�p的样本的(语言)模型�q之间的差距

2.3?N-gram模型

在一个n-gram模型中,关于Xi?的预测只依赖于最后的 n?1?个字符 ,即Xi?(n?1):i?1??,而不是整个历史:

比如:n = 3

n 太小,那么模型将无法捕获长距离的依赖关系,

n太大,无法得到一个好的概率评估

三、大模型

3.1 强大的生成能力

在给定提示的情况下生成完成的文本: prompt -> task competion

3.2 具备一定的推理能力

目前开源的GPT3.5,4.0已经具备了一些逻辑推理能力,能够独立完成一些任务

3.3 风险

当然大模型还存在一些风险:

比如:

可靠性不能保证,可能输出的一段一本正经的乱说

可能生成社会偏见,或者带有侮辱等一些道德方面的文本

?

文章来源:https://blog.csdn.net/fan_fan_feng/article/details/135608657

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- JOSEF约瑟 双位置继电器UEG/C-4H4D AC220V 新款导轨安装 端子号可订做

- 基于ssm的物业管理系统论文

- RSI的c#计算,同花顺

- vscode 下一级文件和上个文件并行

- k8s部署 CNI 网络组件与k8s集群搭建(二)

- GZ075 云计算应用赛题第7套

- 控制笔记本电脑性能,增强性能/控制发热---Thinkpad x280

- 一文搞懂泛型编程

- 前端使用scale属性结合CSS动态样式实现动态的图片缩放效果

- 前端--基础 路径--绝对路径详解