HBase节点故障的容错方案

发布时间:2024年01月21日

本文主要探讨hbase集群的高可用容错方案和容错能力的探讨。涉及Master和RS相关组件,在出现单机故障时相关的容错方案。

更多关于分布式系统的架构思考请参考文档关于常见分布式组件高可用设计原理的理解和思考

1. Master高可用

1.1 选主和HA切换逻辑

Master的HA机制主要依靠zk完成。整体的逻辑跟HDFS的NN逻辑整体上一致,也略有差别,可以参考 HDFS节点故障的容错方案

相同点

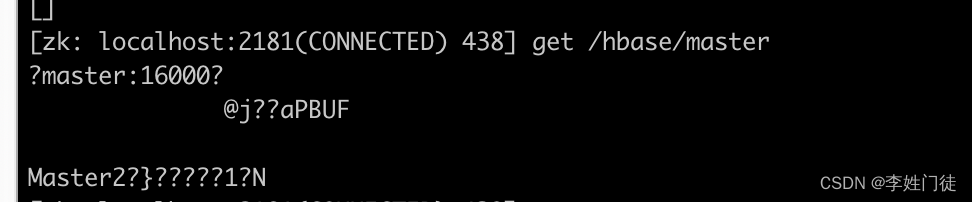

1, Master使用zk的临时锁节点进行选主

2,其他节点的watch机制跟hdfs的逻辑也一致

不同点

1, Master没有另外涉及zkfc辅助选主,而是Master自己完成了相关的逻辑

2,Master集群没有涉及fencing逻辑。

2. RS高可用

RS节点是具体的数据存储节点,HBase通常依赖hdfs进行数据存储,包括wal日志等基础原数据存储等。由于hdfs本身能够提供高可用,并且能够提供远程存储能力,因此1个RS写入的数据(包括wal日志)等能够在另外一个RS中进行数据回放。

由于HBase本身没有直接跟磁盘进行交互,因此底层的磁盘io等信息被hdfs隔离,因此hdfs的读写、存储能力直接影响HBase的性能。

2.1 感知RS节点异常

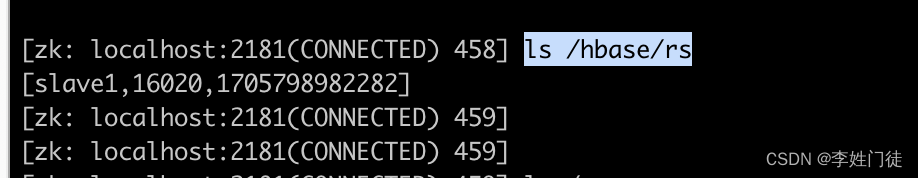

1,RS在zk中注册临时路径(/hbase/rs),如果RS节点异常,在ttl时间(默认 3min)后临时节点会被zk删除。

2, Master通过watch机制监听rs的相关路径,RS在zk中注册的临时路径过期后被删除,zk会将相关事件通知Master

2.2 异常DN上的数据处理

Master感知到RS异常后,会将RS上的Region信息迁移到其他的RS,并将wal日志在对应的RS节点进行回放,从而确保数据不丢失。

4. 疑问和思考

暂无

5. 参考文档

暂无

文章来源:https://blog.csdn.net/weixin_43845924/article/details/135724570

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 兔单B细胞技术|单克隆抗体|兔单抗-卡梅德生物

- 代码随想录算法训练营第22天(二叉树8 | ● 235. 二叉搜索树的最近公共祖先 ● 701.二叉搜索树中的插入操作 ● 450.删除二叉搜索树中的节点

- 低代码平台快速开发CRM 可灵活自定义的CRM软件

- 动态规划06-最后一块石头的重量

- JAVA泛型是什么? 有什么优缺点? 适合哪些使用场景?

- 学习使用wps将ppt的页面保存为图片的方法

- 《长江丛刊》期刊投稿发表

- 如何用自助法或刀切法来估计偏差、方差?

- EF Core 在实际开发中,如何分层?

- 前端跨页面通信方法