经典文献阅读之--U-CE(用于语义分割的不确定性感知交叉熵)

发布时间:2024年01月15日

0. 简介

深度神经网络在各项任务中均展现出卓越的性能,但是它们缺乏鲁棒性、可靠性以及过于自信的倾向,这给它们在自动驾驶等安全关键应用中的部署带来挑战。在这方面,量化模型预测所固有的不确定性是解决这些缺陷的有希望的努力方向。在《U-CE: Uncertainty-aware Cross-Entropy for Semantic Segmentation》中提出了一种新型的不确定性感知交叉熵损失(U-CE),通过对交叉熵损失(CE)逐像素加权,将动态预测不确定性加入训练过程。

1. 主要贡献

本文的贡献总结如下:

- 本文提出了U-CE损失函数,其利用不确定性估计来引导优化过程,突出了具有高度不确定性的区域;

- 本文在两个基准数据集Cityscapes和ACDC上进行了大量的实验,通过两个常见的主干网络ResNet-18和ResNet-101,证明了U-CE相对于常规CE训练的优越性;

- 本文通过多次消融研究和深入讨论,提出了U-CE的额外见解、局限性和潜在改进方向。

2. 总体框架

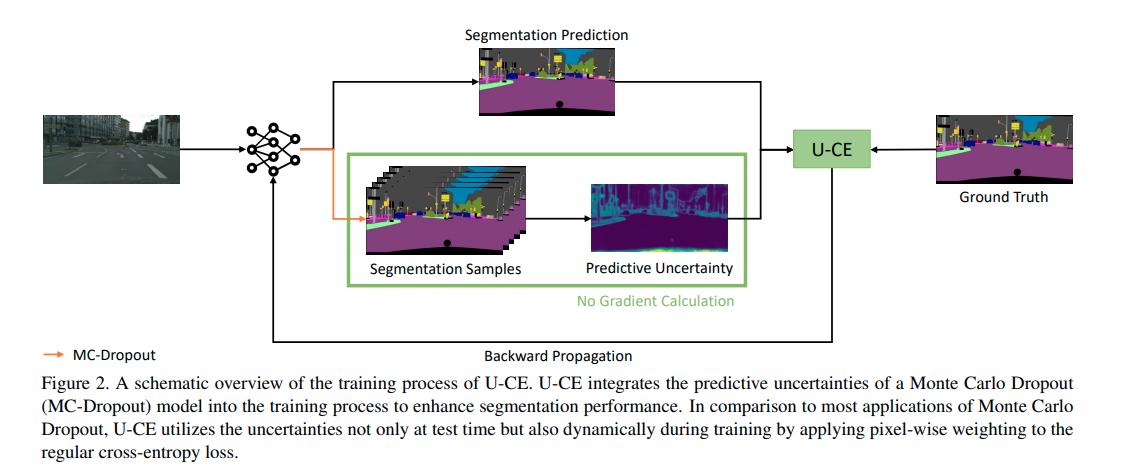

U-CE的核心思想是将预测的不确定性纳入训练过程中,以提高分割性能。如图2所示,我们提出了两种简单但非常有效的改进方法来适应常规训练过程:

-

在训练过程中,我们使用蒙特卡洛Dropout从后验分布中进行采样,以获得与常规分割预测一起的预测不确定性。

-

我们根据收集到的不确定性对常规交叉熵损失进行像素级加权。

图2. U-CE训练过程的示意图。U-CE将Monte Carlo Dropout(MC-Dropout)模型的预测不确定性整合到训练过程中,以提高分割性能。与大多数Monte Carlo Dropout的应用相比,U-CE不仅在测试时利用不确定性,还通过对常规交叉熵损失进行像素级加权,在训练过程中动态地利用不确定性。

…详情请参照古月居

文章来源:https://blog.csdn.net/lovely_yoshino/article/details/132019275

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- yolov5障碍物识别-雪糕筒识别(代码+教程)

- 全国计算机等级考试| 二级Python | 真题及解析(12)

- springboot/java/php/node/python中小型超市管理系统【计算机毕设】

- 夺冠!特等奖!实在Agent智能体闪耀“2023首届全国人工智能应用场景创新挑战赛总决赛”

- GPT应用程序上线注意的问题

- STM32入门教程-2023版【3-1】Led闪烁工程搭建

- 如何挑选一家合格的污水处理服务商

- 5. 问题解答:SAP Fiori Launchpad 点了 Logout 之后,背后都运行了哪些代码

- 7、防写一个shell 命令解释器

- After Effects 2024 (ae2024)