Nerf相关研究

1.Nerf相关研究

随着Luma AI的到来,再次将Nerf推向浪尖,实用性进一步得到强化。Nerf仍以极速的发展速度前行,越来越多的研究方向不断涌现。

4K-Nerf

4K-NeRF: High Fidelity Neural Radiance Fields at Ultra High Resolutions

论文:https://arxiv.org/abs/2212.04701

Git:https://github.com/frozoul/4K-NeRF

效果:

https://user-images.githubusercontent.com/15401551/206893643-a4c09b2b-fb7b-4af9-aa4c-8acf006f4e07.mp4

在本文中,我们提出了一个名为4K-NeRF的新颖而有效的框架,以神经辐射场(NeRF)的方法为基础,在超高分辨率的挑战性场景下追求高保真视图合成。基于nerf的方法的渲染过程通常依赖于逐像素的方式,其中光线(或像素)在训练和推理阶段都是独立处理的,这限制了其描述细微细节的表示能力,特别是在提升到极高分辨率时。我们通过探索射线相关性来提高高频细节的恢复来解决这个问题。特别是,我们使用3d感知编码器在低分辨率空间中有效地建模几何信息,并通过3d感知解码器恢复精细细节,条件是由编码器估计的光线特征和深度。与基于补丁的采样的联合训练进一步促进了我们的方法在像素级损失之外纳入基于感知的正则化监督。得益于几何感知局部环境的使用,与现代NeRF方法相比,我们的方法可以显著提高高频细节的渲染质量,并在4K超高分辨率场景下实现最先进的视觉质量。

作者提出了一种扩展NeRF方法以生成超高分辨率3D场景的方法。通过实现更逼真的3D场景的生成,有望应用于VR/AR和电影制作等领域。

Zip-NeRF

Zip-NeRF: Anti-Aliased Grid-Based Neural Radiance Fields

Zip-NeRF: Anti-Aliased Grid-Based Neural Radiance Fields

论文:https://arxiv.org/abs/2304.06706

代码:https://jonbarron.info/zipnerf/

通过在 NeRF 从空间坐标到颜色和体积密度的学习映射中使用基于网格的表示,可以加速神经辐射场训练。然而,这些基于网格的方法缺乏对比例的明确理解,因此经常引入锯齿,通常以锯齿或场景内容缺失的形式出现。mip-NeRF 360 之前已经解决了抗锯齿问题,其原因是沿圆锥体的子体积而不是沿射线的点,但这种方法本身与当前基于网格的技术不兼容。我们展示了如何使用来自渲染和信号处理的想法来构建一种技术,该技术将 mip-NeRF 360 和基于网格的模型(例如 Instant NGP)相结合,产生的错误率比任何一种现有技术都低 8% - 76%,并且训练速度比 mip-NeRF 360 快 22 倍。

NeRF-Art

NeRF-Art: Text-Driven Neural Radiance Fields Stylization

论文:https://arxiv.org/abs/2212.08070

代码:https://github.com/cassiePython/NeRF-Art

NeRF-Art:文本驱动的神经辐射场风格化

- 提出NeRF-Art,一种基于文本指导的NeRF渲染方法,可以用简单的文本提示来操纵预训练NeRF模型的风格;

- 提出一种新的全局局部对比学习策略,结合定向约束,可同时控制目标样式的轨迹和强度。

- 采用权重正则化方法减少密度场在几何渲染时容易出现的多云现象和几何噪声。

SPIn-NeRFS

SPIn-NeRFS: Multiview Segmentation and Perceptual Inpainting with Neural Radiance Fields

论文:https://arxiv.org/abs/2211.12254

通过用户设置的点去标定图像中的物体,并在后续重建出无标定物体的三维场景(文中称该任务为3D inpainting),同时提出一种新的数据集衡量模型性能。

神经辐射场(Neural Radiance Fields, nerf)已成为一种流行的新视图合成方法。虽然NeRF正在迅速适应更广泛的应用程序,直观地编辑NeRF场景仍然是一个开放的挑战。一个重要的编辑任务是从3D场景中移除不需要的物体,这样被替换的区域在视觉上是合理的,并且与它的背景一致。我们把这个任务称为3D上漆。在3D中,解决方案必须在多个视图中保持一致,并且在几何上有效。在本文中,我们提出了一种新的3D图像绘制方法来解决这些挑战。我们的框架首先在单个输入图像中给定一小组姿势图像和稀疏注释,快速获得目标物体的3D分割掩码。使用掩模,然后引入基于感知优化的方法,利用学习的2D图像画家,将其信息提取到3D空间,同时确保视图一致性。我们还通过引入由具有挑战性的现实场景组成的数据集,解决了缺乏评估3D场景绘画方法的多样化基准的问题。特别是,我们的数据集包含有目标对象和没有目标对象的相同场景的视图,从而可以对3D喷漆任务进行更有原则的基准测试。与基于nerf的方法和2D分割方法相比,我们首先证明了我们的方法在多视图分割方面的优越性。然后,我们评估了3D图像绘制的任务,建立了针对其他NeRF操作算法的最先进性能,以及强大的2D图像绘制基线。

Reference-guided Controllable Inpainting of Neural Radiance Fields

论文:https://arxiv.org/abs/2304.09677

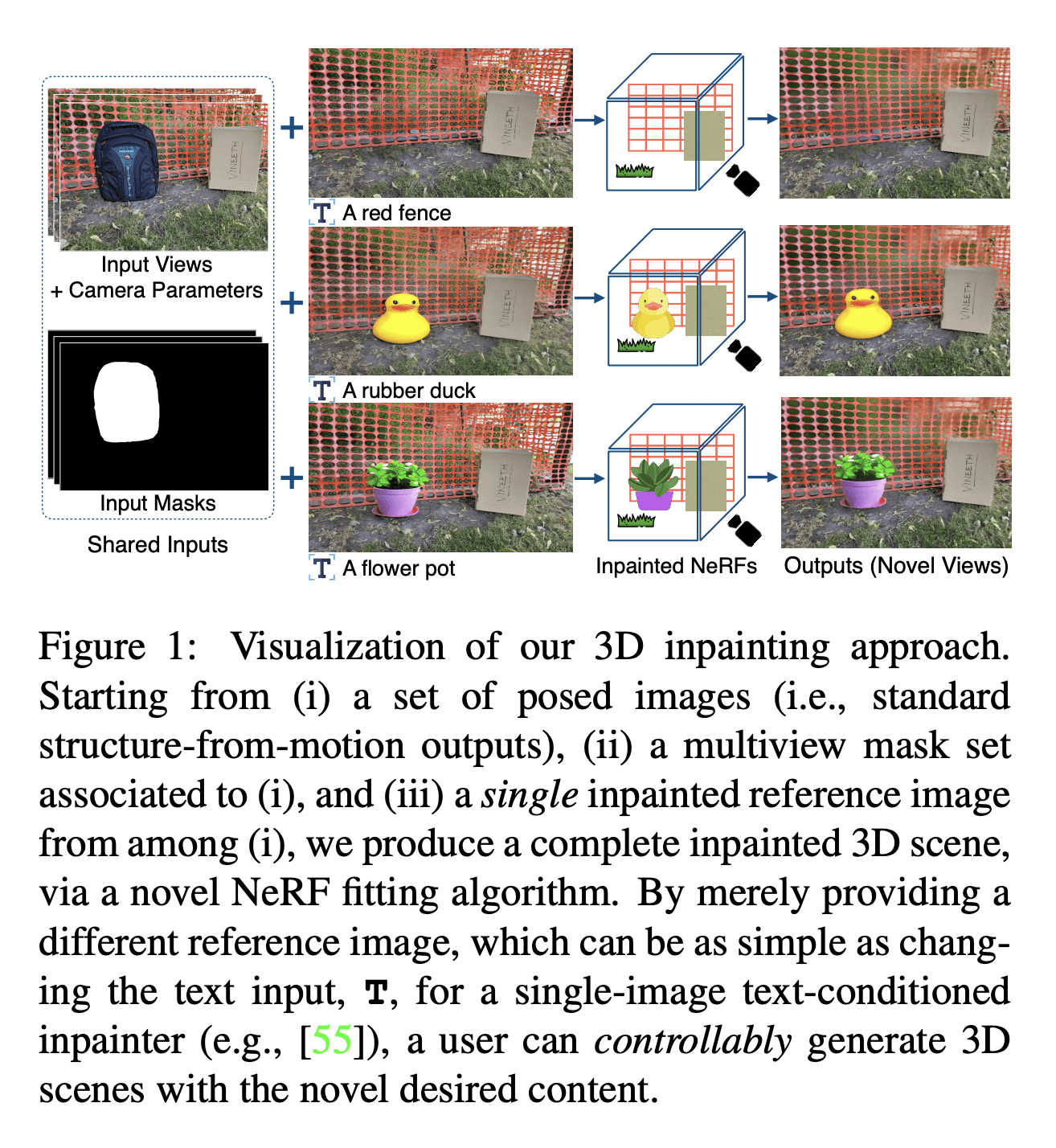

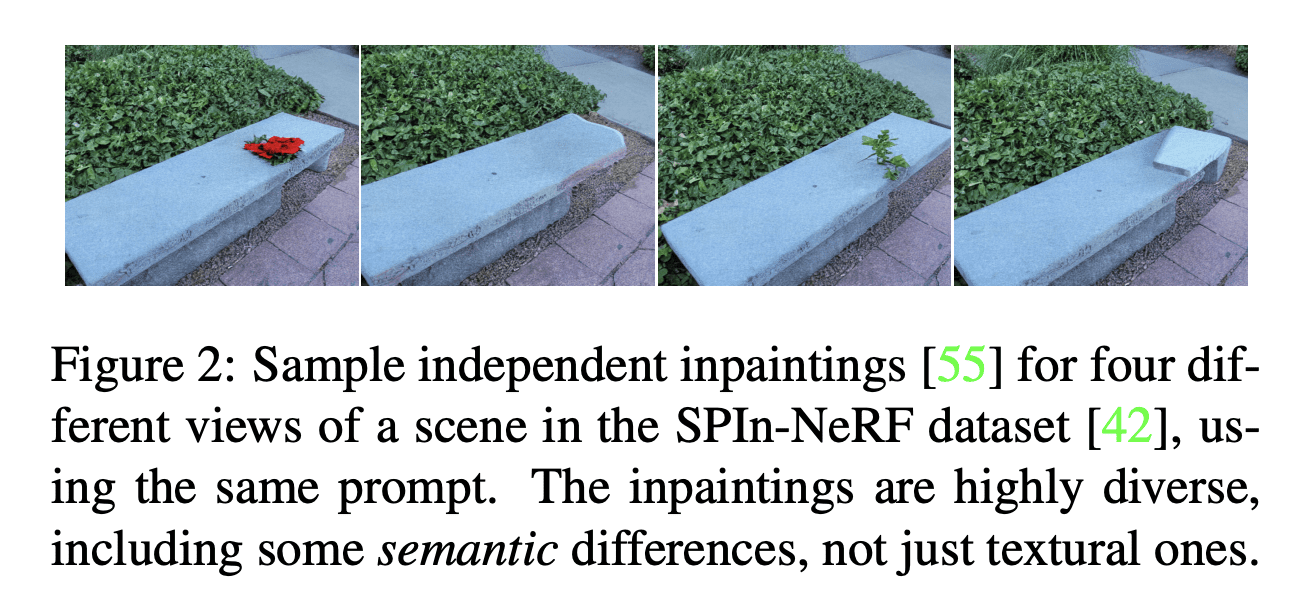

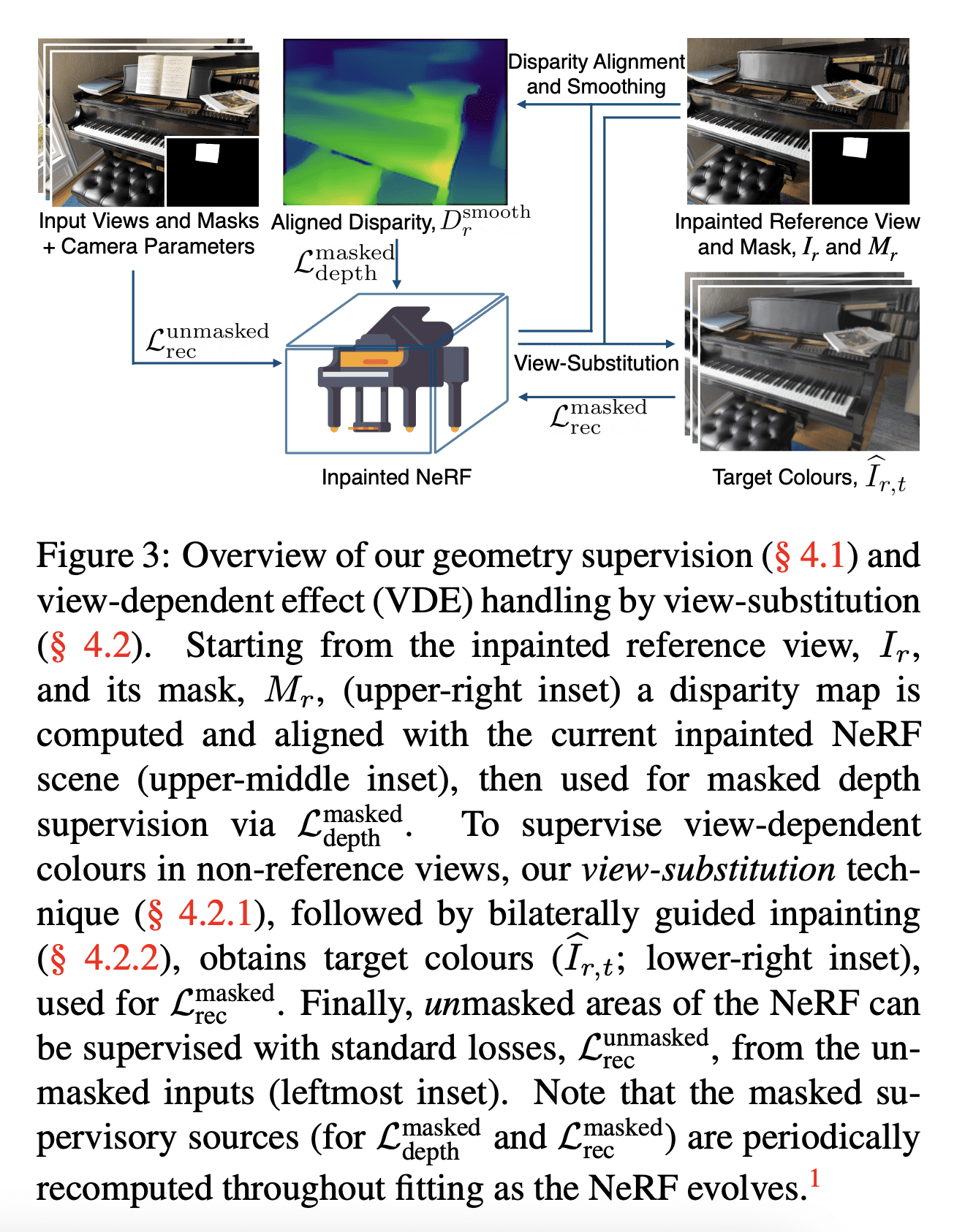

参照指导下的神经辐射场的可控补全

- 动机:由于神经辐射场在新视图合成方面的流行,人们希望开发神经辐射场的编辑工具。本文旨在提供一种在视角一致且可控的情况下的神经辐射场补全方法。

- 方法:用单个补全图像和单目深度估计器,通过一个新的渲染技术实现了非参考视角下的一致补全,并采用图像补全方法填补无法监督的区域。

- 优势:在图像质量和控制性方面有显著改进,用户只需提供一个补全图像即可轻松控制生成的3D场景。

提出一种基于参考图像的神经辐射场补全算法,能在视角一致的情况下,控制补全效果。方法包括使用单个补全图像和单目深度估计器,通过一个新的渲染技术实现了非参考视角下的一致补全,并采用图像补全方法填补无法监督的区域。与其他方法相比,在图像质量和控制性方面有显著改进。

Neural Residual Radiance Fields for Streamably Free-Viewpoint Videos

流媒体自由视点视频的神经剩余辐射场

论文:https://arxiv.org/abs/2304.04452

代码:https://aoliao12138.github.io/ReRF/

Neural Residual Radiance Fields for Streamably Free-Viewpoint Videos

Neural Fields meet Explicit Geometric Representations for Inverse Rendering of Urban Scenes

论文:https://arxiv.org/abs/2304.03266

https://www.youtube.com/watch?linkId=100000197974673&v=1KvHY3tlhhY&feature=youtu.be

基于神经场遇显式几何表示的城市场景逆向渲染

- 动机:现有的逆渲染方法无法同时处理场景的几何、材质和照明,需要一种新的方法来提高场景重建的质量和效率。

- 方法:采用一种神经场来描述主要的光线,用显式的网格来建模产生高阶光影效果(如投影阴影)的次要光线,从而实现对场景几何、材质和HDR照明的联合重建。所提出的FEGR方法可以无缝地支持不同场景操作,例如物体插入和光影效果。

- 优势:FEGR结合了神经场的高分辨率和明确网格表示的高效性,可以从一组定位的RGB图像中提取场景几何、空间变化的材料和HDR照明,并且在各种具有挑战性的数据集上优于现有技术,实现了高保真的光影重构和物体插入等物理场景操作。

提出一种新的逆渲染框架,可以从捕捉到的图像中重建城市场景的几何、材质和高动态范围照明,并实现光影和物体插入等物理场景操作。

VDN-NeRF: Resolving Shape-Radiance Ambiguity via View-Dependence Normalization

论文:https://arxiv.org/abs/2303.17968

代码:https://github.com/BoifZ/VDN-NeRF

我们提出了VDN-NeRF,这是一种训练神经辐射场(nerf)的方法,用于在非朗伯曲面和动态光照条件下获得更好的几何形状,这些条件会导致从不同角度观察时一个点的辐射发生显著变化。而不是明确地建模导致视图依赖现象的潜在因素,这可能是复杂的,但不包括,我们开发了一个简单而有效的技术,通过提取已经编码在学习的nerf中的不变信息来标准化视图依赖。然后,我们联合训练nerf用于视图合成与视图相关的归一化,以获得高质量的几何。我们的实验表明,尽管形状-亮度模糊是不可避免的,但所提出的归一化可以最大限度地减少其对几何形状的影响,这基本上符合解释视图相关变化所需的最佳容量。我们的方法适用于各种基线,并且在不改变体绘制管道的情况下显著改善几何形状,即使数据是在移动光源下捕获的。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 2023.12.29 Python面向对象 封装_继承_多台

- Zernike多项式法生成相位理论推导及图像引导实现原理

- 【Java JMM】编译和优化

- Hyperledger Fabric Docker 方式多机部署生产网络

- 记录汇川:多组练习-梯形图

- 算法导论复习(七) 动态规划

- 198. 打家劫舍

- Mac iTerm2 配置

- SpringSecurity6 | 登录失败后的JSON处理

- 基于JAVA的大学生相亲网站 开源项目