Python并行编程详解:发挥多核优势的艺术

更多资料获取

📚 个人网站:ipengtao.com

在当今计算机时代,充分发挥多核处理器的性能是提高程序运行效率的关键。Python作为一门强大的编程语言,提供了多种并行编程工具和库。本文将深入介绍Python中的并行编程,探讨如何利用多核优势,通过详实的示例代码,帮助大家更全面地理解并实践并行编程的各种技术。

使用 multiprocessing 模块

multiprocessing 模块是Python中实现并行编程的标准库,通过使用进程来并行执行任务。

import multiprocessing

def worker(task):

print(f"Executing task: {task}")

if __name__ == "__main__":

tasks = ['task1', 'task2', 'task3']

with multiprocessing.Pool(processes=3) as pool:

pool.map(worker, tasks)

这个简单的示例展示了如何使用 multiprocessing.Pool 来创建进程池,实现对任务的并行执行。

使用 concurrent.futures 模块

concurrent.futures 模块提供了更高级别的接口,例如 ThreadPoolExecutor 和 ProcessPoolExecutor,使得并行编程更加便捷。

import concurrent.futures

def worker(task):

print(f"Executing task: {task}")

if __name__ == "__main__":

tasks = ['task1', 'task2', 'task3']

with concurrent.futures.ProcessPoolExecutor() as executor:

executor.map(worker, tasks)

这个例子展示了如何使用 concurrent.futures 模块的 ProcessPoolExecutor 来实现进程级别的并行执行。

使用 asyncio 进行异步编程

asyncio 是Python的异步编程框架,通过使用 async/await 语法,可以在单线程中实现高效的并行执行。

import asyncio

async def worker(task):

print(f"Executing task: {task}")

async def main():

tasks = ['task1', 'task2', 'task3']

await asyncio.gather(*(worker(task) for task in tasks))

if __name__ == "__main__":

asyncio.run(main())

这个例子展示了如何使用 asyncio 和 async/await 语法,实现协程级别的并行执行,提高程序的响应性。

使用 joblib 进行任务并行化

joblib 是一个专注于数据并行和批处理任务的库,适用于科学计算和数据处理场景。

from joblib import Parallel, delayed

def worker(task):

print(f"Executing task: {task}")

if __name__ == "__main__":

tasks = ['task1', 'task2', 'task3']

Parallel(n_jobs=3)(delayed(worker)(task) for task in tasks)

这个例子展示了如何使用 joblib 的 Parallel 来进行任务的并行化处理,特别适用于迭代式任务。

使用 Ray 进行分布式计算

Ray 是一个开源的分布式计算框架,提供了简单而强大的 API,使得分布式任务调度变得容易。

import ray

@ray.remote

def worker(task):

print(f"Executing task: {task}")

if __name__ == "__main__":

ray.init()

tasks = ['task1', 'task2', 'task3']

ray.get([worker.remote(task) for task in tasks])

这个例子展示了如何使用 Ray 框架,通过 ray.remote 来定义远程任务,并在分布式集群上并行执行任务。

调度与同步

在并行编程中,任务的调度和同步是至关重要的。Python提供了各种工具和机制,如锁、事件、信号量等,来确保并发任务之间的协同工作。

import threading

import time

def worker(lock, task):

with lock:

print(f"Executing task: {task}")

time.sleep(1)

if __name__ == "__main__":

tasks = ['task1', 'task2', 'task3']

lock = threading.Lock()

threads = [threading.Thread(target=worker, args=(lock, task)) for task in tasks]

for thread in threads:

thread.start()

for thread in threads:

thread.join()

这个例子演示了如何使用 threading.Lock 来确保多个线程之间的任务同步,避免竞争条件。

性能优化与注意事项

并行编程虽然提高了程序的运行效率,但也伴随着性能优化和一些注意事项。例如,合理设置并发任务的数量,避免过度的并行导致资源争用。

import concurrent.futures

def worker(task):

print(f"Executing task: {task}")

if __name__ == "__main__":

tasks = ['task1', 'task2', 'task3']

with concurrent.futures.ThreadPoolExecutor(max_workers=2) as executor:

executor.map(worker, tasks)

这个例子中,

通过 max_workers 参数控制线程池的最大工作线程数量,以避免过度并行。

分布式计算的挑战与解决方案

在大规模数据和计算场景中,分布式计算是一项关键而复杂的任务。虽然框架如 Ray 提供了方便的分布式计算工具,但面临一系列挑战需要仔细考虑。以下是一些主要挑战以及相应的解决方案:

1. 数据传输与通信开销

挑战: 在分布式环境中,数据传输成为性能瓶颈,通信开销可能占据大量时间。

解决方案:

-

数据局部性优化: 尽可能将数据存储在计算节点附近,减少数据传输。

-

压缩和序列化: 使用数据压缩和序列化技术减小传输数据量,降低通信开销。

2. 任务调度和负载均衡

挑战: 有效的任务调度和负载均衡是确保分布式计算性能的关键。

解决方案:

-

智能调度算法: 使用智能的任务调度算法,根据节点负载和任务复杂性进行动态分配。

-

动态负载均衡: 实时监测节点负载,动态调整任务分布,避免节点间负载不均。

3. 容错性和数据一致性

挑战: 在分布式系统中,节点故障和数据一致性是常见问题。

解决方案:

-

容错机制: 使用容错技术,如检查点和恢复,以处理节点故障。

-

一致性协议: 使用分布式一致性协议,如Paxos或Raft,确保数据一致性。

4. 安全性

挑战: 分布式计算面临的安全威胁包括数据泄露和恶意攻击。

解决方案:

-

加密通信: 使用加密技术保护节点间通信,防止数据泄露。

-

身份验证和授权: 实施严格的身份验证和授权机制,限制对系统的未授权访问。

5. 难以调试和监控

挑战: 在分布式环境中,调试和监控变得更加困难。

解决方案:

-

分布式日志: 使用分布式日志系统,集中记录各节点的日志信息。

-

可视化工具: 使用可视化工具监控节点状态和任务执行情况,便于问题追踪。

并行编程的适用场景

并行编程在多个领域都有广泛的应用,以下是一些适用场景以及相应的代码示例:

1. 数据处理

场景: 并行处理大规模数据集。

代码示例: 使用 concurrent.futures 模块进行数据处理。

import concurrent.futures

def process_data(data):

# 数据处理逻辑

result = data * 2

return result

if __name__ == "__main__":

data_set = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10]

with concurrent.futures.ProcessPoolExecutor() as executor:

results = list(executor.map(process_data, data_set))

print("Processed Data:", results)

2. 机器学习训练

场景: 并行训练深度学习模型。

代码示例: 使用 TensorFlow 中的 tf.distribute 模块进行模型训练。

import tensorflow as tf

from tensorflow import keras

# 构建并编译模型

model = keras.Sequential([...])

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 使用分布式策略

strategy = tf.distribute.MirroredStrategy()

with strategy.scope():

# 在并行环境中训练模型

model.fit(train_dataset, epochs=5)

3. 科学计算

场景: 并行进行科学计算任务。

代码示例: 使用 NumPy 和 concurrent.futures 进行向量化操作。

import numpy as np

import concurrent.futures

def perform_computation(data):

# 科学计算任务

result = np.sqrt(data) * 2

return result

if __name__ == "__main__":

large_array = np.random.rand(1000000)

with concurrent.futures.ThreadPoolExecutor() as executor:

results = list(executor.map(perform_computation, large_array))

print("Computed Results:", results[:5])

4. 图像和信号处理

场景: 并行处理图像或信号。

代码示例: 使用 OpenCV 和 concurrent.futures 进行图像处理。

import cv2

import concurrent.futures

def process_image(image_path):

# 图像处理逻辑

image = cv2.imread(image_path)

resized_image = cv2.resize(image, (100, 100))

return resized_image

if __name__ == "__main__":

image_paths = ["image1.jpg", "image2.jpg", "image3.jpg"]

with concurrent.futures.ProcessPoolExecutor() as executor:

processed_images = list(executor.map(process_image, image_paths))

print("Processed Images:", processed_images[:2])

5. 大规模数据库查询

场景: 并行执行复杂的数据库查询。

代码示例: 使用数据库连接池和 concurrent.futures 进行并行查询。

import psycopg2.pool

import concurrent.futures

# 创建数据库连接池

db_pool = psycopg2.pool.SimpleConnectionPool(...)

def perform_database_query(query):

# 执行数据库查询

connection = db_pool.getconn()

cursor = connection.cursor()

cursor.execute(query)

result = cursor.fetchall()

db_pool.putconn(connection)

return result

if __name__ == "__main__":

queries = ["SELECT * FROM table1", "SELECT * FROM table2"]

with concurrent.futures.ThreadPoolExecutor() as executor:

query_results = list(executor.map(perform_database_query, queries))

print("Query Results:", query_results)

6. 模拟和优化

场景: 并行运行多个模拟实例或进行参数搜索。

代码示例: 使用 concurrent.futures 进行并行模拟或优化任务。

import concurrent.futures

def run_simulation(parameters):

# 模拟任务

result = simulate(parameters)

return result

if __name__ == "__main__":

simulation_parameters = [...]

with concurrent.futures.ThreadPoolExecutor() as executor:

simulation_results = list(executor.map(run_simulation, simulation_parameters))

print("Simulation Results:", simulation_results[:3])

7. 实时数据处理

场景: 并行处理实时生成的数据。

代码示例: 使用 concurrent.futures 进行实时数据处理。

import concurrent.futures

def process_realtime_data(data):

# 实时数据处理逻辑

result = data + 10

return result

if __name__ == "__main__":

realtime_data_stream = [15, 20, 25, 30, 35]

with concurrent.futures.ThreadPoolExecutor() as executor:

processed_data = list(executor.map(process_realtime_data, realtime_data_stream))

print("Processed Realtime Data:", processed_data)

异步编程的优势与适用场景

异步编程通过 asyncio 等工具提供了高效的单线程并行执行方式,适用于I/O密集型任务。这种方式避免了多线程和多进程带来的开销和复杂性,提高了程序的响应性和并发处理能力。

import asyncio

async def worker(task):

print(f"Executing task: {task}")

await asyncio.sleep(1)

async def main():

tasks = ['task1', 'task2', 'task3']

await asyncio.gather(*(worker(task) for task in tasks))

if __name__ == "__main__":

asyncio.run(main())

并行编程的调试与错误处理

并行编程中的调试和错误处理是挑战之一,由于多任务的并行执行,问题排查可能更为复杂。因此,适当的日志记录和异常处理是必不可少的。

import logging

import concurrent.futures

def worker(task):

try:

# 任务执行代码

print(f"Executing task: {task}")

except Exception as e:

logging.error(f"Error in task {task}: {e}")

if __name__ == "__main__":

tasks = ['task1', 'task2', 'task3']

with concurrent.futures.ThreadPoolExecutor() as executor:

executor.map(worker, tasks)

并行编程的安全性考虑

在并行编程中,安全性是至关重要的。对于多线程的情况,可能需要考虑线程安全的数据结构和锁机制,以防止数据竞争和不一致性。

import threading

counter = 0

counter_lock = threading.Lock()

def increment_counter():

global counter

with counter_lock:

counter += 1

if __name__ == "__main__":

threads = [threading.Thread(target=increment_counter) for _ in range(100)]

for thread in threads:

thread.start()

for thread in threads:

thread.join()

print("Counter:", counter)

总结

通过深入了解Python中的并行编程,读者可以更加自信地处理大规模计算和处理任务。并行编程为程序员提供了强大的工具,通过合理利用多核处理器和分布式集群,可以显著提升程序的性能和响应速度。在选择适当的工具和库时,务必考虑任务的性质、规模和特点,以及可能遇到的并发问题。希望本文的内容能够为读者在并行编程领域的学习和应用提供有益的指导。

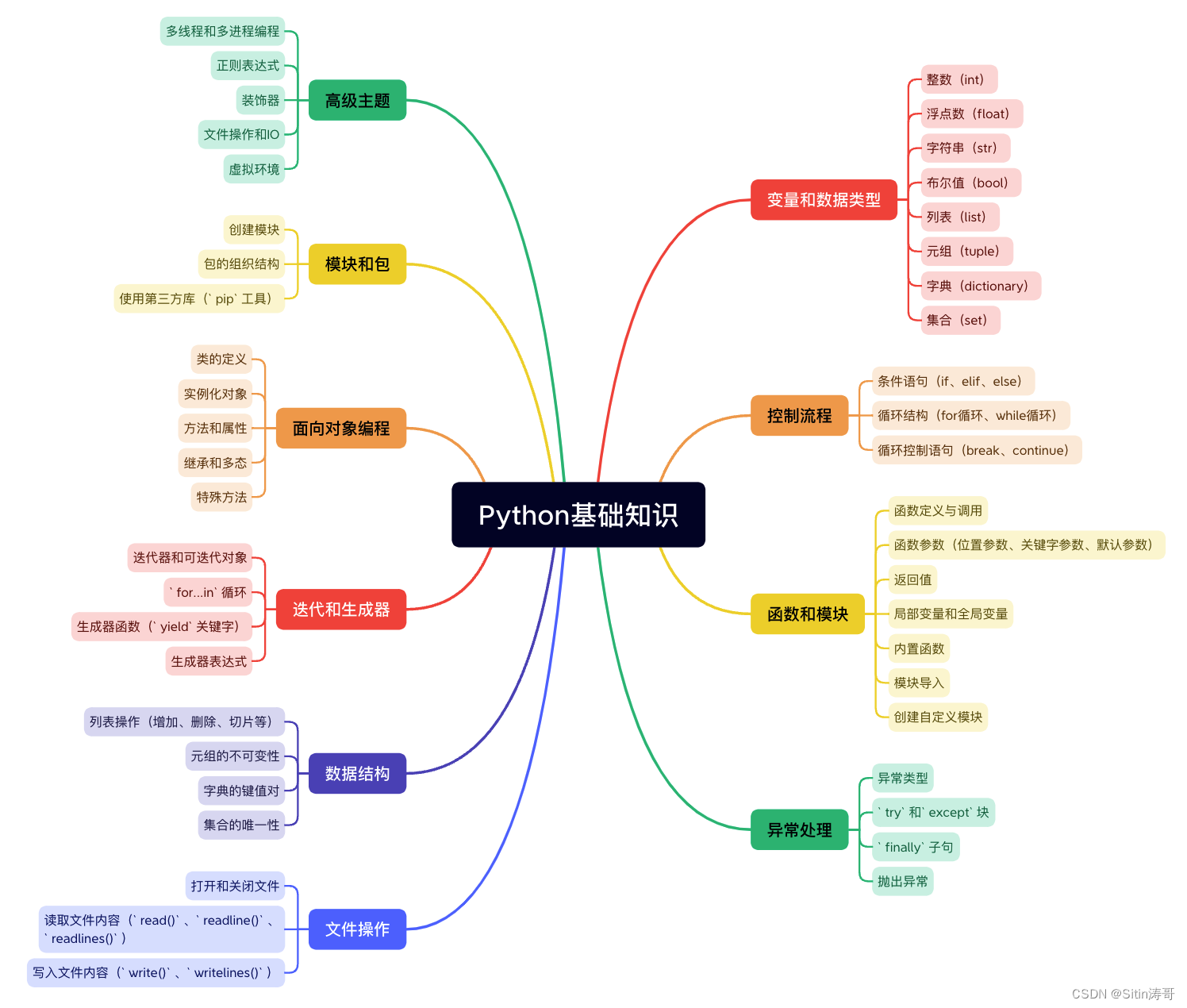

Python学习路线

更多资料获取

📚 个人网站:ipengtao.com

如果还想要领取更多更丰富的资料,可以点击文章下方名片,回复【优质资料】,即可获取 全方位学习资料包。

点击文章下方链接卡片,回复【优质资料】,可直接领取资料大礼包。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!