深度学习第6天:ResNet深度残差网络

发布时间:2023年12月23日

??主页 Nowl

🔥专栏 《深度学习》

📑君子坐而论道,少年起而行之

??

什么是ResNet

ResNet是一种用于图像识别的深度残差网络,是卷积神经网络的一种重要模型,ResNet开创性地引入了残差连接,解决了深层网络在训练过程中梯度弥散的问题,使深层模型的训练更加简便,同时也验证了随着网络层次的加深模型能够获得更好的性能

模型结构

整体架构

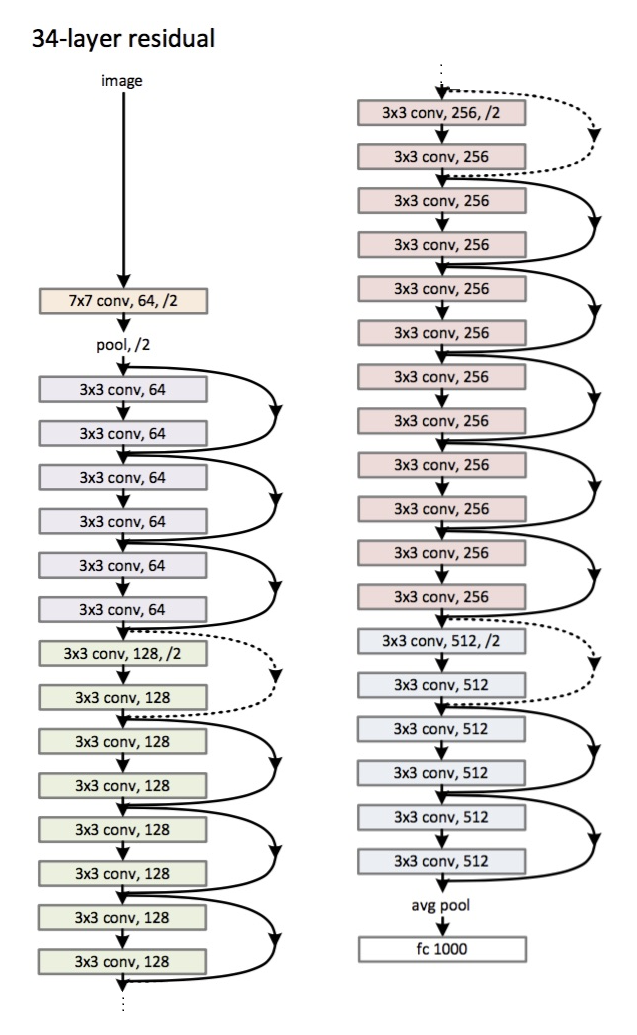

ResNet有许多模型:如ResNet34, ResNet50,不过这些基本上都是根据层数来命名的,ResNet网络模型一般是开始有一层卷积层来提取图像特征,再经过池化,然后进入残差块中(ResNet的主要结构),最后再经过池化层与全连接层被输出出来,下图是一个ResNet34的模型示意图

残差块

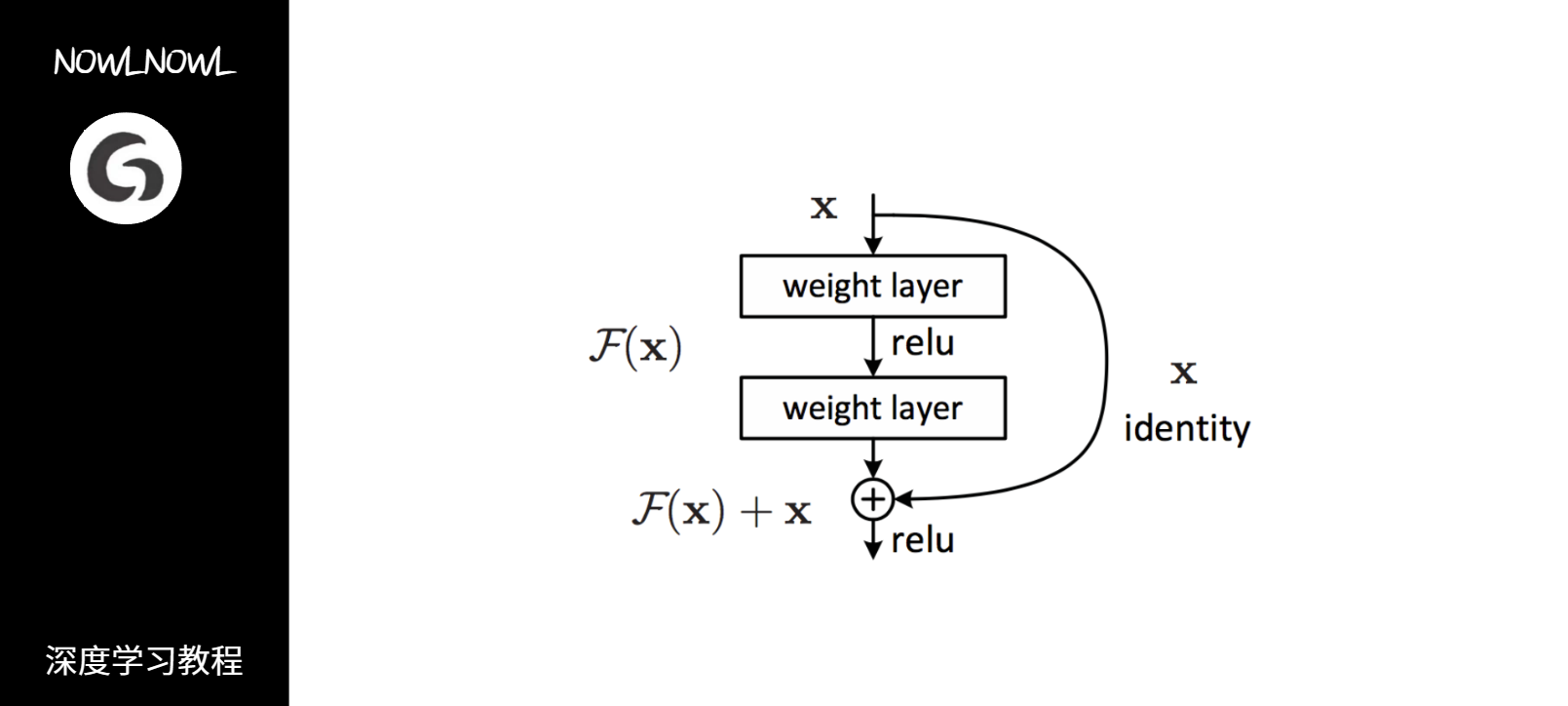

下面是resnet的关键结构——残差块,它由两个卷积层和一个直连通路组成 右侧曲线被称为直连通路,直连通路有助于解决梯度消失的问题,因为此时当神经网络反向传播求权重时,因为这个多项式即使前一部分的梯度消失了,后一部分还能保证梯度的存在

右侧曲线被称为直连通路,直连通路有助于解决梯度消失的问题,因为此时当神经网络反向传播求权重时,因为这个多项式即使前一部分的梯度消失了,后一部分还能保证梯度的存在

模型特性

- 直连通路的存在使得模型可以保留原始数据信息,同时可以解决梯度弥散的问题(梯度消失)

- 可以通过堆叠增加网络层数,不过当模型过于深时,性能可能下降,经原作者试验,在1000层左右的范围内,模型性能随层数增加而增加

- 直连通路的结果与卷积层结果直接相加,使得模型在训练过程中只需要拟合不同层网络输出值与输入值的残差值,而无需直接拟合网络输出值,大大降低了模型学习的难度,有助于模型的收敛

示例代码

以下是一个简化的 ResNet 模型中,有以下主要组件:

- 卷积层(Conv2D):模型开始的卷积层,用于提取图像特征。

- 最大池化层(MaxPool):提取图像中显著的特征

- 4 个残差块(residual_block):每个残差块包括两个卷积层。

- 全局平均池化层(GlobalAveragePooling2D):用于将每个通道的特征平均化,产生一个固定大小的输出。

- 全连接层(Dense):输出层,根据任务的不同可能有不同的神经元数量。

import tensorflow as tf

from tensorflow.keras import layers, Model

def residual_block(x, filters, kernel_size=3, stride=1, conv_shortcut=False):

shortcut = x

if conv_shortcut:

shortcut = layers.Conv2D(filters, kernel_size=1, strides=stride, padding='same')(shortcut)

shortcut = layers.BatchNormalization()(shortcut)

x = layers.Conv2D(filters, kernel_size, strides=stride, padding='same')(x)

x = layers.BatchNormalization()(x)

x = layers.Activation('relu')(x)

x = layers.Conv2D(filters, kernel_size, padding='same')(x)

x = layers.BatchNormalization()(x)

x = layers.add([x, shortcut])

x = layers.Activation('relu')(x)

return x

def resnet(input_shape, num_classes=10):

inputs = tf.keras.Input(shape=input_shape)

x = layers.Conv2D(64, 7, strides=2, padding='same')(inputs)

x = layers.BatchNormalization()(x)

x = layers.Activation('relu')(x)

x = layers.MaxPooling2D(3, strides=2, padding='same')(x)

x = residual_block(x, 64)

x = residual_block(x, 64)

x = residual_block(x, 128, stride=2)

x = residual_block(x, 128)

x = residual_block(x, 256, stride=2)

x = residual_block(x, 256)

x = residual_block(x, 512, stride=2)

x = residual_block(x, 512)

x = layers.GlobalAveragePooling2D()(x)

x = layers.Dense(num_classes, activation='softmax')(x)

model = Model(inputs, x)

return model

# 创建ResNet模型

model = resnet(input_shape=(224, 224, 3), num_classes=1000)

# 打印模型概要

model.summary()

文章来源:https://blog.csdn.net/MuRanstr/article/details/135169702

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- SpringCloud微服务详解,Dockerfile自定义镜像、DockerCompose

- 安装pillow遇到的问题详细讲解

- 运维平台介绍:视频智能运维平台的视频质量诊断分析和监控中心

- Camunda简介

- 葡萄酒术语中的“香气”与“花束”区别在哪里?

- 从零开发短视频电商 SageMaker实时推理实例和费用

- 全程云OA ajax.ashx SQL注入漏洞复现

- GEE中Landsat、Sentinel、Modis主要数据集区别

- git add -A 和 git add -u 和 git add . 的区别

- Linux系统报错锦集二: engine libaio not loadable