【pynput】鼠标行为追踪并模拟

发布时间:2023年12月24日

利用本文内容从事的任何犯法行为和开发与本人无关,请理性利用技术服务大家,创建美好和谐的社会,让人们生活从繁琐中变得更加具有创造性!

前言

这前面文章中,提到了【实时屏幕捕获】的内容,这篇文章则是为大家介绍在现代计算机环境中,鼠标行为追踪的有效的方法,并通过记录和分析用户的鼠标操作,可以减少重复性工作,提高工作效率。尤其是在一些固定且重复的任务中,如接口测试、参数测试等,鼠标行为追踪为自动化提供了可能。

类似于手机上面的语言助手,不是有一个特定语言执行特定动作的功能吗,这个就类似于它,目前之所以做鼠标行为追踪并模拟是为了后面开展更加高级的功能。

基本思路

- 利用按键或时间限制捕获时间段

- 利用 OpenCV 实现鼠标位置点的追踪

- 记录每次操作位置点并回溯

安装依赖包

首先,我们需要安装所需的库。在终端或命令提示符中执行以下命令:

pip install opencv-python pyautogui numpy pynput

opencv-python:用于提供了丰富的图像处理和计算机视觉算法

pyautogui:用于捕获屏幕画面

numpy:用于处理大型多维数组和矩阵,以及执行与数据结构相关的数学运算

pynput:用于捕获以及控制鼠标和键盘

实时鼠标捕获

捕获鼠标位置

通过获取鼠标的位置,可以清晰地判断用户操作的区域:

from pynput import mouse as mos

# 鼠标控制器

mouse = mos.Controller()

# 获取当前鼠标位置

mouse.position

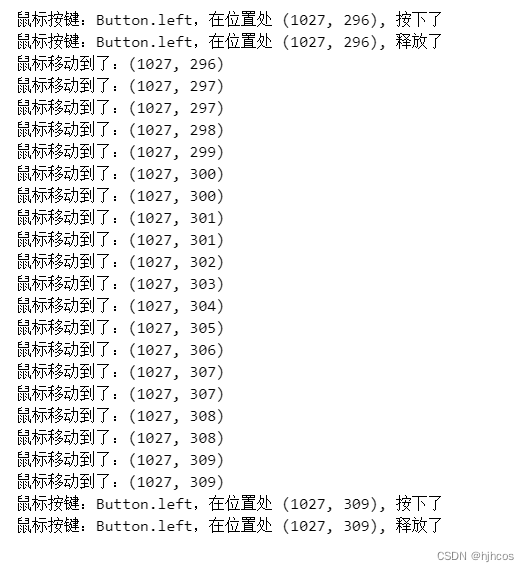

捕获鼠标事件

鼠标事件有三种分为:鼠标移动、点击以及滚轮滚动:

# 移动监听

def on_move(x, y):

print(f'鼠标移动到了:{(x, y)}')

# 点击监听

def on_click(x, y, button, pressed):

print(f'鼠标按键:{button},在位置处 {(x, y)}, {"按下了" if pressed else "释放了"} ')

if not pressed:

# 停止监听

return False

# 滚动监听

def on_scroll(x, y, dx, dy):

print(f'滚动中... {"向下:" if dy < 0 else "向上:"} 至 {(x, y)}')

# 构造监听器对象

listener = mos.Listener(

on_move=on_move,

on_click=on_click,

on_scroll=on_scroll)

# 监听启动

listener.start()

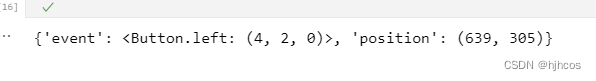

记录点击内容

根据鼠标点击来记录用户点击内容,可以有效地分析用户的行为和爱好,更好地像学徒一样去理解用户的行为,从而达到掌握其技巧:

import pyautogui

import numpy as np

import cv2

user_click_pos = {'event': None, 'position': None}

# 获取屏幕画面并保存

def save_screen():

# 获取屏幕截图

screenshot = pyautogui.screenshot()

# 将截图转换为 OpenCV 格式

screen_img = cv2.cvtColor(np.array(screenshot), cv2.COLOR_RGB2BGR)

# 保存截图

cv2.imwrite("screen_img.png", screen_img)

# 点击监听并记录用户点击事件

def on_click(x, y, button, pressed):

save_screen()

user_click_pos['event'] = button

user_click_pos['position'] = (x, y)

if not pressed:

# 停止监听

return False

# 构造监听器对象

listener = mos.Listener(on_click=on_click)

# 监听启动

listener.start()

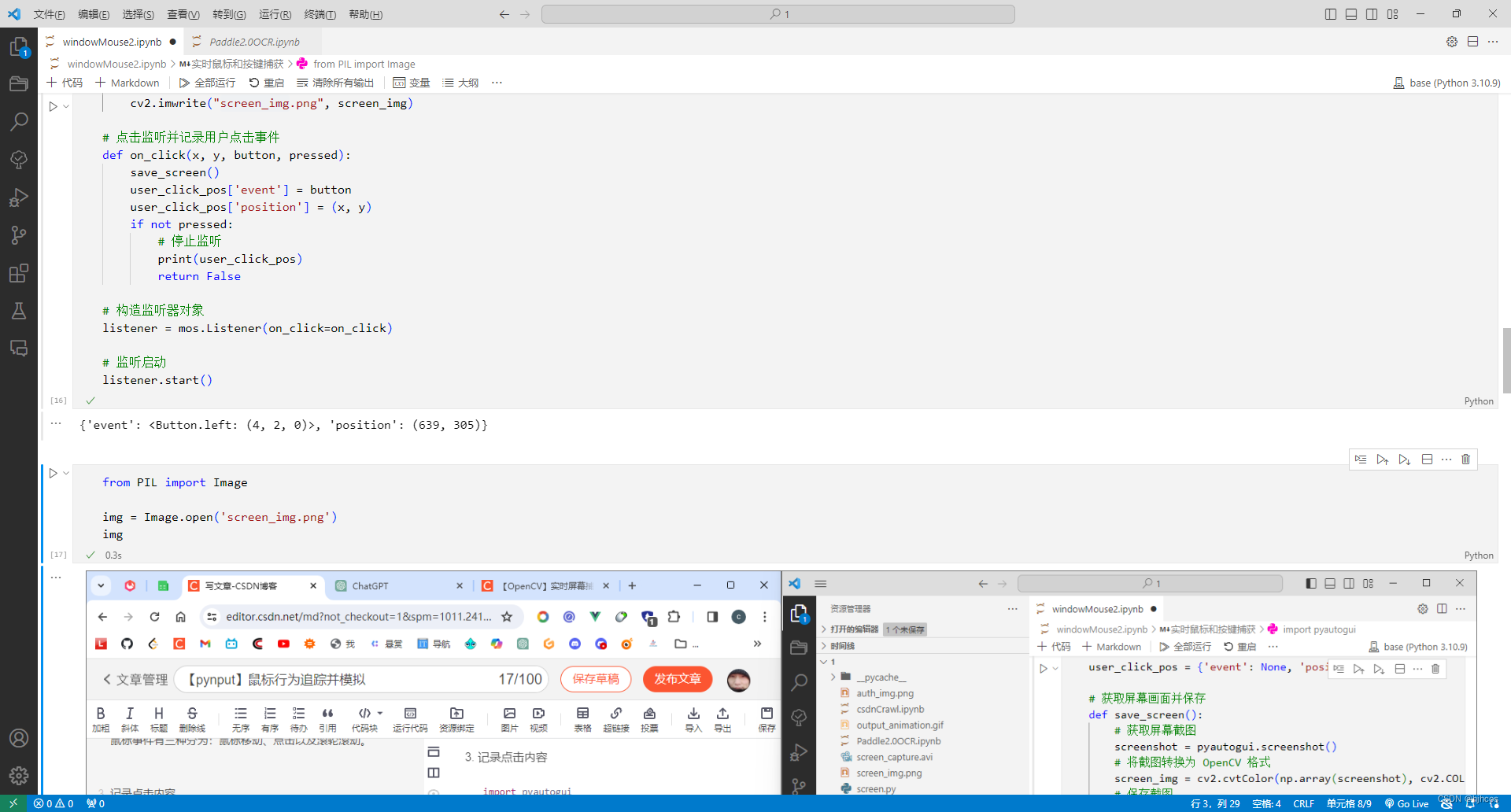

效果图

文章来源:https://blog.csdn.net/hjh_cos/article/details/135176102

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- MySQL,练习

- 代码随想录算法训练营Day23 | 455.分发饼干、376.摆动子序列、53.最大子数组和

- Python服务器监控利器:教你如何实时追踪服务器在线状态!

- Linux中关于tail命令详解

- 孩子还是有一颗网安梦——Bandit通关教程:Level 14 → Level 15

- HTML基础:打开网页魔法的大门

- 【数据结构】二叉树链式结构详解

- Docker知识点整理

- 【利用Yolov8实现多个检测模型融合】

- 关于“Python”的核心知识点整理大全34