翻译: ChatGPT Token消耗粗略计算英文就是除以四分之三

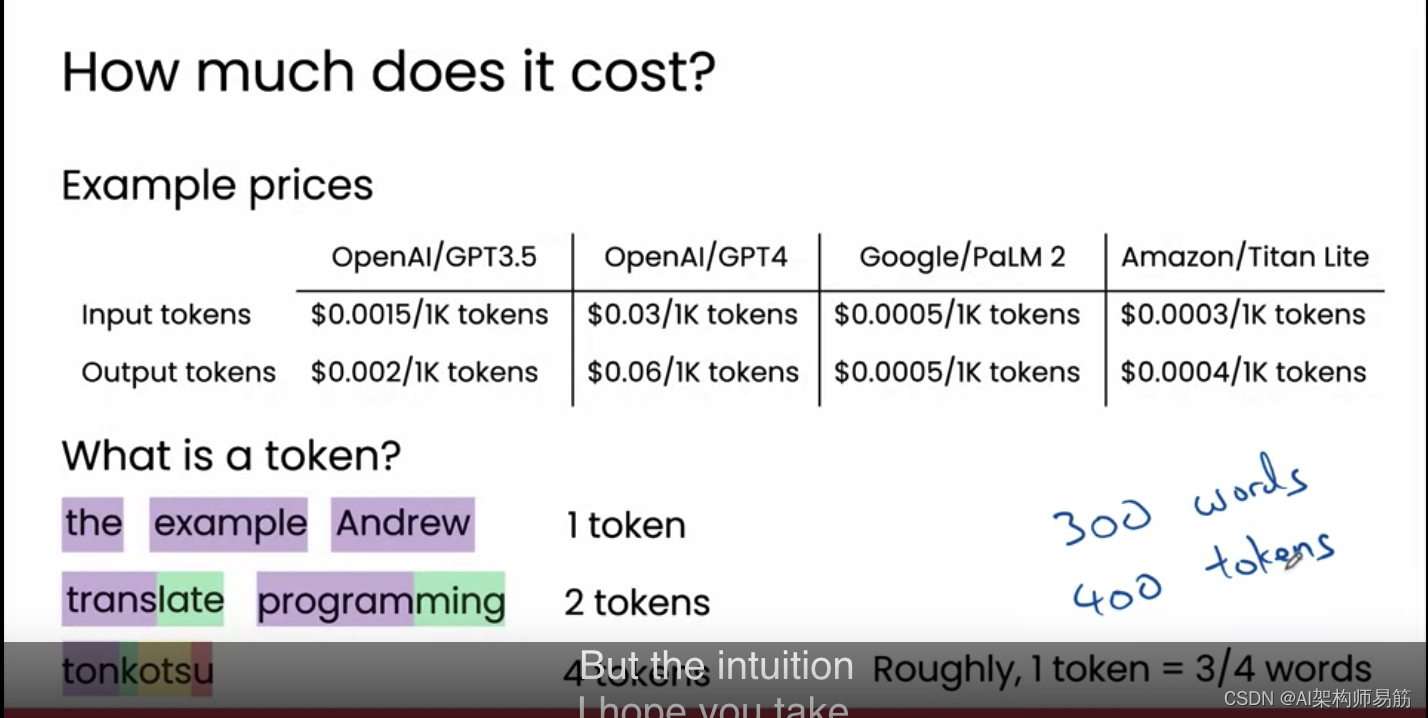

在这个视频中,我想带你快速浏览一些例子,以建立对在软件应用中使用大型语言模型的实际成本的直观感受。让我们来看看。这是一些示例价格,用于从不同的大型语言模型获取提示和回应,这些模型对开发者可用。即,如果你在你的代码中调用这些大型语言模型。OpenAI/GPT3.5每1000个Token收费0.002美元。也就是每1000个Token 0.2美分。GPT4的成本要高得多,每1000个Token 6美分,而谷歌的PaLM 2和亚马逊的Titan Lite也相当便宜。我在这里展示的是生成不同数量Token的成本。技术上,这些大型语言模型也会对提示的长度收费,但提示的长度,有时称为输入Token,几乎总是比输出Token的成本便宜。

现在我们只关注输出Token的成本。你可能会想,什么是Token?事实证明,Token大致是一个单词或单词的一部分。因为这就是大型语言模型处理文本的方式。常见的单词如“the”或“example”在大型语言模型处理时会被计为一个单独的Token。或者我的名字Andrew,是一个相对常见的名字,所以也是一个单独的Token。但不太常见的词如“translate”可能会被大型语言模型分割为两个Token,“tran”和“slate”,因此生成“translate”将花费你两个输出Token。不像更常见的单词,只会花费你一个Token。或者“programming”,可能会被LLM分为“program”和“ming”,也花费两个Token。一个不那么频繁的词如“tonkotsu”可能会被分为四个Token,如“ton”和“k”、“ots”和“u”。

但在大量文本文档的平均水平上,大约每个Token是3/4个单词。如果你要生成300个单词,那将花费你大约400个Token。如果数学没有完全理解也没关系。但我希望你从中获得的直觉是,Token的数量大致等于单词的数量,但稍微多一点。事实证明,大约比单词的数量多33%。在下一张幻灯片上,我们将使用每1000个Token 0.2美分的成本进行这个计算。但当然,如果你使用不同的LLM选项,成本可能会更高或更低。

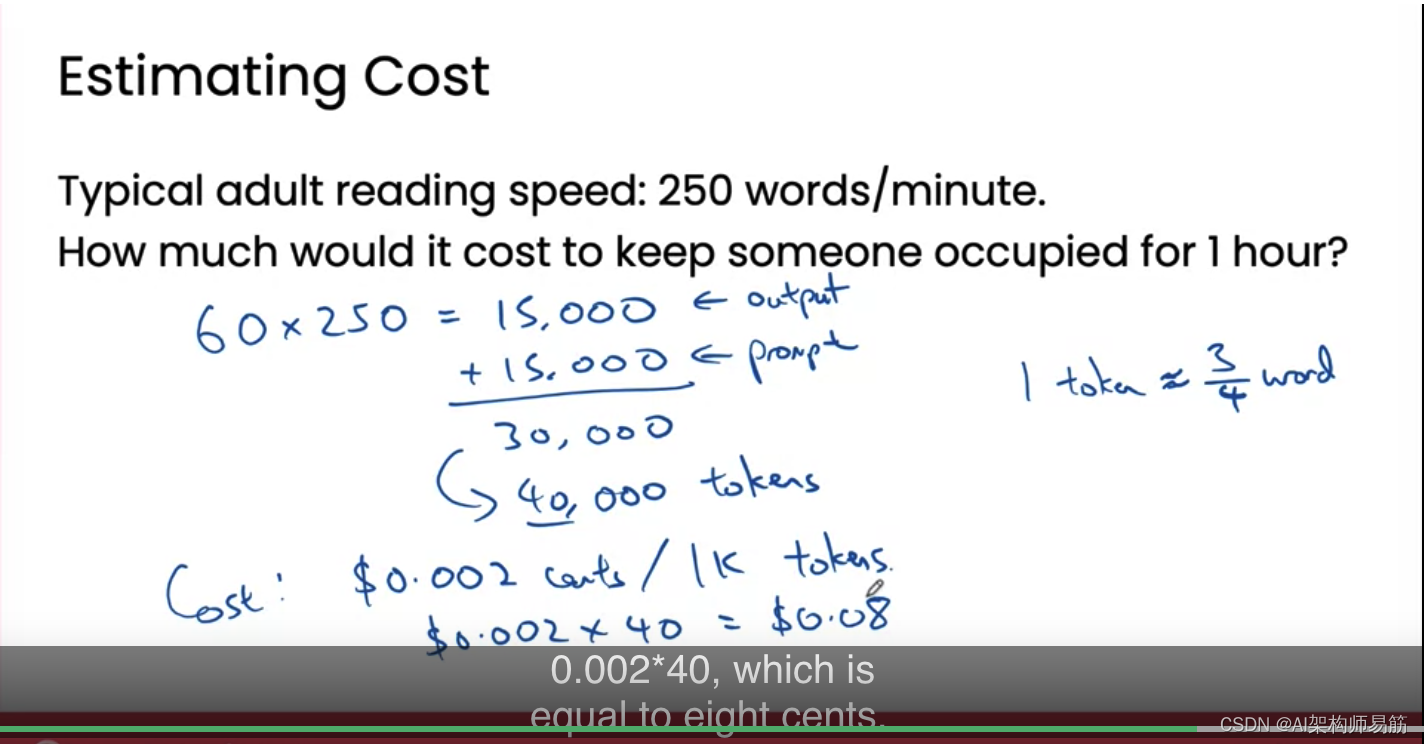

想象一下,你正在为自己的团队构建一个LLM应用,可能会生成对他们阅读有用的文本。让我们估计生成足够的文本以让你团队中的某人忙上一小时的成本。成年人的典型阅读速度可能是每分钟大约250个单词。为了让某人忙上一小时,你需要生成60*250个单词,即15000个单词,这是LLM输出的。但我们也需要提示LLM来生成这个输出。如果我们假设提示的长度与输出的长度相当,那可能会增加另外15000个单词。也就是说,如果我们需要总共提示15000个单词的输入,然后还要生成15000个单词的输出,以让某人忙上一小时。

当然,这是一个非常粗略的假设,但对于建立直觉来说已经足够好。总共我们需要支付3万个单词的费用。正如我们在上一张幻灯片上看到的,因为每个Token大约对应3/4个单词,3万个单词大约对应4万个Token。如果每1000个Token的成本是0.002美分,那么生成4万个Token的成本是0.002*40,即8美分。如果你的软件应用使用的是OpenAI、Azure、谷歌或AWS等提供的云托管LLM服务,那么让某人忙上一个小时的成本可能是8美分。我在这个计算中没有做很多假设,但这似乎相当便宜。在美国,许多地方的最低工资可能在每小时10-15美元左右,所以为某人密集阅读额外支付每小时8美分似乎是一个小的增量成本,特别是如果它帮助他们更高效。当然,如果你有一个百万用户正在使用的免费产品,那么8美分乘以一百万次,没有相关收入,可能会变得昂贵。但我发现,对于许多应用程序来说,使用LLM的成本比大多数人认为的要便宜。我希望这能给你提供一些关于LLM成本的有用直觉。让我们继续看下一个视频。我们将了解一些更先进的技术,它们可以使你的LLM变得更加强大。下一个视频见。

参考

https://www.coursera.org/learn/generative-ai-for-everyone/lecture/6BrQX/cost-intuition

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【音视频 ffmpeg 】直播推流QT框架搭建

- exp imp 详解 include 不通用 content DATA_ONLY

- c# OpenCvSharp透视矫正参数调整器

- 力扣(leetcode)第257题二叉树的所有路径(Python)

- 「品牌变革必备」品牌战略咨询公司精选策略,引领企业焕新之路

- 【从浅到深的算法技巧】2.语句

- python+django超市进销存仓库管理系统s5264

- 当前从 Python 调用 C/C++ 代码的有多少种方法、最佳方案是什么?

- 【Vue3】2-11 : 生命周期钩子函数及原理分析

- kubesphere和k8s的使用分享