Keras实现seq2seq

发布时间:2024年01月06日

概述? ? ??

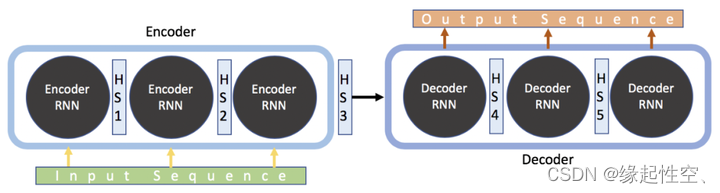

? ? ? ? ? Seq2Seq是一种深度学习模型,主要用于处理序列到序列的转换问题,如机器翻译、对话生成等。该模型主要由两个循环神经网络(RNN)组成,一个是编码器(Encoder),另一个是解码器(Decoder)。

? ? ? ? Seq2Seq被提出于2014年,最早由两篇文章独立地阐述了它主要思想,分别是Google Brain团队的《Sequence to Sequence Learning with Neural Networks》和Yoshua Bengio团队的《Learning Phrase Representation using RNN Encoder-Decoder for Statistical Machine Translation》。这两篇文章针对机器翻译的问题不谋而合地提出了相似的解决思路,Seq2Seq由此产生。

工作原理

- 编码阶段:输入一个序列,使用RNN(Encoder)将每个输入元素转换为一个固定长度的向量,然后将这些向量连接起来形成一个上下文向量(context vector),用于表示输入序列的整体信息。

- 转换阶段:将上下文向量传递给另一个RNN(Decoder),在每个时间步,根据当前的上下文向量和上一个输出生成一个新的输出,直到生成一个特殊的结束符号,表示序列的结束。

- 训练阶段:根据目标序列和生成的输出之间的差异计算损失,并使用反向传播算法优化模型的参数,以减小损失。

- 预测或生成阶段:使用训练好的模型根据输入序列生成目标序列。

示例?

# 导入所需的库和模块

from keras.models import Model

from keras.layers import Input, LSTM, Dense

#定义输入维度

#词汇表大小

vocab_size = 10000

#序列最大长度

max_seq_len = 100

#定义编码器模型

#编码器的输入层,形状为(max_seq_len,)

encoder_input = Input(shape=(max_seq_len,))

#使用LSTM层作为编码器的主要结构,输出维度为

encoder_output = LSTM(128)(encoder_input)128

#创建编码器模型,输入为encoder_input,输出为encoder_output

encoder_model = Model(encoder_input, encoder_output)

#定义解码器模型

#解码器的输入层,形状为(max_seq_len, vocab_size)

decoder_input = Input(shape=(max_seq_len, vocab_size))

#使用LSTM层作为解码器的主要结构,输出维度为128

decoder_output = LSTM(128)(decoder_input)

#使用全连接层作为解码器的输出层,输出维度为词汇表大小,激活函数为softmax

decoder_output = Dense(vocab_size, activation='softmax')(decoder_output)

#创建解码器模型,输入为decoder_input,输出为decoder_output

decoder_model = Model(decoder_input, decoder_output)

#构建Seq2Seq模型

#Seq2Seq模型的输入层,形状为(max_seq_len, vocab_size)

seq2seq_input = Input(shape=(max_seq_len, vocab_size))

#将编码器模型作为Seq2Seq模型的前半部分

seq2seq_output = encoder_model(seq2seq_input)

#将解码器模型作为Seq2Seq模型的后半部分

seq2seq_output = decoder_model(seq2seq_output)

#创建Seq2Seq模型,输入为seq2seq_input,输出为seq2seq_output

seq2seq_model = Model(seq2seq_input, seq2seq_output)

# 编译模型

seq2seq_model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy']) # 设置损失函数为分类交叉熵,优化器为Adam,评估指标为准确率

# 训练模型(此处仅为示例,实际训练数据和训练过程需要根据具体任务进行设置)

seq2seq_model.fit(x_train, y_train, batch_size=64, epochs=10)

? ? ? ? ?在以上示例代码中首先导入了所需的库和模块,包括Keras中的Model、Input、LSTM和Dense。然后定义了输入维度,包括词汇表大小和序列最大长度。接下来分别定义了编码器和解码器模型。编码器模型使用LSTM层作为主要结构,输出维度为128;解码器模型同样使用LSTM层作为主要结构,输出维度为词汇表大小,并使用softmax激活函数。最后,通过将编码器和解码器模型组合起来构建了Seq2Seq模型。在构建完Seq2Seq模型后,使用compile方法对模型进行编译,设置了损失函数为分类交叉熵,优化器为Adam,评估指标为准确率。最后一行代码是训练示例,实际使用时需要根据具体的训练数据和训练过程进行设置。

文章来源:https://blog.csdn.net/lymake/article/details/135418923

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 不同分子成像方式的比较-分辨率敏感度

- vim一般使用

- 2023 搞懂git 工作目录---暂存区---本地仓库---版本库

- 【SD】tile 模型 - 固定衣服 生成人物 ?

- 乐观锁和悲观锁。看了就会。。易懂。

- np.bincount函数的用法

- 环信 CocoaPods could not find compatible versions for pod “HyphenateChat“:报错

- Kubernetes (五) Init容器及探针

- PDF-XChange Editor v10.2.0.384

- zabbix监控部署