Spark-SQL电商大数据驱动精准营销

引言?

????????大数据,作为21世纪最重要的技术之一,正在引领着全球的信息革命。随着互联网的快速发展和智能设备的普及,我们正处在一个数据爆炸的时代。海量的数据不仅催生了新的商业模式和产业形态,而且正在改变着我们的日常生活。

????????大数据给商业带来了巨大的机遇。通过收集、存储和分析海量的数据,企业可以更好地了解市场需求、消费者行为和竞争对手动态。这样的洞察力可以帮助企业做出准确的决策,提高效率和竞争力。例如,电子商务平台可以根据用户的浏览和购买记录,精确地推荐符合其兴趣和需求的商品,提升购物体验和销售额。同时,大数据还可以帮助企业预测市场趋势,优化供应链管理,降低成本,增加营收。

背景描述: 某电商平台希望通过大数据分析,提高用户购买转化率和销售额。他们拥有海量的用户数据,包括浏览记录、购买记录、个人信息等。

????????该电商平台能够更好地了解用户需求,提供个性化的推荐和优惠,从而提高用户购买转化率和销售额。通过数据分析,他们可以精确把握用户喜好,减少广告推送的盲目性,提高广告投放的回报率。电商大数据的实操案例可以帮助企业更好地了解用户需求,优化营销策略,提高销售额。通过数据分析和个性化推荐,可以提升用户体验,增加用户忠诚度。同时,企业也需要关注数据安全和隐私保护,确保大数据的合法使用和合规运营。

简单案例实现

下面是一个使用Hadoop、Hive和Spark进行电商用户购买行为分析的操作命令和代码示例

在Hive中创建用户购买记录表。打开Hive终端,执行以下命令:

-- 创建用户购买记录表

CREATE TABLE user_purchase (

user_id INT,

product_id INT,

purchase_time TIMESTAMP

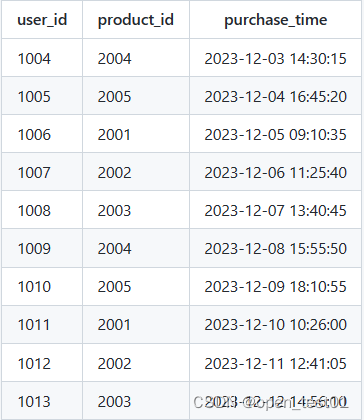

) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',' STORED AS TEXTFILE;INSERT INTO user_purchase VALUES

(1004, 2004, '2023-12-03 14:30:15'),

(1005, 2005, '2023-12-04 16:45:20'),

(1006, 2001, '2023-12-05 09:10:35'),

(1007, 2002, '2023-12-06 11:25:40'),

(1008, 2003, '2023-12-07 13:40:45'),

(1009, 2004, '2023-12-08 15:55:50'),

(1010, 2005, '2023-12-09 18:10:55'),

(1011, 2001, '2023-12-10 10:26:00'),

(1012, 2002, '2023-12-11 12:41:05'),

(1013, 2003, '2023-12-12 14:56:10');

????????Spark中创建一个完整的工程,并执行数据查询和计算指标的操作,并将结果插入到MySQL数据库中

代码中包含以下指标计算:

- purchase_count(购买记录数量):计算user_purchase表中的记录总数,即购买记录的数量。

- user_purchase_count(每个用户的购买次数):对user_purchase表按user_id进行分组,计算每个用户的购买次数。

- product_sales(每个产品的销售次数):对user_purchase表按product_id进行分组,计算每个产品的销售次数。

- daily_sales(每天的销售次数):将purchase_time字段转换为日期,并对user_purchase表按日期进行分组,计算每天的销售次数。

- user_total_amount(每个用户的总购买金额):对user_purchase表按user_id进行分组,计算每个用户的总购买金额。

这些指标可以提供有关购买行为的统计信息,例如购买量、用户偏好、产品热销情况等

import org.apache.spark.sql.{SparkSession, SaveMode}

object MetricCalculation {

def main(args: Array[String]): Unit = {

// 创建SparkSession

val spark = SparkSession.builder()

.appName("Metric Calculation")

.getOrCreate()

// 注册DataFrame为临时表

df.createOrReplaceTempView("user_purchase")

// 执行SQL查询操作

val count = spark.sql("SELECT COUNT(*) as purchase_count FROM user_purchase").first().getAs[Long]("purchase_count")

println(s"购买记录数量: $count")

val userPurchaseCount = spark.sql("SELECT user_id, COUNT(*) as purchase_count FROM user_purchase GROUP BY user_id")

userPurchaseCount.show()

val productSales = spark.sql("SELECT product_id, COUNT(*) as sales_count FROM user_purchase GROUP BY product_id")

productSales.show()

val dailySales = spark.sql("SELECT DATE(purchase_time) as purchase_date, COUNT(*) as daily_sales FROM user_purchase GROUP BY DATE(purchase_time)")

dailySales.show()

val userTotalAmount = spark.sql("SELECT user_id, SUM(amount) as total_amount FROM user_purchase GROUP BY user_id")

userTotalAmount.show()

// 将结果插入到MySQL数据库

val mysqlProperties = new java.util.Properties()

mysqlProperties.setProperty("driver", "com.mysql.jdbc.Driver")

mysqlProperties.setProperty("user", "your_username")

mysqlProperties.setProperty("password", "your_password")

userPurchaseCount.write.mode(SaveMode.Append)

.jdbc("jdbc:mysql://your_mysql_host:your_mysql_port/your_database", "user_purchase_count", mysqlProperties)

productSales.write.mode(SaveMode.Append)

.jdbc("jdbc:mysql://your_mysql_host:your_mysql_port/your_database", "product_sales", mysqlProperties)

dailySales.write.mode(SaveMode.Append)

.jdbc("jdbc:mysql://your_mysql_host:your_mysql_port/your_database", "daily_sales", mysqlProperties)

userTotalAmount.write.mode(SaveMode.Append)

.jdbc("jdbc:mysql://your_mysql_host:your_mysql_port/your_database", "user_total_amount", mysqlProperties)

}

}

在代码中,通过Spark的SQL查询来计算这些指标,并将结果使用write方法写入到MySQL数据库中的不同表中。为了连接到MySQL数据库,我们设置了相关的属性,如MySQL数据库的驱动程序、用户名、密码等。

在实际应用中,需要根据自己的需求和数据结构调整代码中的表名、连接参数以及MySQL数据库的主机和端口等配置信息。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!