MS-DETR论文解读

前言

今天,偶然看到MS-DETR论文,以为又有什么高逼格论文诞生了。于是,我想查看一番,改论文讨论原始DETR中使用一对一监督的传统训练过程缺乏对对象检测候选者的直接监督。本文旨在通过混合一对一监督和一对多监督来明确监督候选生成过程,从而提高DETR训练效率。本文最主要贡献在解码decoder实现行一对多监督。实验结果表明,我们的方法优于相关的DETR变体,如DN-DETR、Hybrid DETR和Group DETR,并且与相关DETR变体的组合进一步提高了性能。本博客将带领读者共同探讨此文章。

一、摘要

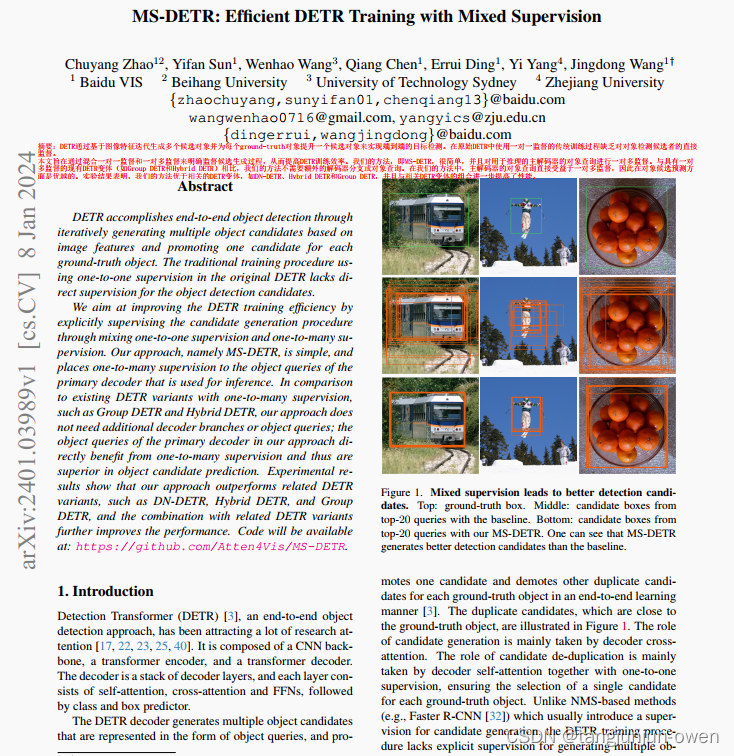

摘要:DETR通过基于图像特征迭代生成多个候选对象并为每个ground-truth对象提升一个候选对象来实现端到端的目标检测。在原始DETR中使用一对一监督的传统训练过程缺乏对对象检测候选者的直接监督。

本文旨在通过混合一对一监督和一对多监督来明确监督候选生成过程,从而提高DETR训练效率。我们的方法,即MS-DETR,很简单,并且对用于推理的主解码器的对象查询进行一对多监督。与具有一对多监督的现有DETR变体(如Group DETR和Hybrid DETR)相比,我们的方法不需要额外的解码器分支或对象查询。在我们的方法中,主解码器的对象查询直接受益于一对多监督,因此在对象候选预测方面是优越的。实验结果表明,我们的方法优于相关的DETR变体,如DN-DETR、Hybrid DETR和Group DETR,并且与相关DETR变体的组合进一步提高了性能。

二、引言

端到端目标检测方法DETR已有很多研究者研究。该类模型是基于CNN的backbone、一个编码、一个解码。解码是decoder层堆叠,每一层由self-attention、cross-attention和FFNs模块,仅接class与box预测。

DETR的解码生成很多目标候选框,他们以目标查询表征,在端到端学习方法中提出一个候选框和很多冗余的框。这些冗余候选框也靠近gt box框,如图1说明。而候选框是通过decoder的cross-attention生成。候选去重主要有解码self-attention与一对一监督完成,确保选择一个候选框符合gt box目标。不像基于NMS方法(如:fastercnn)通常使用一个监督生成候选框,而DETR模型训练对生成多个目标候选缺乏明确监督。

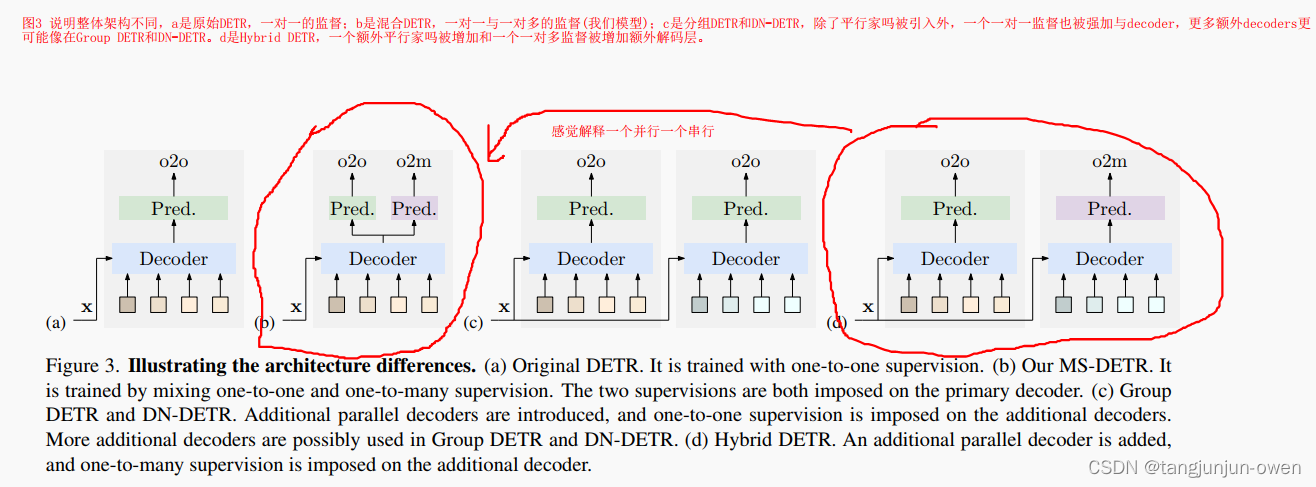

我们提出监督查询,该查询在解码模块混了一对一监督与一对多监督,从而改善训练效率。我们架构非常简单,我们增加模块与预测head相似,实现一对一监督,它由一个box预测、一个类别预测构成。我们命名为MS-DETR,如图3说明。我们想要指出增加的模块不影响训练过程与推理过程。

图1说明我们模型对后弦检测影响。我们发现DETR没有一对多监督也对gt目标产生多个候选框。在用一对多监督后,预测box会更好,候选框也更好。我们也发现一对一的分类与box回归 loss是低于有一对多监督。这是能够改善候选框,这样对一对一监督loss有帮助的。

我们方法通过引入额外监督(一对多)在图像特征选择上改善目标查询。与相关方法比较,如conditional DETR、Deformable DETR,明显不同,他们是修改cross-attention架orquery格式,我们方法也是,然而不同我们是一朵朵监督。特别的,我们方法直接在primary上加了一对多的监督。

三、贡献

作者在原有一对一监督DETR模型上,提出一对多监督,使其与原有一对一监督混合监督,提高DETR训练效率。

四、MS-DETR模型方法

实际是在原有DETR一对一的监督增加一对多的监督,但我感觉有些将 Group DETR和DN-DETR的平行结构换成了串行结构,且实验在哪个位置分出一对多监督结构,实际是loss约束成分。

1、模型整体结构解读

图3 说明整体架构不同,a是原始DETR,一对一的监督;b是混合DETR,一对一与一对多的监督(我们模型);c是分组DETR和DN-DETR,除了平行家吗被引入外,一个一对一监督也被强加与decoder,更多额外decoders更可能像在Group DETR和DN-DETR。d是Hybrid DETR,一个额外平行家吗被增加和一个一对多监督被增加额外解码层。

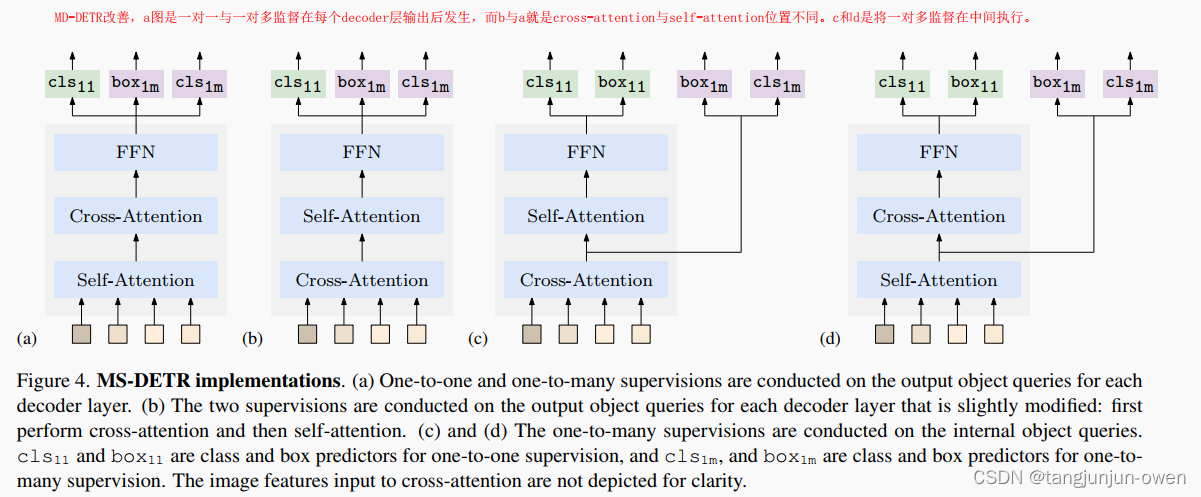

2、模型改善结构解读

MD-DETR改善,a图是一对一与一对多监督在每个decoder层输出后发生,而b与a就是cross-attention与self-attention位置不同。c和d是将一对多监督在中间执行。

3、一对多监督原理

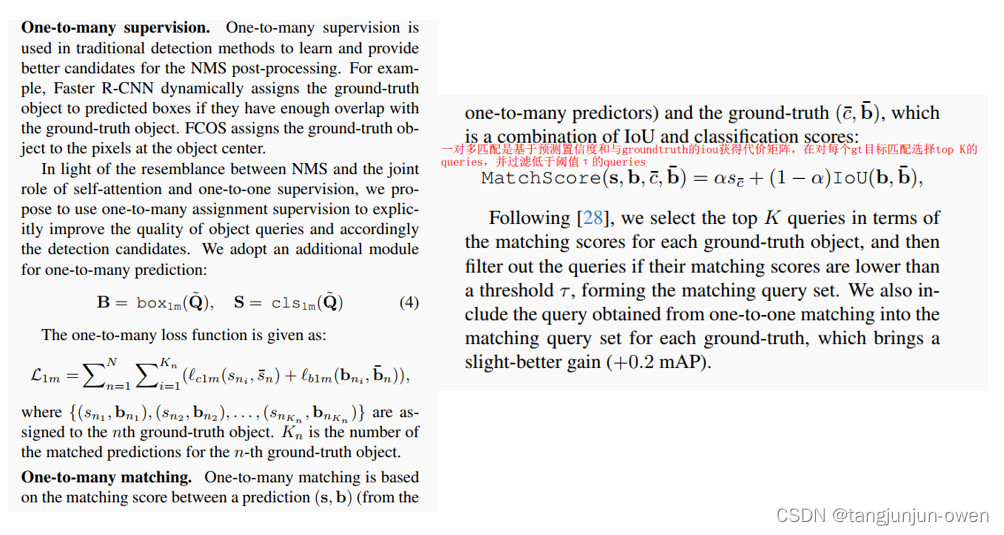

一对多匹配是基于预测置信度和与groundtruth的iou获得代价矩阵,在对每个gt目标匹配选择top K的queries,并过滤低于阈值τ的queries。

五、实验结果

1、实验比较

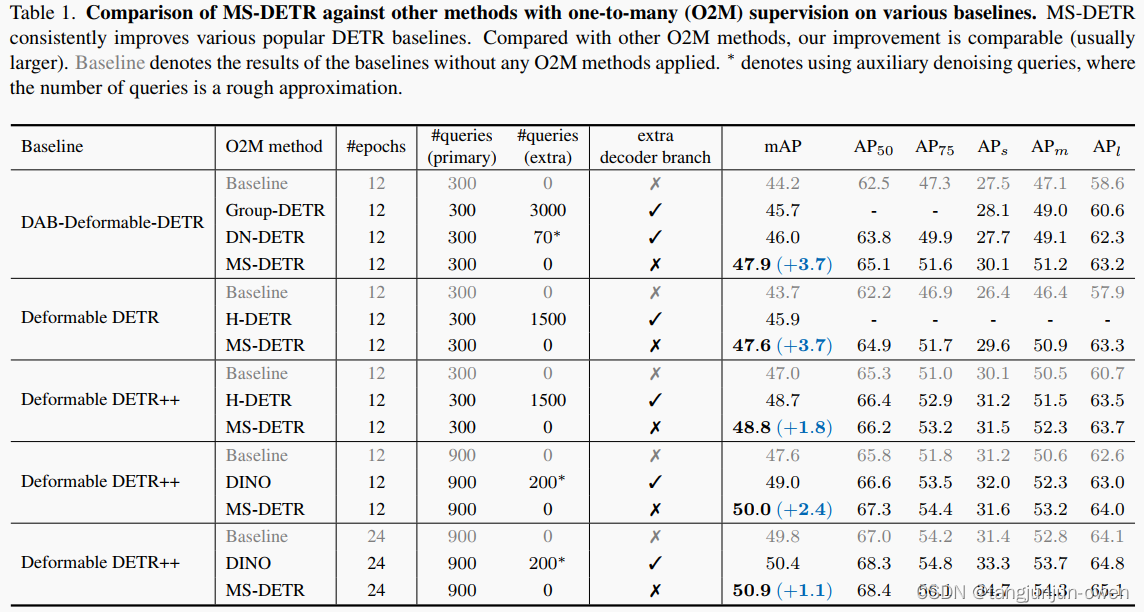

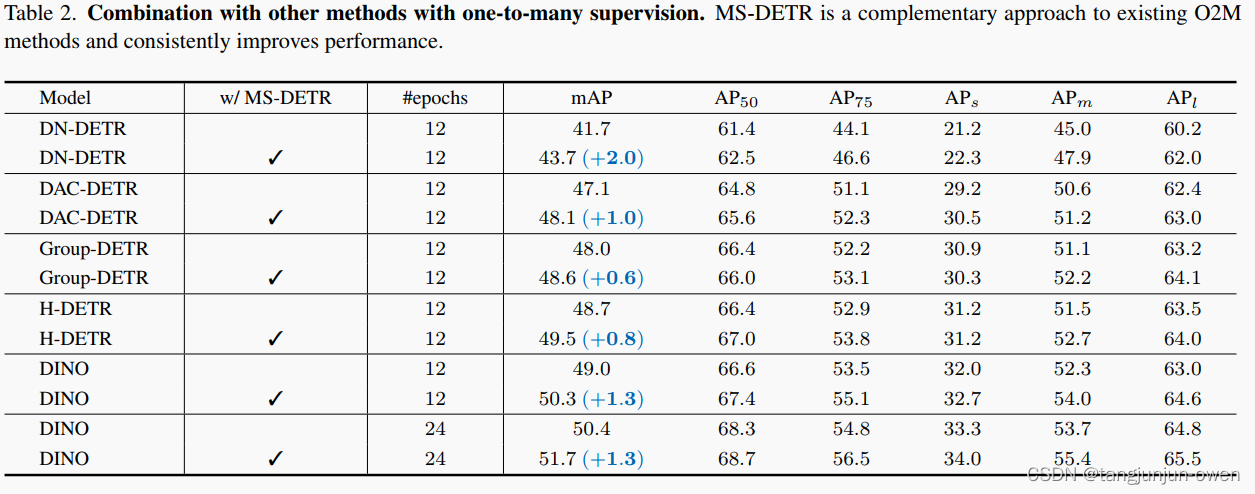

作者在epoch=12或24比较不同模型差异,如下表:

2、论文链接

该论文有部分注释,下载链接如下:

链接:https://pan.baidu.com/s/1_PxFMsto6uXSRCj29K0lIA

提取码:depa

总结

该篇文章比较容易读,但我感觉技术应该不是那么惊艳(个人理解),而读者想更加深刻理解,需查看源码,我只是大概说了该篇论文相关内容。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!