(二十一)Kubernetes系列之计算资源

Kubernetes在创建一个Pod时,调度器将会为Pod选择一个运行的Node。对于每一个Node来说,其都存在一个最大的资源能力(CPU和内存)。调度器在调度时,要确保Node上CPU和内存能够满足所有Pod对于计算资源的要求。

Pod中的容器启动时,request和limit会作为参数传递给容器运行时。当docker作为容器运行时:

-

spec.containers[].resources.requests.cpu:值会被转换为core,然后乘以1024,再将结果通过–cpu-shares参数的值传递给docker run命令。

-

spec.containers[].resources.limits.cpu:值会被转化为millicore,然后乘以100。结果值是作为容器在100微秒内能够使用的CPU总量时间。默认的配额周期是100ms,最小的CPU配额是1ms。

-

spec.containers[].resources.limits.memory:值会被转化为整数,在docker run命令中作为–memory字段的值。

如果容器在运行过程中使用的内存超过了内存的limit,它将会被终止。同时如果此容器是可重启的,则kubelet会在后续会重新启动它。如果容器在运行过程中使用的内存超过了内存的request,则当Node内存不足时,它所在的Pod会被删除,但容器运行过程中如果使用了超过要求CPU,容器并不会被杀死。

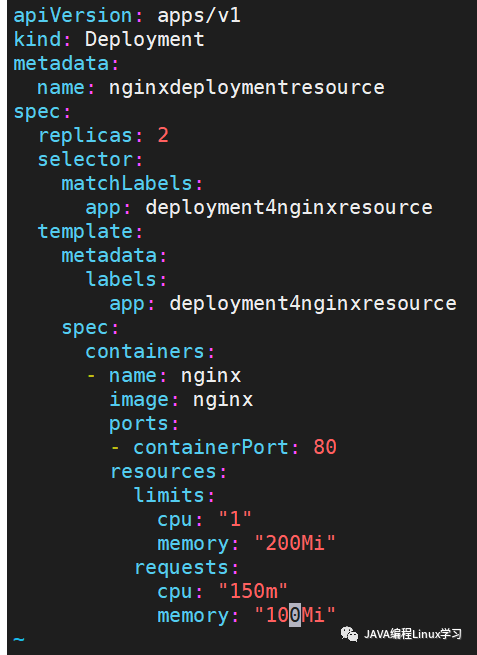

1.创建模板

vi nginxdeploymentresource.yml

内容如下

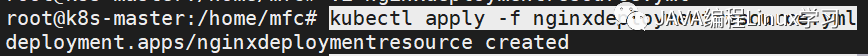

2.使用模板创建deployment

kubectl apply -f nginxdeploymentresource.yml

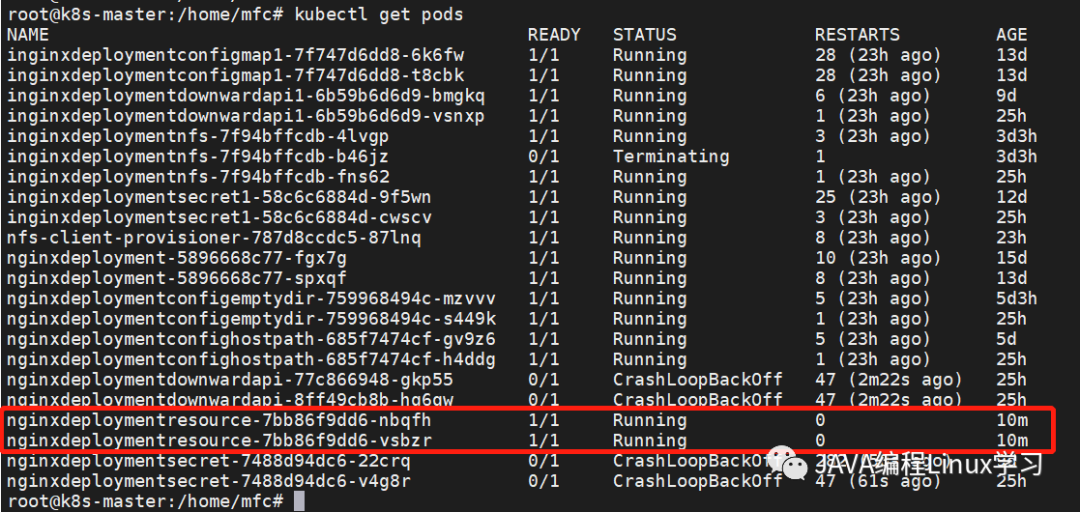

3.查看创建的pod

kubectl get pods

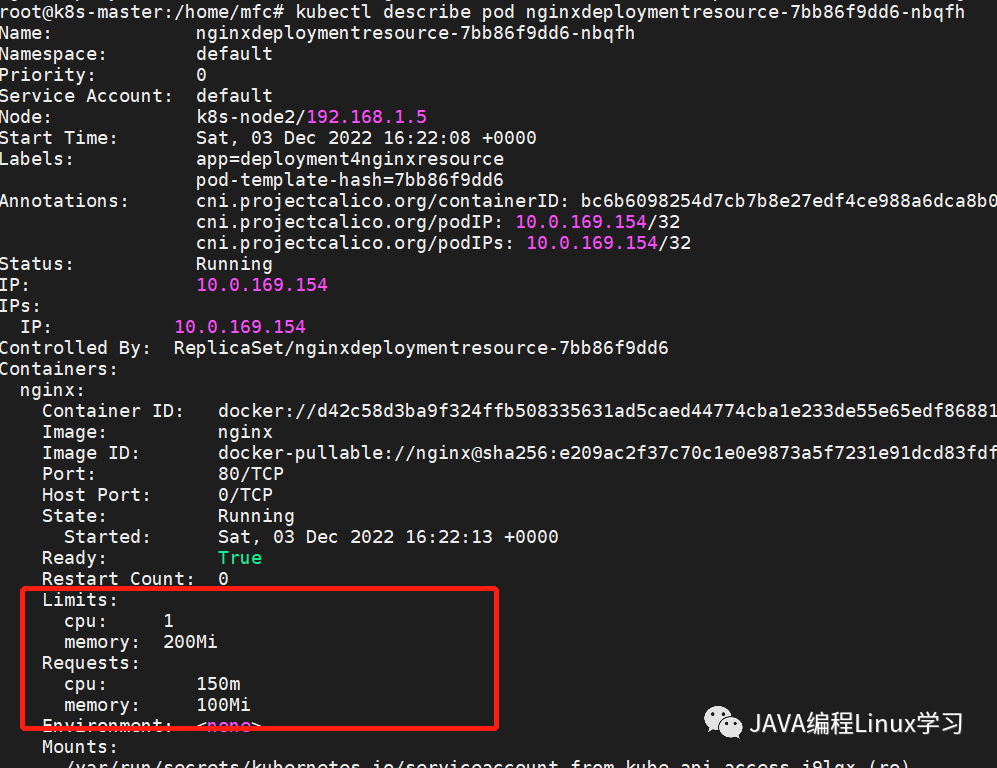

kubectl describe pod

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- ubuntu18.04 添加python3.8环境

- jmeter解决返回unicode编辑

- 【RabbitMQ】RabbitMQ高级:如何保证消息可靠性

- 力扣 | 75. 颜色分类

- AtCoder Beginner Contest 214 G. Three Permutations(组合数学 容斥 背包 二项式反演)

- CentOS7部署bamboo9.4.2-postgresql版

- 外包干了1年,已经摆烂了

- 【代码随想录】3

- yum仓库详解(命令+搭建)

- docker安装RabbitMq插件