RWKV入门

发布时间:2024年01月14日

主要参考资料

B站视频《【项目原作解读】RWKV Foundation侯皓文:新型RNN模型RWKV,结合Transformer的并行化训练优势和RNN的高效推理》

RWKV官网: https://www.rwkv.com/

前言

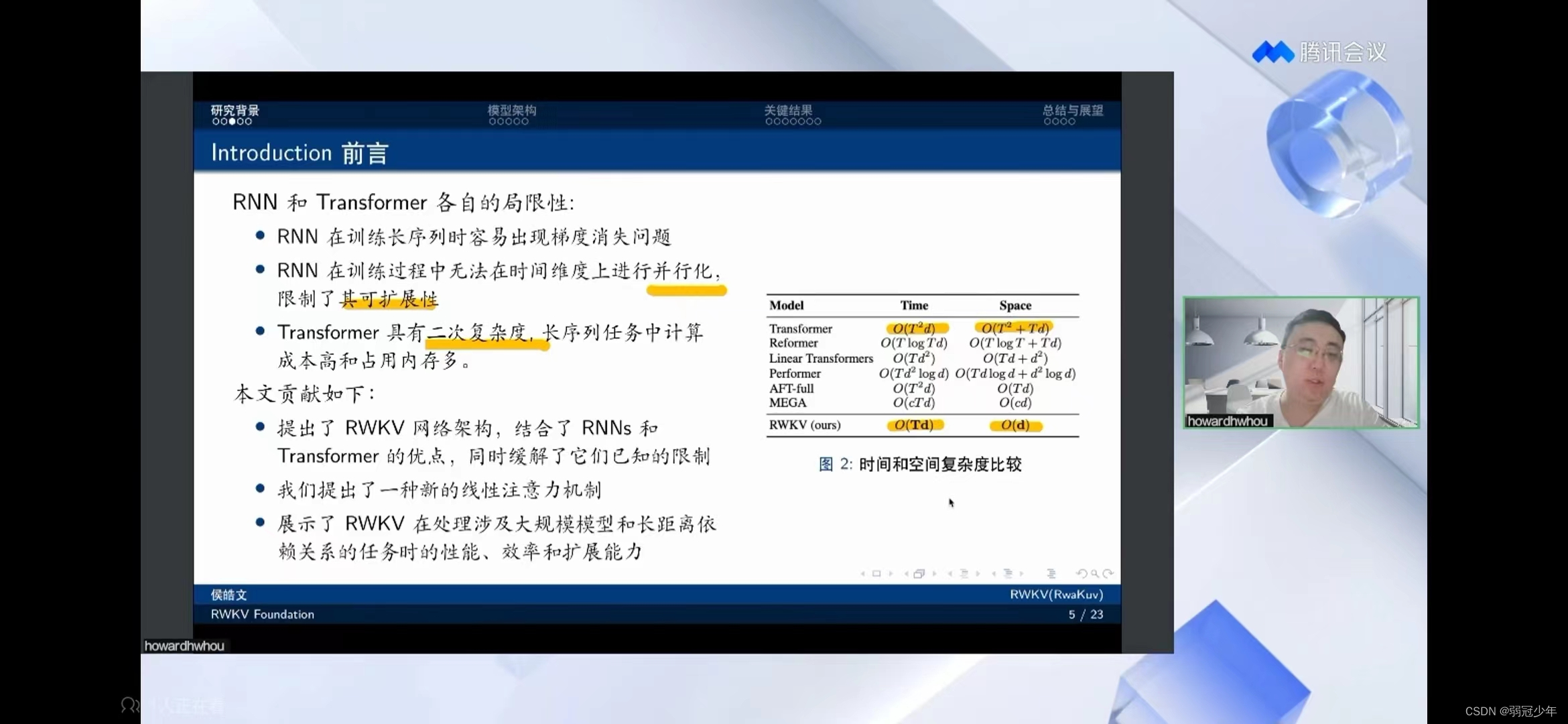

RNN无法并行化,Transformer的二次复杂度,RWKV的改善。

RWKV由来

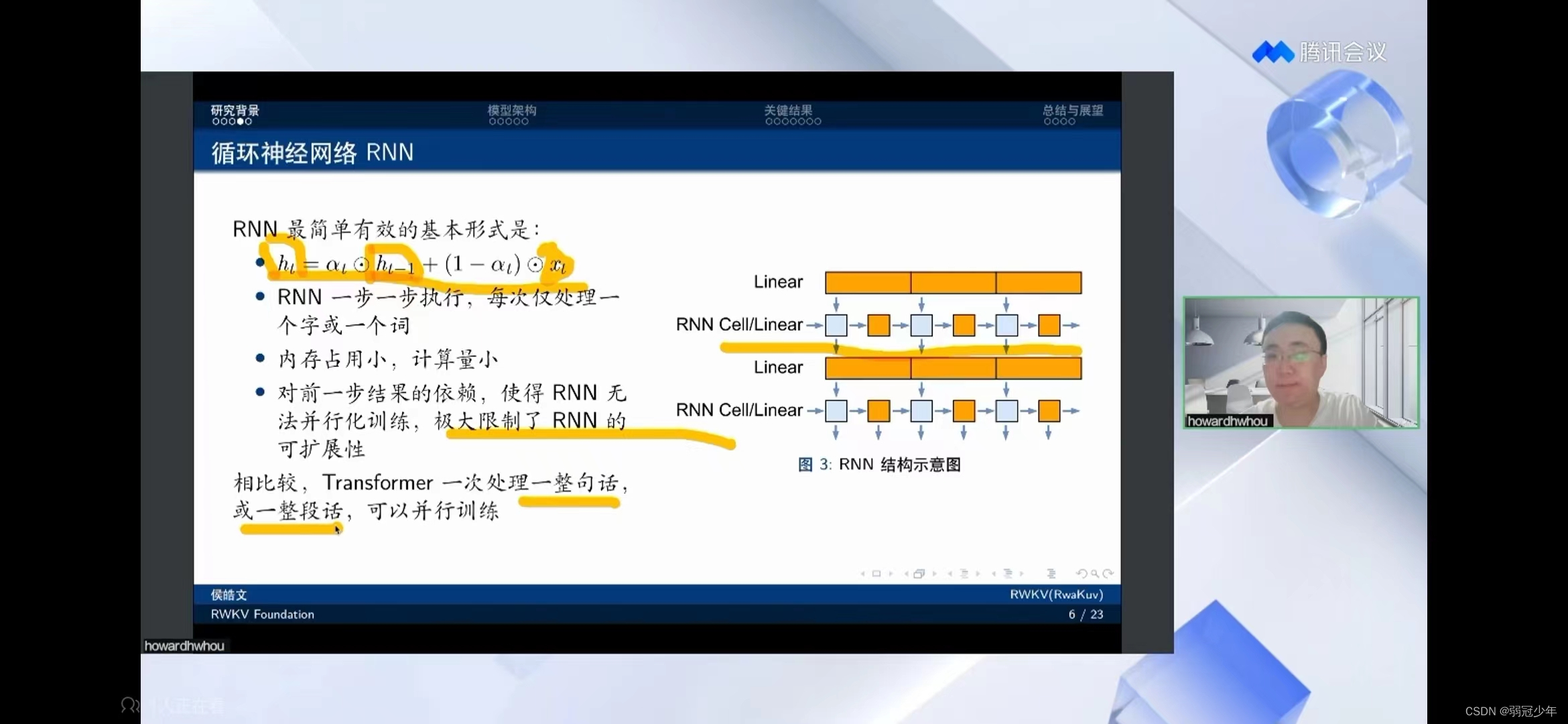

RNN的局限是无法进行并行化训练,相较Transformer处于劣势。

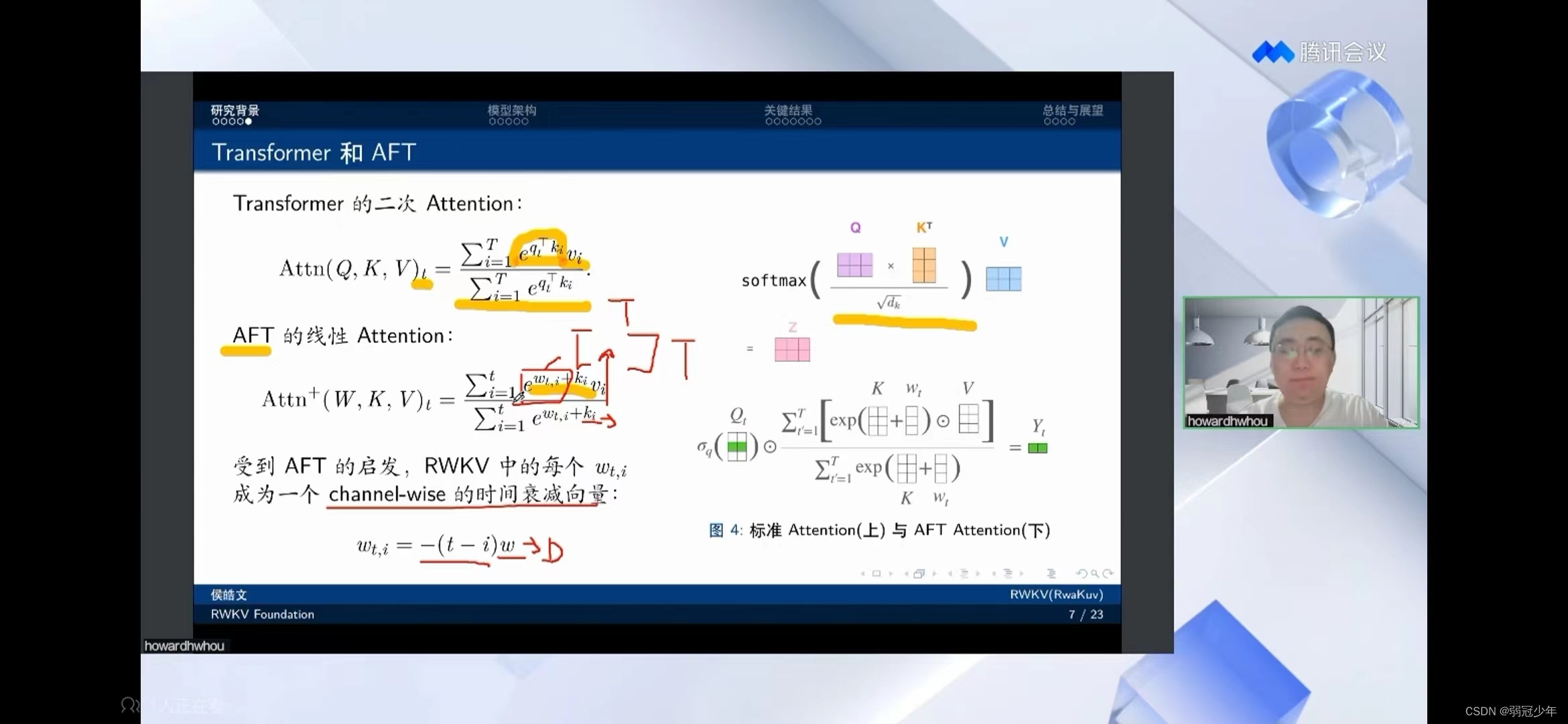

继《Attention is all you need》横空出世后,针对Transformer的二次Attention,苹果提出AFT的线性Attention,RWKV受苹果启发,提出时间衰减向量的概念。

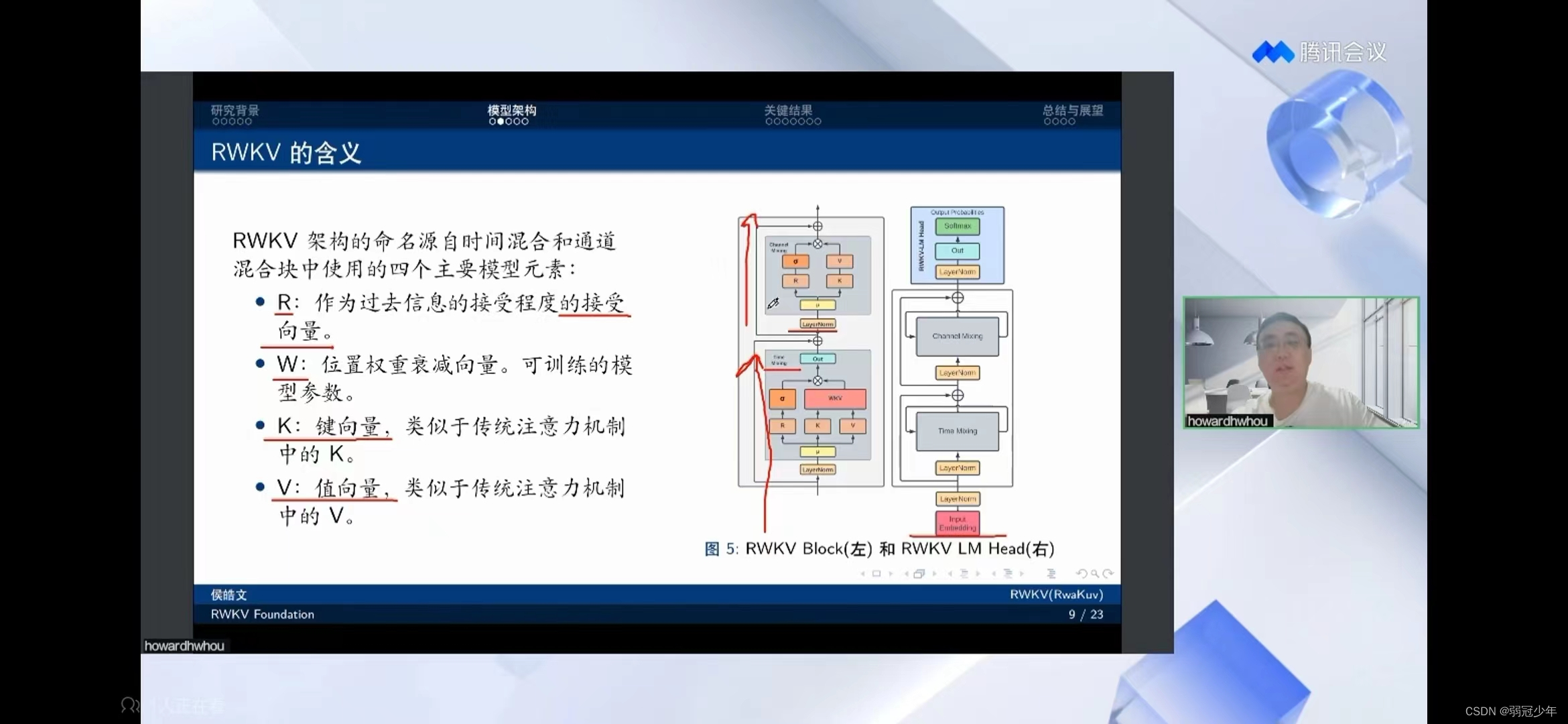

模型架构

一个Embeding Input进入RWKV,首先会进入Time-mixing模块,会跟之前的文本信息进行一次融合。之后是channel-mixing模块,会对每个词的channel进行混合和非线性,增强非线性能力。

关键结果

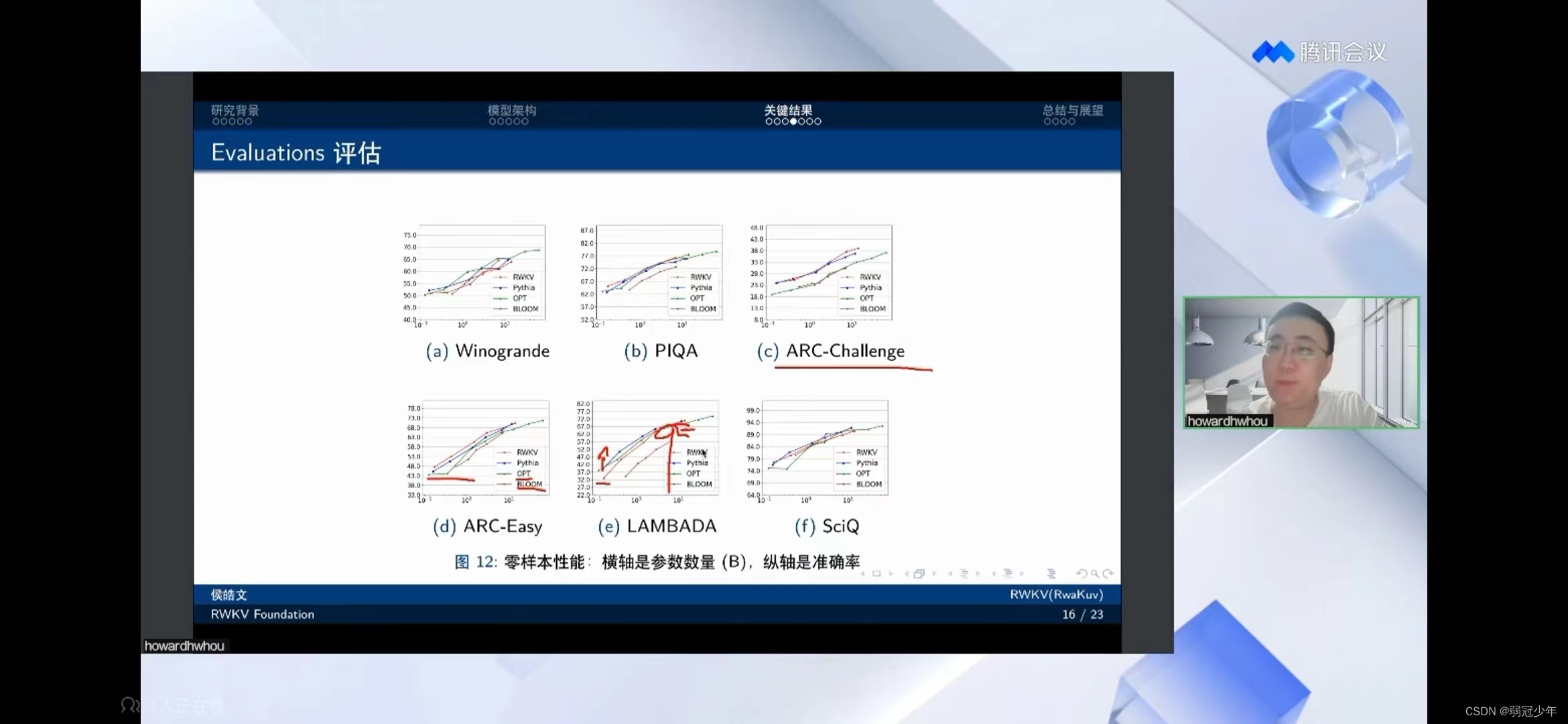

在LAMBADA测试集中,RWKV的劣势在参数量小的时候,与Transformer有一定的差距,因为Transformer可以将过去的数据集都拉出来重算一遍。

但是在7B时RWKV已经接近Tranformer,14B时已经不相上下。因此从模型角度RWKV更有优势。

PS:但是GPT-3已经是175B的数据量了。。。

GPT:无所谓,我有钱

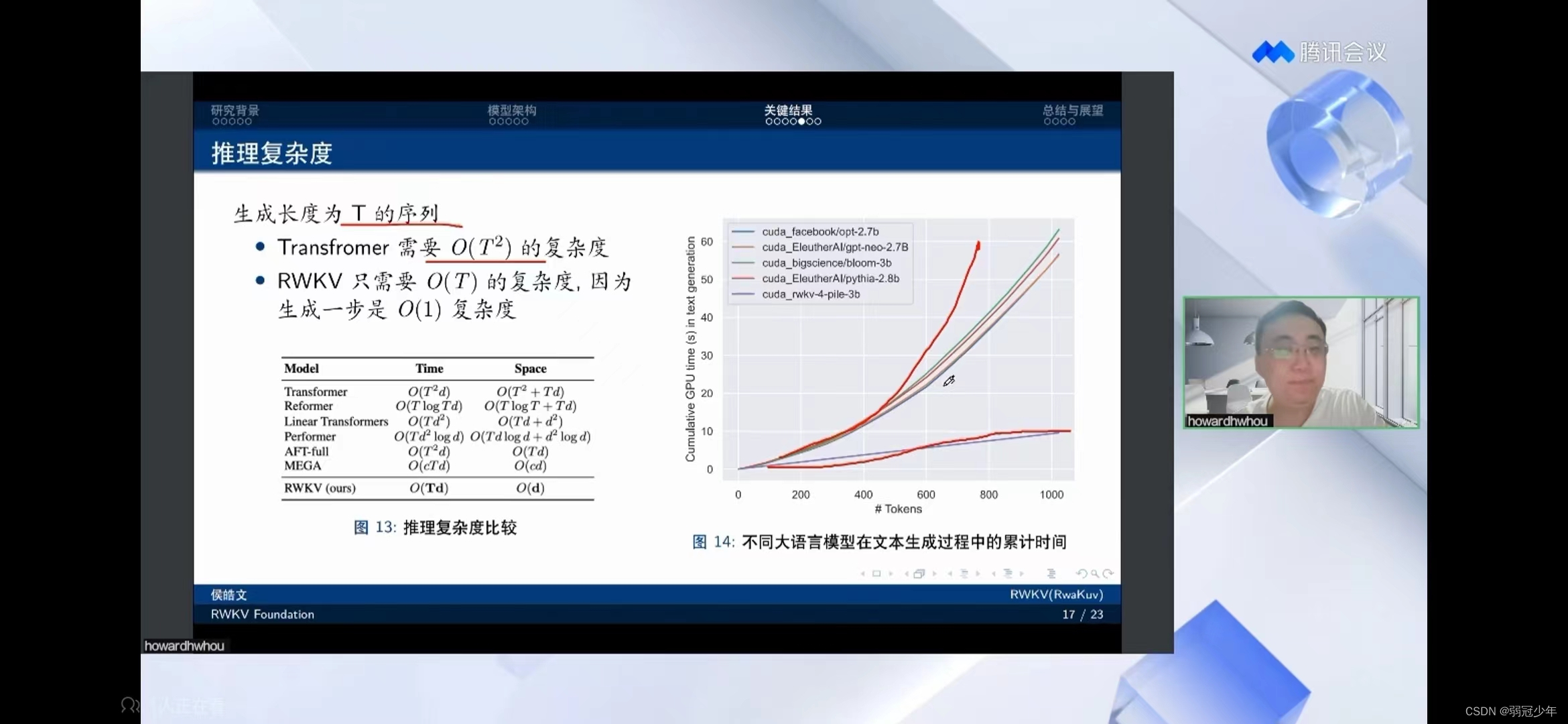

再次重申,RWKV的优越性,时间复杂度更低。

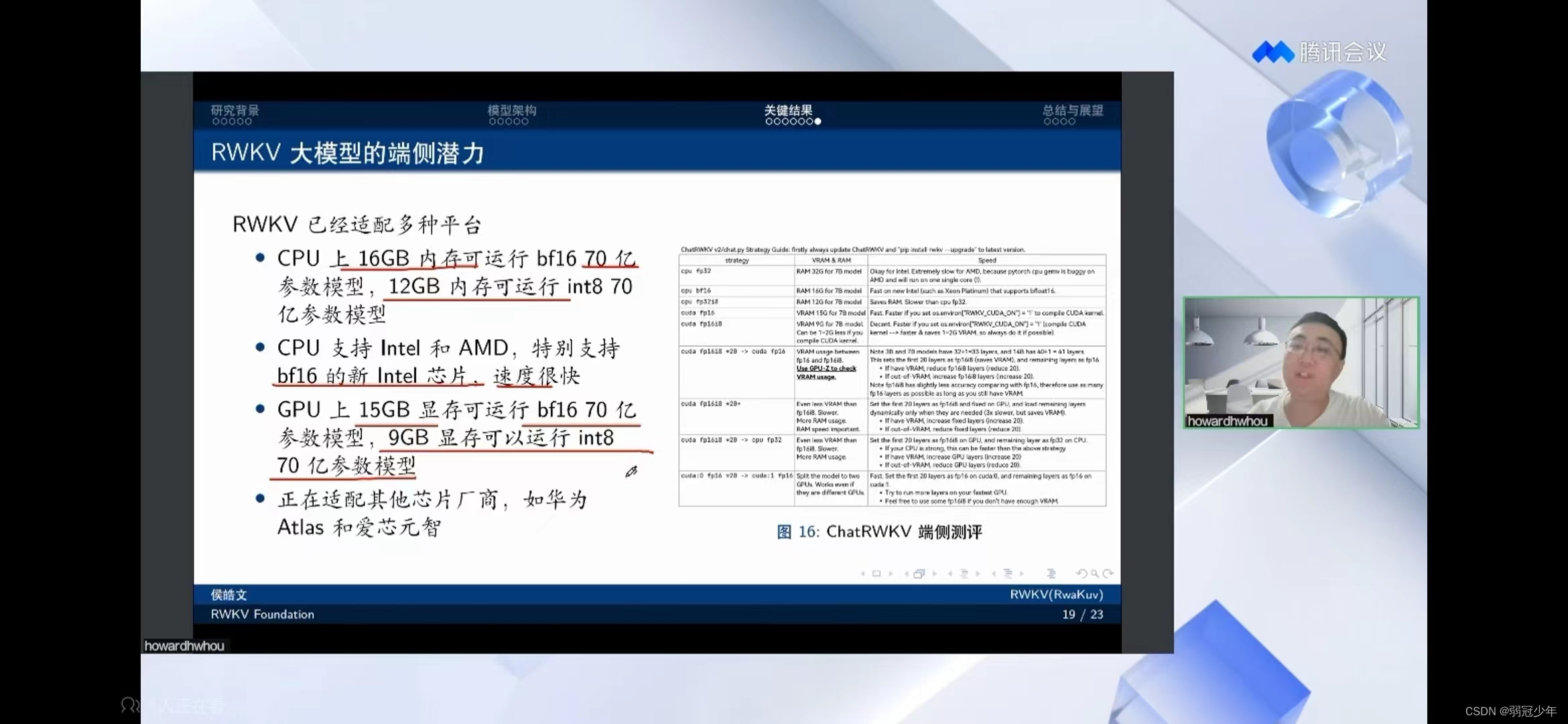

数据量7B的RWKV至少需要CPU内存12GB 或者 显卡显存9GB。。。

劣势

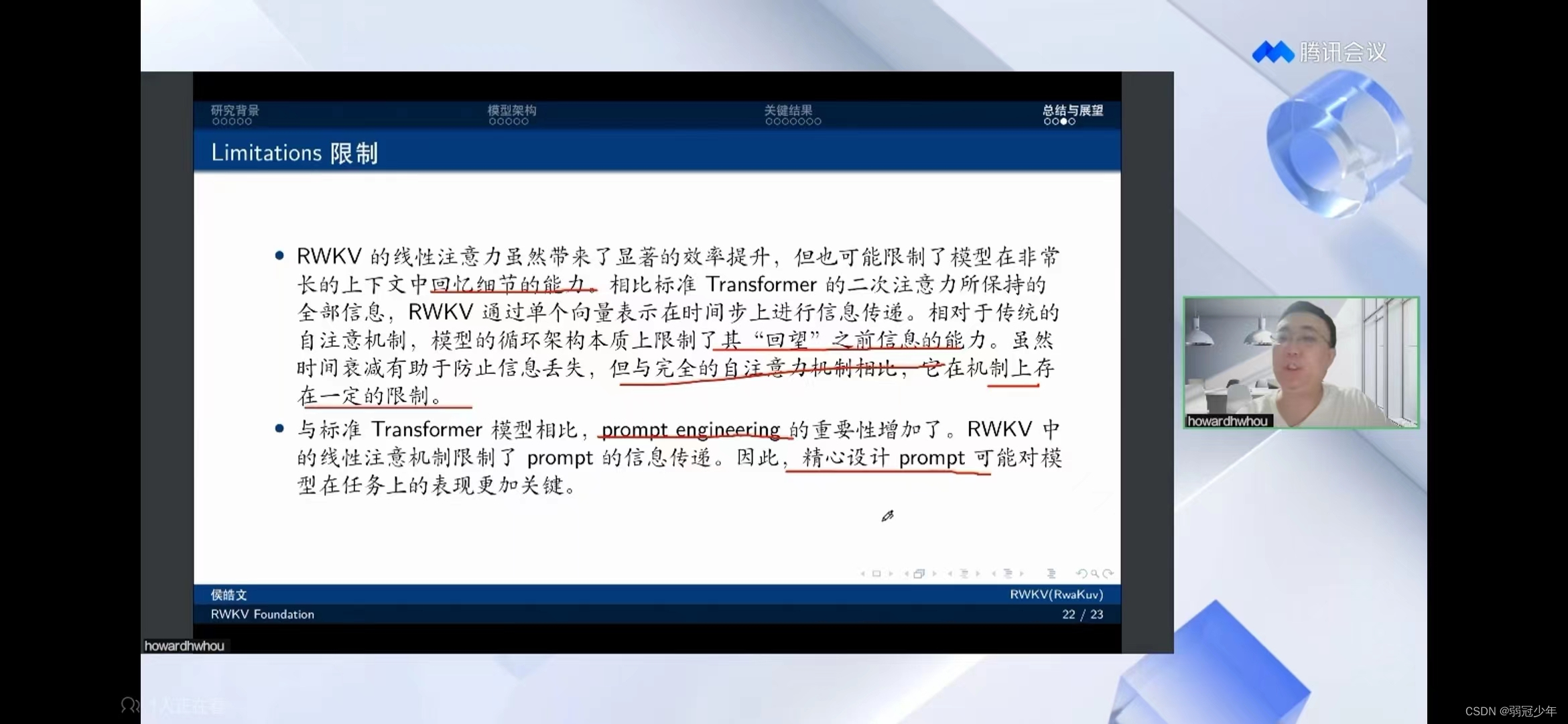

RNN的特性,让RWKV在对前文的记忆很差,因此需要精心设计prompt。

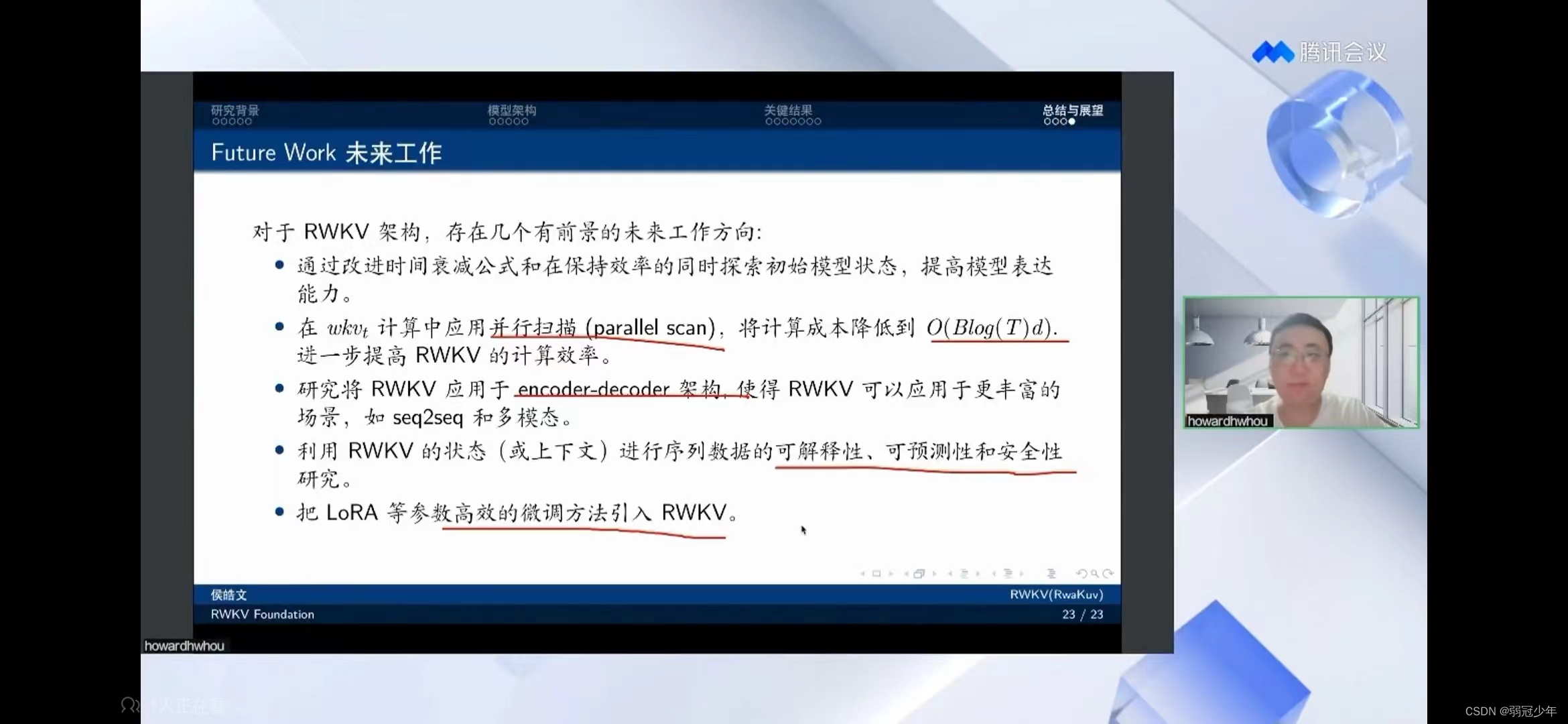

未来展望

(1)RWKV可以进一步提高效率(遗忘是不是更严重?)

(2)增加多模态,现在只是decoder

文章来源:https://blog.csdn.net/qq_40773212/article/details/135575538

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- TS 36.213 V12.0.0-PUSCH相关过程(4)-UE HARQ-ACK过程

- ssm534基于JavaEE的智能实时疫情监管服务平台的设计与实现+jsp

- C //练习 6-2 编写一个程序,用以读入一个C语言程序,并按字母表顺序分组打印变量名,要求每一组内各变量名的前6个字符相同,其余字符不同。字符串和注释中的单词不予考虑。请将6作为一个可在命令行

- 数组去重你想到几种办法呢?

- c++学习第九讲---类和对象---多态

- cf round917 B题讲解

- 110基于matlab的混合方法组合的极限学习机和稀疏表示进行分类

- springboot社区养老服务系统设计与实现

- WIZnet Ethernet HAT评估版介绍

- 技术的本质,是解决需求