深度学习记录--学习率衰减(learning rate decay)

发布时间:2024年01月21日

学习率衰减

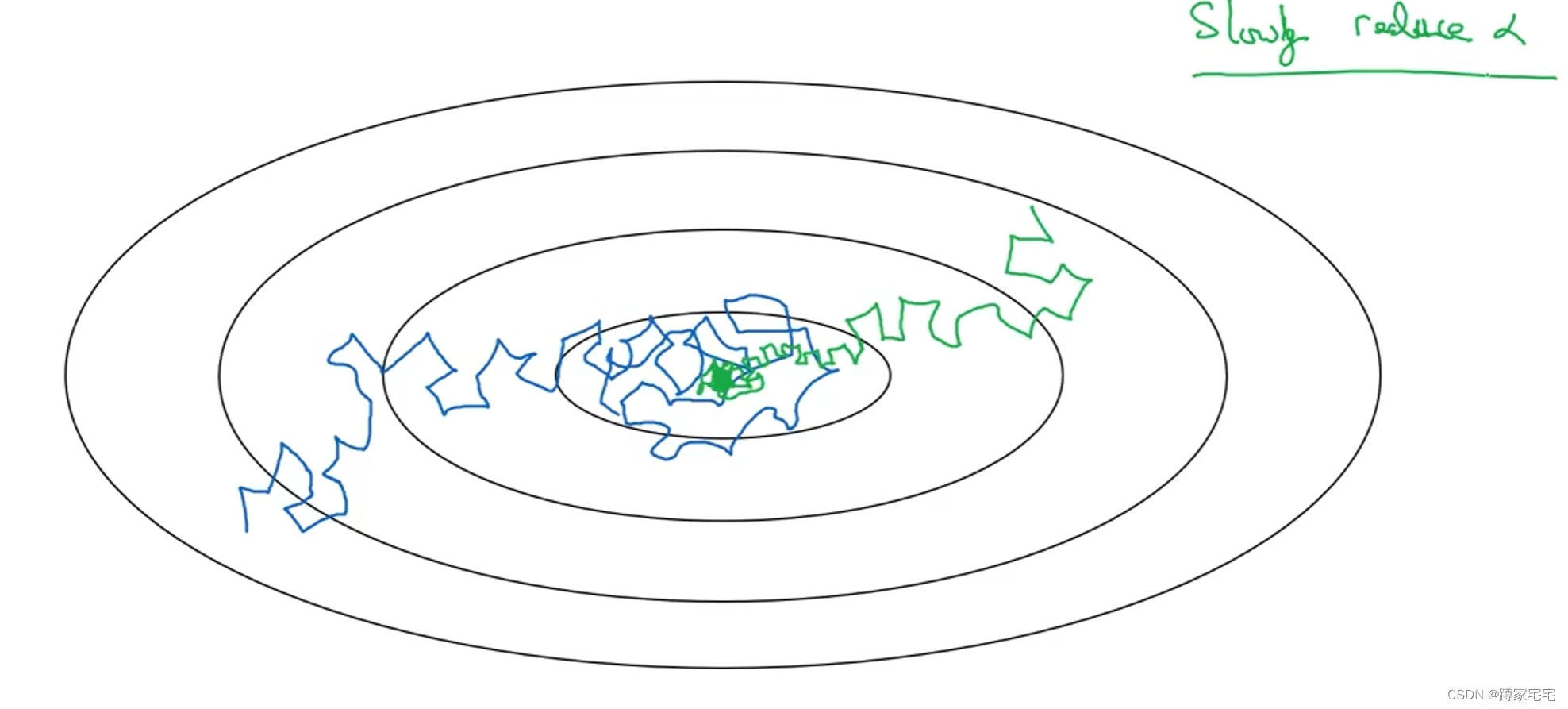

mini-batch梯度下降最终会在最小值附近的区间摆动(噪声很大),不会精确收敛

为了更加近似最小值,采用学习率衰减的方法

随着学习率的衰减,步长会逐渐变小,因此最终摆动的区间会很小,更加近似最小值

如下图,蓝色曲线表示mini-batch梯度下降,绿色曲线表示采用学习率衰减的梯度下降

学习率衰减的实现

1 epoch = 遍历数据1次

是学习率衰减的超参数,

是初始学习率,

是遍历次数

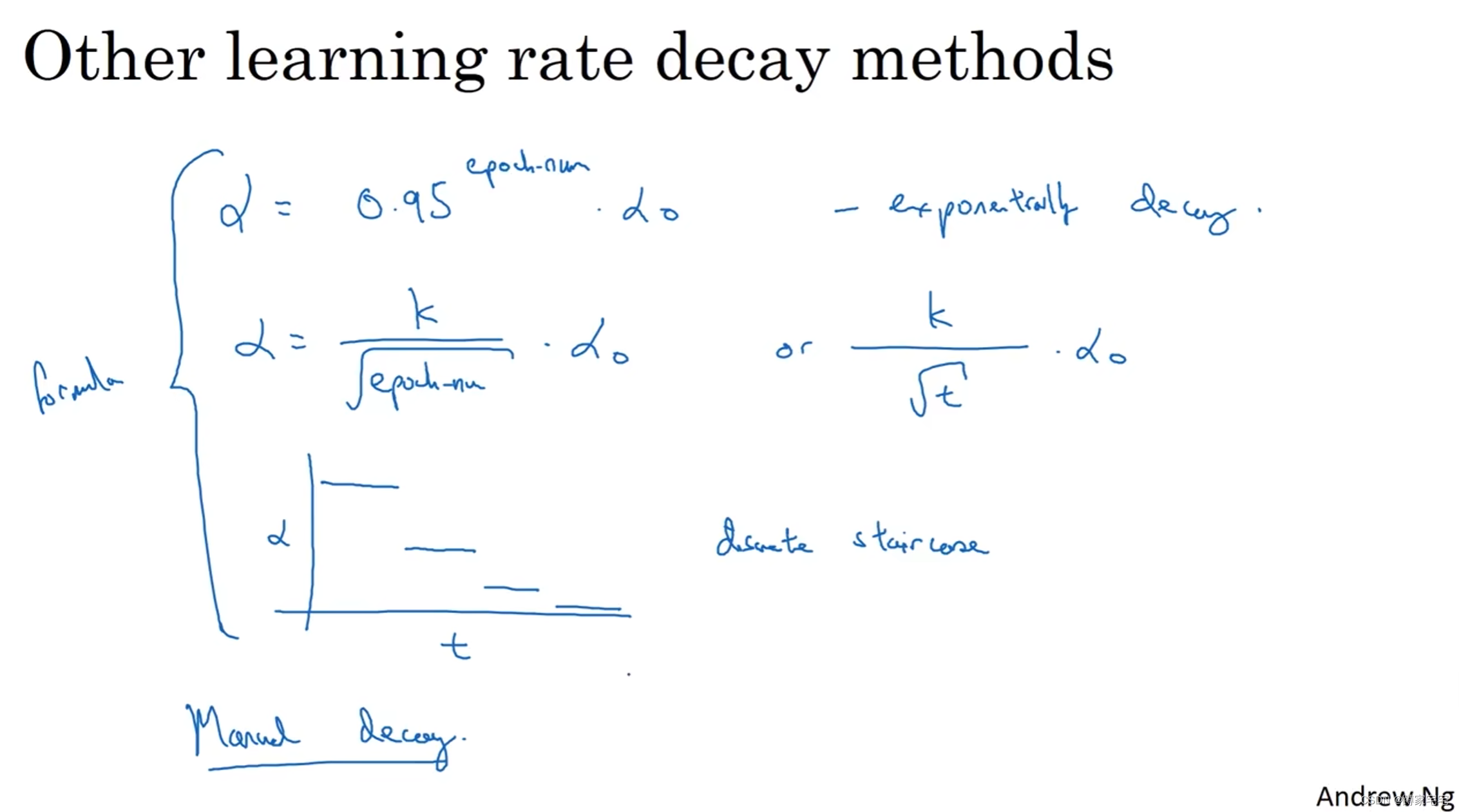

其他衰减方案

是初始学习率,

是衰减常量,一般设置

,

是遍历次数

是初始学习率,

是衰减常量,

是遍历次数

分段衰减函数

文章来源:https://blog.csdn.net/Xudong_12345/article/details/135731758

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 接口自动化框架搭建-写在前面

- C++&Python&C# 三语言OpenCV从零开发(3):图像读取和显示

- 【QT】线程模型、事件机制、信号槽机制 讲解

- Java各种加密算法的原理优缺点详解含示例代码(值得珍藏)

- P1308 [NOIP2011 普及组] 统计单词数----有意思

- 分布式系统的三字真经CAP

- Linux防火墙相关命令

- 软件项目测试指南

- 注意力机制在神经网络中的作用与影响

- 后台管理系统: spu管理模块