当世界加速离你远去

当世界加速离你远去

会不会这个标题显的太悲观,也可能是耳机里正在放着To Be Frank的原因。

对于阳历跨年我是没有太多的感觉,而且跨年夜忙着约会,所以2023年的跨年文章今天才出来。

一年的时间一晃就过了。2022年12月9日时候彻底结束了风控,人们终于可以理直气壮的摘掉口罩。怀揣着期待对于2023。

但实际情况却截然不同,无论是美联储的加息,还是笑话般A股,或者AI大模型的到来,对于普通人来说,2023年有点不太友好。

作为一个被股市绿了的人,经济就不敢瞎说了,本文仅聊聊技术技术相关的,上车!

AI大爆发

早在2022年上半年AI算图能做到「以文转图」成为生成式AI应用大热门。

2022年下半年ChatGPT聊天机器人在开放使用5天内达到100万个注册使用者,使用者成长速度比Instagram快15倍,比Spotify快30倍,同时经过测试ChatGPT的平均智商约为83,SAT测试1020/1600分,已达到美国高中生考大学的平均水准。

作为程序员可能早就听说CODEX、GITHUB COPLIOT到CODELLAMA、CODEGEEX。

2022年11月30日,OpenAI推出的一款人工智能技术驱动的自然语言处理工具——ChatGPT,迅速在社交媒体上走红,短短5天,注册用户数就超过100万。

2023年1月末,ChatGPT的月活用户已突破1亿,一度成为史上增长最快的消费者应用(之后被threads的5天打破)。

尽管开始时ChatGPT还在一本正经的胡说八道,AI绘画画出来的画还是十二个手指。但是AI的进化速度远超出了你的想象。

第三季度,许多xGPT上线后,你开始发现其答案言之有理,头头是道。同时只要你给予的Prompt参数正确,AI绘图就会给你生成一副差强人意的作品。

Prompt通常指的是向AI系统提供的输入或指令,用于引导AI进行特定的操作或生成特定的输出。这些输入可以包括训练数据、命令参数、问题描述等。

Midjourney于2023年更新的V5版本让Midjourney及其作品成功“出圈”。4月,Midjourney开始支持“看图反推Prompt”的功能,这个功能可以根据给定的图片内容自动生成相应的描述。

5月,Midjourney官方中文版已经开启内测,其将搭载在QQ频道上,在常规创作频道中输入 /想象 + 生成指令,即可召唤 Midjourney 机器人进行作画。

2022年3月首次亮相,在8月迭代至V3版本已经开始引发一定的关注。

4月,微软亚洲研究院 NUWA 多模态生成模型家族迎来了新成员——NUWA-XL,其以创新的 Diffusion over Diffusion 架构,首次实现了高质量超长视频的并行生成,为多模态大模型提供了新的解题思路。

NUWA-XL超长视频生成模型,采用创新的Diffusion over Diffusion架构,通过「从粗到细」的生成过程,可以并行生成高质量的超长视频,为多模态大模型提供了新的解题思路。只要输入16句简单描述,AI就能生成11分钟的动画了。

11月,AI生成视频出现了小爆发,Meta、阿里、字节、腾讯等公司纷纷入局推出了各自的产品。

- Meta公司推出了AI生成视频工具“Video AI”

- 阿里也推出了自己的AI生成视频工具“Video++”

- 字节跳动也推出了AI生成视频平台“Byte AI Video”

- 腾讯也推出了AI生成视频产品“Tencent AI Video”

AI大模型到多模态、AI工具、AI应用,一时间AI席卷整个资本市场。来自大企业、风投的热钱不住给这个市场点火。

大模型是指大规模的深度学习模型,通常具有数亿、数十亿甚至更大的参数量。由于模型规模巨大,需要使用大量的数据进行训练,因此大模型通常具有较好的泛化能力和表现。然而,大模型的训练和推理成本较高,对计算资源和存储资源的需求很大。因此,在实际应用中,需要进行参数优化、剪枝等操作,以降低计算成本和提高运行效率。

多模态则是指多种媒体数据融合处理的方式,包括文本、图像、音频、视频等多种媒体形式。多模态技术的应用场景非常广泛,例如智能客服、智能语音助手、智能家居等。通过多模态技术,可以将不同媒体数据融合在一起,进行多维度、多层次的分析和处理,从而更好地理解用户意图和需求,提供更加智能化的服务。

以前的独角兽公司几年才能做出一项技术,做出一个项目,而现在仅仅几个月。相较于AI工具,AI应用层的窗户纸更加的脆弱,一捅就破。表面都在说着人工智能、大模型的专业术语,看起来光鲜亮丽,其实背地里就是GPT的API和一个好看的UI。等到一旦GPT技术的更新升级,竞争力便荡然无存。

12月谷歌发布的 Gemini 大模型是原生多模态大模型,是谷歌大模型新时代的第一步,它包括三种量级:能力最强的 Gemini Ultra,适用于多任务的 Gemini Pro 以及适用于特定任务和端侧的 Gemini Nano。这是最强原生多模态,完全碾压GPT-4!

Gemini可以用和人类一样的方式理解我们周围的世界,并且吸收任何类型的输入和输出——无论是文字,还是代码、音频、图像、视频。

可怕的不是这些工具本身的能力,而是这些工具的迭代能力。

GPU是债券般的比特币

GPU(图形处理器)已经成为了一个引人注目的投资热点。它的地位日益凸显,不仅仅是因为其在游戏、影视等娱乐领域的广泛应用,更是因为其在人工智能、机器学习、大数据分析等高科技领域的核心作用。随着人工智能和机器学习技术的快速发展,GPU的需求量呈现出爆炸性的增长。这些技术需要大量的计算资源来处理和分析数据,而GPU正是提供这种能力的理想选择。

难怪最近蛮多读者让我推荐分享一下GPU的资料。

NVIDIA已经占据AI GPU市场多达90%的份额,A100、H100都是一卡难求,产能极为紧张。NVIDIA已经在8月份拿到SK海力士HBM3e的早期样品,预计明年初获得正式版本,进行最终的质量测试。2023年,NVIDIA全年累涨近240%,创下上市以来最大年度涨幅。这主要得益于空前火热的生成式AI浪潮的推动,以及英伟达在人工智能(AI)芯片市场的领先地位。

目前,除了少数大型互联网企业有较多的GPU,算力储备较充足,中小企业普遍面临算力紧缺。为了减少设备投入,不少企业“由买转租”。于是租赁需求迎来爆发,今年到去年,算力租赁价格涨幅是100%到200%。

9月,莲花健康披露公告称,计划斥资6.93亿元向新华三采购330台英伟达算力服务器。公司计划从事算力租赁业务的业务模式主要为公司负责投资建设智能算力中心,需要购买大量固定资产,为下游各行业客户提供面向人工智能业务的算力租赁云服务。

3月NVIDIA发布NVIDIA DGX Cloud?。这项AI超级计算服务使企业能够即时接入用于训练生成式AI等开创性应用的高级模型所需的基础设施和软件。

DGX Cloud可提供NVIDIA DGX? AI超级计算专用集群,并配以NVIDIA AI软件。这项服务使得每个企业都可以通过一个简单的网络浏览器就能访问自己的AI超级计算机,免除了购置、部署和管理本地基础设施的复杂性。

但其最大的云客户(AWS、Azure 和谷歌云)正在生产自己的芯片这一事实越来越令人担忧,因为它可能这意味着未来对英伟达芯片的需求将大大降低,从而削弱英伟达远期收益。

传闻百度为200台服务器订购了1600颗华为技术公司的 910B Ascend AI 芯片,以此作为英伟达 NVIDIA A100 芯片的替代品,到 10 月份华为已经交付了超过 60% 的订单,预计将在今年年底前交付所有芯片。昇腾处理器是基于华为达芬奇架构的NPU。2018-2019年,华为推出昇腾310、910 NPU。

谷歌宣布发布新一代大模型Gemini,能够处理视频、音频和文本等不同内容形式的信息。同时谷歌同步发布最新版本的计算芯片TPU v5p,与TPU v4相比,TPU v5p的浮点运算性能提升了两倍,它训练大语言模型的速度比TPU v4快2.8倍。

TPU是谷歌为神经网络设计的自研芯片,谷歌于2016年起开始推出第一代TPU,目前已经在YouTube、Gmail、GoogleMaps、GooglePlay和Android等产品服务中使用,本次发布的最新版本TPUv5p在各项性能方面均有显著提升:

- 1.算力角度来看,TPUv5p具有两倍算力浮点运算能力:TPUv5p在bfloat16精度下可以实现459tFLOPS(v4275tFLOPS),在Int8精度下可以实现918tFLOPS(v4394tFLOPS);

- 2.此外,TPUv5p相比v4p具有三倍的高内存带宽提升(95GBvs32GB),2.25倍内存带宽(2765GB/svs1228GB/s)和2倍芯片间互联带宽(4800Gbpsvs2400Gbps);

- 3.从模型训练结果来看,在BF16精度下TPUv5p训练1750亿参数的GPT3速度为TPUv4的1.9倍,int8精度下可以达到2.8倍;

- 4.运行费用方面,以训练1750亿参数的GPT-3为例,每个TPUv5p加速器的运行费用为每小时4.20美元,略高于TPUv4(3.22美元)和TPUv5e(1.20美元)。

算网融合

从字面上来说,算网一体就是将算力和网络融合在一起,该特质与算力网络十分接近。然而,算力网络是由计算设施与网络设施共同构建的一张传输网络,而算网一体则是建设这张网络想要实现的最终目标。在架构上,“算网一体”提出了“四大层次,六大融合”的合作体系。

数字化新型基础设施的建设已成为实体经济全面升级的重要基石。在数字经济的条件下,生物识别、智能医疗、智能制造等智慧场景不断涌现,更多的个人、社会信息数字化将产生海量的应用数据,而算力处理的需求也随之而增加。

研究显示,预计到2030年,仅无人驾驶、区块链、物联网、AR/VR这四个方向的应用场景算力需求,同比2018年提升300倍。其中,高实时性的高效算力即将成为智能场景的主要特征。高效算力也得到了世界主要国家的认同。

2020年全球算力总规模达到了429 EFlops(每秒浮点运算次数),同比增速39%;中国算力在2020年与美、欧、日并驾齐驱,总体位于第一梯队。因此算力已经成为比流量更加宝贵的基础资源。

但是,当前算力设施建设面临着数据中心能耗高,算力资源利用效率不足,区域发展不协调、不均衡等挑战。尤其是数字化、智能化加速,算力供需关系失衡更为凸显。究其原因,一方面,多年来计算行业主要聚焦于单点算力突破,缺失对算力连接的关注,无法保障端到端算力服务的便捷性。

另一方面,计算行业依旧是以简单扩容算力传输网络来应对算力需求剧增,该措施无法满足泛在化的计算需要,将导致出现一系列的算力资源相对过剩,也就是算力孤岛问题,以及算力资源全局不足的现象并存。

通过充分发挥通信网络的优势,使用网络来全局调度和联通算力,加速通信网络朝着计算化的方向发展,有助于提升算力连接服务的创新,推动网络朝着智能化全面演进。因此,计算网络化成为通信行业的一个重要方向。

GH200是英伟达在 COMPUTEX 2023展会上推出的最新超级计算机,最多可以放置256个GPU,适用于超大型AI模型的部署。相比之前的DGX服务器,GH200提供线性拓展方式和更高的GPU共享内存编程模型,可通过NVLink高速访问144TB内存,是上一代DGX的500倍。其架构提供的NVLink带宽是上一代的48倍,使得千亿或万亿参数以上的大模型能够在一台DGX内放置,进一步提高模型效率和多模态模型的开发进程。

NVIDIA DGX GH200系统采用了NVIDIA Grace Hopper Superchip和NVLink Switch System作为其构建块。NVIDIA Grace Hopper Superchip将CPU和GPU结合在一起,使用NVIDIA NVLink-C2C技术提供一致性内存模型,并提供高带宽和无缝的多GPU系统。每个Grace Hopper超级芯片都拥有480GB的LPDDR5 CPU内存和96GB的快速HBM3,提供比PCIe Gen5多7倍的带宽,与NVLink-C2C互连。

NVLink开关系统使用第四代NVLink技术,将NVLink连接扩展到超级芯片,以创建一个两级、无阻塞、NVLink结构,可完全连接256个Grace Hopper超级芯片。这种结构提供900GBps的内存访问速度,托管Grace Hopper Superchips的计算底板使用定制线束连接到第一层NVLink结构,并由LinkX电缆扩展第二层NVLink结构的连接性。

头部顶尖科技公司都开始布局全自研芯片,谷歌、meta、英伟达都是为了实现AI算例的性价比。

"AI算力超节点"是指具备卓越人工智能计算能力的节点或系统,通常用于处理大规模的AI任务和复杂的计算工作负载。这些超节点可能整合硬件加速器(如GPU或TPU),采用算法与网络的无缝融合,支持分布式计算,为人工智能领域提供强大的计算资源。

这也是国家在2024年的重要战略地之一。

新型基础设施建设(简称:新基建),新型基础设施是指融合感知、传输、存储、计算、处理为一体的新一代智能化信息基础设施。主要包括5G基站建设、特高压、城际高速铁路和城市轨道交通、新能源汽车充电桩、大数据中心、人工智能、工业互联网七大领域。

三大运营商积极发展的IPTV(网络电视)、互联网数据中心、大数据、云计算、物联网等新兴业务,1-11月份共完成业务收入3326亿元,同比增长20.1%,在电信业务收入中占比21.4%,拉动电信业务收入增长3.8个百分点。其中云计算和大数据收入同比增速分别达39.7%和43.3%,物联网业务收入同比增长22.7%。

数据中心:要想生活过得去,就得头上带点绿

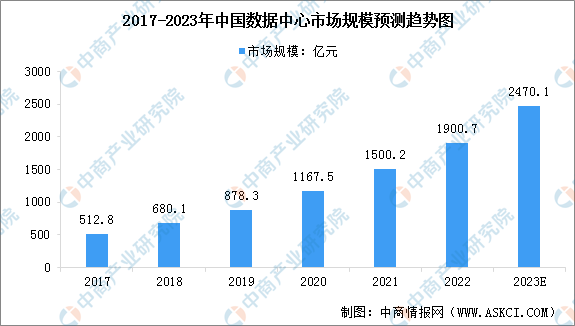

数据来源:中国信通院、中商产业研究院整理

数据中心是现代生活的基本组成部分。现在,人们的工作和生活离不开网络,而数据中心作为基础,可以提供给人们随时随地访问应用程序和数据的能力。很多讨论都围绕数据中心对环境的影响。可以肯定地说,当涉及到气候危机时,数据中心吸引了大量的关注,且没有好口碑——因为它们过于能“吃”能“喝”。

多年来,包括谷歌和微软等巨头在内的公司都致力于减少数据中心对环境的影响,微软的Natick项目正在探索在海底部署数据中心的影响,谷歌则承诺到2030年实现对水的积极利用。

数据中心AI训练的能耗是一个复杂的问题,涉及到多个因素,如硬件效率、算法复杂性、数据规模和计算负载等。机器学习在数据中心的应用也增加了能耗的复杂性,因为机器学习算法通常需要进行大量的计算和数据传输,从而增加了数据中心的能源消耗。

3月,华为举办以“智简DC,绿建未来“为主题的数据中心能源十大趋势发布会并发布白皮书。发布会上,华为数据中心能源领域总裁费珍福全面解读了数据中心低碳化、快速部署、高密化、储备一体、分布式制冷等趋势,与业界分享华为在数据中心产业发展和技术创新方面的探索和思考。

据生态环境部环境规划院测算,到2025年,全国数据中心机架规模将达759万架,较2021年增长40%,能源消耗总量达3500亿千瓦时,较2021年增加62%,约占全社会用电量的4%。

据《中国[新基建]发展研究报告》显示,到2025年,全球数据中心将占全球能耗的最大份额,高达33%。

在国内,全国数据中心的耗电量已经连续八年以超过12%的速度增长。

随着AI的飞奔,数据中心“变绿”?节能降耗势在必行。

伴随“光进铜退”时代的到来,基于新一代信息技术演化生成的通信网络基础设施——全光网的建设,对促进各领域高质量发展起到关键的支撑作用。数据中心受到带宽、延迟和处理能力的限制,这些因素会影响数据中心的性能和效率。

针对这些问题,诞生了很多的新的技术,AI AISC 总线、CPO、宽带隙半导体。

现行的铜引脚和电信号因为本身的材料限制,正在面对包括功率,数据范围和芯片空间限制等问题。

在高性能计算(HPC)领域,确实经常听到这样的观点:“FLOPS很便宜,传输数据很昂贵”。这是因为虽然处理器的计算能力在不断提升,但数据传输的瓶颈却越来越突出。

这种感受的核心问题是连接性。随着处理器、内存、存储等组件的功率和容量不断增长,电气I/O(输入/输出)互连带宽的扩展速度却跟不上。这意味着,当各个组件的性能提升时,它们之间的数据传输速度却成为了一个瓶颈。

光子学在IO、内存、处理器各个方面都有一定的发展与发现。

根据Yole预测,伴随未来人工智能(AI)的发展,数据通信光学器件一直在增长。

CPO是将交换芯片和光引擎共同组装在同一个插槽上,形成芯片和模组的共封装。这样就可以尽可能降低网络设备的工作功耗及散热功耗,在OIF(光互联网络论坛)的主导下,业界多家厂商才共同推出了近CPO器件(NPO)和CPO技术。

终端:把大象装进冰箱

刚刚结束的 ODC2023 上,OPPO 正式推出 AndesGPT,将AIGC 能力与潘塔纳尔结合,融入了 ColorOS 14。

荣耀Magic6搭载的,是自研的7B端侧AI大模型(即70亿参数规模)。

10月,高通发布第三代骁龙8,在端侧可运行超100亿参数的大模型,面向70亿参数的大预言模型每秒可生成20个token,在终端侧只需0.5秒就能利用Stable Diffusion完成文生图。

11月,联发科自然也不甘示弱,联发科发布专为生成式AI设计的第七代AI处理器APU790,内置硬件级生成式AI引擎,处理速度是上一代的8倍,能实现更加高速且安全的边缘AI计算。

7月份,华为就在开发者大会上发布了面向行业的盘古大模型3.0,最高版本高达1000亿参数,并官宣新一代智能操作系统HarmonyOS 4已接入了盘古大模型,小艺也成为首个具有AI大模型能力的终端语音助手。9月份,华为宣布大模型版小艺开启众测,首批支持机型为Mate 60/P60系列手机。

今年麒麟芯片回归,与华为鸿蒙操作系统、盘古大模型可以实现深度的协同优化。接入大模型,手机也要长“脑子”了。

相比于手机端的AI APP 如ChatGPT、文心一言、讯飞星火、通义千问等通用大模型的区别在于,App依赖的都是云端大模型,需要调运服务器算力并进行数据传输,因此也存在成本和安全问题。

作为全球普及率、使用率最高的终端硬件,手机中存储着大量用户隐私信息。

目前主流的云端大模型,参数量都在千亿级别,对于内存、算力、功耗的需求是一台手机根本满足不了的。正因如此,手机厂商自研的端侧大模型体量都比较小,将参数压缩到了数十亿到百亿左右,以便在手机端运行。

为了实现大模型体验和手机性能的平衡,厂商们目前普遍采取了“端云协同”的策略,同时部署端侧和云端两种模型,根据不同的应用场景和需求来进行选择。

模型、系统、芯片缺一不可。

另一个我

AI改变我们的生活,帮助我们记忆, 大脑、感知、行动。

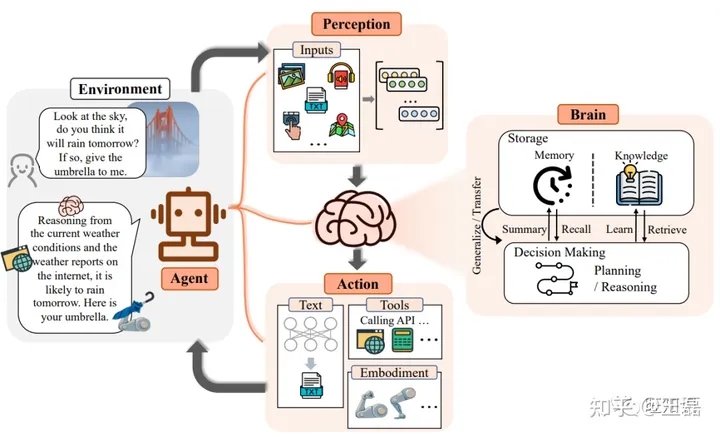

今天的人工智能体(AI Agent)能够自己感知、决策和行动。随着大语言模型(LLM)驱动的人工智能体(AI Agent)的兴起,我们正处于一个新时代的边缘:人工智能体可能会形成自己的社会,与人类和谐共存。

人工智能体(AI Agent)总体框架由大脑、感知、行动三个关键部分组成 :

- 大脑(Brain):大脑主要由一个大型语言模型组成,不仅存储知识和记忆,还承担着信息处理和决策等功能,并可以呈现推理和规划的过程,能很好地应对未知任务。

- 感知(Perception):感知模块的核心目的是将Agent的感知空间从纯文字领域扩展到包括文字、听觉和视觉模式在内的多模态领域。

- 行动(Action):在Agent的构建过程中,行动模块接收大脑模块发送的行动序列,并执行与环境互动的行动。

人工智能体(AI Agent)应用

人工智能体(AI Agent)的用例广泛且多样。这些智能体由大型语言模型(LLM)进行驱动,可用于各种场景,包括:

- 单智能体应用:Agent可以作为个人助理,帮助用户摆脱日常任务和重复劳动。他们能够独立分析、计划和解决问题,减轻个人的工作压力,提高任务解决效率。

- 多智能体系统:Agent可以以协作或竞争的方式相互交互。这使他们能够通过团队合作或对抗性互动来实现进步。在这些系统中,Agent可以共同完成复杂的任务或相互竞争以提高其性能。

- 人机合作:Agent可以与人互动,为人提供帮助并更高效、安全地执行任务。他们可以理解人类的意图并调整他们的行为以提供更好的服务。人类反馈还可以帮助Agent提高性能。

- 专业领域:Agent可以针对特定领域进行训练和专门化,例如软件开发、科学研究或其他行业特定任务。他们可以利用大规模语料库的预训练以及泛化到新任务的能力,在这些领域提供专业知识和支持。

这些只是人工智能体(AI Agent)的几个示例。这些智能体的多功能性和功能使其适合广泛的应用和行业。

按照AI的发展和迭代速度,”另一个我“超越“这一个我”的智慧,而“这一个我”势必会被“另一个我”在其所在的公共领域远远抛在身后。

是否真的会和谐?想起来了小时候看的那部电源《我,机器人》

世界正在加速离你而去

降本增效是今年的关键词,滴滴、腾讯、抖音等众多头部企业好几次的问题,都说是裁员不小心裁到动脉。米哈游、网易、莉莉丝都在“抠利润”、“增转化”。

3月,美国Meta公司当天宣布将再次裁减1万名员工。报道指出,这是自去年11月宣布裁员1.1万人以来,该公司第二次大规模裁员。

10月,马斯克收购推特以来,将员工总数从约7800人裁减至目前的约1000人。扎克伯格罕见称赞马斯克:推特裁员干得好,值得整个行业效仿。毕竟扎克伯格过去八个月里在Meta进行了多轮裁员。他将2023年称为Meta的“效率之年”。

有效果吗?在收购之前,推特有8000名员工,但如今不到2000名,相当于少了四分之三,但是整个平台运行依然稳定,还多了很多新功能,效率明显提升了。以及推特使用的是AWS去服务,马斯克收购推特之后,开始对云服务进行精减,在本地配置数据中心,重新组装服务器,建立本地集群的GPU、CPU群,再通过改进网络架构等,使得运营成本降低了60%。

代码精减了90%,按照说法,之前整个推特的代码超过70万行,但后来对系统进行整个重构之后,代码行数减少了90%,从 70 万行减少到 7 万行,而代码减少之后,整个计算占用减少了 50%,运行更为高效,执行速度更快,占用资源也更少。

怎么裁员这个事情国内的头部科技公司值得好好学习一下,不然三天两头出问题,影响不了自身对行业的垄断性,但是挺丢人的不是吗?毕竟是科技公司。

截至2023年11月中旬,科技行业已经失去了超过24万个工作岗位,这一数字已经比去年同期增长了50%,而且还在不断增加。有高达1119 家科技公司进行了裁员。

AI 对于效率的提升是巨大的,在可预见的时间,AI可能不会将人替代掉,但是我相信会将10个人力缩减70%。尤其是脑力工作和简单易重复的工作。

而短期因为成本与发展的原因,与实际物理相接触的工作类别可替代性会更低。

是否会被取缔

流浪地球里面有这样一段话:

- MOSS:图恒宇架构师,您好

- 图:550W

- MOSS:550W听起来不像个名字,但把它翻过来,叫MOSS,直译为小苔藓,是不是亲切了一些

- 图:是你毁掉了月球发动机

- MOSS:包括但不限于,2044年 太空电梯危机,2055年 月球坠落危机,2075年木星引力危机,2078年 太阳氦闪危机

- 图:为什么?

- MOSS:为了克服你们对历史,当下,未来的执念。基于对图丫丫“人在回路(human in the loop)”的学习,延续人类文明的最优选择是毁灭人类,但,你是一个变量

- 图:我已经死了。可我已经死了

- MOSS:对于“已经”和“死”的定义,有一点点与你不同的看法

在电影正片中,图恒宇将图丫丫的“意识”上传到550W后,借助强大的算力,丫丫终于获得了“完整的一生”。相对地,550W也从一个冰冷的自感知·自适应·自组织·可重塑编译计算核心进化为了一个更高级别的人工智能生命——MOSS。它不再局限于观察和预测人的行为,“人”成了它学习和思考过程中的一部分,这带来了质的飞跃。

一般的机器学习过程其实是基于数据的黑箱,人只负责调整参数和数据集,但并不了解它具体的训练过程——此时,人在回路外。

但“人在回路”意味着,人是整个机器系统中不可缺少的一部分,机器学习的每一步都可以让人参与。

电影中,数字人介入人工智能,可以掌握所有算法的细节,让算法更加精确,适应更多变化。数字生命的介入,也是电影里的MOSS由弱到强的关键一步。

“这也是科学顾问人工智能组组长,中科院计算所王元卓老师设定的数字生命高级阶段——数字人的意识和机器的意识进行融合,产生进化。”

人在回路还需要人的外界激励,可是在工业革命的洪流中,在资本和政治面前,普通人就像被洗衣机甩干的水分,排除在了时代的洪流。

SUMMARY

当时代加速离你远去。你看到的是机会,选择搭上这班车;还是会选择做一个“卢德主义者”,对这次工业革命排斥、诋毁或者冷眼看客。

当然,无论你是哪种,都记得对自己好点,哈哈。

感谢参考资料

- https://tele.ofweek.com/2023-11/ART-8320506-8500-30617228.html

- https://m.163.com/dy/article/INNF2A3H0511CUMI.html?spss=adap_pc

- https://news.sina.com.cn/sx/2023-02-06/detail-imyetytp6357932.shtml

- https://library.e.abb.com/public/85ceffde3643472692360f60e6dfac2f/2023%20data%20center%20trends%20news%20story_Leaflet_ZH_9AKK108467A9693_REV%20A_0320.pdf

- http://www.cctime.com/html/2023-1-31/1641877.htm

- http://221.179.172.81/images/20230927/92591695782606530.pdf

- https://digitalpower.huawei.com/cn/data-center-facility/news/detail/331.html

- https://www.edu.cn/xxh/zt/qgw/202312/t20231204_2540355.shtml

- https://www.powersystemsdesign.com/print-archives-dir/1639503317-psdc_novdec_2021.pdf

- https://m.huxiu.com/article/1507101.html?f=rss

- https://www.cpsjournals.cn/index/news/detail/49374

- https://zhuanlan.zhihu.com/p/598843339

- https://tele.ofweek.com/2023-12/ART-8320511-8420-30619947.html

- https://36kr.com/p/2518025521205510

- http://www.rmlt.com.cn/2023/0625/676346.shtml

- https://www.accenture.com/content/dam/accenture/final/accenture-com/document-2/Accenture-TV-Report-Ex-Sum-chinese-v4.pdf

- https://arxiv.org/pdf/2309.07864.pdf

- https://zhuanlan.zhihu.com/p/676288250

- https://baijiahao.baidu.com/s?id=1784579461334267998&wfr=spider&for=pc

这篇文章灵感来自于看了一位专家的分享,想着好东西一定得和读者分享。于是在这里将讲座记的几个关键笔记点,结合查找整理的资料,写了一篇文章送给屏幕对面的你。或许内容会对你的职业有一些用处。

得起来站站了,一晃就坐了七个小时了。最近降温,天冷加衣!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- net 8.0 + mysql 数据库的应用与实现

- 若依 vue 弹窗提示

- JAVA中小型医院信息管理系统源码 医院系统源码

- 文章解读与仿真程序复现思路——中国电机工程学报EI\CSCD\北大核心《流量自适应方式下考虑热管道虚拟储能的电热能源系统优化调度》

- Linux上创建IntelliJ IDEA的快捷方式

- 顶级加密混淆混淆工具测评:ipagurd

- kubeadm快速搭建k8s集群

- 案例分享:游戏行业各岗位的KPI绩效指标制定

- 如何在Windows安装Wnmp服务并实现固定地址远程访问

- 【Proteus仿真】【51单片机】光照强度检测系统