深度学习核心技术与实践之深度学习基础篇

发布时间:2023年12月28日

非书中全部内容,只是写了些自认为有收获的部分

神经网络

生物神经元的特点

(1)人体各种神经元本身的构成很相似

(2)早期的大脑损伤,其功能可能是以其他部位的神经元来代替实现的

(3)神经元具有稀疏激活性,尽管大脑具有高达五百万亿个神经元,但真正同时被激活的仅有1%~4%

神经元模型

(1)ReLu是一种特殊的Maxout函数

(2)理论上可以多种激活函数混用,但在实践中较少这样应用

感知机困境

(1)对于非线性问题,感知机只有通过人工提取特定的特征——在这些特征中将非线性的因素包含进来——使得特征仅用线性关系就可判别,才能达到目标。但这意味着非线性的引入需要靠人工完成,感知机完全帮不上忙

目标函数的选取

交叉熵的损失函数的偏导数结果简介、漂亮

初始化模型

2006年Hinton发表的Science论文提出了一种深度模型的可行训练方法,其基本思想是利用生成模型受限玻尔兹曼机一层一层地进行初始化训练,然后再利用真实数据进行参数微调

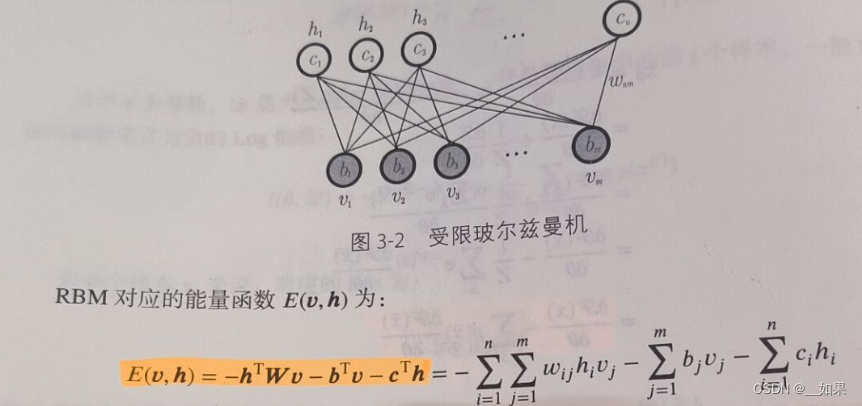

受限玻尔兹曼机(RBM)

(1)受限玻尔兹曼机由可视层和隐层构成

(2)RBM属于生成模型,用于建模观察数据和输出标签之间的联合概率分布

能量模型(EBM)

(1)系统越杂乱无序或概率分布越趋近于均匀分布,系统对应的能量越大

(2)当E(x) = -wx,EBM就是Softmax

带隐藏单元的能量模型

(1)在很多情况下,并不能直接观测到所有的x值,这时候往往需要引入隐藏变量

(2)

受限玻尔兹曼机基本原理

(1)玻尔兹曼机是一种特殊的对数线性马尔可夫随机场,因为其能量函数是参数的线性形式.。其隐藏单元既要依赖于观察单元,也要依赖于其他隐藏单元;观察单元可能既依赖于隐藏单元,也依赖于同层的其他观察单元

(2)受限玻尔兹曼机:同层之间不存在相互依赖关系,只有观察层和隐藏层之间存在关系

(3)能量函数:

(4)从概率图的角度来看,给定所有观察变量的值时隐藏变量之间相互独立;对称的,给定所有隐藏变量的值时观察变量之间相互独立

二值RBM

未完待续...

文章来源:https://blog.csdn.net/m0_73202283/article/details/135279203

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 节省时间:AI 模型靠谱下载方案汇总

- 【PostgreSQL内核学习(二十)—— 数据库中的遗传算法】

- 黑马程序员 Java设计模式学习笔记(一)

- [java] 转义字符&&控制台最常用快捷键

- java常见面试题:如何使用Java进行Spring框架开发?

- 传奇手游详细图文架设教程

- 基于Springboot的体育馆管理系统(有报告)。Javaee项目,springboot项目。

- Ansible常用模块的使用

- 大语言模型概述

- 浅析兼容性测试主要过程