Win11 跑通tensorRT

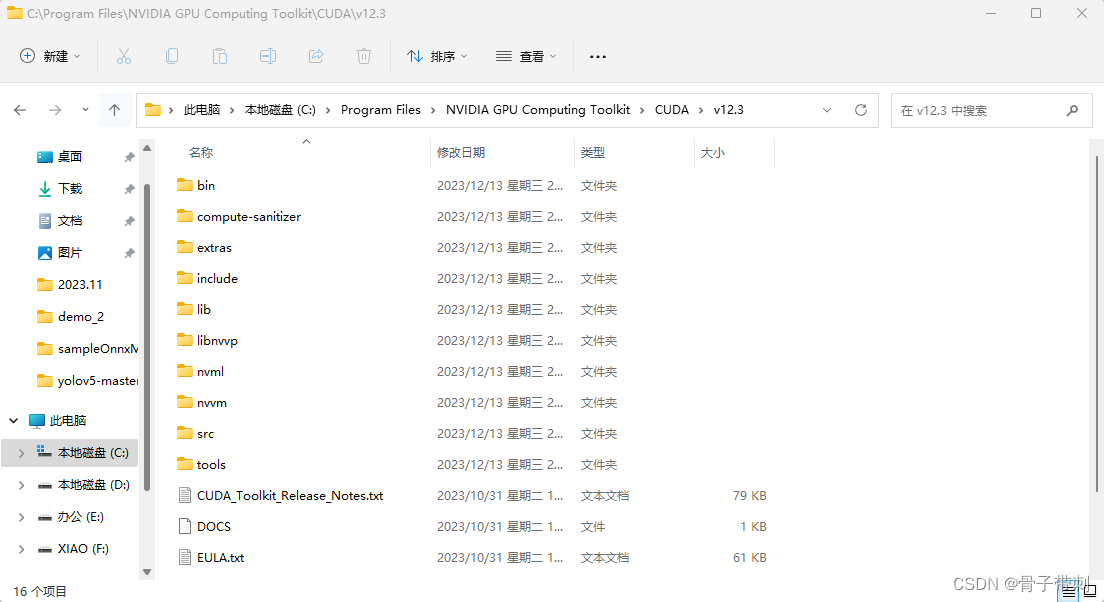

cuda_12.3.1_546.12_windows

TensorRT-8.6.1.6.Windows10.x86_64.cuda-12.0

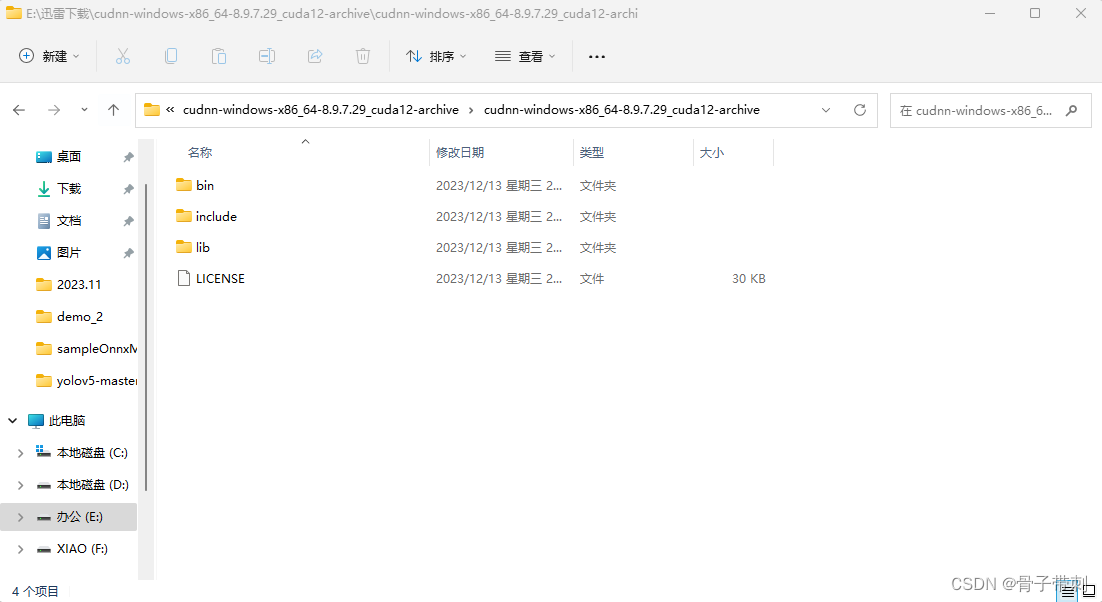

cudnn-windows-x86_64-8.9.7.29_cuda12-archive

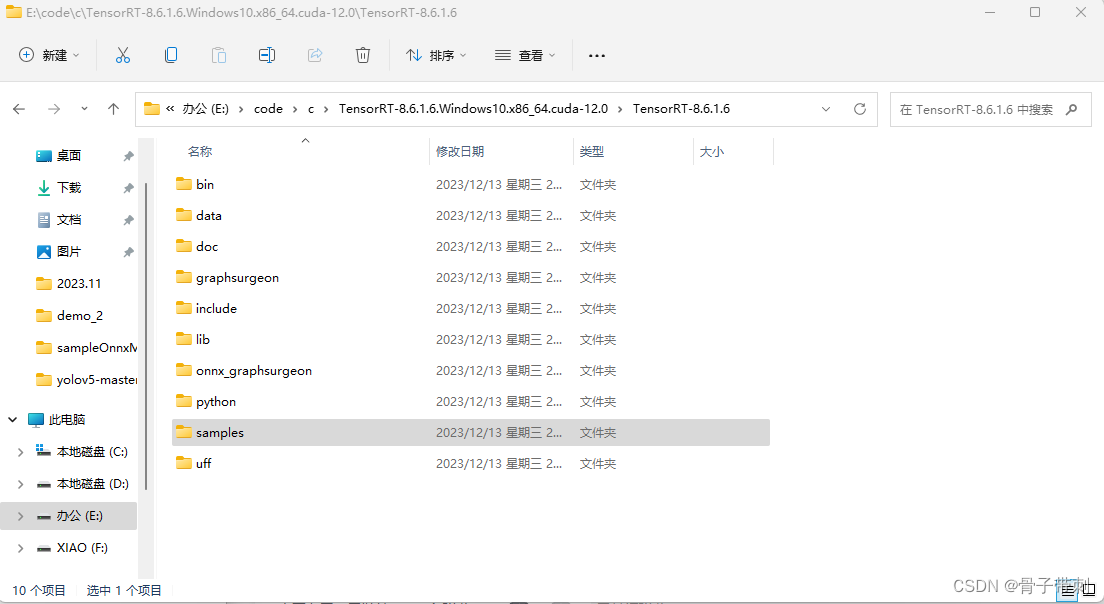

准备

1.安装cuda,成功之后文件夹如下图所示

2.下载cudnn,把cudnn对应的文件放在cuda里面

3.安装vs

4.安装对应cuda版本的tensorRT

https://developer.nvidia.com/tensorrt-download

5.opencv安装

编译好

打开vs,配置环境

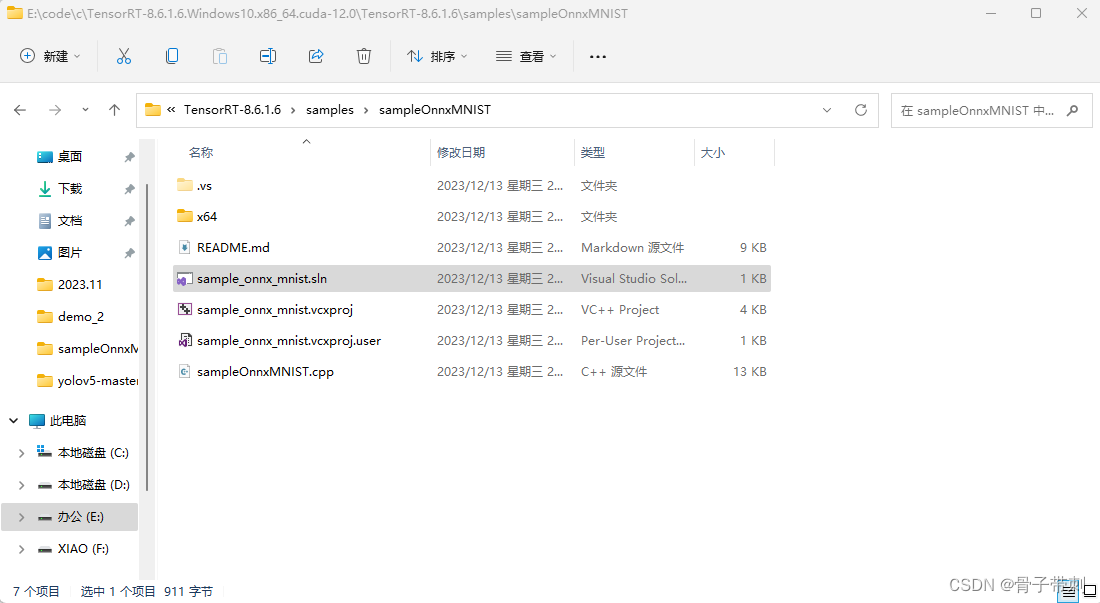

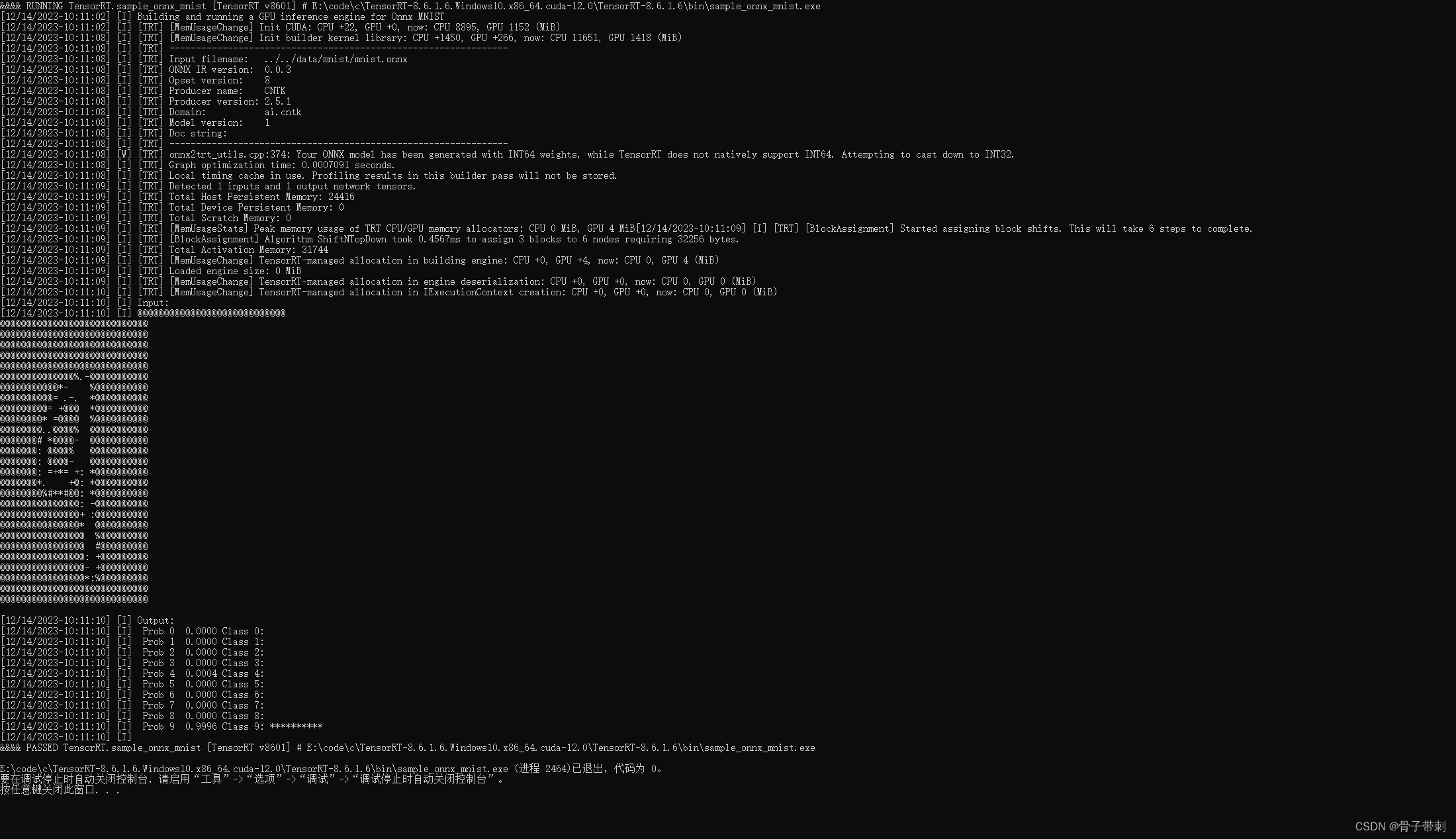

用vs打开tensorRT中sample这个demo,双击sample_onnx_mnist.sln

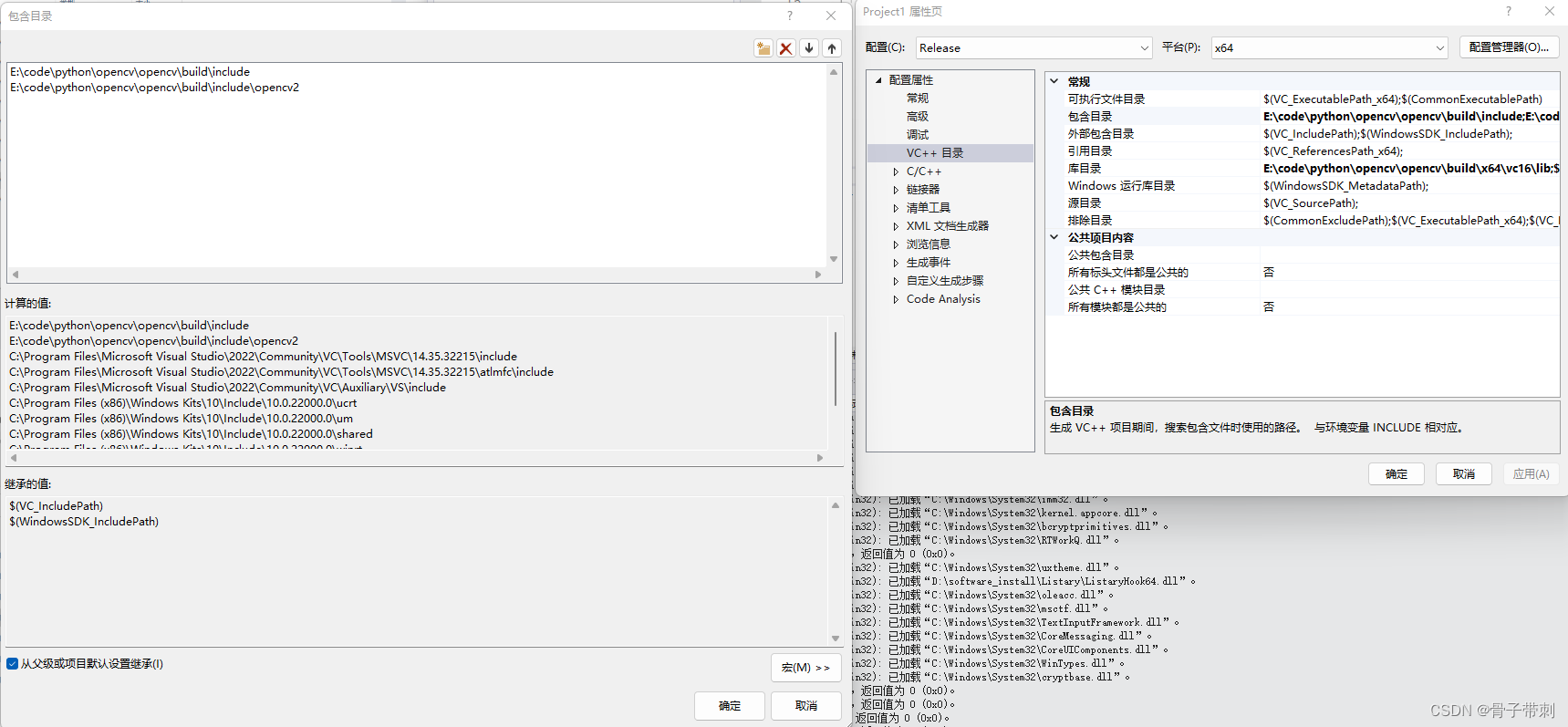

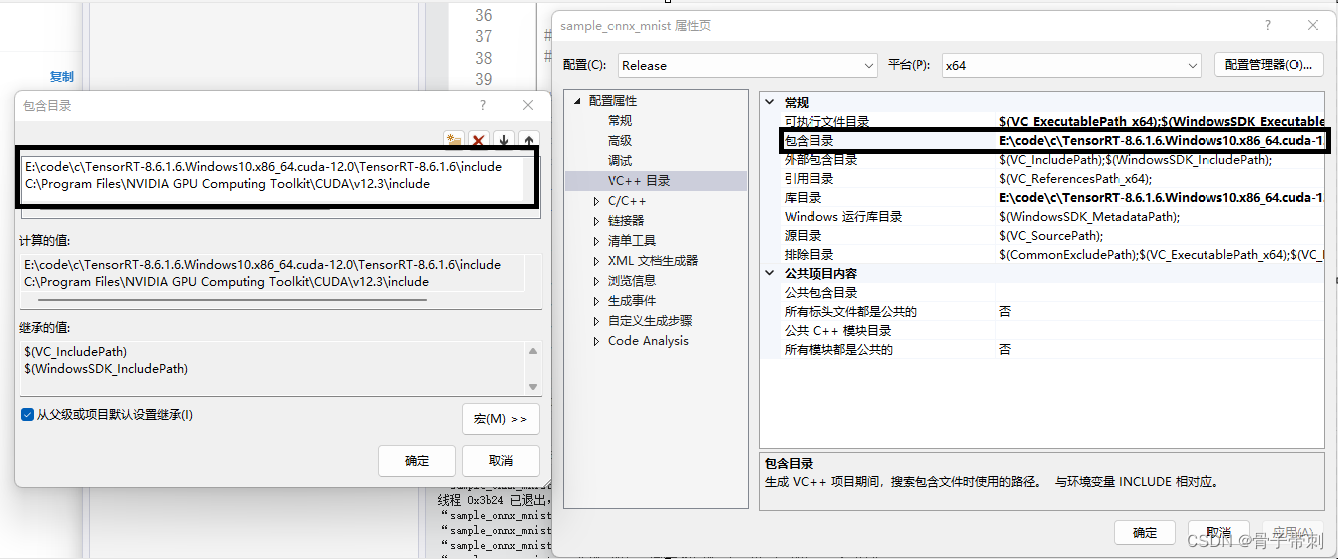

打开项目选项,属性,添加include

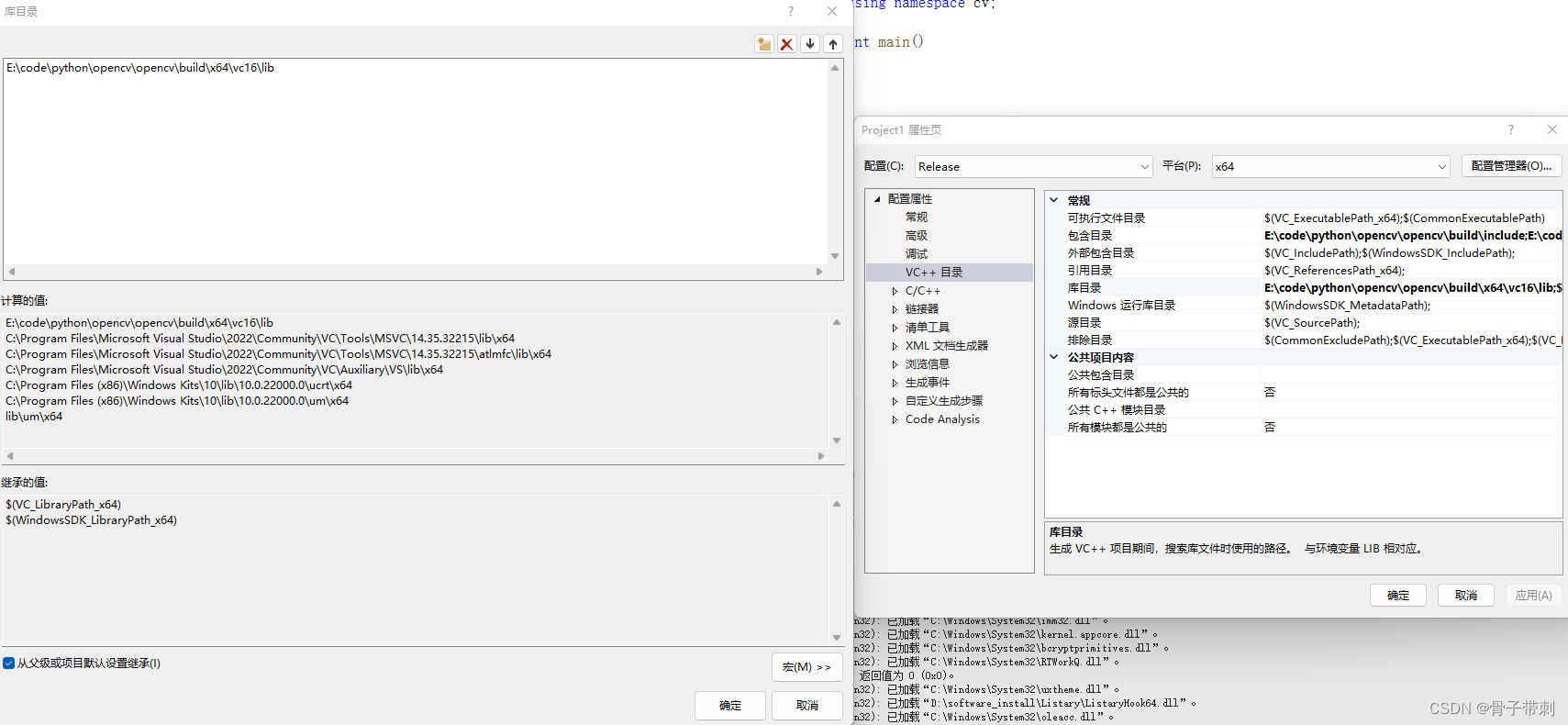

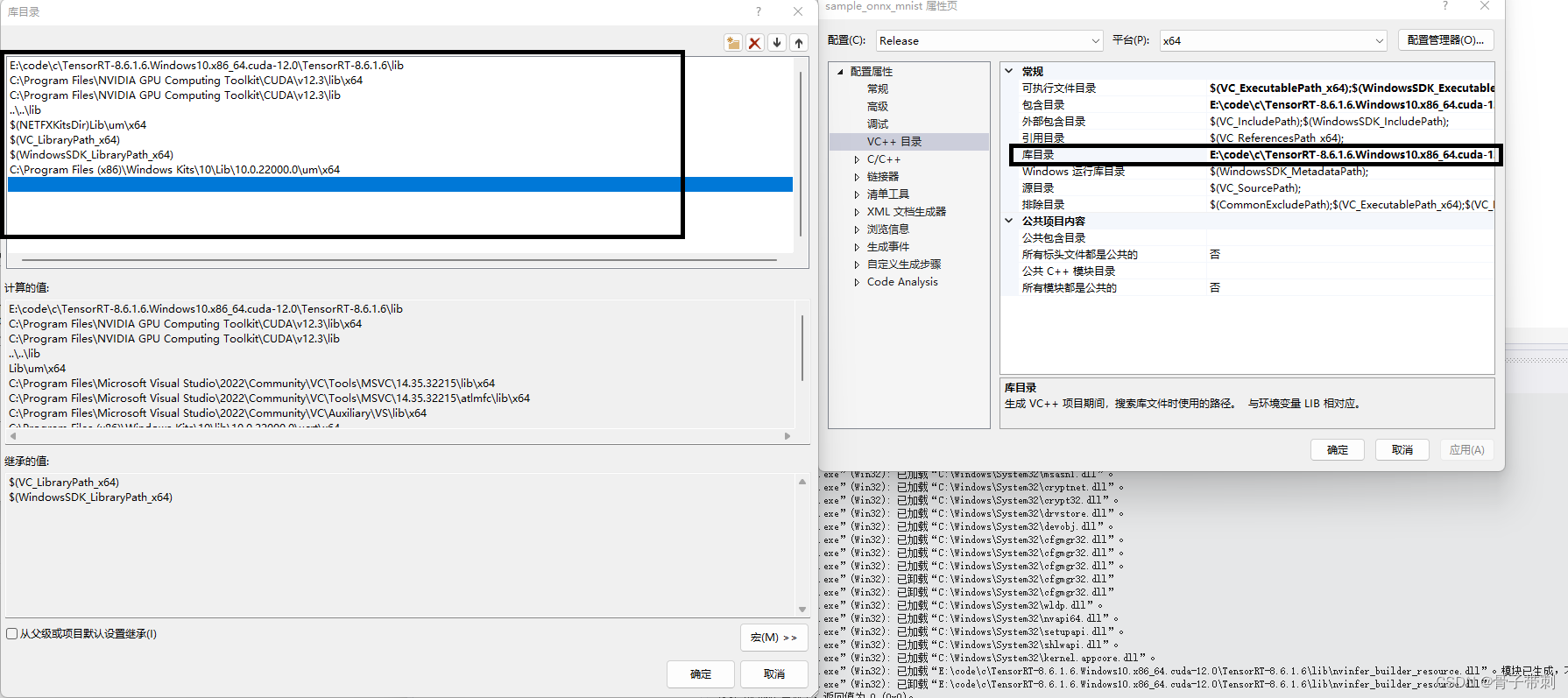

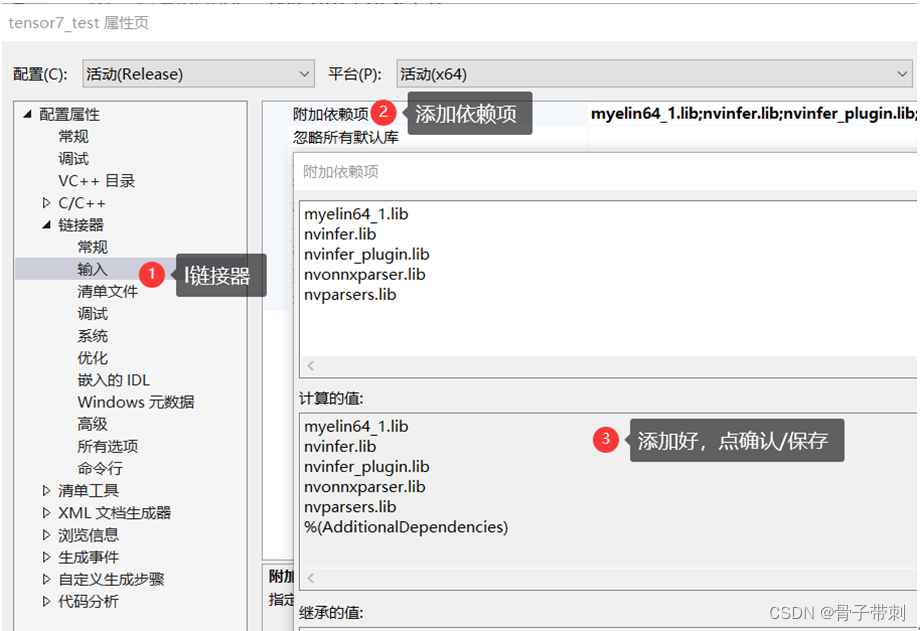

添加lib

直接运行

遇到的问题:

解决:

debug就debug里面添加,release就在release里面添加

tensorRT的sample中,附加依赖项是这样的

kernel32.lib

user32.lib

gdi32.lib

winspool.lib

comdlg32.lib

advapi32.lib

shell32.lib

ole32.lib

oleaut32.lib

uuid.lib

odbc32.lib

odbccp32.lib

%(AdditionalDependencies)

nvinfer.lib

nvinfer_plugin.lib

nvonnxparser.lib

nvparsers.lib

cudnn.lib

cublas.lib

cudart.lib

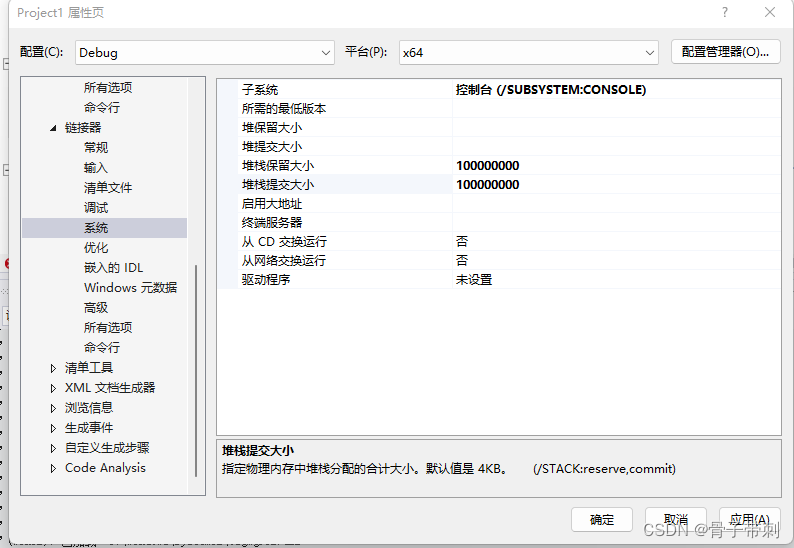

2.需要开启很大的数组

3.量化

对onnx模型,进行量化

使用tensorRT

trtexec --onnx=yolov5s.onnx --saveEngine=model_int8.engine --int8 --fp16

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Rust学习笔记006:代码组织

- 以远见超越未见丨硬核盘点之2023十大网安事件

- 智慧校园建设方案

- 一文揭秘人才成长规律,看到就是赚到

- 经销商持续加码国台,国台做对了什么?

- C++力扣题目232--用栈实现队列

- JavaSec基础 反射修改Final修饰的属性及绕过高版本反射限制

- 22k+star炒鸡好用的开源的网盘神器FileBrowser Docker自建个人网盘神器教程

- 2024年艺术发展与文化产业国际会议(ICADCI 2024)

- 微信小程序面试题