【机器学习】深度学习与神经网络

1 人工神经网络(Artificial Neural Network, ANN )

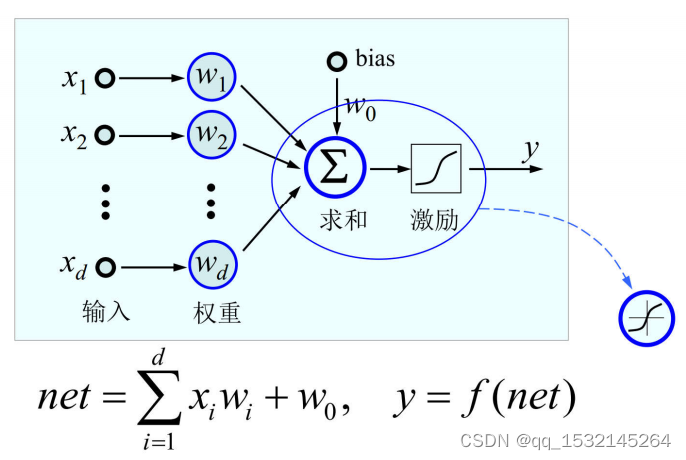

感知机:

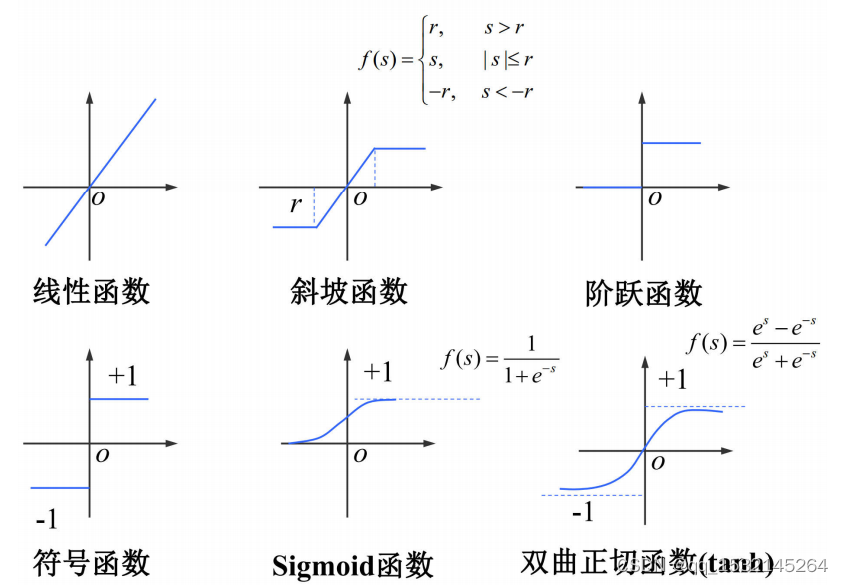

激励函数 f(·),也称转移函数、传输函数或限幅函数,其作用是将可能的无限域变换到指定的有限范围内进行输出。

常用的激励函数:

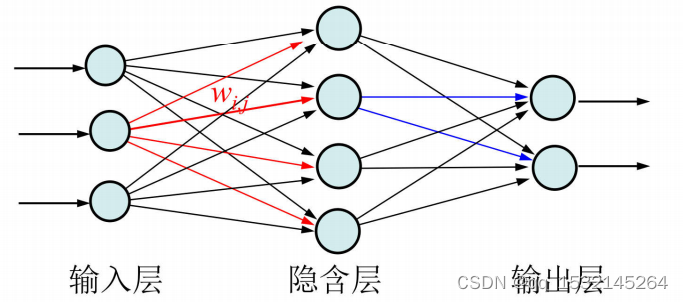

多层感知机:

输入层:接收输入信号的层。

输出层:产生输出信号的层。

中间层称为隐含层,不直接与外部环境打交道。隐含层的层数可从零到若干层。实际情况中,层与层之间可能有部分连接的情况。

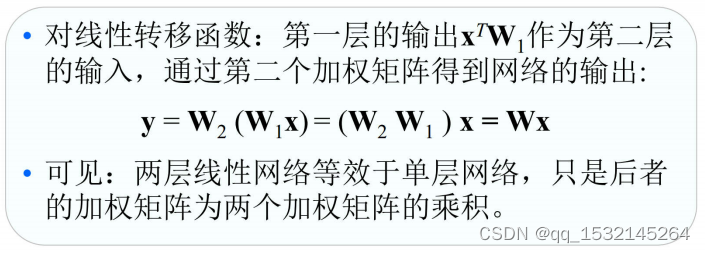

激励函数应是非线性的,否则多层网络的计算能力并不比单层网络强。

前馈网络:没有层内联接,各结点前馈联接到下一层所有结点

反馈网络:结点的输出依赖于当前的输入,也依赖于自己以前的输出

- 前馈型网络“不存储记忆”,结点的输出仅仅是当前输出的加权和(再加激励)。

- 在反馈网络中,要将以前的输出循环返回到输入。反馈网络类似于“人类的短期记忆”,即网络的输出状态部分取决于以前的输入。

2 卷积神经网络(Convolutional Neural Networks, CNN)

卷积神经网络是一类包含卷积计算且具有深度结构的前馈神经网络,广泛应用于图像处理。

2.1 CNN算法组成结构

CNN算法结构主要组成部分:卷积层、池化层、全连接层。

卷积层

简单讲,进行卷积计算,提取特征。

池化层

池化层基于局部相关性的思想,通过从局部相关的一组元素中进行采样或信息聚合,从而得到新的元素值。

作用:减少参数、降维、防止过拟合。

常见的池化方式:

(1)最大池化(Max Pooling),从局部相关元素集中选取最大的一个元素值。

(2)平均池化(Average Pooling),从局部相关元素集中计算平均值并返回。

全连接层

顾名思义,连接所有神经元,输出结果。

2.2 CNN两大核心

局部链接:每个神经元只与上一层的部分神经元相连。即,只让相关性较强(一般指的距离较近的)的神经元参与计算。

参数共享:同一个卷积核在计算中都是共享的。

3 循环神经网络(Recurrent Neural Network, RNN)& 递归神经网络(Recursive Neural Network, RNN)

两者都简称为RNN,都可以处理序列数据。都主要都应用在在自然语言处理(Natural Language Processing, NLP)。但两者的算法结构不同。

想进一步了解可以看以下参考文章。

参考文章:

深度学习知识点全面总结

大话卷积神经网络(CNN)

大话循环神经网络(RNN)

百度百科:卷积神经网络

百度百科:循环神经网络

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【每日一题】【12.29】 - 【12.31】年终收尾

- 初识JVM底层知识,一文读懂JVM知识文集。

- 外包干了3年,技术退步太明显了。。。。。

- VC2019更改文件名称代码

- 微信小程序(五)下拉刷新

- 在ASP.NET MVC中使用JQuery提供的弹出窗口(模态窗口)

- 【设计模式】腾讯面经:原型模式怎么理解?

- 死锁的原理、产生条件及避免死锁的方法,银行家算法的简介和实现

- Qt pro文件

- Jtti:Linux内核怎么通过inline hook实现隐藏进程