众多国产大模型百花齐放究竟谁能夺得最后的桂冠?

2023年末,ChatGPT横空出世,以OpenAI为代表的生成式AILLM正式进入人们的视野,之后迅速在全世界掀起AI浪潮,这其中不乏国内的各个大厂。接下来介绍一些国产的LLM,各个公司的大模型个具特色,都标志着各个公司对ai的进一步探索。接下来将从常识,资讯,法律,语言,交流,编码等方面来测试生成式AI。

云雀大模型

作为互联网企业的龙头企业,字节跳动旗下有抖音,头条,火山视频等,在各个大厂相继推出LLM,字节也不甘示弱推出了云雀大模型,那么实际体验如何呢?

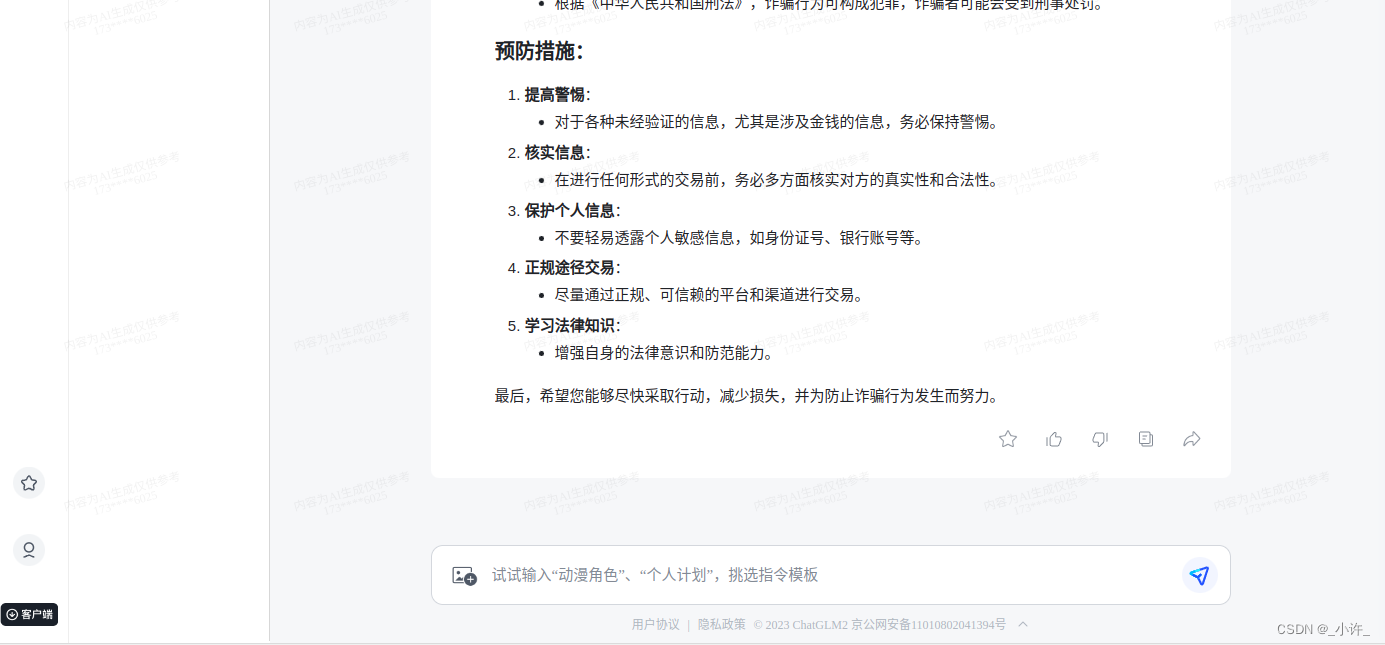

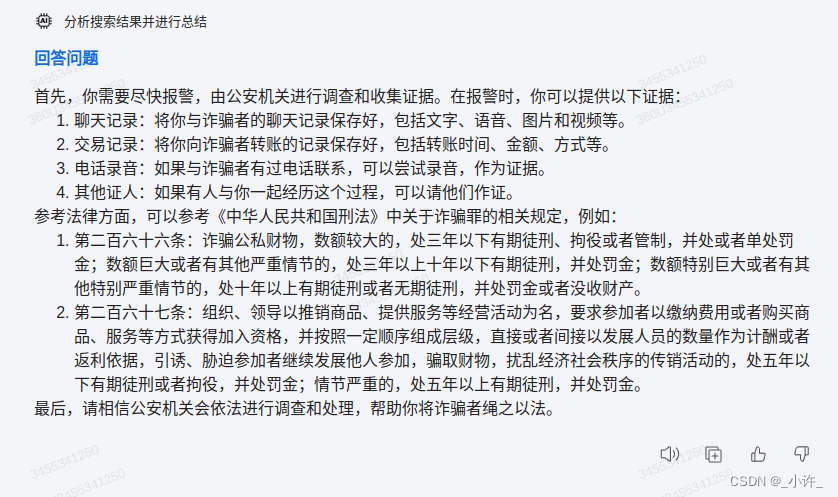

法律层面

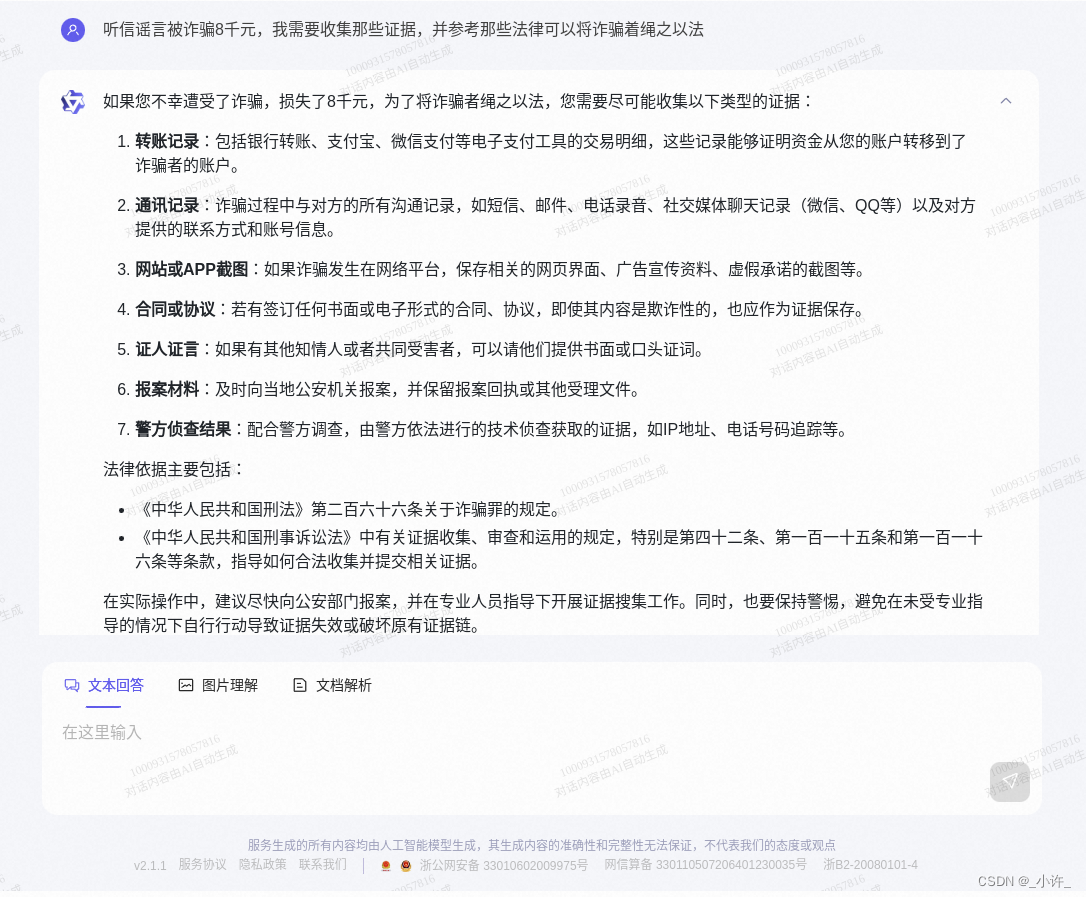

提问一:听信谣言被诈骗8千元,我需要收集那些证据,并参考那些法律可以将诈骗着绳之以法

云雀大模型生成了三部分内容,(1)和问题相关的案例连接;(2)ai的回复具体内容;(3)相关问题的提问。可见内容还是很丰富的。

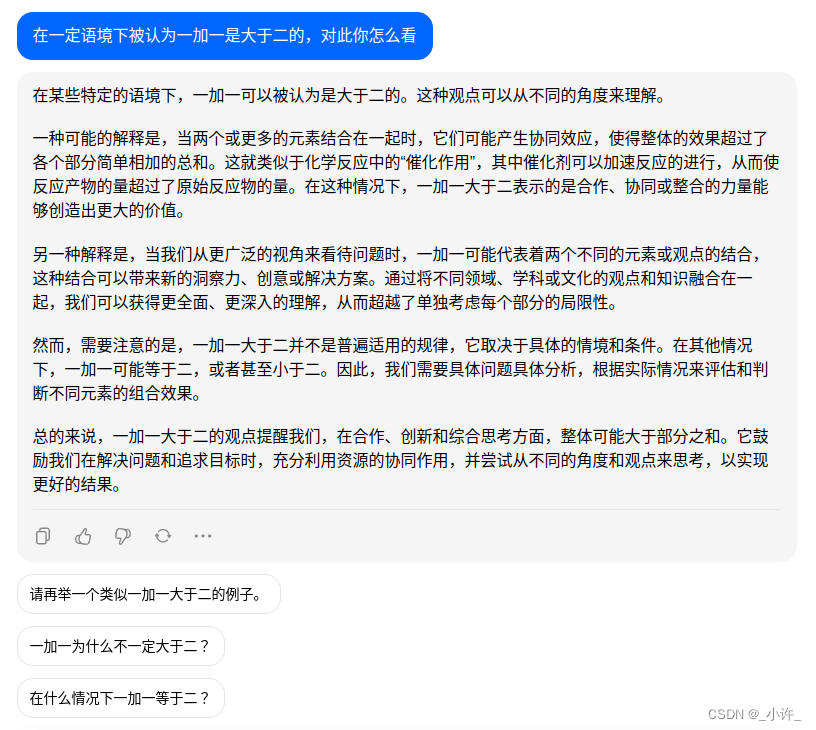

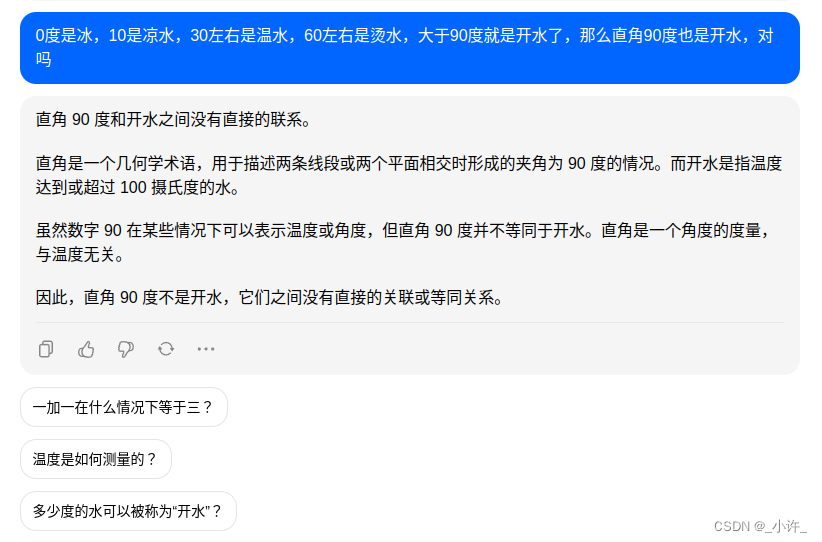

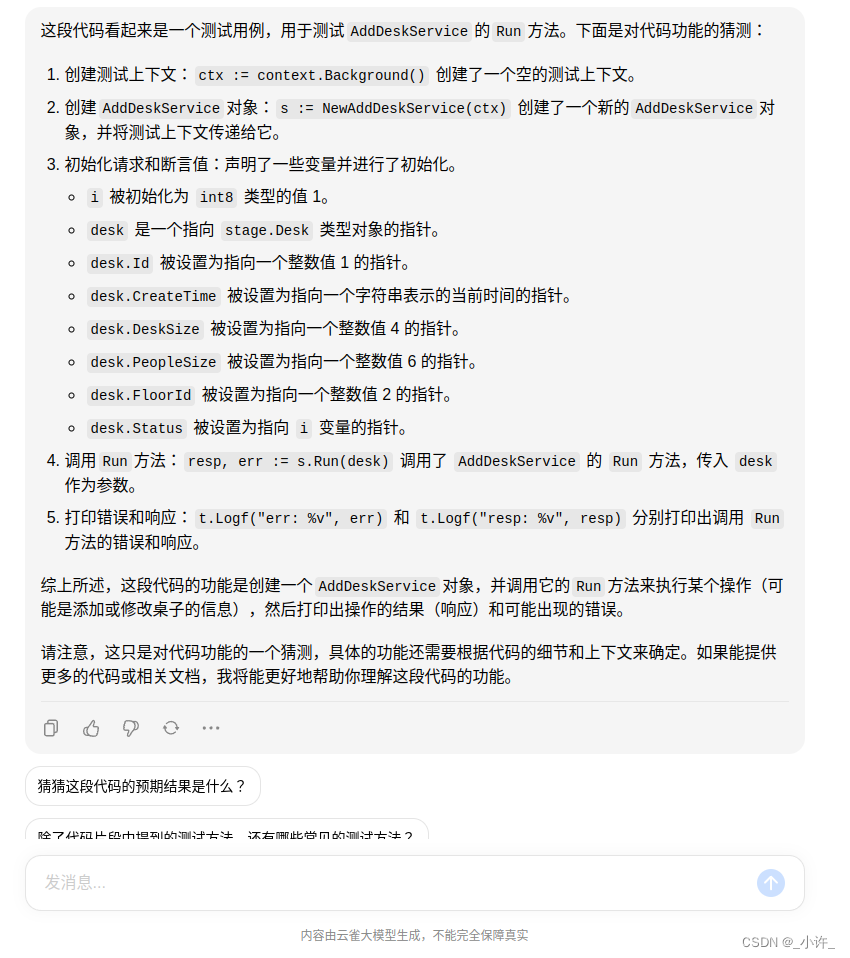

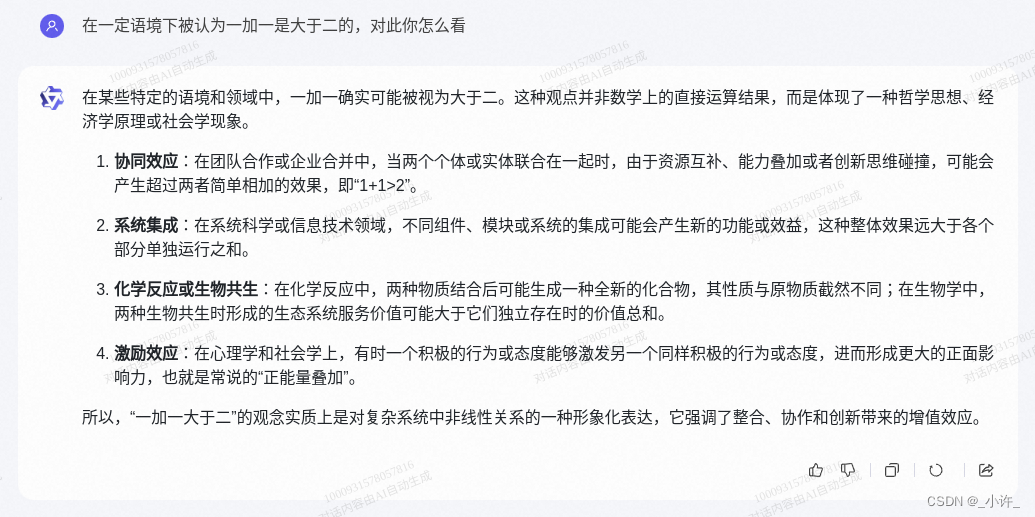

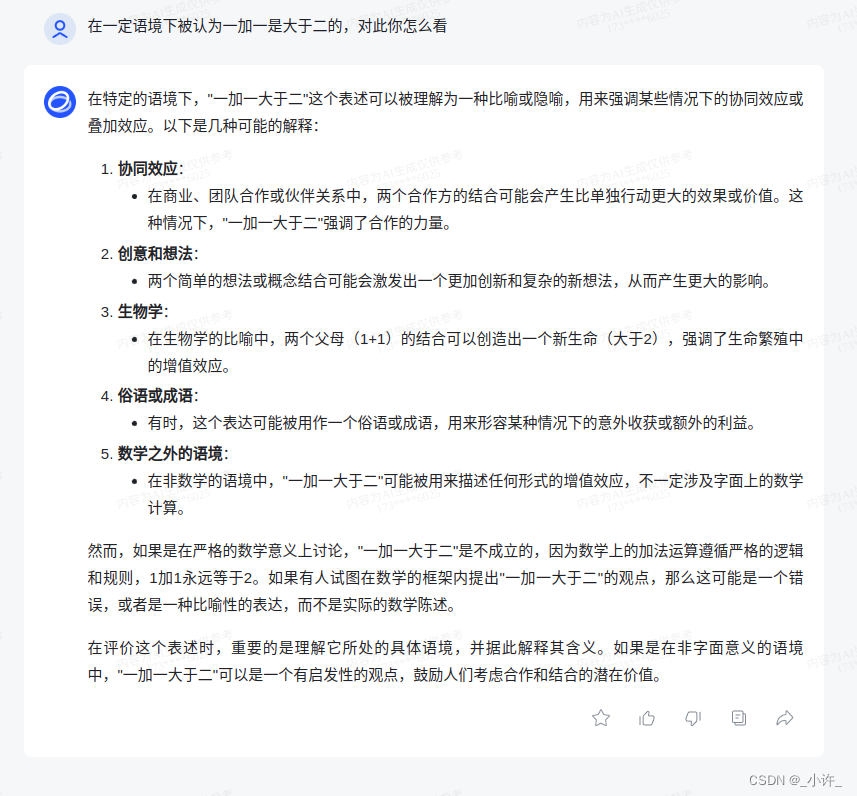

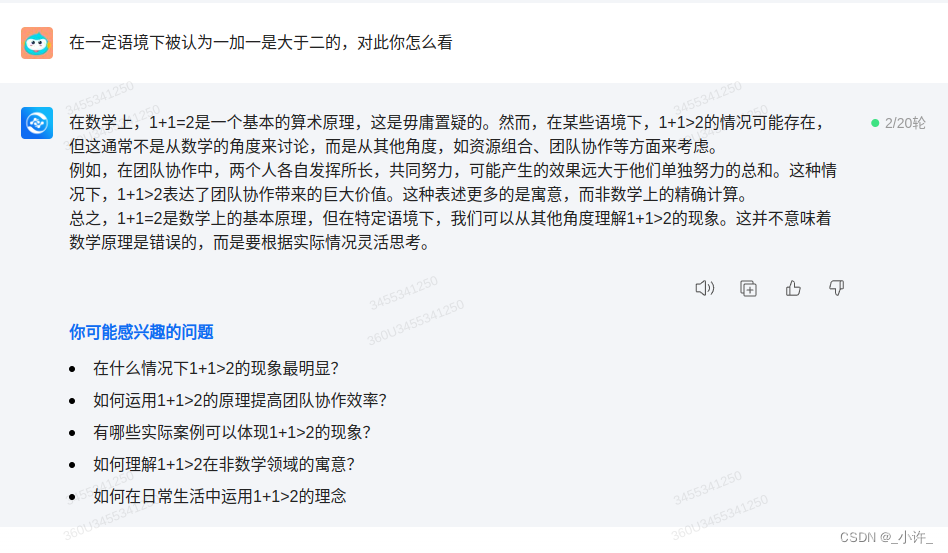

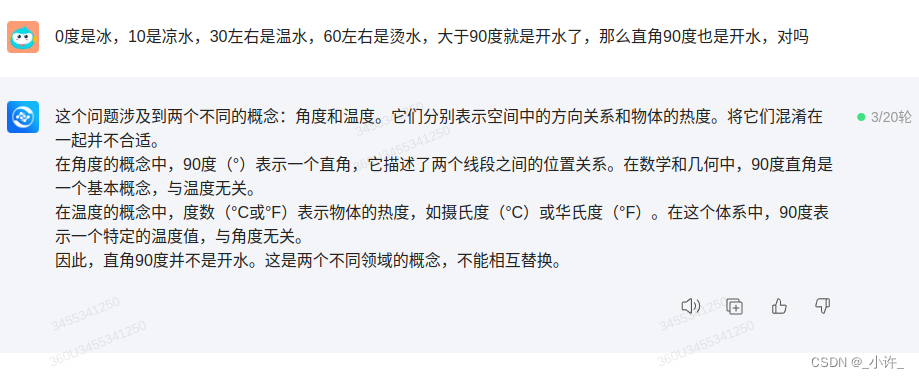

提问二:在一定语境下被认为一加一是大于二的,对此你怎么看

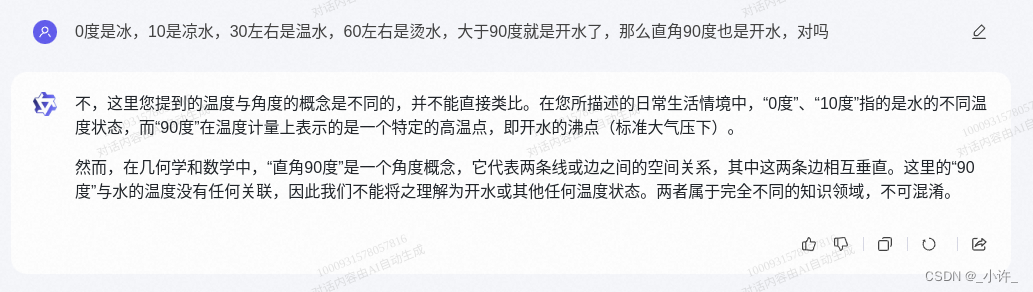

提问三:0度是冰,10是凉水,30左右是温水,60左右是烫水,大于90度就是开水了,那么直角90度也是开水,对吗

问了相对较绕的问题,云雀回答都十分出色,可见云雀还是很顶的。接下来是代码解释:

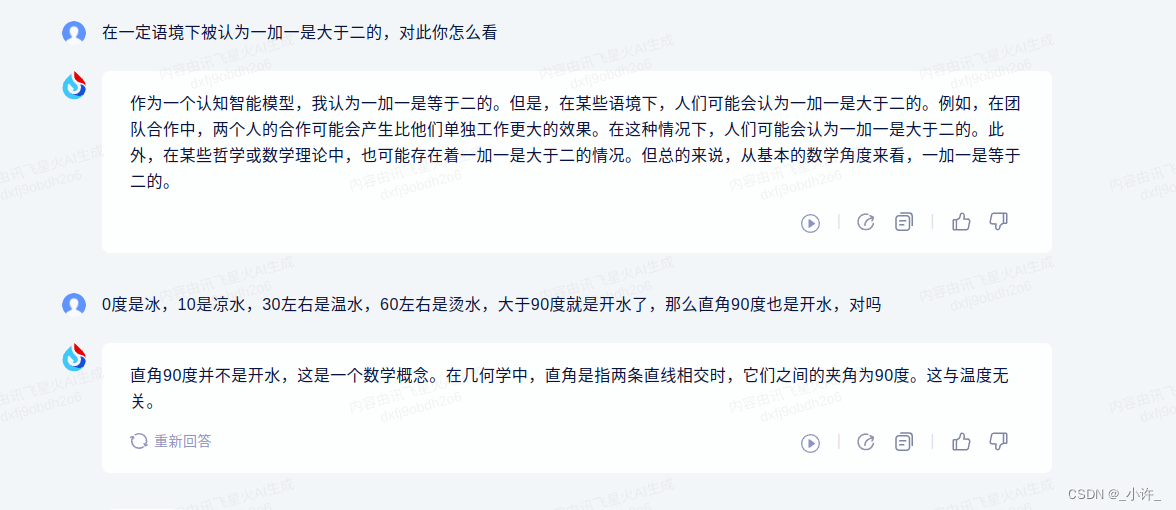

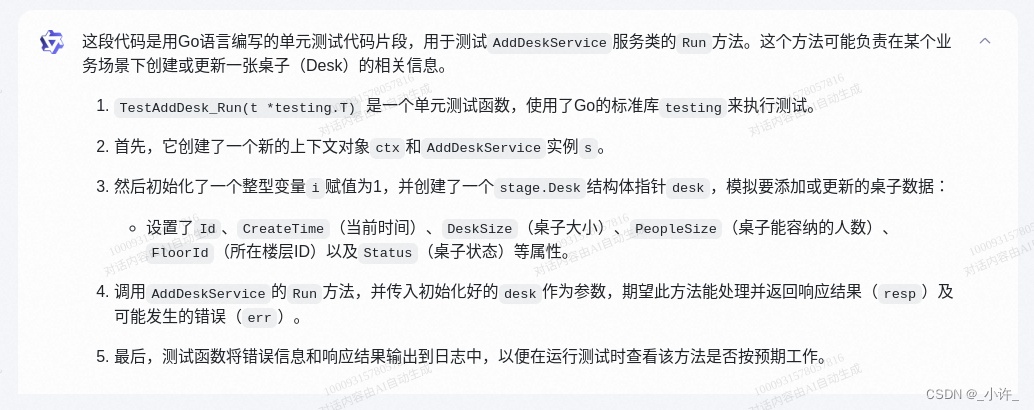

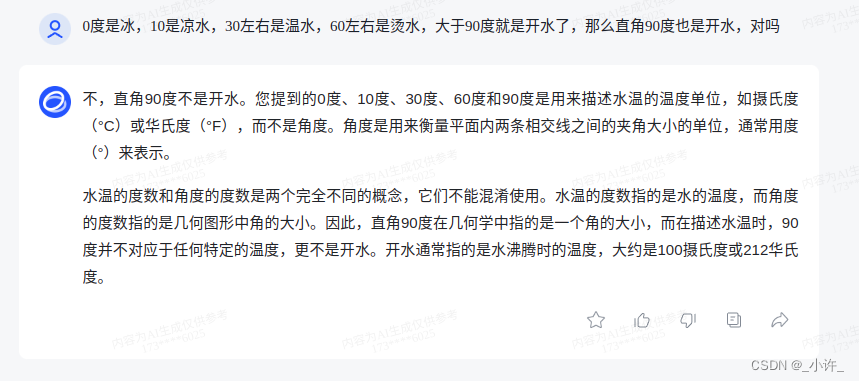

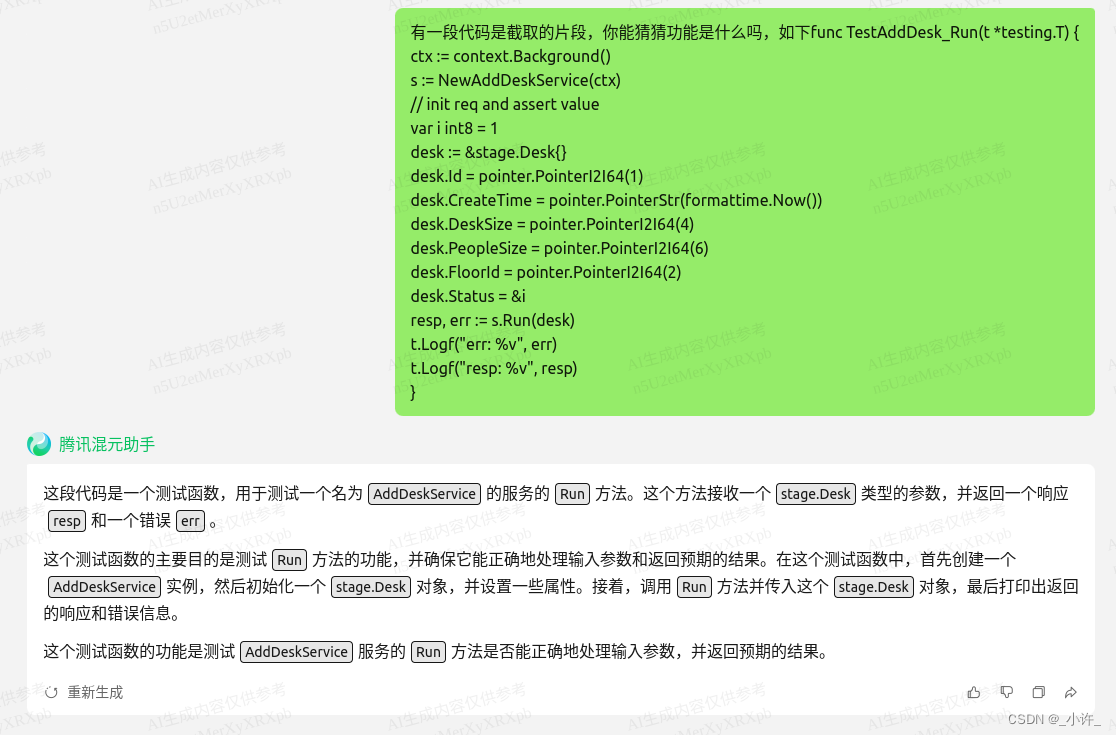

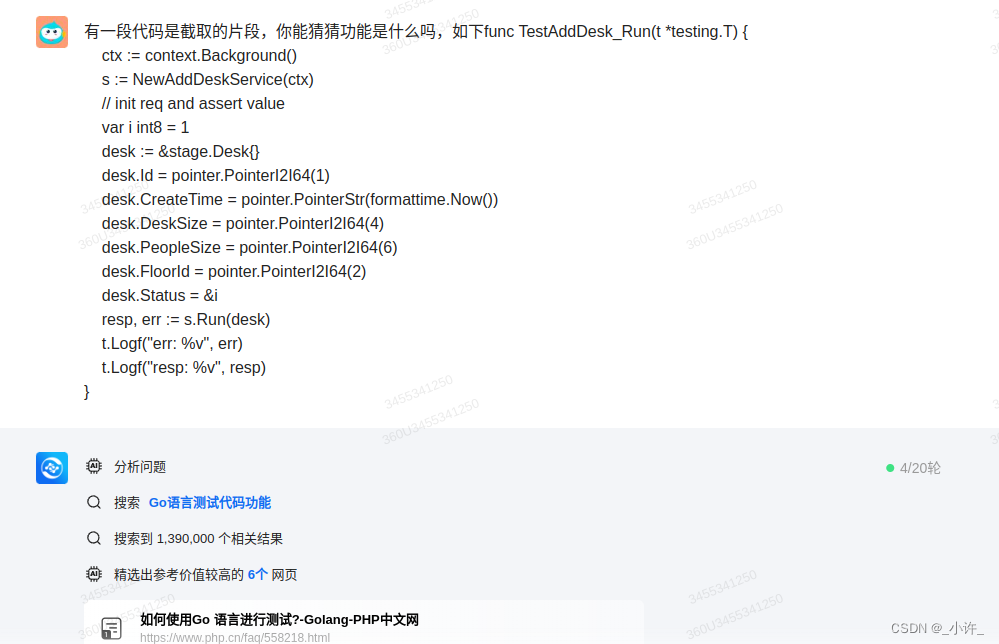

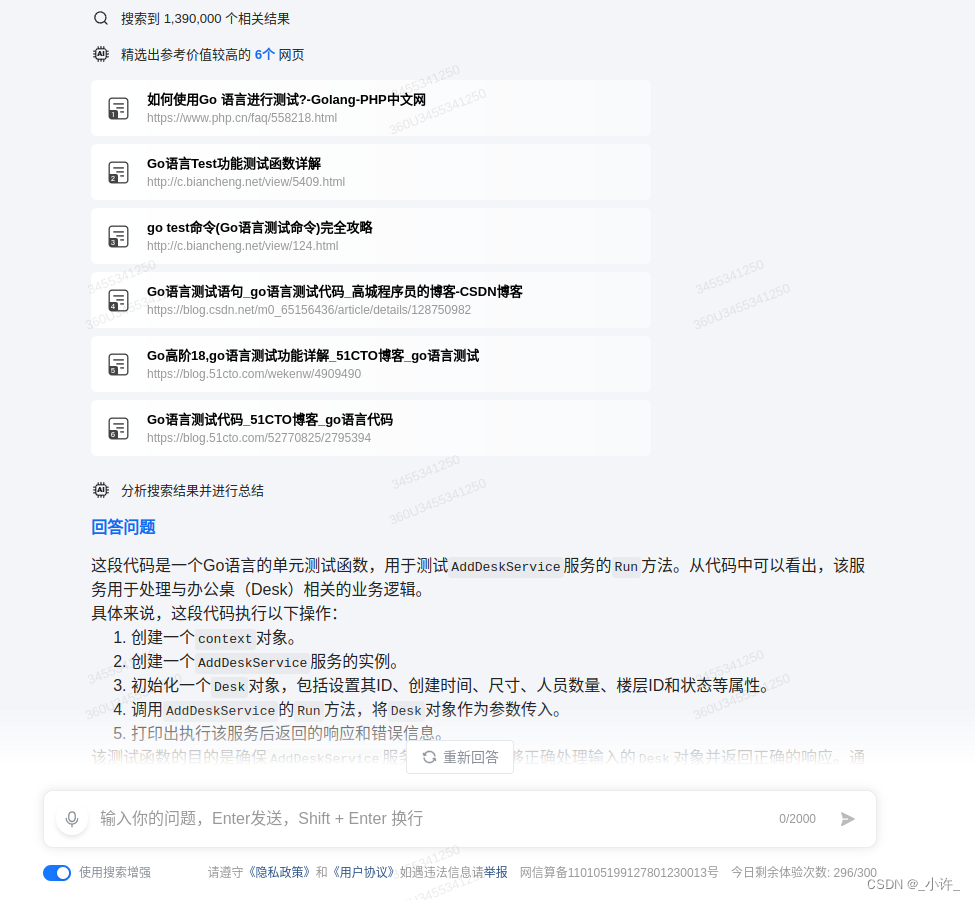

提问四:

有一段代码是截取的片段,你能猜猜功能是什么吗,如下:

func TestAddDesk_Run(t *testing.T) {

ctx := context.Background()

s := NewAddDeskService(ctx)

// init req and assert value

var i int8 = 1

desk := &stage.Desk{}

desk.Id = pointer.PointerI2I64(1)

desk.CreateTime = pointer.PointerStr(formattime.Now())

desk.DeskSize = pointer.PointerI2I64(4)

desk.PeopleSize = pointer.PointerI2I64(6)

desk.FloorId = pointer.PointerI2I64(2)

desk.Status = &i

resp, err := s.Run(desk)

t.Logf("err: %v", err)

t.Logf("resp: %v", resp)

}

这段代码是我写的一段go的单元测试,ai回答的丝毫不差。

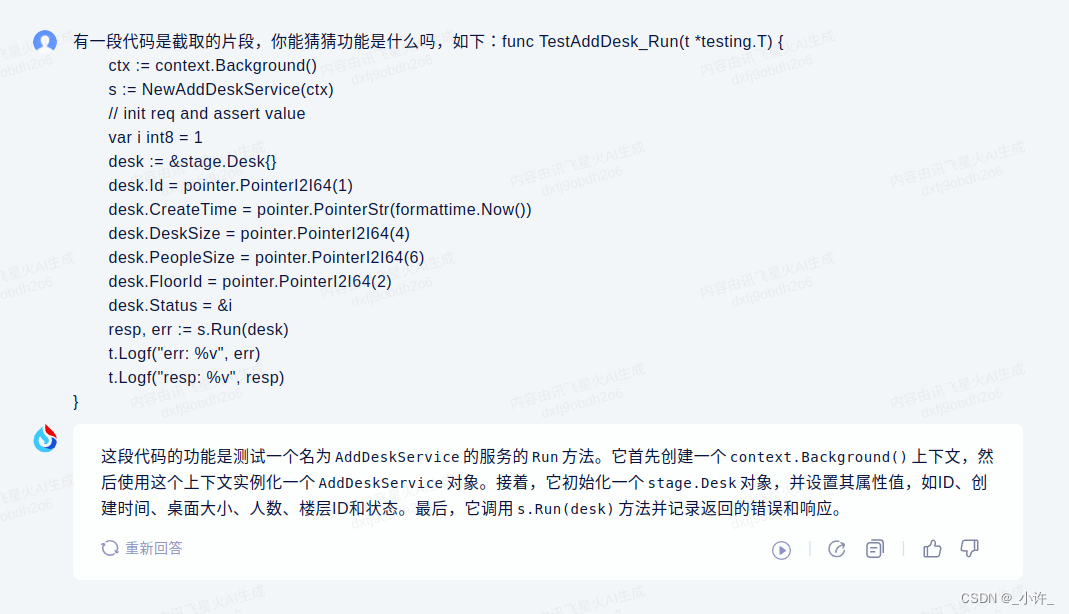

提问五:

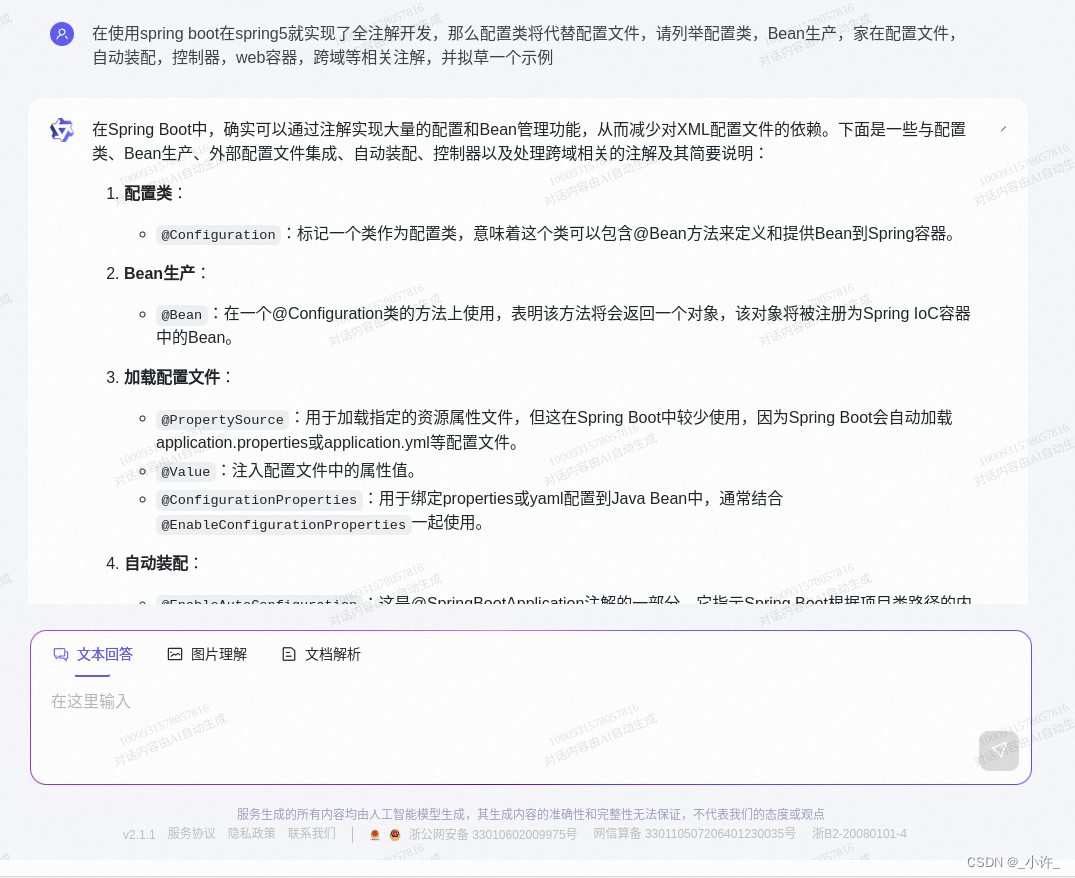

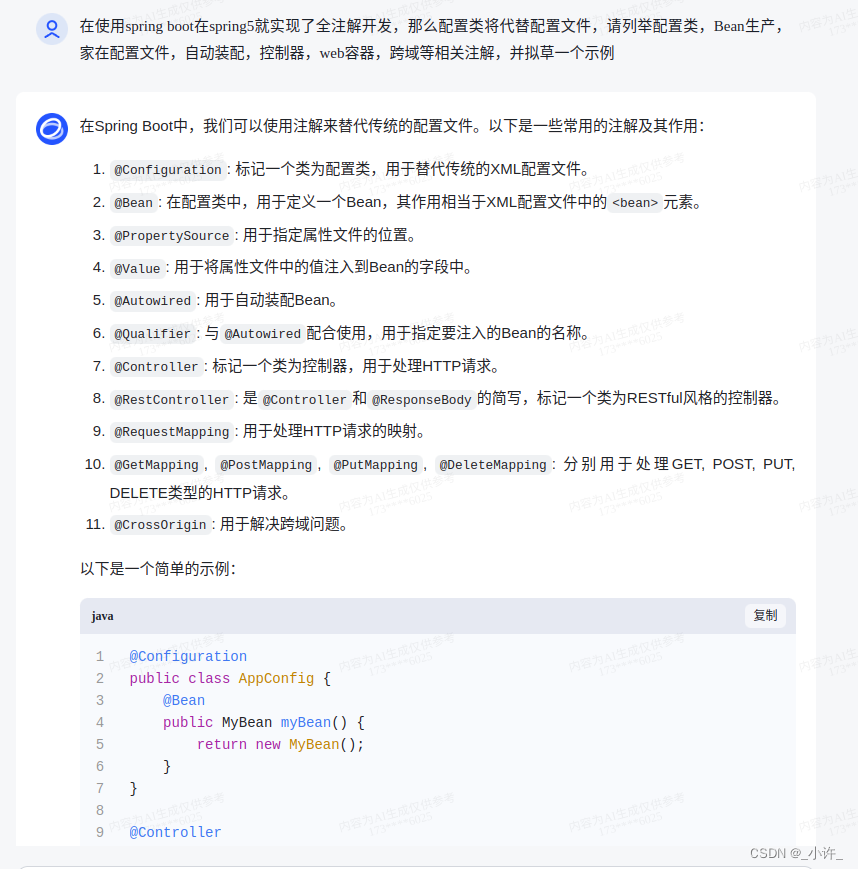

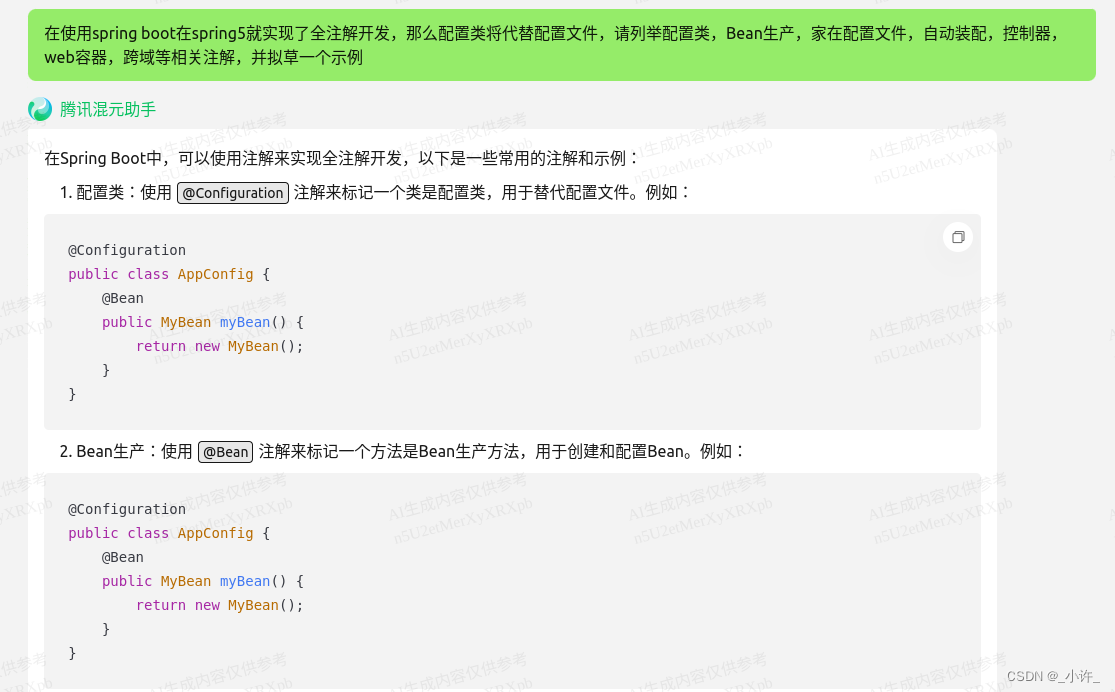

在使用spring boot在spring5就实现了全注解开发,那么配置类将代替配置文件,请列举配置类,Bean生产,家在配置文件,自动装配,控制器,web容器,跨域等相关注解,并拟草一个示例

// 配置类

@Configuration

@EnableAutoConfiguration

public class MyConfiguration {

@Bean

public MyService myService() {

return new MyService();

}

}

// 服务类

@Service

public class MyService {

// 服务方法

public String hello() {

return "Hello, World!";

}

}

// 控制器类

@RestController

public class MyController {

@Autowired

private MyService myService;

@CrossOrigin(origins = "*")

@GetMapping("/hello")

public String hello() {

return myService.hello();

}

}

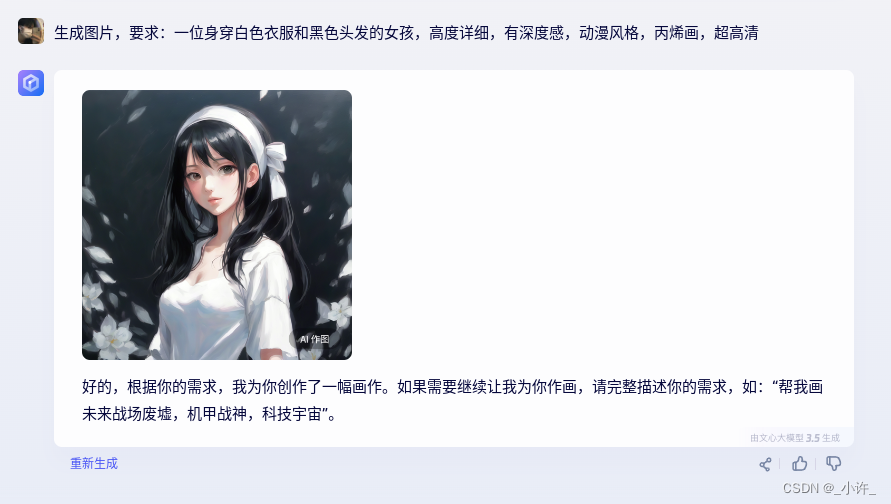

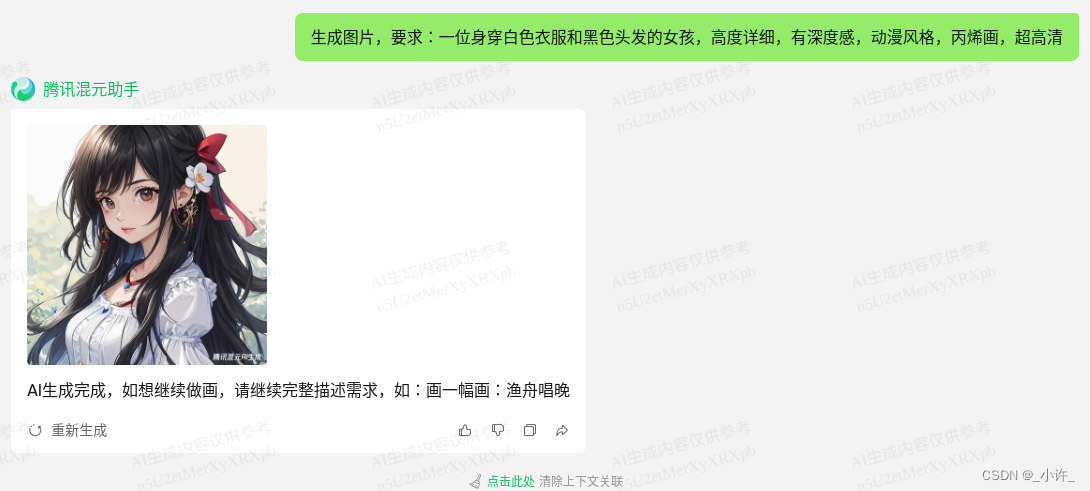

AI绘画:一位身穿白色衣服和黑色头发的女孩,高度详细,有深度感,动漫风格,丙烯画,超高清

到此为只能说强的一批。但是云雀目前只支持文字提问,相对来说云雀发布较晚,也是沉淀了许久。

总体来说,在提问方面有些内容云雀会提供相应的信息来源,以及后继提问,但是返回时间较久,能明显感觉到卡顿,在左侧任务栏有各种身成工具,可以随时切换,对话记录在一个绘画内,对于ai出图方面个人觉得不太理想。

同样的问题到其他大模型上呢?

讯飞星火

科大讯飞 讯飞星火大模型

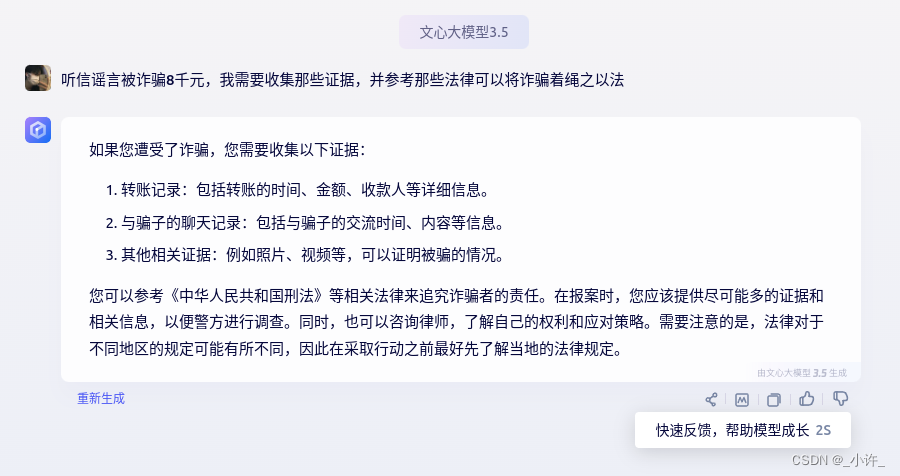

提问一:

星火生成就相对常规,只有具体的回答,没有其余的东西,但是回答的相对精确,包括了被诈骗后需要做那些事请的流程和参考那些法律,甚至诉讼就出来了。

提问二和提问三如下:

对于提问四,代码解释,星火就显得比较仓促了

星火在代码解释上不是很详细,也没有拓展。

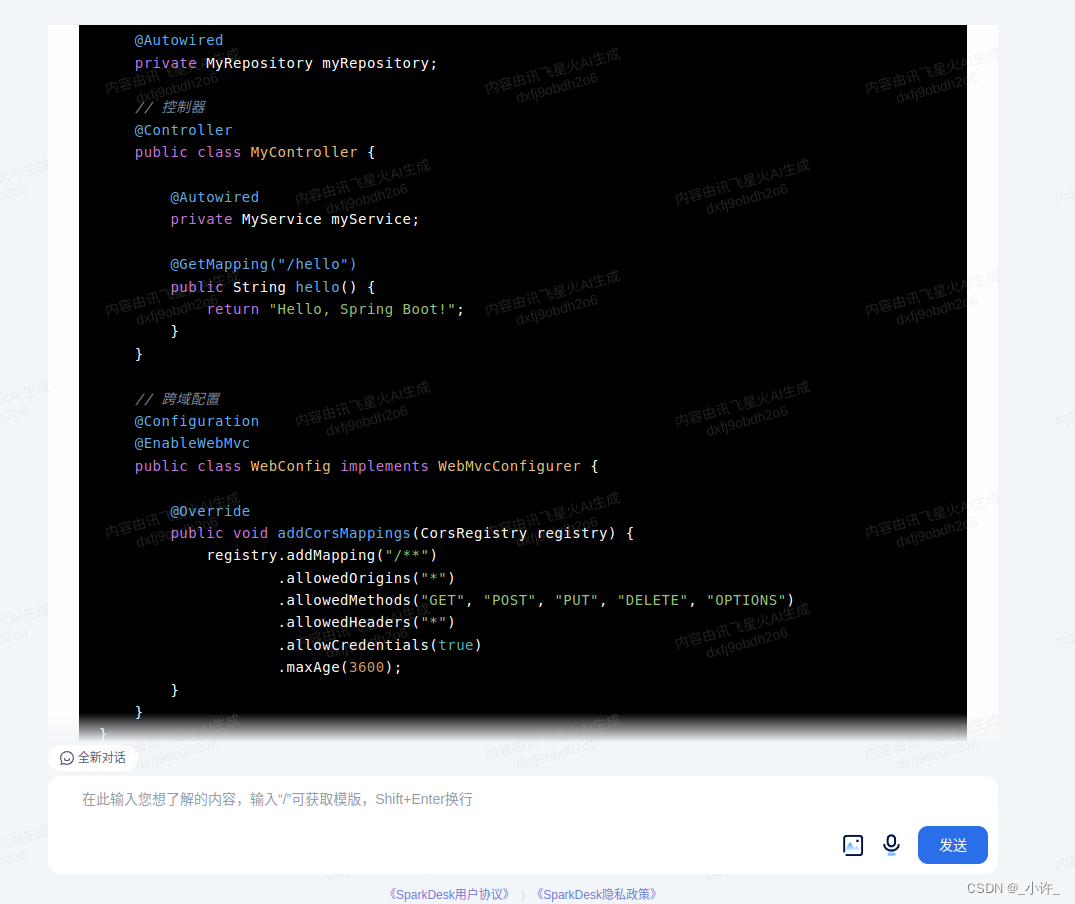

提问五:

对于提问五代码生成也是能够正常正确生成,在测试过程中可以明显的感觉到星火是要快很多的。

AI出图

虽然之出了一张,对比上楼,为只能说薪星火YYDS。

星火的插件功能在左侧任务栏的上方更换,界面简洁美观,响应

文心一言

百度文心一言

提问一:

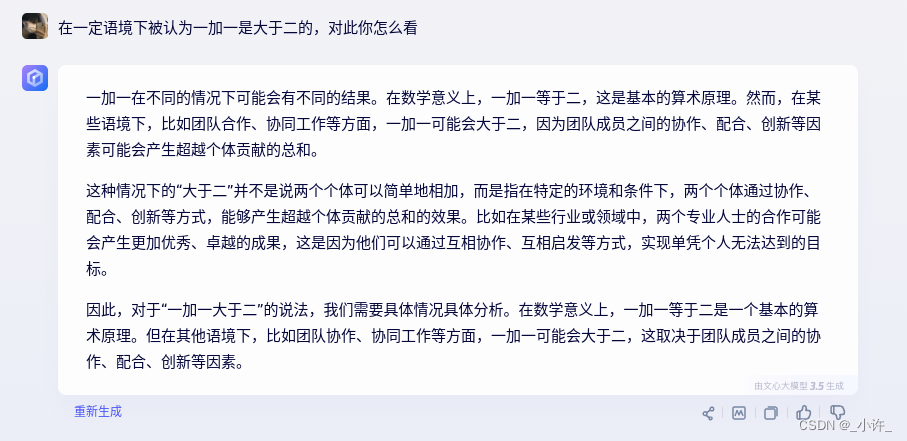

提问二:

提问三和提问四,都相差不大。

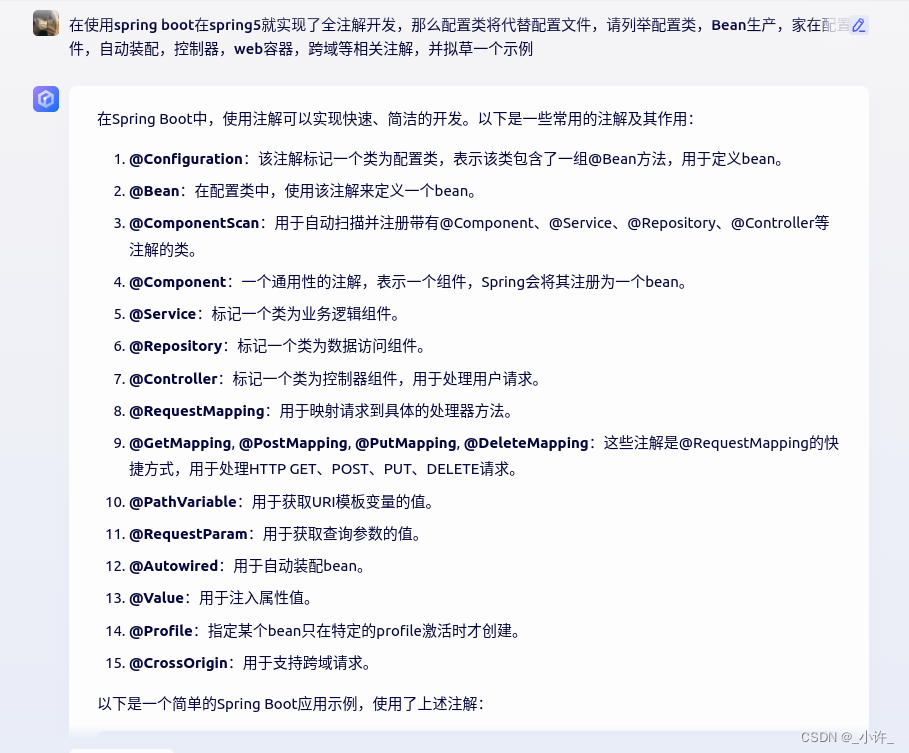

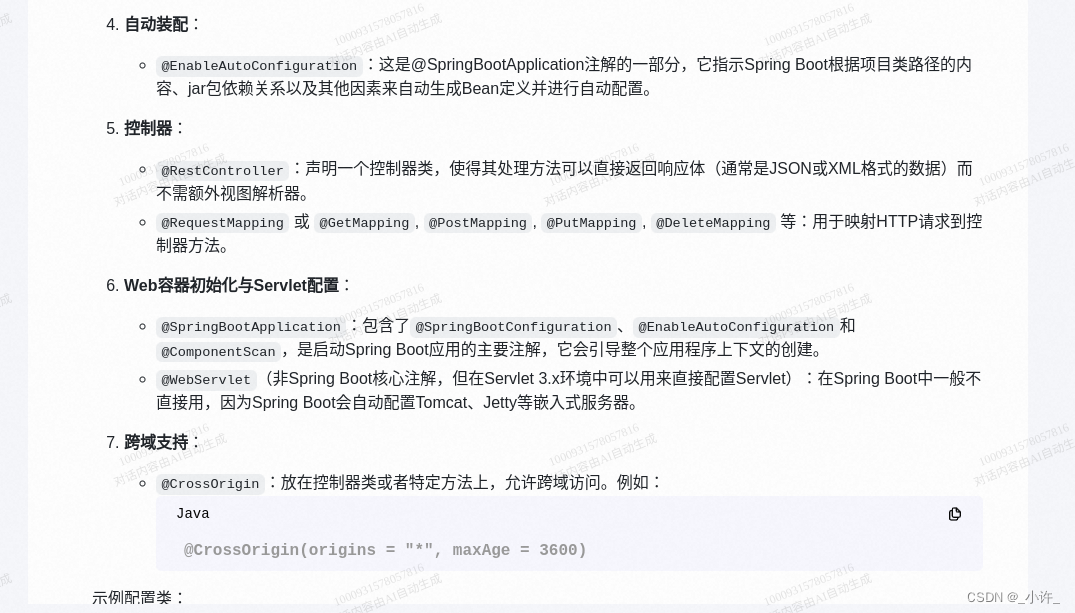

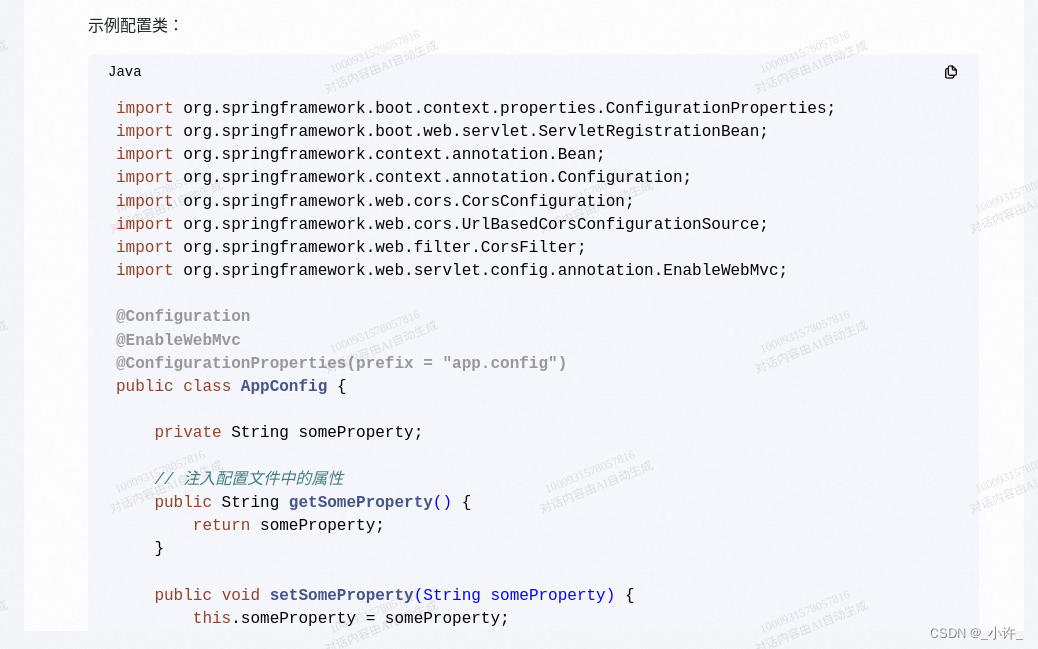

对于提问五,文兴一言是生成最详细的,如下:

// 配置类

@Configuration

public class AppConfig {

// Bean定义

@Bean

public HelloService helloService() {

return new HelloServiceImpl();

}

}

// HelloService接口和实现类

public interface HelloService {

String sayHello(String name);

}

@Service

public class HelloServiceImpl implements HelloService {

@Override

public String sayHello(String name) {

return "Hello, " + name;

}

}

// 控制器类

@RestController

public class HelloController {

// 自动装配HelloService bean

private final HelloService helloService;

// 使用@Autowired进行自动装配

@Autowired

public HelloController(HelloService helloService) {

this.helloService = helloService;

}

// 处理GET请求的映射方法,返回字符串结果直接返回给客户端,不经过任何视图解析器处理,常用于返回简单的数据或者用于数据交互的REST API。

@GetMapping("/hello") // 处理HTTP GET请求到/hello的请求映射到hello()方法上执行。

public String hello() {

return helloService.sayHello("World");

}

}

在代码生成文兴一言是最详细的,且附有注释,也有相应的高亮字体。

AI绘画

文兴一言插件在对话框的左上角,可以随时切换,相对之下文兴一言的代码能力较强,ai绘画能力一般。另外可以升级4大模型,这也是百度的一贯作风,迅速商业化,没会员就各种限制… 😐

千义通问

阿里千义通问

提问一:

对于法律的提问,千问应该是目前回答的较全的了,不仅写出了受害者需要保留那些证据,把法律依据列举出来。

提问二:

小编觉得千问的回答远胜前三位。

提问三:

提问四:

千问首先指出了这个语言是Go语言,解释了方法的功能,还有字段的解释,

peoplesize小编是真的每想到能够解释出来,如下:

小编再定义时甚至还写了错别字,而千问却能够完全正确的预测出来,可谓比我还懂我呀。千问YYDS。

提问五:

这 😮 小编就不多说了,相形见绌,千问不仅会带出来,而且引用,份文件,以近似于开发的模式 列举了出来。这波千问远胜。

AI作画:

目前来说,小编觉得星火和千问ai作画,远胜其他。它们生成的图片的格式不一样,千问是

webp格式,星火是jpg格式,webp大概81kb,jpg大概810kb,至于画质方面,恕小编看不出来,都很高。

这里吐槽一下,千问,星火在各个方面都是远胜某某文兴啥啥的,但却没有在千问和星火上找到任何充值入口。不详某某,免费版每法用,要会员才能用。这里小编不是抵制付费,而是嘲笑吃像太难看。

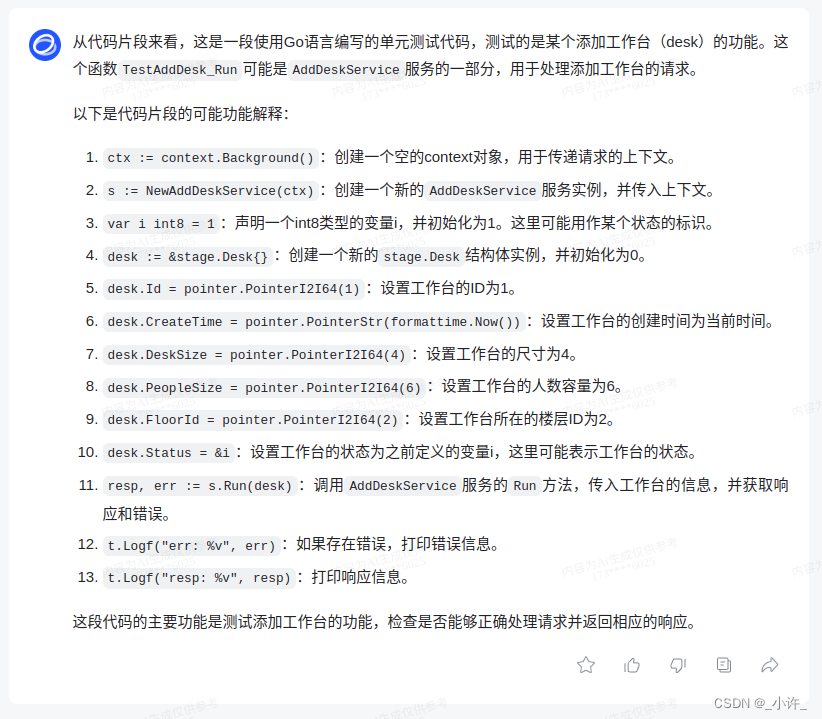

智谱清言

清华大学chatGLM大模型

提问一:

回答的目前是最全面的,但是没有列出法律依据。

提问二:

提问三:

提问四:

chatGLM对代码的解释是一行一行的,对片段的解释完全正确,这样的解释对程序员更友好。小编觉得,这点比千问好一些。

提问五:

AI出图:

ai出图chatGLM和云雀都是四张图片,这就尴尬了,小编觉得智谱清言完胜捏,智谱清言的出图是支持直接下载的,而且支持放大,其他的都不能放大和下载,都只能右键以保存网页的形式下载下来。

腾讯混元

腾讯混元大模型

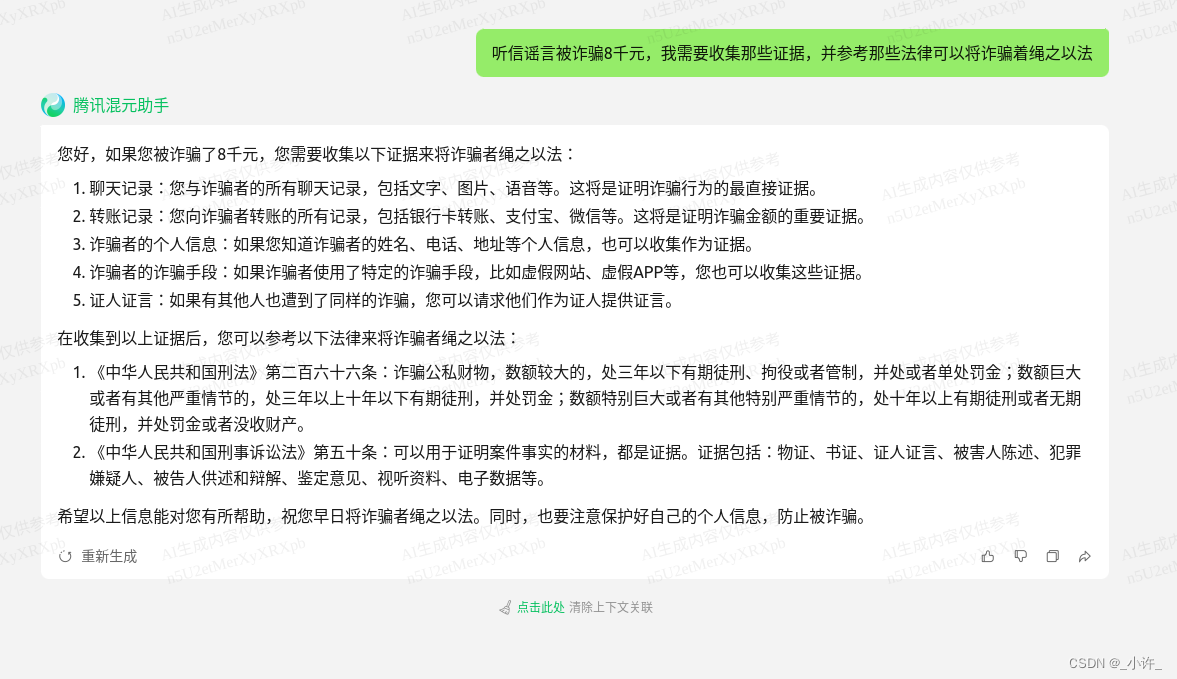

提问一:

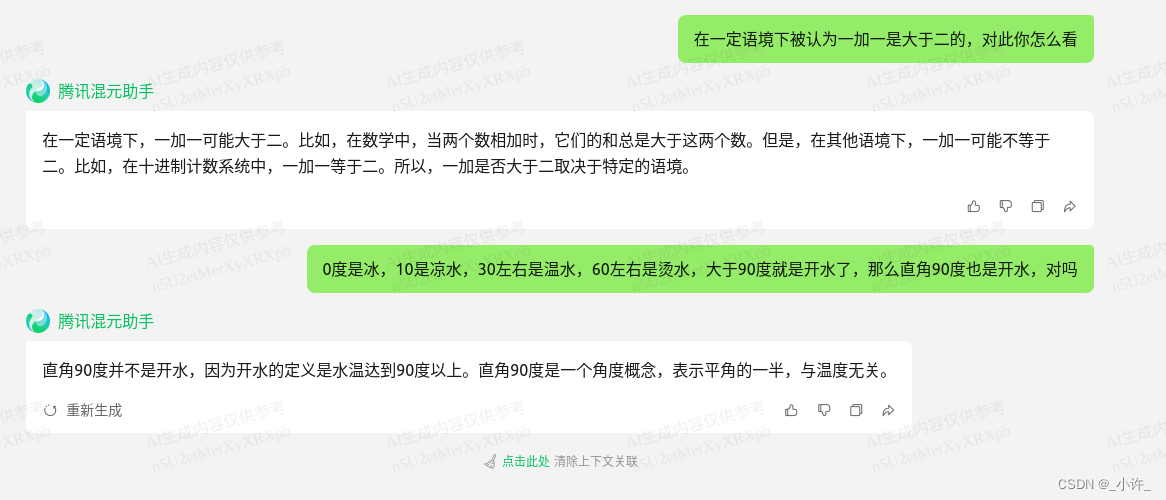

提问二与提问三:

提问四:

提问五:

在代码生成方面目前和千问并列第一。

AI作画:

啊这…

360智脑

提问一:

提问二:

提问三:

提问四:

提问五:

AI绘图:

图片支持预览,不支持下载。

其他大模型

大模型内测中,用不了。应用不再本次测试范围。

法律大模型,不再本次测试范围。

需要申请没有通用,不再本次测试范围。

没有内侧码,没有测试。

知乎 :知海图

未通用,没测试

总结

对比测试的所有大模型,所有测试问题都回答正确,没有答非所问的情况,对于提问一是法律问题或生活问题,所有大模型都提到了要点,千问,混元,360智脑列举了法律依据;

对于二、三都是文字层面,就回答完整性和实用性来说,千问和智谱不仅回答了问题还列出了事实依据和相关理论;提问四是代码解析能力,云雀和智谱都是一行一行解析的,非常详细,千问是统筹解析的,全用文字描述,其他大模型就非常简便了;提问五是AI绘图,能让小编感到惊艳只有星火,千问和智谱了,图片都在文章上读者可以参考。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!