MOE介绍 混合专家模型

发布时间:2024年01月13日

GShard

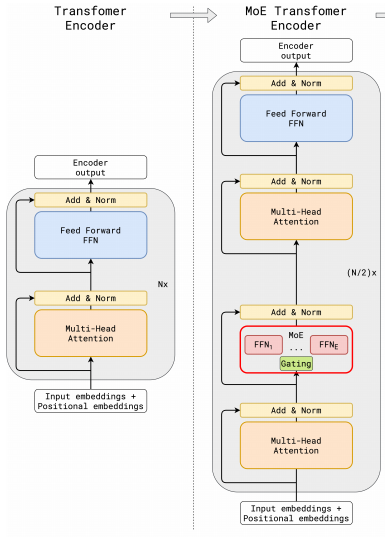

模型架构图:

参考GShard论文笔记(1)-MoE结构可知,MOE具备以下几种特点:

- 改造了原本的FFN层,变成Gate+n个FFN层。

- n个FFN层的训练数据集不同。

- 推理时会计算token与每个FFN的匹配程度,并k个被最匹配的FFN的输出对作加权平均。

https://github.com/laekov/fastmoe

另外:

- Gate只是一个维度是[dim, num_experts]的二维矩阵,用来计算每个token与每个expert的相关性。

- 每个FFN的结构相同。比如可以是[in_dim, hidden_dim, in_dim]形式的两层FFN。

也推荐阅读DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models的"2. Preliminaries: Mixture-of-Experts for Transformers"部分,该论文对MOE的讲解也很清晰。

文章来源:https://blog.csdn.net/duoyasong5907/article/details/135569777

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- @PathVariable——获取请求参数之获取路径参数

- 操作系统 第五章 存储器管理

- 【操作系统】同步和互斥详细讲解(算法+源码)

- LT7911D是TYPE-C/DP或者EDP转2 PORT MIPI和LVDS加音频

- js正则校验密码的一些正则

- 软件测试和软件开发之间的关系及模型

- test-02-test case generate 测试用例生成 EvoSuite 介绍

- 上门按摩系统:科技与传统融合的新体验

- 关联规则分析和相关系数

- 标准库--容器