使用主动检索增强生成FLARE来实现更好的RAG

文章链接:https://arxiv.org/abs/2305.06983

项目代码:https://github.com/jzbjyb/FLARE

原文地址:Better RAG with Active Retrieval Augmented Generation FLARE

2023 年 11 月 18 日?

欢迎深入探讨前瞻性主动检索增强生成 (FLARE),这是一种提高大语言模型 (LLM) 准确性和可靠性的创新方法。我们将探讨 FLARE 如何应对LLMs中的幻觉挑战,特别是在复杂的长篇内容生成任务中。

LLMs中的幻觉是指生成不正确或毫无根据的内容。这个问题在涉及大量输出的任务中变得更加明显,例如长篇问答、开放域摘要和思维链推理。FLARE 旨在通过在生成过程中集成外部经过验证的信息来减少这些不准确性。

什么是 FLARE

FLARE 是前瞻性主动检索增强生成(Forward-Looking Active Retrieval Augmented Generation)的缩写。这是一种补充 LLM 的方法,在模型生成内容的过程中主动纳入外部信息。这一过程大大降低了产生幻觉的风险,确保内容不断得到外部数据的检查和支持。

传统的检索-增强生成?在传统的检索-增强生成模型中,通常的方法是在生成过程开始时执行一次检索。该方法涉及使用初始查询,例如“总结 Narendra Modi 的维基百科页面”,并根据此查询检索相关文档。然后,模型使用这些文档来生成内容。然而,这种方法有其局限性,特别是在处理长篇和复杂的文本时。

传统方法的局限性

- 单一检索:一旦检索到初始文档,模型就会继续仅根据这组初始信息生成内容。

- 缺乏动态性:随着生成的进行,模型不会更新或检索新信息,以适应正在生成的内容的演变上下文。

- 过时或不完整信息的可能性:如果随着文本的生成,新信息变得相关,模型可能无法捕捉到这些信息,因为它依赖于最初检索到的文档。

- 多次检索:利用过去的上下文在固定的间隔内检索附加信息,即每 10 个单词或 1 个句子。它们将在固定的间隔内检索,无论你是否想要检索。?

FLARE 方法

多次检索:FLARE不使用固定的检索,而是在不同的间隔内进行多次检索,它知道何时进行检索以及应该检索什么。

何时检索:当 LLM 缺乏所需的知识时, LLM 生成的概率较低的标记。

检索什么:将考虑LLM未来打算生成的内容。

了解 FLARE 的迭代生成过程:

FLARE的操作方式是通过迭代生成临时的下一句,将其用作查询以检索相关文档,如果这些文档包含概率较低的标记,就会重新生成下一句,直到达到整体生成的结束。

FLARE 有两种类型:FLARE instruct 和 FLARE Direct。

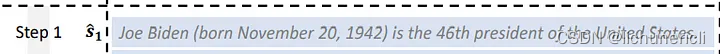

FLARE instruct:这种模式提示模型生成用于信息检索的具体查询。模型暂停生成,检索必要的数据,然后恢复,整合新的信息。我们在下图中来理解这一点。

试想一下,AI 模型的任务是根据用户的输入查询,生成一份关于 Joe Biden 的摘要。流程如下:

- 用户查询:任务以用户的请求开始:"生成一份关于 Joe Biden 的摘要"。

- 初始句生成:模型开始构建内容,生成开头语,如 "Joe Biden attended."

- 集中搜索启动:此时,模型会激活一个搜索查询,例如"[Search(Joe Biden University)]."

- 暂停和搜索:内容生成暂时停止。然后,模型深入搜索 "Joe Biden University."。

- 检索与整合:接下来,模型与检索器通信,检索有关 "Joe Biden University." 的相关数据。它有效地检索并整合了诸如 "the University of Pennsylvania, where he earned." 的信息。

- 继续搜索和更新:搜索过程并未在此停止。模型再次启动搜索,这次使用 "[Search(Joe Biden degree)]." 按照相同的协议,它将检索并整合新的数据,例如有关他的法学学位的信息。

这种生成和检索相结合的迭代过程确保 AI 模型能够生成信息充分、准确的摘要,并动态地纳入相关的最新信息。这就是 FLARE instruct 的工作原理。

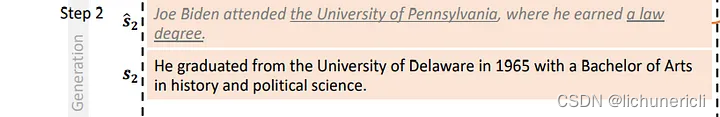

FLARE Direct:在这种情况下,模型在遇到置信度较低的标记时,会将生成的内容作为直接查询进行检索。让我们通过一个例子来深入探讨:

- 初始查询:我们开始一个语?言模型输入:"Generate a summary about Joe Biden."

- 模型生成响应。

- 如果生成的句子准确且置信度高,则被视为正确句子。

![]()

- 假设?模型生成了一个句子,但其中的 "the University of Pennsylvania" 和 "a law degree." 的置信度较低(元素高亮显示)。模型对这两句话的置信度很低。

现在有两种方法可以解决这个问题。

处理低置信度信息:为纠正或核实低置信度信息,FLARE Direct 采用了两种方法:

- 通过屏蔽进行隐含查询(橙色突出显示):这包括识别句子中的关键词或短语,如 "Joe Biden attended" 和 "where he earned." 然后,模型会在其数据库(vectorDB)中搜索这些关键词,以检索相关的准确信息。

- 问题生成明确查询(绿色高亮显示):在这里,会提示模型提出与输入查询相关的具体问题。示例可能包括 "What university did Joe Biden attend?" 和 "What degree did Joe Biden earn?" 然后利用这些问题从数据库中提取相关数据,确保信息的准确性和相关性。

通过采用这些方法,FLARE Direct 可以有效地完善和验证内容,提高所生成摘要的准确性和可靠性。为了建立这个链条,我们需要三样东西:

- 生成答案的 LLM

- 生成假设问题供检索使用的 LLM

- 用于查找答案的检索器

我们用来生成答案的 LLM 需要返回 logprobs,这样我们才能识别不确定的标记。因此,我们强烈建议您使用 OpenAI 封装器(注意:不是 ChatOpenAI 封装器,因为它不返回 logprobs)。我们用来生成假设问题以用于检索的 LLM 可以是任何东西。在本笔记本中,我们将使用 ChatOpenAI,因为它既快又便宜。让我们一起动手编码吧。

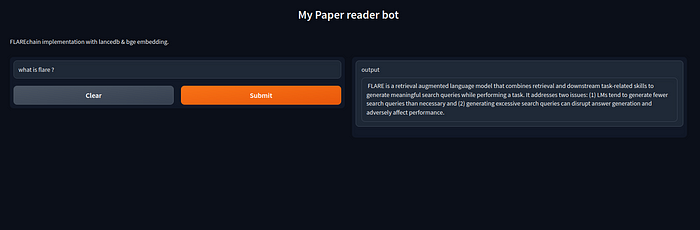

以下是 gradio 代码,您可以在本地系统上运行它。我们使用 arvixloader,因此您可以直接向论文提出问题。这里有一个?https://arxiv.org/pdf/2305.06983.pdf?的示例。您需要将此号码传给查询 2305.06983,然后您就可以根据论文提出任何问题。

需要了解的其他重要参数

- max_generation_len: 在停止检查是否有不确定标记之前生成标记的最大数量。

- min_prob:任何生成的标记概率低于此值,都将被视为不确定标记。

from langchain import PromptTemplate, LLMChain

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.chains import RetrievalQA

from langchain.embeddings import HuggingFaceBgeEmbeddings

from langchain.document_loaders import PyPDFLoader

from langchain.vectorstores import LanceDB

from langchain.document_loaders import ArxivLoader

from langchain.chains import FlareChain

from langchain.prompts import PromptTemplate

from langchain.chains import LLMChain

import os

import gradio as gr

import lancedb

from io import BytesIO

from langchain.llms import OpenAI

import getpass

# pass your api key

os.environ["OPENAI_API_KEY"] = "sk-yourapikeyforopenai"

llm = OpenAI()

os.environ["OPENAI_API_KEY"] = "sk-yourapikeyforopenai"

llm = OpenAI()

model_name = "BAAI/bge-large-en"

model_kwargs = {'device': 'cpu'}

encode_kwargs = {'normalize_embeddings': False}

embeddings = HuggingFaceBgeEmbeddings(

model_name=model_name,

model_kwargs=model_kwargs,

encode_kwargs=encode_kwargs

)

# here is example https://arxiv.org/pdf/2305.06983.pdf

# you need to pass this number to query 2305.06983

# fetch docs from arxiv, in this case it's the FLARE paper

docs = ArxivLoader(query="2305.06983", load_max_docs=2).load()

# instantiate text splitter

text_splitter = RecursiveCharacterTextSplitter(chunk_size=1500, chunk_overlap=150)

# split the document into chunks

doc_chunks = text_splitter.split_documents(docs)

# lancedb vectordb

db = lancedb.connect('/tmp/lancedb')

table = db.create_table("documentsai", data=[

{"vector": embeddings.embed_query("Hello World"), "text": "Hello World", "id": "1"}

], mode="overwrite")

vector_store = LanceDB.from_documents(doc_chunks, embeddings, connection=table)

vector_store_retriever = vector_store.as_retriever()

flare = FlareChain.from_llm(

llm=llm,

retriever=vector_store_retriever,

max_generation_len=300,

min_prob=0.45

)

# Define a function to generate FLARE output based on user input

def generate_flare_output(input_text):

output = flare.run(input_text)

return output

input = gr.Text(

label="Prompt",

show_label=False,

max_lines=1,

placeholder="Enter your prompt",

container=False,

)

iface = gr.Interface(fn=generate_flare_output,

inputs=input,

outputs="text",

title="My AI bot",

description="FLARE implementation with lancedb & bge embedding.",

allow_screenshot=False,

allow_flagging=False

)

iface.launch(debug=True)

概括

FLARE:前瞻性主动检索增强生成(FLARE)通过主动整合外部信息来减少内容生成过程中的幻觉,从而增强大型语言模型(LLM)。它超越了传统模型,具有动态、多重检索功能,能适应不断变化的语境。FLARE Instruct 和 FLARE Direct 展示了其生成更准确、更可靠内容的能力。博客还介绍了使用 LanceDB 和矢量数据库的实施要点和实际应用。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Nginx解析域名到指定端口

- 医疗行业的运维方案:解决IT监控、资产管理困难

- 安防视频监控EasyCVR平台HTTP-FMP4播放协议在分屏播放时的性能优化

- 将数据“0x0f“写入AT24C02再读出送P1口显示

- 笔记本安装Centos Stream9系统的详细安装教程-第二版

- Android ZXing二维码包含中文时乱码解决

- 云仓酒庄的品牌雷盛红酒LEESON分享香槟为什么是“酸”的?

- 亚马逊云国际站代理商:申请亚马逊云服务器域名

- 图片懒加载和预加载

- 2024.1.10力扣每日一题——删除子串后的字符串最小长度