翻译: 负责任的人工智能 Responsible AI

负责任的人工智能指的是以道德、值得信赖和社会负责任的方式开发和使用人工智能。许多开发者、企业和政府都关心这一点,并且一直在进行对话,也在努力确保人工智能的构建和使用是负责任的。由于对负责任的人工智能的所有这些关注和努力,我们在过去几年实际上取得了相当大的进展,例如,许多政府和公司发布了负责任人工智能的框架。但仍有许多工作要做。让我们看看负责任的人工智能意味着什么。虽然我们仍在弄清楚如何构建负责任的人工智能的许多细节,但一些共同主题已经浮现出来。

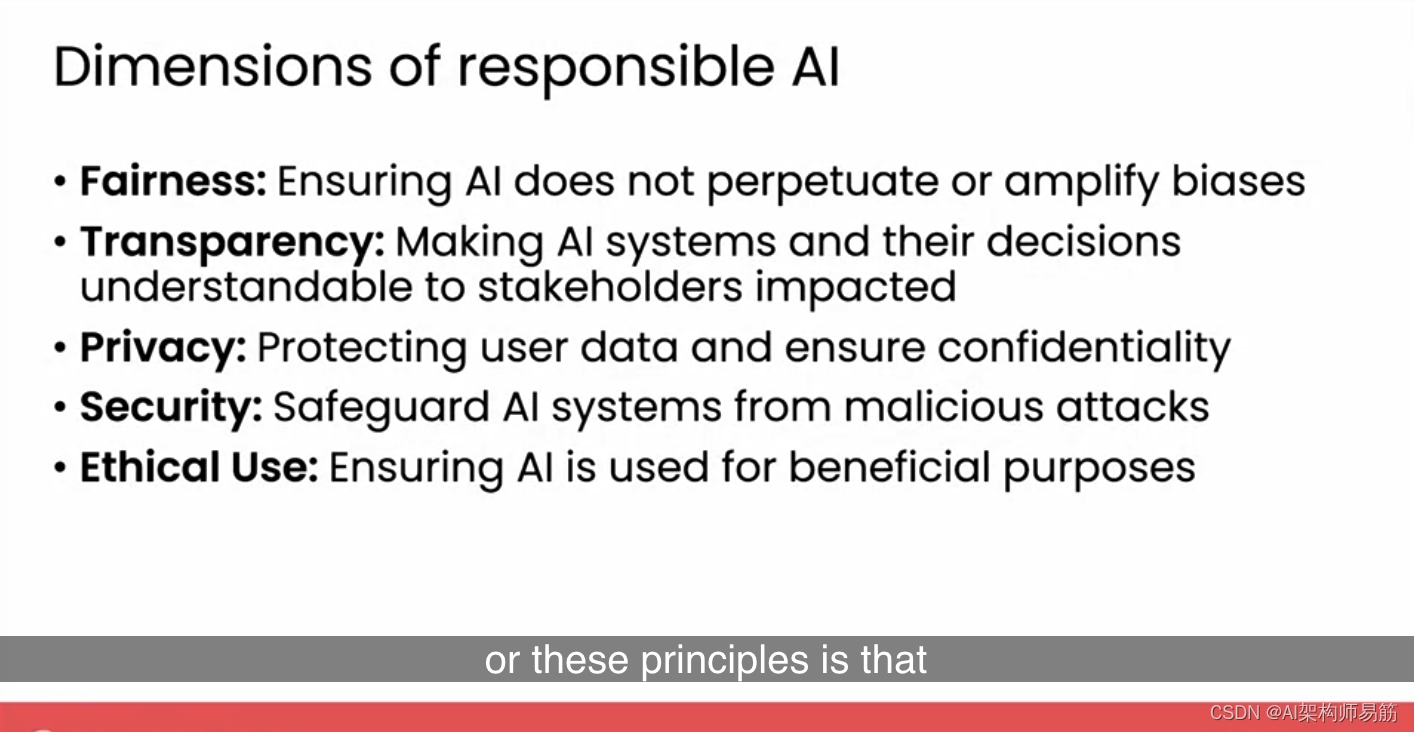

我认为这些是实施负责任人工智能的关键维度。

- 首先是公平性,确保人工智能不会延续或放大偏见。

- 透明度,确保人工智能系统及其决策对利益相关者、受影响的人来说是可以理解的。

- 隐私,保护用户数据,确保保密性。

- 安全性,保护人工智能系统免受恶意攻击,

- 最后是伦理使用,确保人工智能用于有益的目的。

这些维度或原则的挑战之一是,实施并不总是直截了当的。例如,我想至少两千年来,人类一直在辩论什么是道德的,什么是不道德的。不幸的是,没有关于伦理与非伦理行为的清晰的数学定义。尽管当然也有许多明确的案例。但这就是为什么个人、组织甚至国家要采用负责任的人工智能,出现了一些新的最佳实践,希望有讨论和辩论,即使有时正确的事情要做可能是模棱两可的,也能带来更好、更负责任的决定。

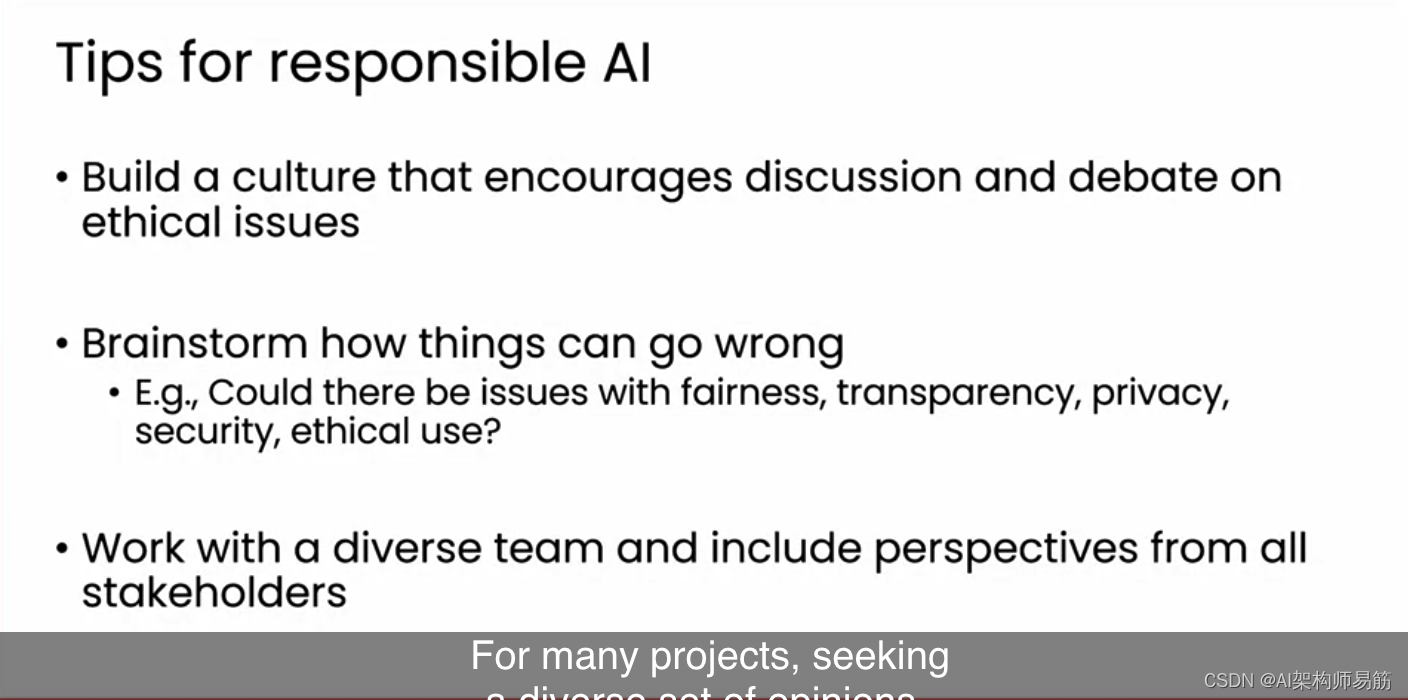

我想分享一些提示。

- 首先,我认为鼓励就伦理问题进行讨论和辩论的文化很重要。如果您的团队中有人对负责任的人工智能使用有担忧,如果他们有自由提出这个问题以使团队能够做出更好的决定,那就太好了。

- 第二个建议是自己或与团队,或与更广泛的利益相关者群体一起头脑风暴可能出错的情况。我发现在许多项目中,这种头脑风暴可以帮助识别潜在问题,并允许团队提前减轻它们。头脑风暴的清单可以是我在上一张幻灯片中描述的五个维度。

人工智能系统是否可能存在公平性、透明度、隐私、安全性或伦理使用方面的问题。

3. 例如,在我参与的一些项目中,我的团队提前头脑风暴了我们部署的人工智能是否可能存在公平性问题,例如它是否可能表现出您在本课程中早些时候看到的一些偏见。

4. 最后,我鼓励您与多样化的团队合作,并包括所有受人工智能系统影响的利益相关者的观点。

对于许多项目来说,寻求多样化的意见,以及与可能与我自己截然不同的人交谈,使我的团队能够更好地了解人工智能系统的影响,并促使我们做出更好的决定。

5. 例如,在医疗系统建设中,我发现与患者和医生交谈提供了与我不同的观点,并真正改变了我们项目的方向;

6. 在零售应用中,与一些客户以及卖家交谈,给了我的团队我们本来不会有的新想法。

我认为这种模式适用于许多项目。如果您在特定行业工作,例如医疗、金融、媒体或技术行业,也许有一些针对您行业的负责任人工智能的新兴最佳实践,您在开始项目时也可以咨询这些。我认为我们都希望使用人工智能让人们过得更好。

有几次我因伦理原因终止了在财务上看似可行的项目。在您决定从事什么工作和不从事什么工作时,我希望您继续考虑负责任的人工智能,只从事您认为是道德的并且能让人们过得更好的项目。

现在,我们即将结束这门课程。让我们到下一个视频中看看我们所涵盖的内容的总结。

参考

https://www.coursera.org/learn/generative-ai-for-everyone/lecture/uKeoC/responsible-ai

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Springcloud 微服务实战笔记 Zuul

- MFC用代码加载一张bmp图片到picture control并适应到控件大小 解决OnInitDialog中调用不显示

- 晚上空闲时间多,又不想荒废,那就来做点副业吧

- 加法放大器电路、计算公式、原理及应用

- Docker常用管理命令

- 【漏洞复现】企望制造ERP系统 RCE漏洞

- Electron自定义通知Notification

- Java框架基础--maven,http,postman

- 小型洗衣机怎么用?高质量的小型洗衣机推荐

- 代码随想录算法训练营29期Day29|LeetCode 491,46,47