LLM Agent-指令微调方案

上一章我们介绍了基于Prompt范式的工具调用方案,这一章介绍基于模型微调,支持任意多工具组合调用,复杂调用的方案。多工具调用核心需要解决3个问题,在哪个位置进行工具调用(where), 从众多工具中选择哪一个(Which), 工具的输入是什么(What)。Where + Which + What,我称之为3W原则,3H它兄弟哈哈哈哈~

其实如何教大模型使用工具,和教人类使用工具没啥区别。就像上周末我想给我妈买的可以防弹,超重的岩板餐桌按个滑轮需要使用电钻,那我学习使用电钻的途径无非有三种

-

基于历史经验:我之前都是手动的没用过电动的,我凭借自信直接上手结果拧歪了......对应到LLM其实就是本章要提到的工具微调,我们让模型先学习在在不同的场景使用什么工具,如何使用,再利用大模型的迁移泛化能力泛化到更多的场景。

-

从工具说明书中学习:我去翻了翻说明书,奈何写的太抽象没看懂......对应到LLM简单版的就是上一章的zero-shot prompt方案,告诉大模型工具的使用场景和用法;升级版就是之后会提到的优化方案,我们可以动态召回工具的完整说明书和使用范例作为上文输入模型

-

通过观察他人使用工具来学习:最终我打开小红书看短视频学习了下,一点就通,于是我拥有了可丝滑移动的防弹餐桌!对应到LLM简单版就是上一章介绍的few-shot prompt方案,我们让LLM看到在其他场景它是如何使用工具的;升级版就是之后会提到的动态few-shot prompt的方案。

下面我们看下通过微调为模型注入工具使用经验的两个方案:Toolformer和Gorilla

Toolformer

TALM: Tool Augmented Language Models

Toolformer: Language Models Can Teach Themselves to Use Tools

填充式工具使用 + InContext制造自监督样本

Toolformer是工具调用领域的前辈,使用LM监督微调得到可以进行Inline工具调用的模型。解码时,模型会在恰当的位置生成API调用的请求,并中止解码,去调用API得到返回值,把返回值拼接到"->"字符之后,再继续模型解码,如下

Toolformer的创新主要在API调用的样本构造,因此我们先来看下样本构造的部分

样本

Toolformer单一API的样本构造主要包含以下3个步骤

-

Sampling API

以QA API为例,作者会先编写几个样本作为In-Context,得到以下的FewShot指令样本

然后针对新的长度为N的输入文本,作者会计算每个位置得到<API>前缀的条件解码概率,并保留超过阈值的TopK个最优可能出现<API>的位置。然后每个位置,基于上文,让模型随机解码m次生成m个候选的API调用请求。这样我们就得到了候选样本集,每一段文本,最多有K个可能进行工具调用的位置,且每个位置有至多m个候选请求{c1,...cm}。

-

Executing API Calls

执行以上得到的候选请求,每个请求得到一个对应的返回值{r1,....rm}。 可以是计算器的结果,维基百科的搜索返回等等

-

Filtering API Calls

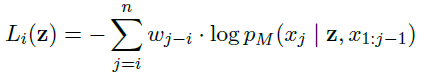

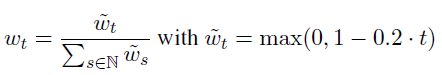

最后是过滤筛选,原理是好的工具调用样本,应该会让工具调用位置后面的文本解码概率提高,Perplexity降低。因此作者计算了在工具调用位置之后,所有token的加权条件解码概率。

以上加权的权重计算如下,离工具调用位置越远权重越小

条件解码概率的条件Z,分别是[工具调用+返回值],[工具调用+无返回值],[无工具调用],这三者中Loss较小的一个,过滤方案是[工具调用+工具返回值]的Loss降幅超过阈值,则保留该样本

整体量级上,1个API生成了25K左右的样本用于微调,样本长度1024

微调

使用以上样本生成方案得到多API调用的样本集混合后得到增强训练样本。样本的构建方式是在原始文本中直接插入API调用的语句x1:i?1,e(ci,ri),xi:n�1:�?1,�(��,��),��:�,如下

The Nile has an approximate length of QA(What is the approximate length of the Nile?)->6,853 km 6,853 kilometers, the White Nile being its main source

这样通过微调,模型会学习到在什么位置使用什么样的工具,以及工具的请求输入。同时和解码的格式保持一致,后文会依赖API调用结果进行解码。微调使用了GPT-J模型,Batch=128, lr=1e-5,warmup=10%,训练了2K step,常规的LM Loss.

总结

Toolformer的创新主要在使用模型的Few-shot理解能力,使用少量的人工标注样本制造大量的自监督样本。这样Tooformer理论上可以支持任意的API工具。但Toolformer有一些局限性

-

工具独立:论文中每个API调用的样本是独立构造的,工具之间没有交互,且同一工具的多次调用之间也是独立,不依赖上文的调用返回。

-

常规解码:没有引入思维链推理,限制了最终效果

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 元道经纬相机信息化赋能光伏电站运维管理

- 防蓝光护眼台灯哪个牌子好?2024护眼灯315合格产品

- Java:Stream流

- 阿里云国外服务器价格表

- 实现第一个JDBC程序

- Java动态代理机制,创建代理对象的方法(InvocationHandler,Proxy)

- C#,字符串匹配(模式搜索)有限自动机(Finite Automata)算法的源代码

- Kubernetes快速实战与核心原理剖析

- QT开发 2024最新版本优雅的使用vscode开发QT

- MySQL查询命令练习(一)