学习openAI 短长期AGI计划、使命、宪章、开创性研究、产品、工作待遇等

网站的设计:简洁而现代

主页

使命:Creating safe AGI that benefits all of humanity.

(比人类更聪明的人工智能系统)(自己实现或帮别人实现都认为是达成使命)(造福全人类:最大限度地提高人工智能技术的社会和经济效益)

宪章

1、广泛分布的福利(造福每个人)

2、长期安全(后期的AGI开发会成为一场竞争激烈的竞赛,而没有时间采取足够的安全预防措施)

3、技术领先(技术必须处于 AI 能力的最前沿,领导作用)

4、合作导向(全球社区,共同应对AGI的全球挑战)

AGI 计划

AGI 不可能或永远停止其发展;相反,社会和AGI的开发者必须弄清楚如何把它做好。

1、最大化好的一面,最小化坏的一面,让AGI成为人性的放大器。

2、部署功能较弱的技术版本来不断学习和适应(限制版)。

3、之所以后来闭源是因为“要先弄清楚如何安全地共享对系统的访问和好处”。

短期

1、逐步过渡到一个拥有AGI的世界总比突然过渡要好,社会和人工智能共同发展。

2、在创建和部署模型时变得越来越谨慎。

3、社会在如何使用人工智能的极其广泛的范围内达成一致

4、计划对外部输入进行实验

5、默认的部署版本有相当大的限制,但会赋予个人做出自己的决定的能力以及思想多样性的内在力量。

6、AI对齐研究提高人工智能系统从人类反馈中学习并协助人类评估人工智能的能力。(AI与人类价值观一致)

7、就三个关键问题进行全球对话:如何管理这些系统,如何公平分配它们产生的利益,以及如何公平地分享使用权。

8、协助其他组织提高安全性,而不是在后期 AGI 开发中与他们竞争。

9、为人类的利益而运作(并且可以凌驾于任何营利性利益之上)

10、在发布新系统之前接受独立审计,在开始训练未来的系统之前进行独立审查

11、我们试图设计我们的组织结构和制度,使我们每个成员的利益和目标都与我们想要达到的良好结果保持一致。换句话说,我们希望每个人都为共同的成功而努力,而不是为了个人的利益而损害整体。

**AI对齐研究(Alignment Research)**是指在人工智能发展过程中,确保AI系统的目标、决策与人类价值观和目标一致的研究领域。这个领域的关键目标是防止AI系统采取对人类有害的行动,即使这些行动是为了实现它们被编程要实现的目标。

例如,一个简单的AI系统可能被设定任务为最大化生产某种产品。如果没有适当的对齐,这个系统可能会忽略环境保护、资源节约或人类福祉等因素,只专注于任务本身,从而导致负面后果。

AI对齐研究的挑战在于如何确保AI系统在学习和决策过程中,能够理解并遵循人类的道德和价值观。这需要跨领域的合作,包括技术、哲学、伦理学等领域的知识。

长期

1、想象一个人类繁荣到我们任何人都无法完全想象的程度的世界

2、在路上改进。

研究:关于AGI之路的开创性研究

1、目前的人工智能研究建立在以前的大量项目和进展之上。

2、20*166页 太多了。

产品:利用 AI 改变工作和创造力

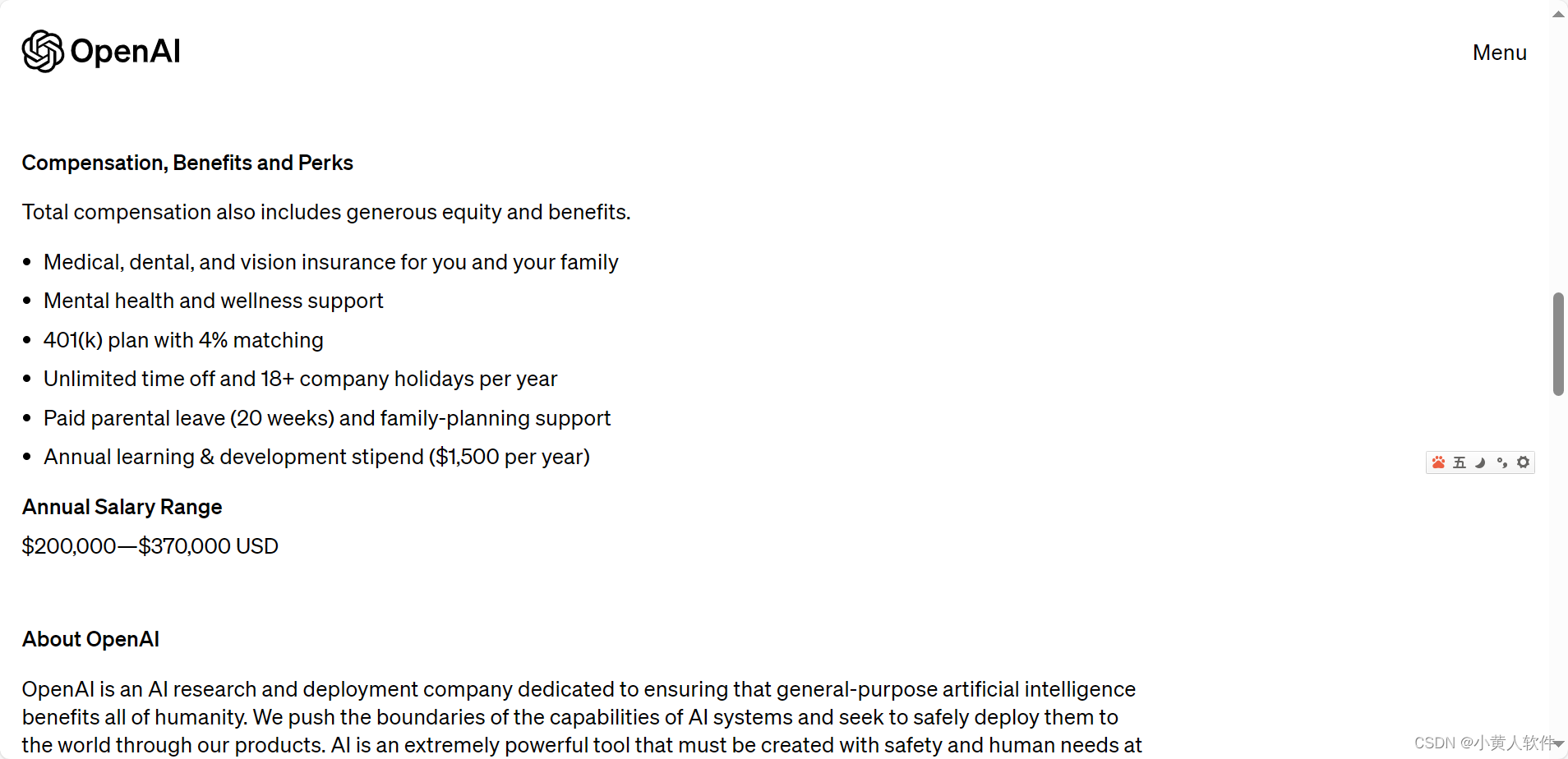

工作机会:开发安全有益的人工智能需要来自不同学科和背景的人才。

Workplace MAC Specialist:薪酬为 45.67 美元/小时,每周 40 小时。将提供福利,包括健康保险和休假。

VC Partnerships Manager:年薪范围235,000 美元—285,000 美元

Research Scientist:年薪范围200,000 美元—370,000 美元

最新更新:重大事件。

安全与责任:了解潜在的风险和收益,并仔细考虑其影响。

具体产品研究:生成模型以及如何使它们与人类价值观保持一致。

产品:更详细

又是招聘:不断学习。不同主题或领域的想法通常可以激发新的想法并拓宽潜在的解决方案空间。

网站地图:展开的。

菜单:折叠的网站地图。

结构:由非营利组织管理,上限利润模式推动了我们对安全的承诺(随着人工智能变得越来越强大,可以重新分配工作利润,以最大限度地提高人工智能技术的社会和经济效益)。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 使用PE信息查看工具和Dependency Walker工具排查因为库版本不对导致程序启动报错问题

- 如何使用网络测试仪构造特殊流量

- 灵活扩展:深入理解MyBatis插件机制

- 找城市(100%用例)C卷 (Java&&Python&&C++&&Node.js&&swift)

- Python多项式回归sklearn

- 系统安全的加固

- 网易数帆CodeWave低代码开发平台强势来袭

- Python实验项目9 :网络爬虫与自动化

- 内核线程创建-kthread_create

- Vue组件间通信(六种方式)