【Hadoop】执行start-dfs.sh启动hadoop集群时,datenode没有启动怎么办

发布时间:2023年12月18日

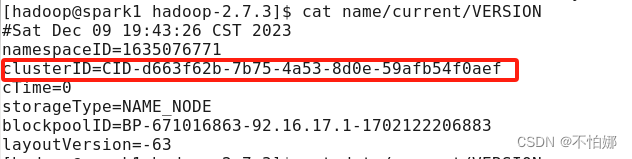

执行start-dfs.sh后,datenode没有启动,很大一部分原因是因为在第一次格式化dfs后又重新执行了格式化命令(hdfs namenode -format),这时主节点namenode的clusterID会重新生成,而从节点datanode的clusterID 保持不变。

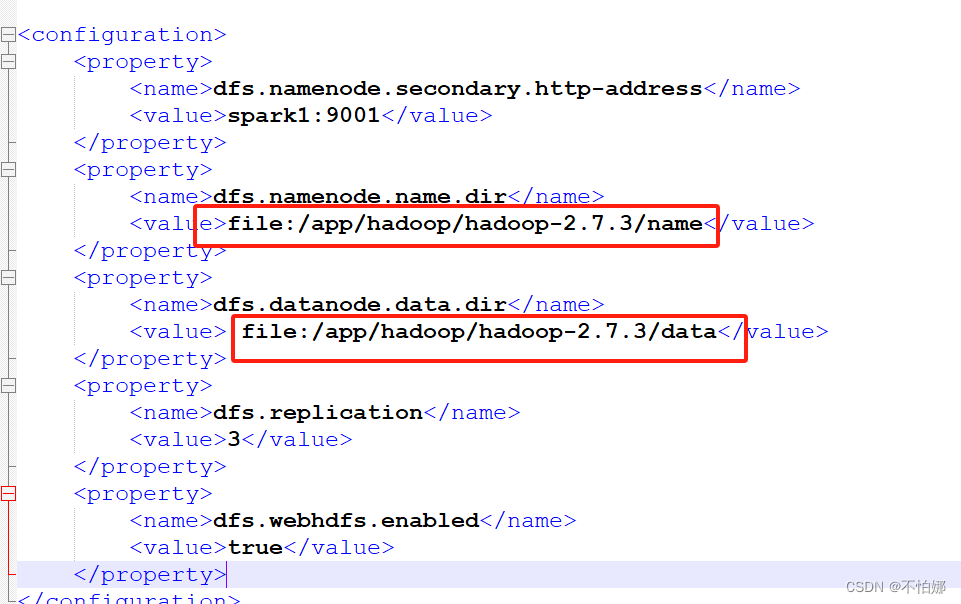

在主节点也就是namenode那个节点上的hdfs-site.xml文件下找到这两个文件路径

打开name目录中current下面的VERSION文件,然后用这个clusterID替换掉datanode节点上的data/current/VERSION里的clusterID

文章来源:https://blog.csdn.net/m0_60511809/article/details/134899966

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 企业微信开发:本地运行一个页面应用

- c 语言学习:输出阶乘的算式

- 解密神经网络:深入探究传播机制与学习过程

- 一、Mindspore 公开课 - Transformer

- B. Neutral Tonality 寒假思维训练计划day8

- 【C++】题解:三道只出现一次的数字问题

- 聊聊PowerJob的WorkerHealthReporter

- Docker入门

- 每日一题——LeetCode1154.一年中的第几天

- 速度与稳定性的完美结合:深入横测ToDesk、TeamViewer和AnyDesk