AI绘画中UNet用于预测噪声

介绍

在AI绘画领域中,UNet是一种常见的神经网络架构,广泛用于图像相关的任务,尤其是在图像分割领域中表现突出。UNet最初是为了解决医学图像分割问题而设计的,但其应用已经扩展到了多种图像处理任务。

特点

-

对称结构:UNet的结构呈现为“U”形,分为收缩路径(下采样)和扩展路径(上采样)两部分,因此得名UNet。这种结构有助于网络在保持上下文信息的同时捕获精细的细节。

-

跳跃连接(Skip Connections):UNet通过在下采样和上采样路径之间建立跳跃连接,能够在网络的深层保留高分辨率特征。这对于精确地定位和分割图像中的对象至关重要。

-

灵活性:尽管最初是为医学图像设计的,UNet的结构被证明对于各种图像分割任务都非常有效,包括但不限于卫星图像分析、地理信息系统(GIS)应用等。

架构

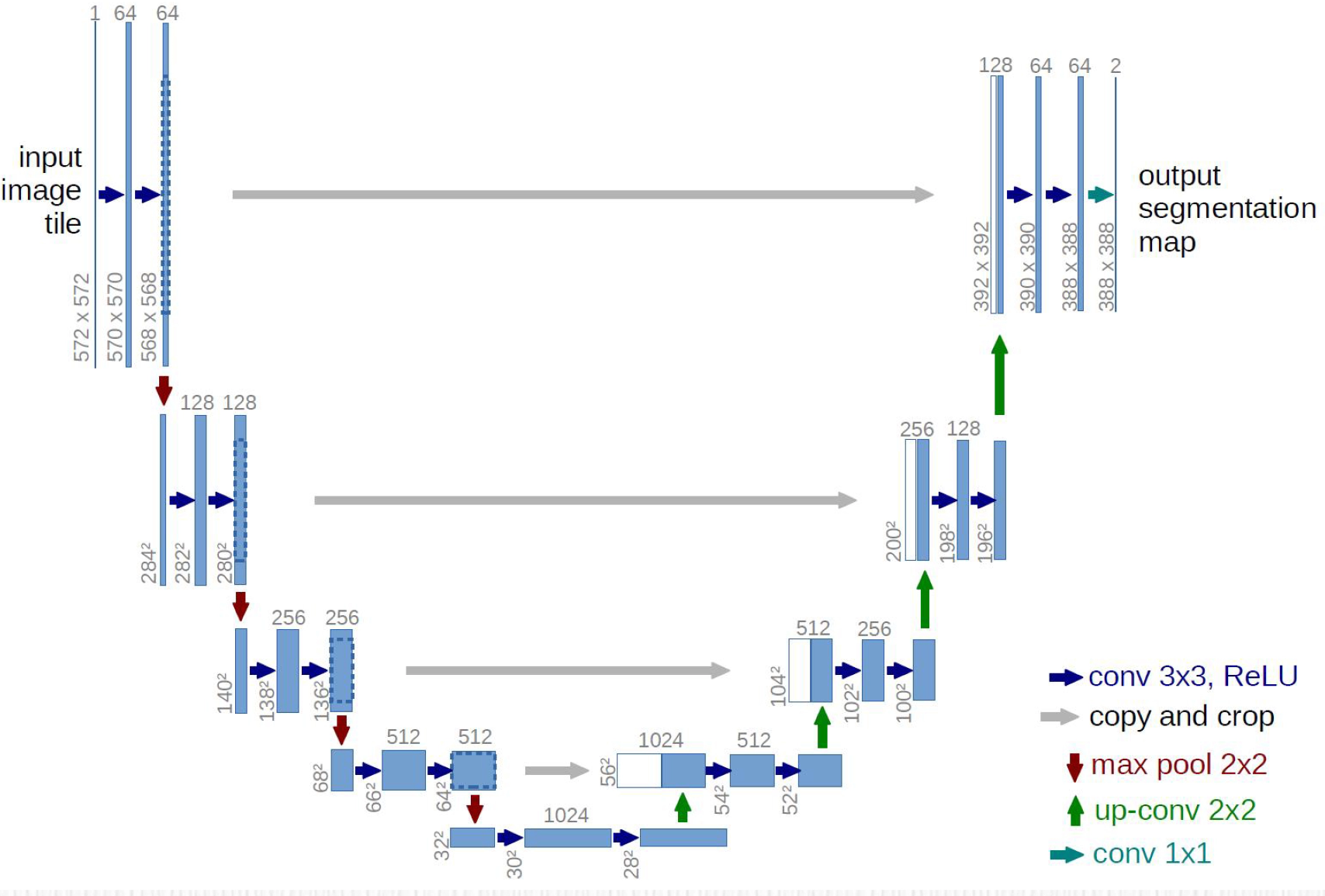

这张图片展示了UNet架构的典型布局。UNet由两部分组成:收缩路径(下采样)和扩展路径(上采样),中间通过跳跃连接相连。

-

收缩路径:由蓝色箭头表示,它通过连续的卷积层(conv 3x3)和ReLU激活函数处理输入图像,然后应用最大池化(max pool 2x2,红色箭头向下)来降低分辨率并增加特征图的深度。

-

扩展路径:由绿色箭头表示,它通过上采样卷积(up-conv 2x2)将特征图分辨率增加,并通过跳跃连接(灰色箭头),将收缩路径中相应尺寸的特征图与上采样后的特征图合并。合并后,再次应用卷积层(conv 3x3)和ReLU激活函数。

-

跳跃连接:它们是图中的灰色箭头,将收缩路径的特征图直接传输到扩展路径的相应层,这有助于在上采样时恢复图像的细节。

-

输出:最后,一个1x1的卷积层(conv 1x1,蓝色箭头指向输出)将深层特征图转换为所需的输出分割图(在这里是输出分割地图)。

整个UNet架构是一个对称结构,它允许网络在分割任务中同时学习图像的局部特征(通过下采样)和全局上下文(通过上采样和跳跃连接)。这种结构使得UNet在医学图像分割和其他需要精确定位的图像处理任务中非常有效。

数学公式

在数学层面上,UNet的操作可以通过卷积(Conv)和池化(Pool)运算来表达,但详细的数学表达会涉及到卷积运算的具体公式,激活函数的选择等,这些通常在具体的研究论文或技术文档中详细描述。

为了简化,可以认为每一步的操作是一个函数 ( f ),它接受一个输入 ( x ) 并产生一个输出 ( y ),如 ( y = f(x) )。在UNet中,这些函数会是卷积、激活、池化或上采样操作。

代码实现

import torch

import torch.nn as nn

import torch.nn.functional as F

class DoubleConv(nn.Module):

"""(卷积 => [BN] => ReLU) * 2"""

def __init__(self, in_channels, out_channels, mid_channels=None):

super().__init__()

if not mid_channels:

mid_channels = out_channels

self.double_conv = nn.Sequential(

nn.Conv2d(in_channels, mid_channels, kernel_size=3, padding=1),

nn.BatchNorm2d(mid_channels),

nn.ReLU(inplace=True),

nn.Conv2d(mid_channels, out_channels, kernel_size=3, padding=1),

nn.BatchNorm2d(out_channels),

nn.ReLU(inplace=True)

)

def forward(self, x):

return self.double_conv(x)

class UNet(nn.Module):

def __init__(self, n_channels, n_classes):

super(UNet, self).__init__()

self.n_channels = n_channels

self.n_classes = n_classes

# UNet的下采样部分

self.inc = DoubleConv(n_channels, 64)

self.down1 = DoubleConv(64, 128)

self.down2 = DoubleConv(128, 256)

self.down3 = DoubleConv(256, 512)

self.down4 = DoubleConv(512, 1024)

# UNet的上采样部分

self.up1 = nn.ConvTranspose2d(1024, 512, kernel_size=2, stride=2)

self.conv1 = DoubleConv(1024, 512)

self.up2 = nn.ConvTranspose2d(512, 256, kernel_size=2, stride=2)

self.conv2 = DoubleConv(512, 256)

self.up3 = nn.ConvTranspose2d(256, 128, kernel_size=2, stride=2)

self.conv3 = DoubleConv(256, 128)

self.up4 = nn.ConvTranspose2d(128, 64, kernel_size=2, stride=2)

self.conv4 = DoubleConv(128, 64)

# 最后一层卷积,将特征图转换为输出类别

self.outc = nn.Conv2d(64, n_classes, kernel_size=1)

def forward(self, x):

# 向前传播,按顺序应用下采样和上采样

x1 = self.inc(x)

x2 = self.down1(x1)

x3 = self.down2(x2)

x4 = self.down3(x3)

x5 = self.down4(x4)

x = self.up1(x5)

x = torch.cat([x, x4], dim=1)

x = self.conv1(x)

x = self.up2(x)

x = torch.cat([x, x3], dim=1)

x = self.conv2(x)

x = self.up3(x)

x = torch.cat([x, x2], dim=1)

x = self.conv3(x)

x = self.up4(x)

x = torch.cat([x, x1], dim=1)

x = self.conv4(x)

logits = self.outc(x)

return logits

# 实例化模型,输入通道数为1,输出类别数为2

model = UNet(n_channels=1, n_classes=2)

# 创建一个假的输入数据,其形状为(batch_size, channels, height, width)

input = torch.randn(1, 1, 572, 572)

# 得到模型输出

output = model(input)

print(output.shape) # 打印输出张量的形状

在这个实现中,我们定义了一个DoubleConv模块来执行两次卷积操作,每次卷积后都会执行批量归一化(BatchNorm)和ReLU激活函数。在UNet模型中,我们首先定义了下采样(编码器)和上采样(解码器)的步骤。在上采样步骤中,我们使用转置卷积进行特征图的扩大,并使用torch.cat函数来实现跳跃连接,将编码器的特征与解码器的特征结合起。

AI绘画中UNet 与扩散模型结合

UNet架构与扩散模型的结合是在人工智能绘画和图像生成领域的一个相对较新的研究方向。扩散模型,特别是深度学习中的生成扩散模型,已经被证明在生成高质量的图像方面表现出色。它们通过逐步添加噪声到数据中,然后学习如何逆转这个过程来生成数据。

结合UNet与扩散模型通常涉及以下步骤:

-

特征提取:使用UNet的下采样路径来提取输入图像的特征。这些特征捕获了图像的重要信息和上下文。

-

特征扩散:将这些特征传递给扩散模型,扩散模型将通过添加和学习逆转噪声的过程来扩散特征。

-

特征重建:使用UNet的上采样路径和跳跃连接来重建和细化特征,这一步骤通常会生成更加精细和清晰的图像。

-

图像生成:最后,使用1x1卷积或其他类型的映射来将重建的特征转换为最终的图像输出。

在这种结合中,UNet通常用于其强大的特征提取和重建能力,而扩散模型用于生成过程中的细节增强和变化模拟。这种结合可以用于创造性绘画、图像修复、风格迁移等任务,其中不仅需要精确的图像内容,还需要高质量的图像纹理和细节。这种方法的一个例子是将扩散模型用于生成纹理,然后通过UNet进行细化,以实现更高质量的图像输出。

UNet 应用

UNet架构最初是为医学图像分割而设计的,但由于其高效的特征学习和上下文整合能力,它已经被广泛应用于多种不同的图像处理任务。下面列出了一些UNet的主要应用领域:

-

医学图像分割:

- 细胞计数。

- 器官定位。

- 肿瘤检测。

- 病变分割。

-

卫星图像处理:

- 地物分类。

- 道路提取。

- 土地覆盖变化检测。

- 建筑物检测。

-

自然图像分割:

- 物体轮廓提取。

- 图像背景去除。

- 交互式图像编辑。

-

农业:

- 植物病害检测。

- 作物分析。

- 农田监测。

-

自动驾驶汽车:

- 道路和行人检测。

- 车辆周边环境的理解。

- 交通标志识别。

-

工业应用:

- 缺陷检测。

- 产品质量评估。

- 自动化检视系统。

-

视频处理:

- 运动分析。

- 物体追踪。

- 视频分割。

-

艺术创作:

- 风格迁移。

- 图像合成。

- 动漫角色生成。

UNet的这些应用通常依赖于其能力来理解图像中的复杂结构,并且能够在分割任务中保留重要的细节信息。它的成功部分归因于其独特的架构,该架构通过跳跃连接将低级别的细节特征与高级别的上下文特征相结合,从而在图像的不同分辨率级别上实现了准确的分割。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 云服务器十大服务商——云服务器哪家好用

- 超低温冰箱居然还能这样管理?这招也太炫酷了!

- 智慧灌溉解决方案(基于物联网的智能灌溉系统)

- iEnglish:人工智能激发学习兴趣,推动个性化学习

- 与供应商合作:成功供应商管理的六种最佳实践

- 软信天成:合理利用数据治理工具为企业带来的价值

- springcloudalibaba01

- 企业电子招投标系统源码之电子招投标系统建设的重点和未来趋势

- Windows下linux 子系统 WSL2怎样使用usb串口(USBIPD-win4.0.0)

- linux防护与集群——系统安全及应用