【DeepLearning-2】预归一化(Pre-Normalization)策略

发布时间:2024年01月24日

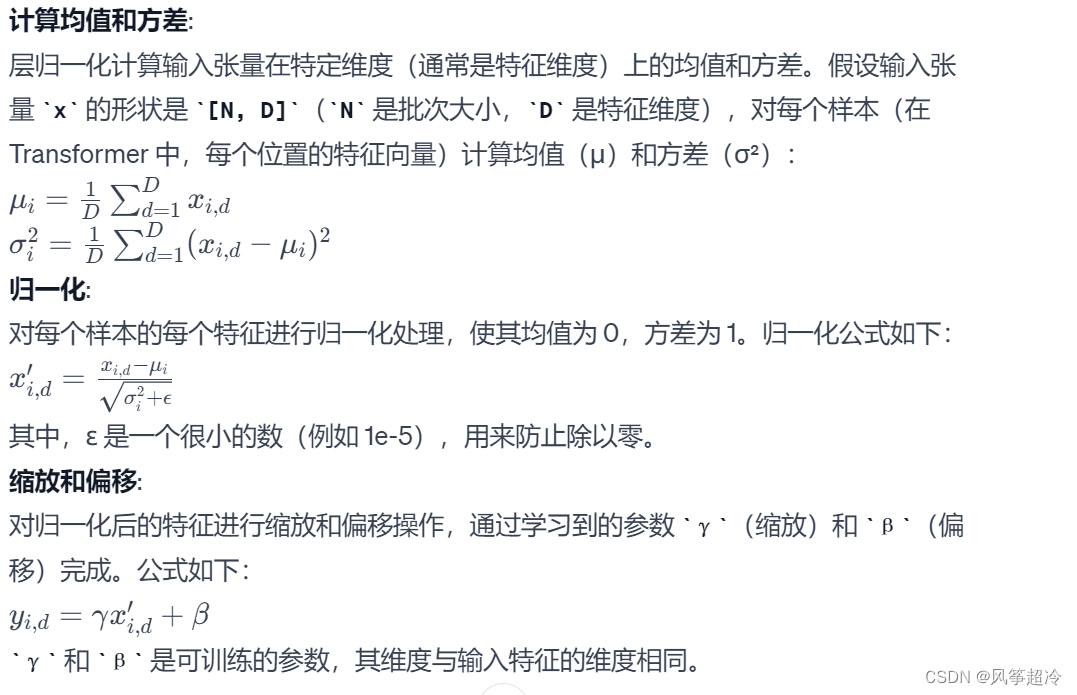

2.1层归一化(Layer Normalization)在 PreNorm 类中的数学原理:

2.2代码实现:?

class PreNorm(nn.Module):

def __init__(self, dim, fn):

super().__init__()

self.norm = nn.LayerNorm(dim)

self.fn = fn

def forward(self, x, **kwargs):

return self.fn(self.norm(x), **kwargs)层归一化:

self.norm = nn.LayerNorm(dim)

前向传播(forward 方法):

def forward(self, x, **kwargs): 在前向传播过程中,PreNorm类首先对输入x应用层归一化,然后将归一化后的结果传递给fn函数或模块。return self.fn(self.norm(x), **kwargs): 这行代码先对x应用层归一化,然后将归一化的结果传递给fn。这里的**kwargs允许传递额外的参数给fn函数。

文章来源:https://blog.csdn.net/qq_60245590/article/details/135796689

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 一文解读Docker 网络Network

- electron-vite中的ipc通信

- xtu oj 1354 Digit String

- UE蓝图 RPG动作游戏(一) day14

- leetcode LCR 159. 库存管理 III(easy)(小林出品必属精品)

- 电器企业品牌网站建设的作用是什么

- 骨传导耳机品牌年度排行榜,骨传导耳机十大品牌排行榜分享

- 6个免费无版权的高清视频素材网站,剪辑必备~

- 如何正确使用 Bean Validation 进行数据校验

- 生产者消费者模型(C++11示例)