[Python] scikit-learn - accuracy_score(准确率分数)函数介绍和使用场景(案例)

Scikit-learn是一个用于机器学习和数据挖掘的Python库,提供了大量的机器学习算法和工具,使得机器学习任务更加便捷和高效。其中一个非常常用的函数是accuracy_score,用于计算分类器的准确率。本文将介绍accuracy_score函数的具体功能、函数原型和使用场景,并提供一个使用案例来说明其用法和作用。

函数介绍

accuracy_score函数是scikit-learn库中用于计算分类器准确率的函数。准确率是分类器在所有分类样本中正确分类的比例。accuracy_score函数接受两个参数,分别是真实标签和预测标签,返回一个准确率的浮点数值。

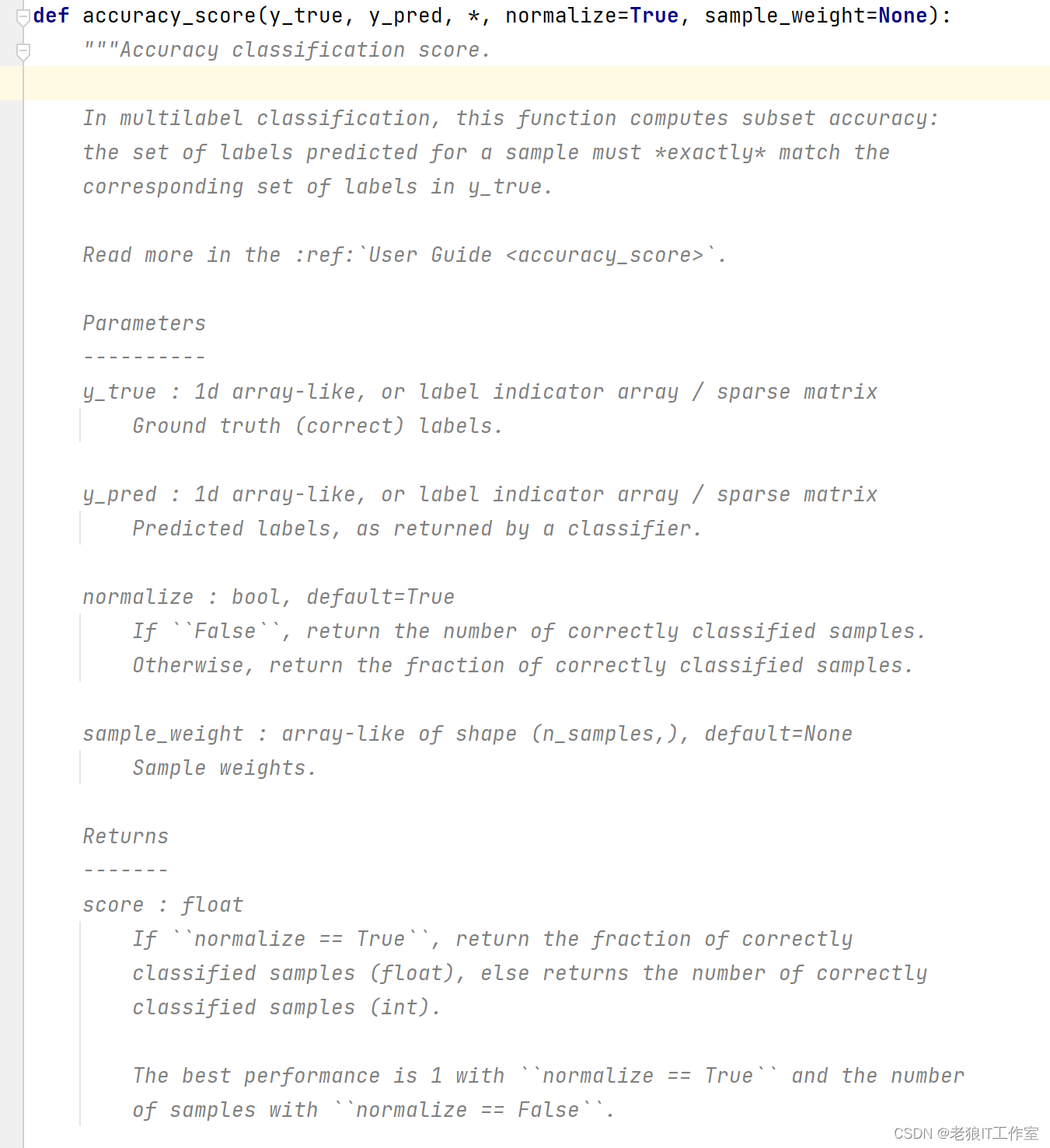

函数原型

sklearn.metrics.accuracy_score — scikit-learn 1.4.0 documentation

accuracy_score(y_true, y_pred, normalize=True, sample_weight=None)- y_true:真实的标签,通常是一个一维数组或列表

- y_pred:预测的标签,通常是一个一维数组或列表

- normalize:是否将结果归一化,默认为True,即返回一个准确率的百分比;若设置为False,即返回一个正确分类的样本数量

- sample_weight:样本权重,可选参数,默认为None

使用场景

accuracy_score函数广泛应用于分类问题中,用于计算分类器的准确率。准确率是分类问题中最常用的评价指标之一,可以帮助我们评估和比较不同分类器的性能。通过比较不同分类器的准确率,我们可以选择最优的分类器来应用于实际场景中。

使用案例

为了更好地理解accuracy_score函数的使用方法和作用,下面给出一个使用案例,展示如何计算分类器的准确率。

from sklearn.metrics import accuracy_score

# 真实标签

y_true = [0, 1, 2, 1, 3, 2, 0, 1, 2, 3]

# 预测标签

y_pred = [0, 1, 1, 1, 3, 2, 0, 0, 2, 3]

# 计算准确率

normal_accuracy = accuracy_score(y_true, y_pred, normalize=True)

non_normal_accuracy = accuracy_score(y_true, y_pred, normalize=False)

print("归一化准确率:", normal_accuracy, "非归一化准确率:", non_normal_accuracy)输出结果为:

归一化准确率: 0.8 非归一化准确率: 8.0以上案例中,我们定义了真实的标签y_true和预测的标签y_pred。通过调用accuracy_score函数,传入这两个标签,即可计算出分类器的准确率。在这个例子中,准确率为0.8,意味着分类器正确分类的样本占总样本数量的80%(或者8.0,意味着分类正确的有8个样本,总样本为10个)。

总结

本文介绍了scikit-learn库中accuracy_score函数的具体功能、函数原型和使用场景,并提供了一个使用案例来说明其用法和作用。accuracy_score函数是在机器学习中广泛使用的函数,常用于计算分类器的准确率,帮助我们评估和比较不同分类器的性能。在实际应用中,我们可以根据准确率选择最优的分类器来解决具体的问题。

?

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- vue3项目 - Eslint 配置代码风格

- 实现一个最简单的内核

- 【开源】基于JAVA的停车场收费系统

- Docker安装并配置Mongodb 5.0单机复制集

- linux的第一个进程及由父进程生成子进程机制设计缘由

- MyBatis 查询数据库

- 2023年软件测试已经崩盘了吗,为什么都找不到工作了?

- Mac专用投屏工具AirServer 7 .27 for Mac破解版2024最新免费下载及 2024激活码进行详细解析

- JAVA程序流程控制

- PDF控件Spire.PDF for .NET【安全】演示:从 PDF 中删除数字签名字段