Python实现交叉验证法

发布时间:2024年01月22日

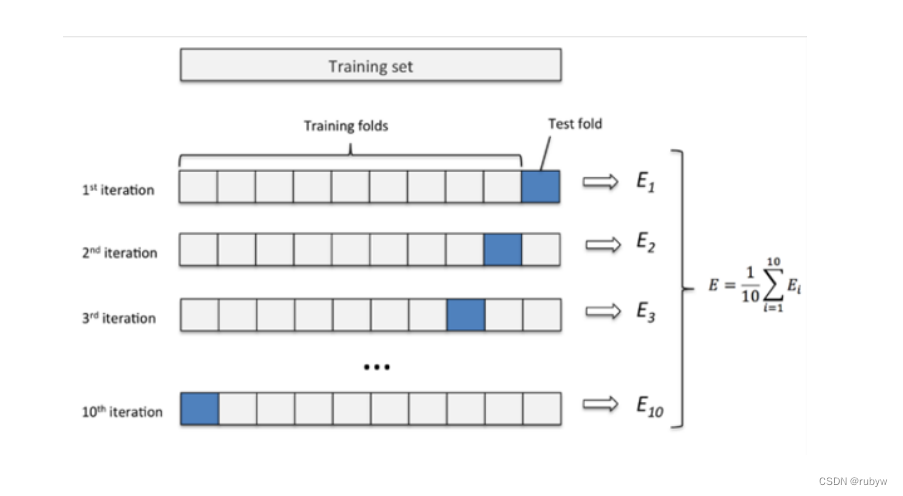

交叉验证是一种用于评估模型性能和选择超参数的方法。其中,k折交叉验证是最常用的形式之一。它将数据集分为k个相似大小的折(folds),然后执行k次训练-测试过程,每次选择一个不同的折用作测试集,其余折用作训练集。最后,将k次测试的性能指标的平均值作为最终性能指标。

在scikit-learn库中,可以使用cross_val_score函数进行交叉验证。以下是一个示例,演示如何在多项式回归中使用交叉验证:

import numpy as np

from sklearn.model_selection import cross_val_score

from sklearn.linear_model import LinearRegression

from sklearn.preprocessing import PolynomialFeatures

from sklearn.pipeline import make_pipeline

# 生成一些示例数据

np.random.seed(0)

X = 2 * np.random.rand(100, 1)

y = 3 * X + 2 * X**2 + 1 + np.random.randn(100, 1)

# 创建多项式回归模型

degree = 2

model = make_pipeline(PolynomialFeatures(degree), LinearRegression())

# 进行k折交叉验证

k_folds = 5

cv_scores = cross_val_score(model, X, y, cv=k_folds, scoring='neg_mean_squared_error')

# 输出交叉验证的均方误差(MSE)得分

print("交叉验证的均方误差得分:", -cv_scores)

# 输出均方误差的平均值

print("平均均方误差:", -np.mean(cv_scores))

在这个例子中,我们使用PolynomialFeatures将特征转换为多项式特征,并创建一个多项式回归模型。然后,我们使用cross_val_score进行k折交叉验证,并输出交叉验证的均方误差(MSE)得分。这个得分可以用于评估模型性能。

文章来源:https://blog.csdn.net/rubyw/article/details/135751060

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 保姆级CISP报考攻略,让你不再迷茫

- 图形化编程:以Scratch引领少儿编程思维启蒙之旅

- 动态规划系列问题之打家劫舍和买股票

- 【IC前端虚拟项目】MVU寄存器文档编写与RTL代码生成

- 上海交通大学生存手册

- 2024年工业互联网平台的发展趋势如何?

- 【建议收藏】一文全面解读Linux最常用的解压缩命令(tar、zip、unzip、gzip、guznip、bzip2、bunzip2)

- DNS域名解析服务

- AI经典科幻电影《超级骇客2》(上)——虚拟与现实的终极之战

- 代码随想录 Leetcode225. 用队列实现栈