可抓取性和可索引性:它们是什么以及如何影响搜索引擎优化

什么是可抓取性?

网页的可抓取性是指搜索引擎(如谷歌)发现网页的难易程度。

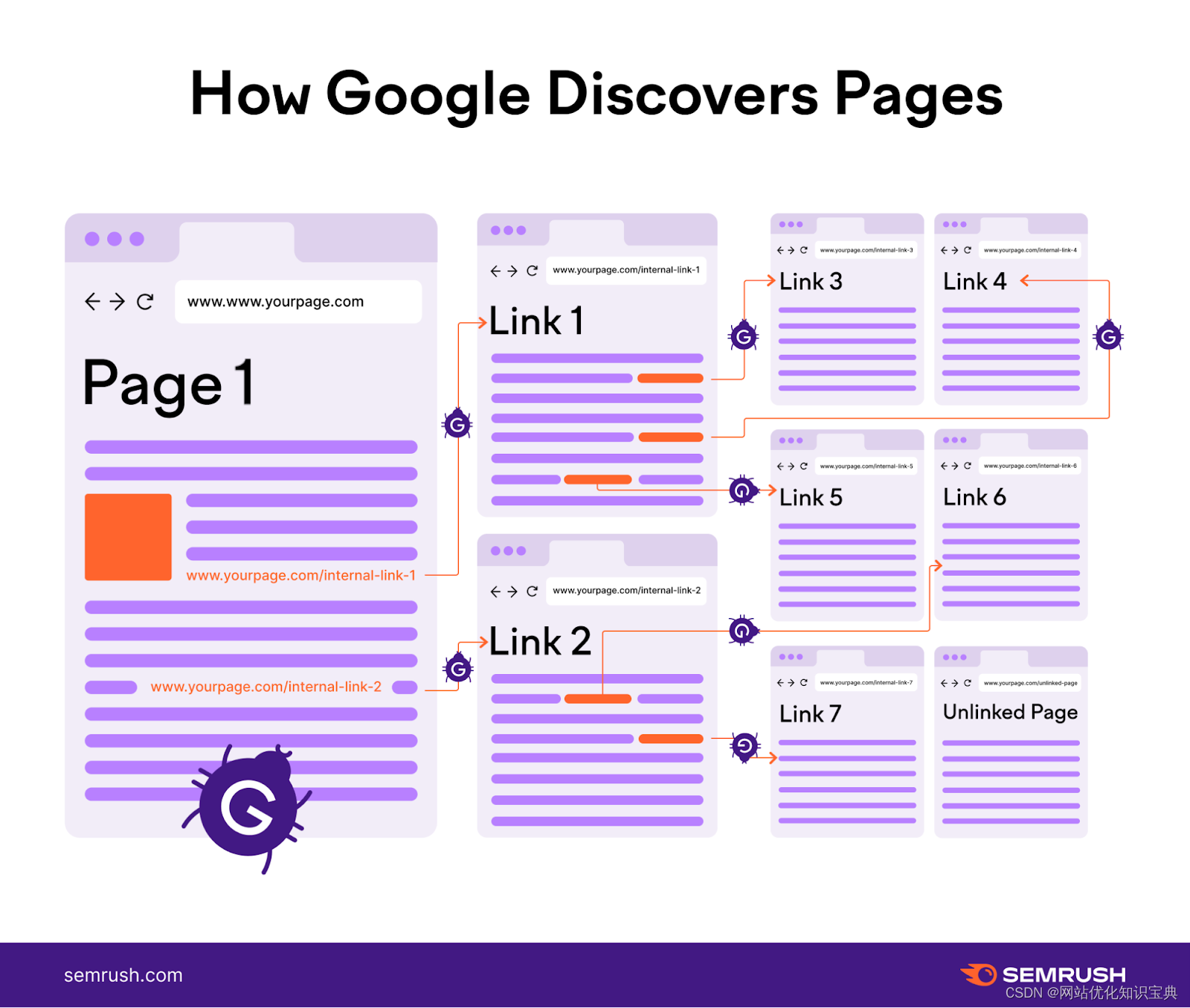

谷歌发现网页的过程称为爬行。它使用称为网络爬虫(也称为机器人或蜘蛛)的计算机程序。这些程序会跟踪网页之间的链接,以发现新的或更新的网页。

索引通常是在爬行之后进行的。

什么是索引能力?

网页的可索引性意味着搜索引擎(如 Google)能够将网页添加到其索引中。

将网页添加到索引的过程称为索引。这意味着 Google 会分析网页及其内容,并将其添加到包含数十亿网页的数据库(称为 Google 索引)中。

可抓取性和可索引性如何影响搜索引擎优化?

可抓取性和可索引性对搜索引擎优化至关重要。

下面是一个简单的图解,展示了谷歌是如何工作的:

首先,谷歌会抓取页面。然后编制索引。只有这样,它才能在相关搜索查询中对页面进行排名。

换句话说:如果页面没有被抓取和编入索引,就不会被 Google 列入排名。没有排名=没有搜索流量。

是什么影响了可抓取性和可索引性?

内部链接

内部链接会直接影响网站的可抓取性和可索引性。

请记住,搜索引擎使用机器人来抓取和发现网页。内部链接就像一个路线图,引导机器人从您网站上的一个页面到另一个页面。

布局合理的内部链接能让搜索引擎机器人更容易找到网站的所有页面。

因此,请确保您网站上的每个页面都有来自网站其他地方的链接。

首先要在内容中加入导航菜单、页脚链接和上下文链接。

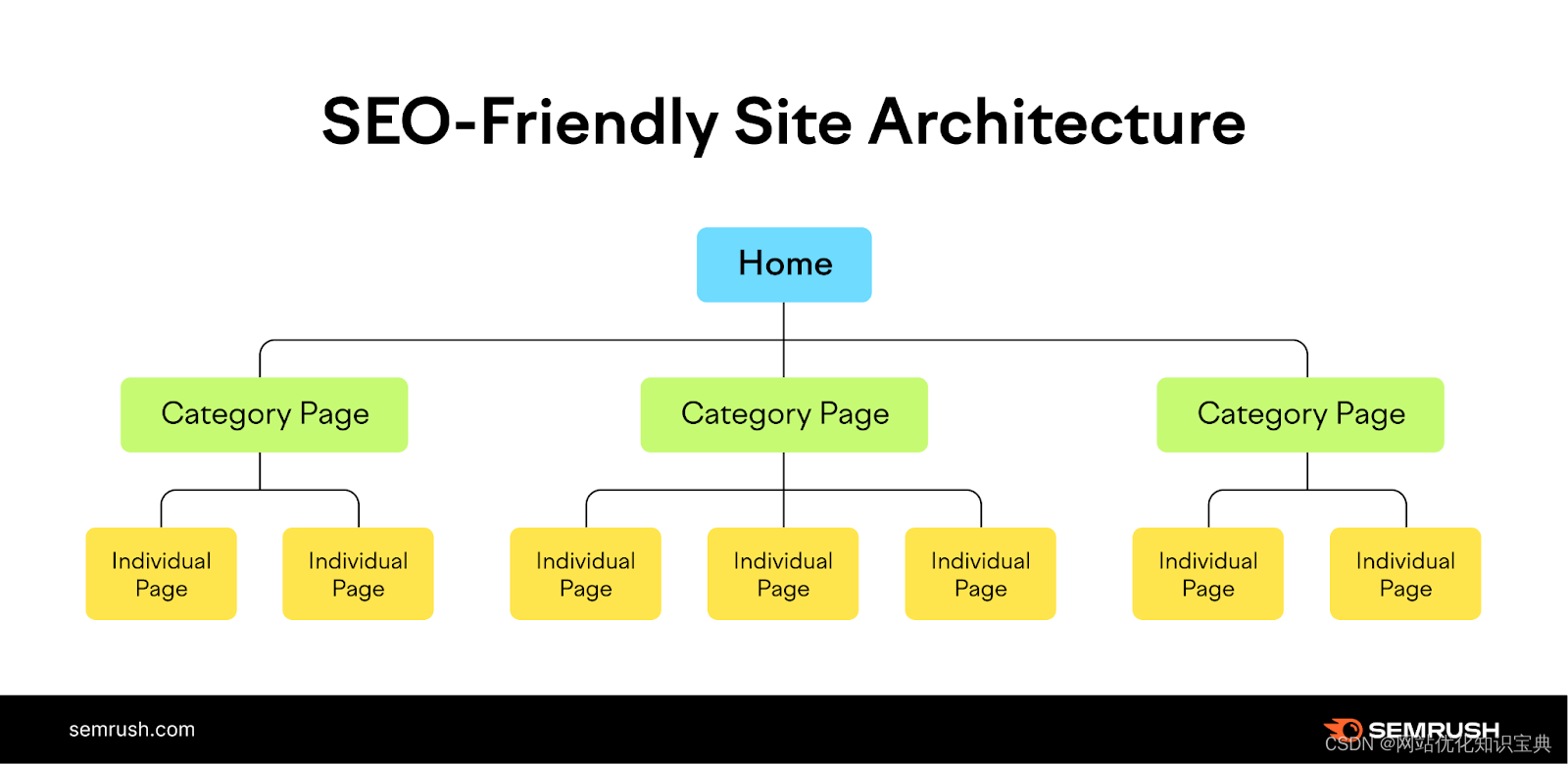

如果您还处于网站开发的早期阶段,创建一个合理的网站结构也可以帮助您建立一个强大的内部链接基础。

合理的网站结构将网站分为不同的类别。然后,这些类别链接到网站上的各个页面。

比如

主页连接到每个类别的页面。然后,每个类别的页面连接到网站上的特定子页面。

通过调整这种结构,你将为搜索引擎轻松导航和索引你的内容打下坚实的基础。

Robots.txt

Robots.txt 就像派对入口处的保镖。

它是网站上的一个文件,告诉搜索引擎机器人可以访问哪些页面。

下面是一个 robots.txt 文件示例:

User-agent: *

Allow:/blog/

Disallow:/blog/admin/

让我们来了解该文件的每个组成部分。

- User-agent: *: 这一行指定规则适用于所有搜索引擎机器人

- Allow: /blog/: 该指令允许搜索引擎机器人抓取"/blog/"目录下的页面。换句话说,允许抓取所有博客文章

- Disallow: /blog/admin/: 该指令告诉搜索引擎机器人不要抓取博客的管理区域

当搜索引擎发送机器人探索您的网站时,它们首先会检查 robots.txt 文件,检查是否有限制。

注意不要不小心屏蔽了你希望搜索引擎找到的重要页面。例如您的博客文章和常规网站页面。

此外,虽然 robots.txt 可以控制抓取的可访问性,但它不会直接影响网站的可索引性。

搜索引擎仍然可以发现并索引从其他网站链接过来的页面,即使这些页面在 robots.txt 文件中被屏蔽了。

为确保某些页面(如点击付费(PPC)登陆页面和 "感谢 "页面)不被索引,请使用 "noindex "标签。

请阅读我们的 meta robots 标签指南,了解该标签及实施方法。

XML 网站地图

XML 网站地图对提高网站的可抓取性和可索引性至关重要。

它向搜索引擎机器人展示您希望抓取和索引的网站上的所有重要页面。

这就像给它们一张藏宝图,让它们更容易发现你的内容。

因此,请在网站地图中包含所有重要页面。包括那些通过常规导航可能难以找到的页面。

这将确保搜索引擎机器人能高效地抓取和索引您的网站。

内容质量

内容质量影响搜索引擎如何抓取和索引您的网站。

搜索引擎机器人喜欢高质量的内容。如果您的内容文笔优美、信息量大且与用户相关,就能吸引搜索引擎的更多关注。

搜索引擎希望为用户提供最好的结果。因此,它们会优先抓取内容一流的网页并将其编入索引。

专注于创建原创、有价值和精心撰写的内容。

使用正确的格式、清晰的标题和有条理的结构,让搜索引擎机器人更容易抓取和理解您的内容。

有关创建一流内容的更多建议,请查看我们的优质内容指南。

技术问题

技术问题会妨碍搜索引擎机器人有效抓取和索引您的网站。

如果您的网站存在页面加载速度慢、链接断开或重定向循环等问题,就会妨碍机器人浏览您的网站。

技术问题也会妨碍搜索引擎正确索引您的网页。

例如,如果您的网站存在重复内容问题或使用了不恰当的规范标签,搜索引擎可能会难以理解该索引哪个版本的网页并对其进行排名。

诸如此类的问题都会损害网站在搜索引擎中的可见度。尽快发现并解决这些问题。

如何查找可抓取性和可索引性问题

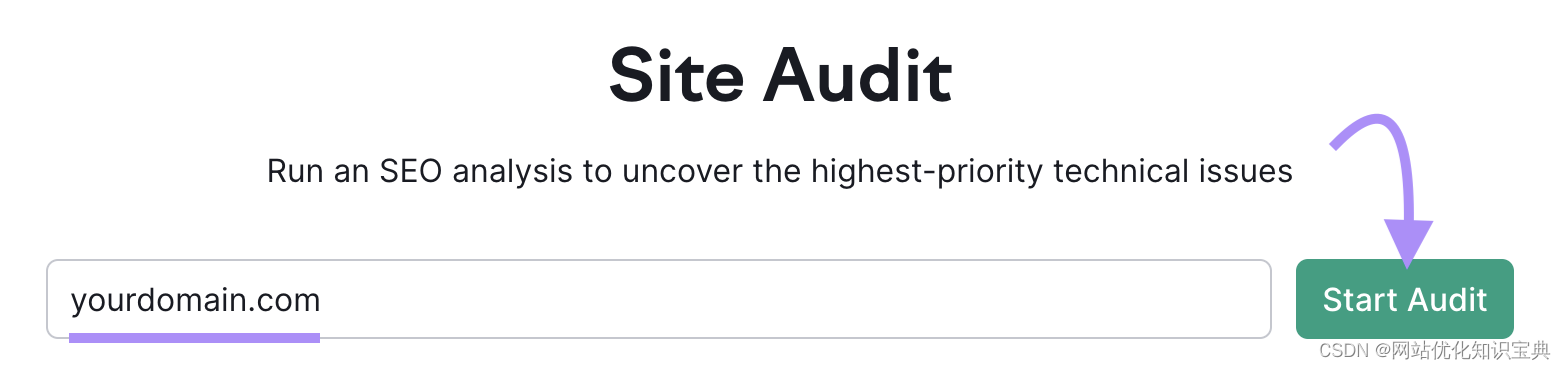

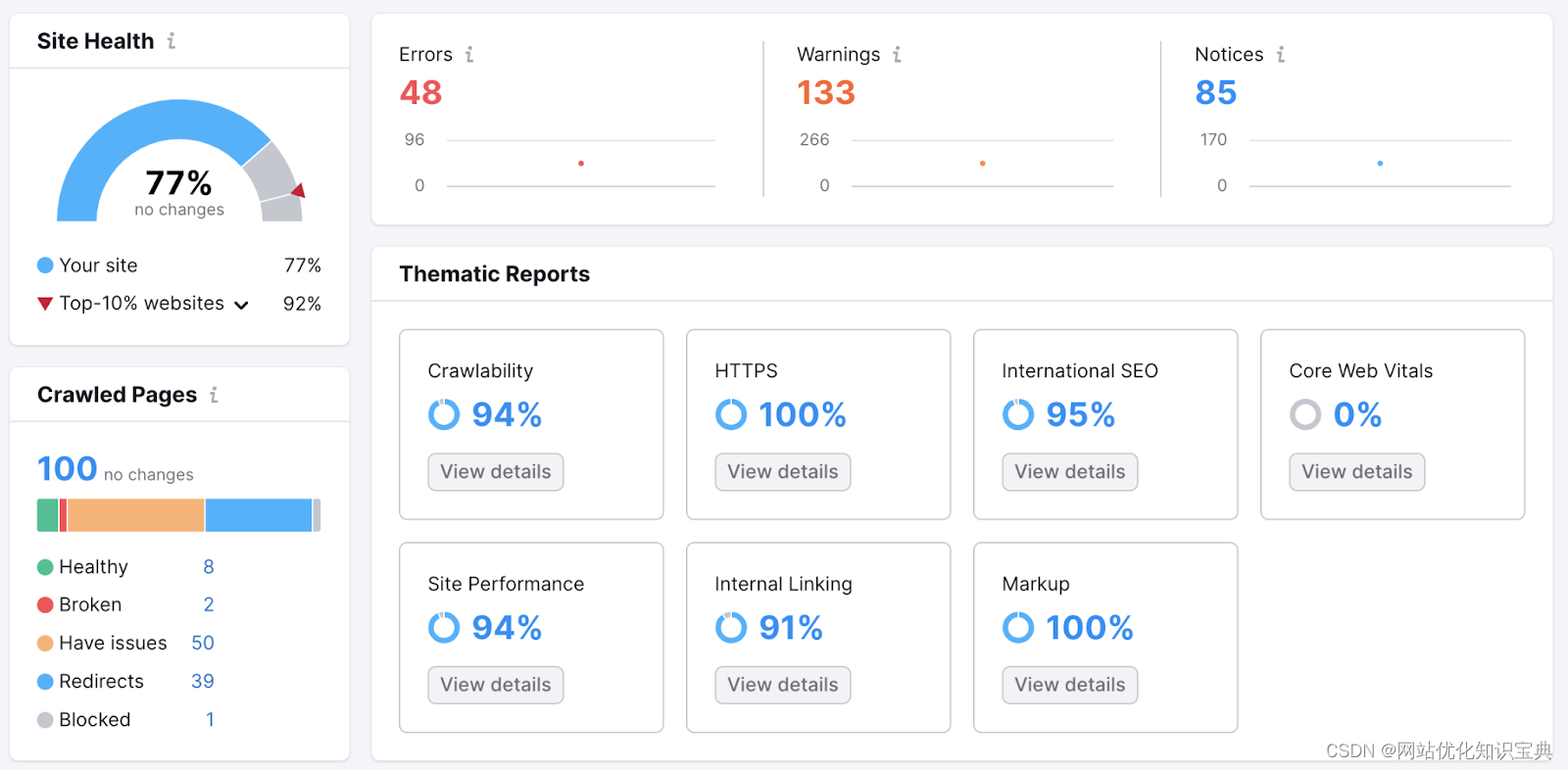

使用 Semrush 的网站审计工具查找影响网站抓取和索引能力的技术问题。

该工具可以帮助您发现并修复以下问题:

- 重复内容

- 重定向循环

- 内部链接中断

- 服务器端错误

要开始使用,请输入您的网站 URL,然后点击 “开始审核”。

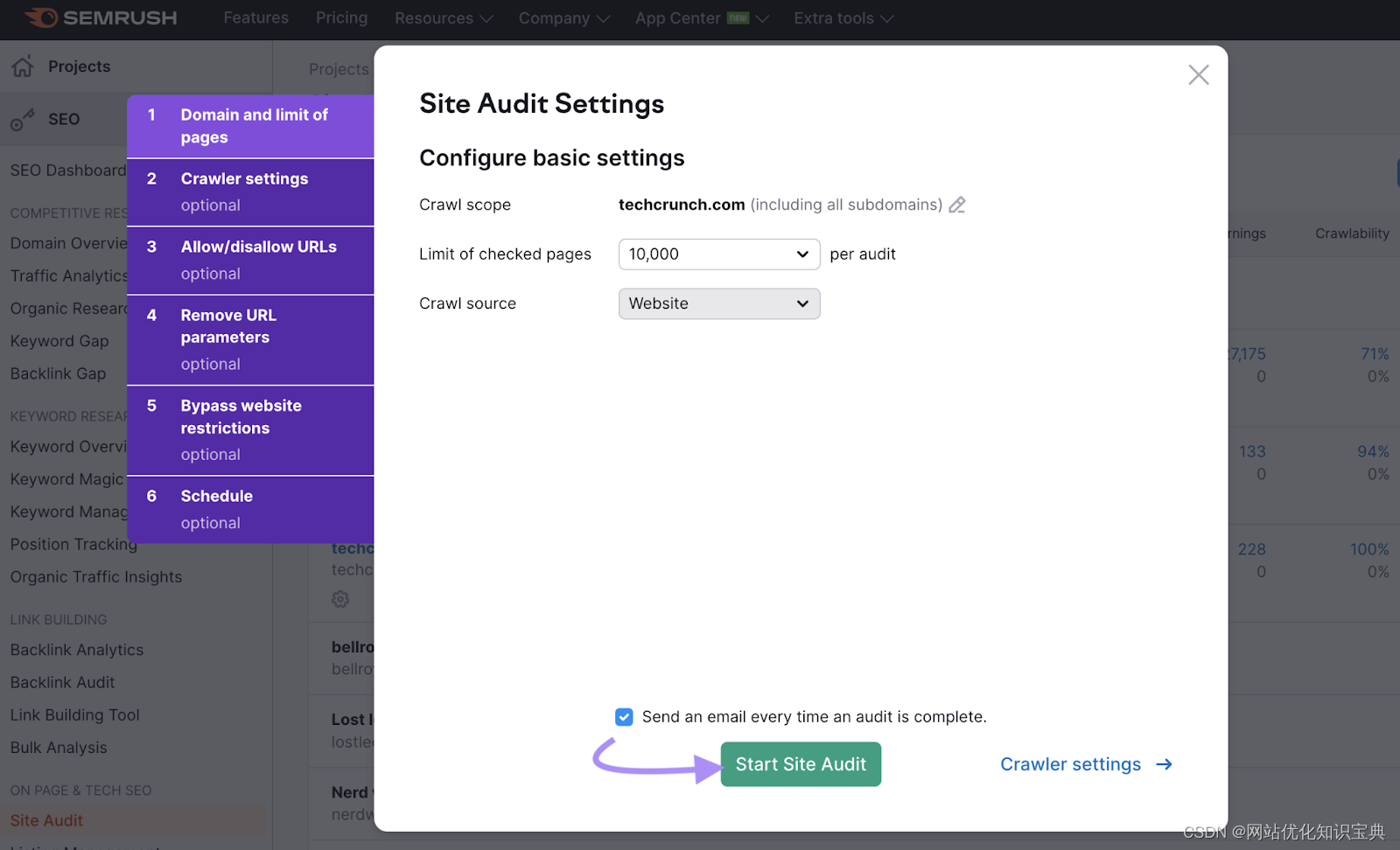

接下来,配置审核设置。完成后,点击 “开始网站审核”。

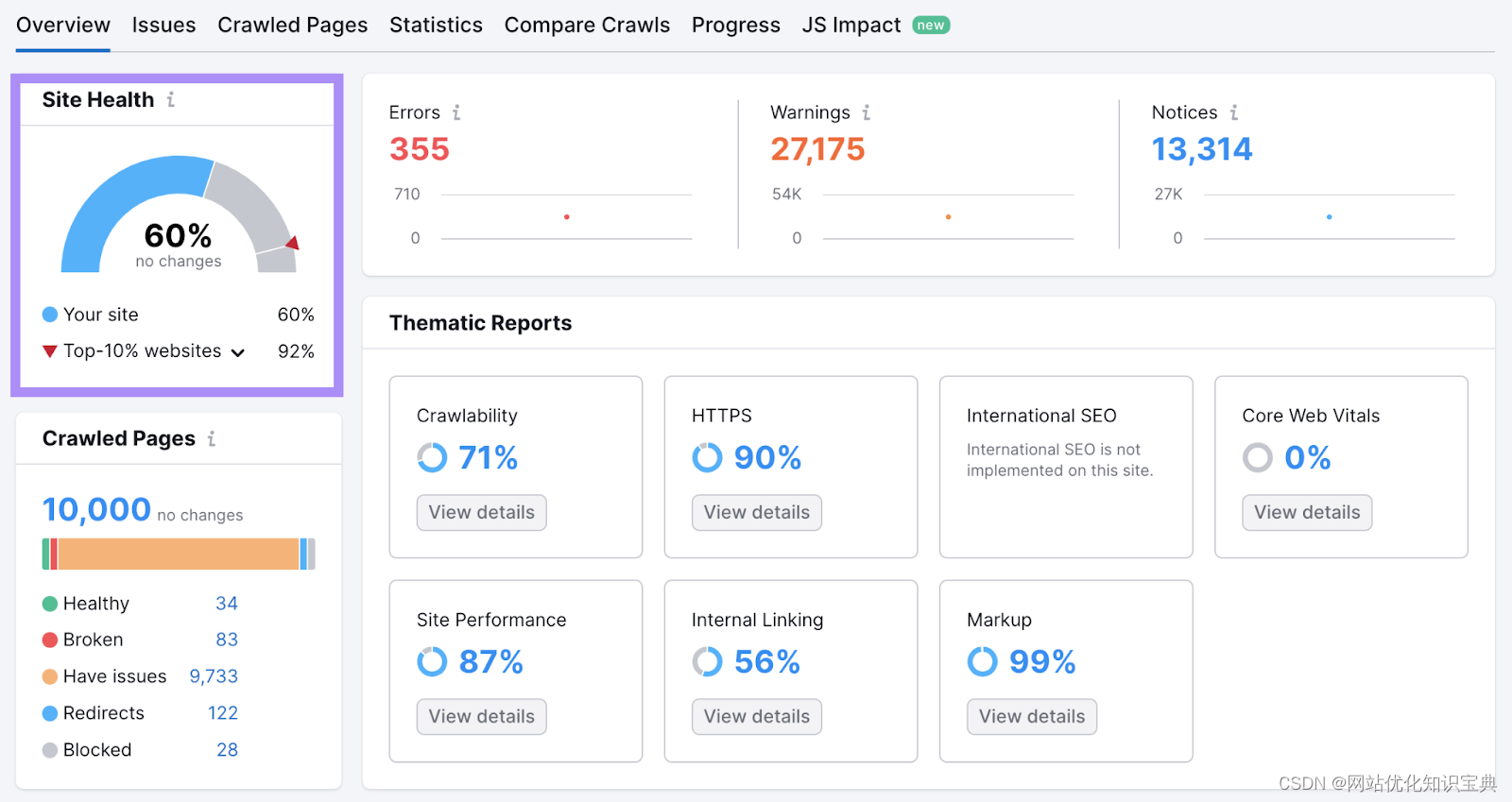

该工具将开始审核网站的技术问题。完成后,它将通过 "网站健康 "指标显示网站技术健康状况概览。

它以 0 到 100 的范围来衡量网站的整体技术健康状况。

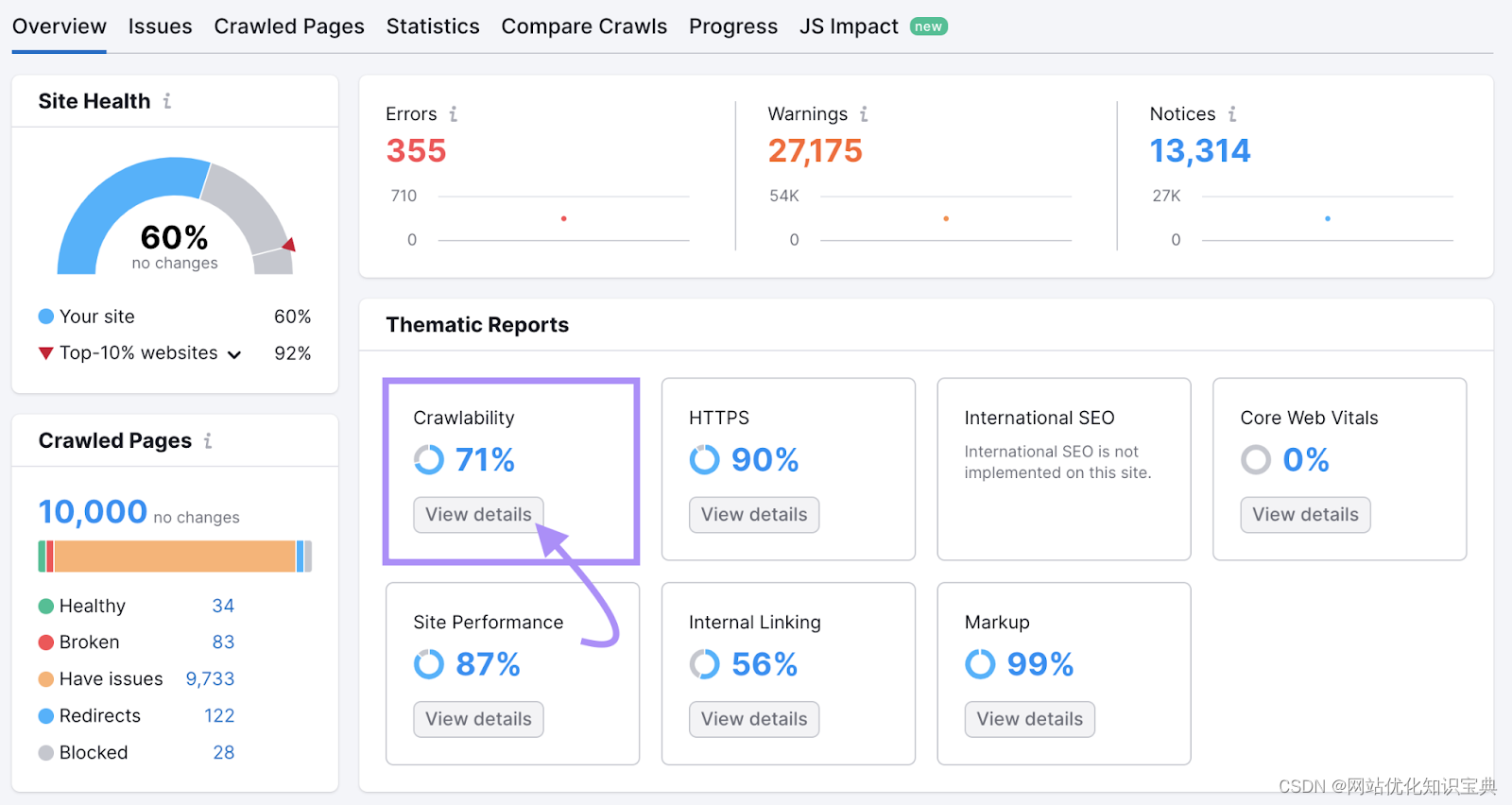

要查看与可抓取性和可索引性相关的问题,请导航至 "可抓取性 "并点击 “查看详情”。

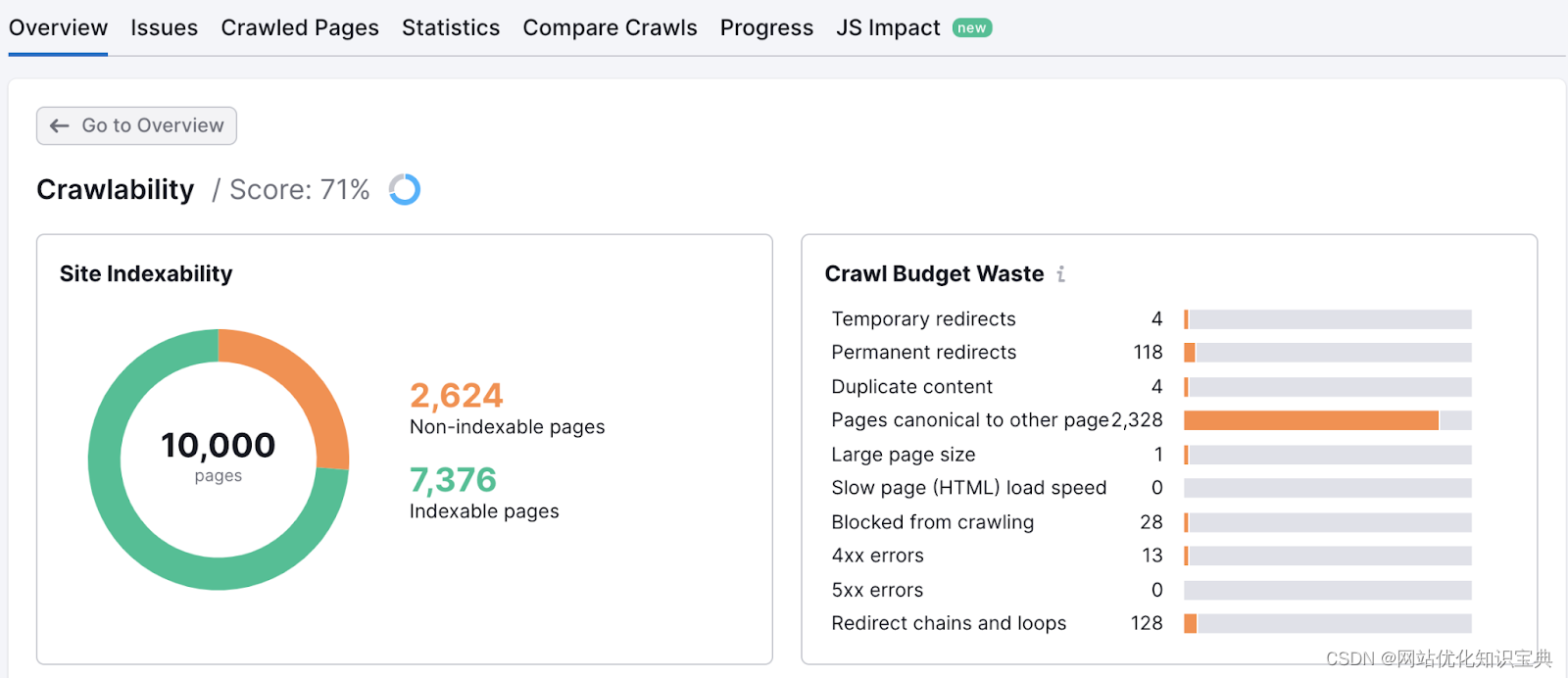

这将打开一份详细的报告,突出显示影响网站可抓取性和可索引性的问题。

点击每个问题项目旁边的横条图。该工具将显示所有受影响的页面。

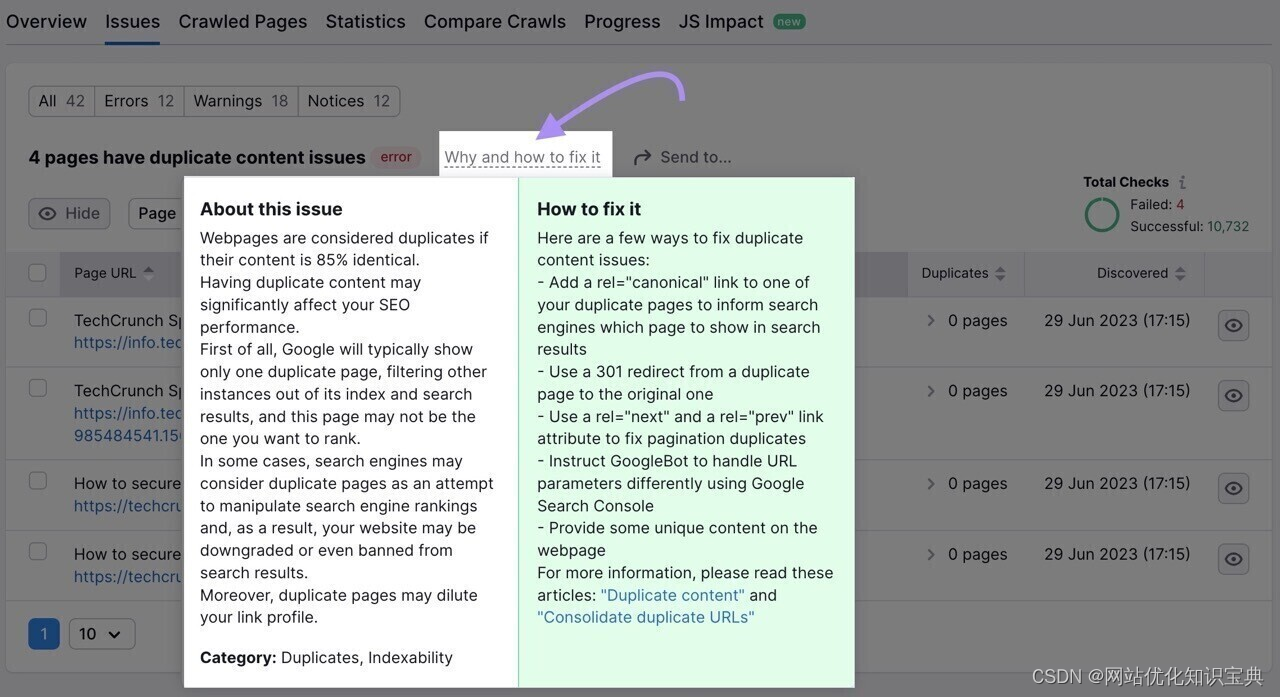

如果您不确定如何解决某个问题,请单击 "为什么以及如何解决 "链接。

您将看到问题的简短描述和修复建议。

通过及时解决每个问题并维护一个技术健全的网站,您将提高网站的可抓取性,有助于确保适当的索引,并增加排名靠前的机会。

如何提高抓取能力和索引能力

向谷歌提交网站地图

向谷歌提交网站地图文件有助于抓取网页并编制索引。

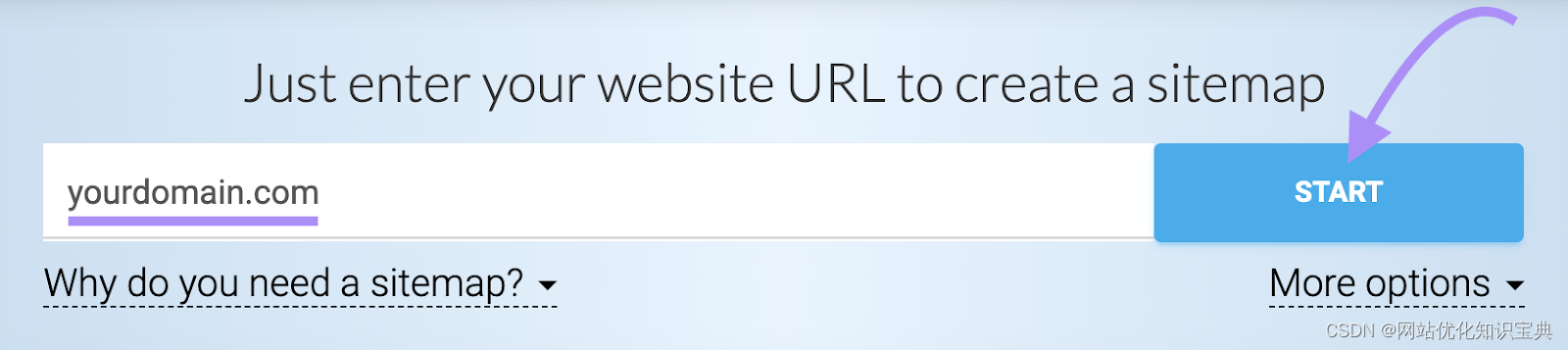

如果还没有网站地图,请使用 XML Sitemaps 等网站地图生成工具创建一个。

打开工具,输入网站 URL,然后点击 “开始”。

该工具会自动为您生成网站地图。

下载网站地图并将其上传到网站根目录。

例如,如果您的网站是 www.example.com,那么您的网站地图应位于 www.example.com/sitemap.xml。

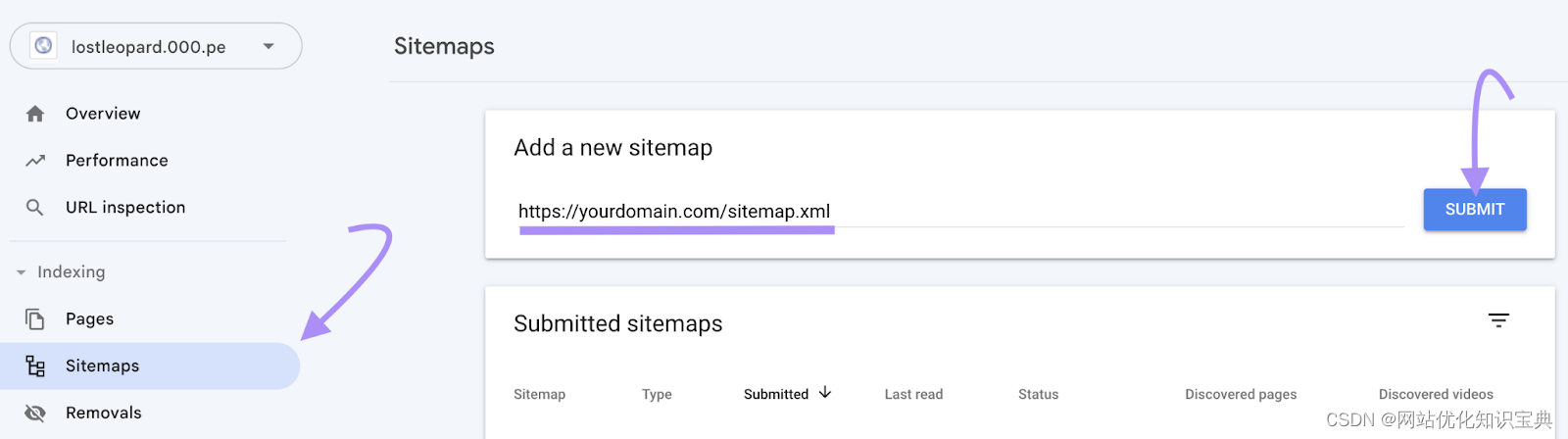

网站地图上线后,通过 Google Search Console (GSC) 账户将其提交给 Google。

没有设置 GSC?请阅读我们的 Google Search Console 指南。

激活后,从侧边栏导航至 “网站地图”。输入网站地图 URL,然后点击 “提交”。

这样可以提高网站的可抓取性和索引性。

加强内部链接

网站的可抓取性和可索引性还在于其内部链接结构。

修复与内部链接相关的问题,如断开的内部链接和孤儿页面(即没有内部链接的页面),并加强内部链接结构。

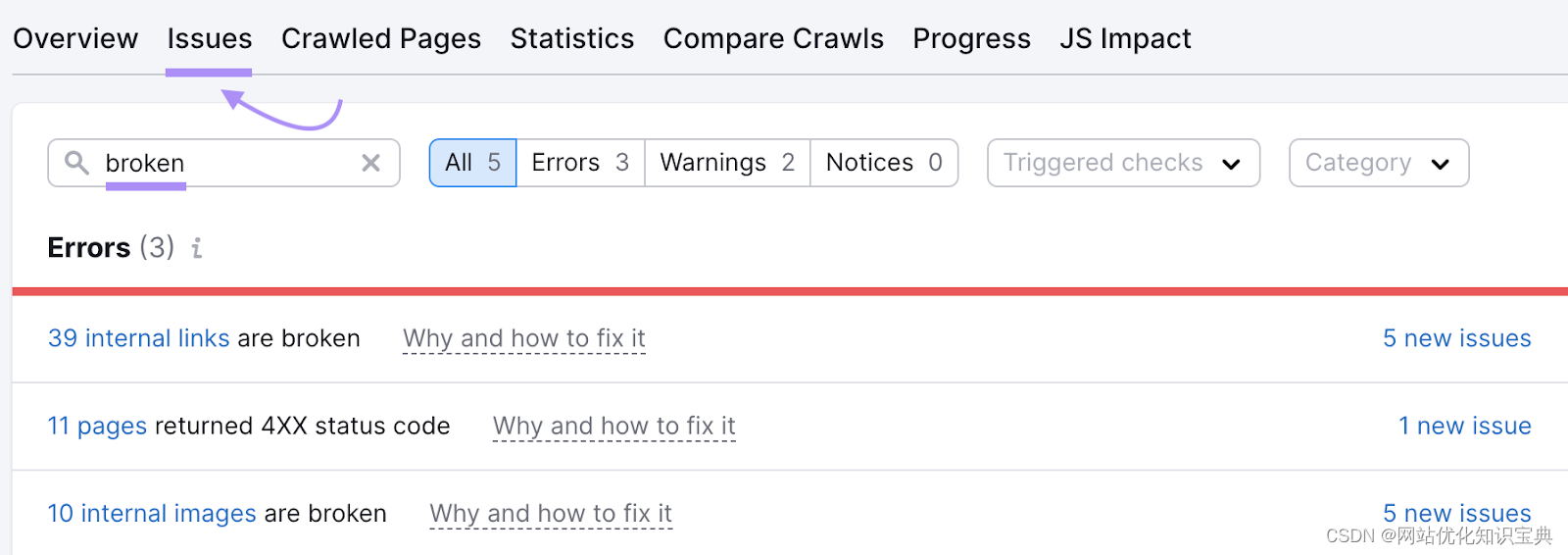

为此,请使用 Semrush 的网站审计工具。

转到 "问题 "选项卡,搜索 “断开的”。该工具将显示网站上任何断开的内部链接。

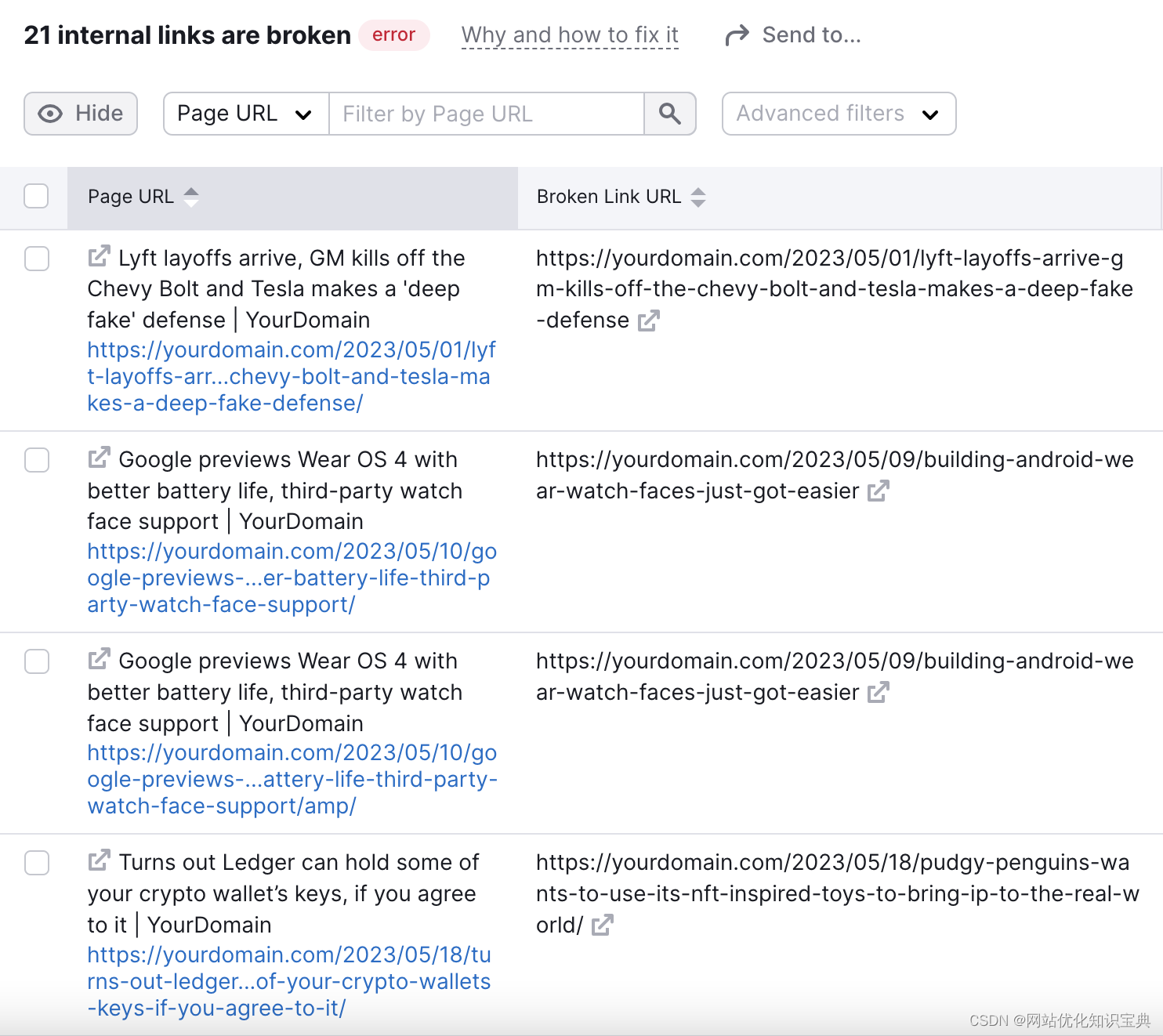

单击 “XXX 内部链接已损坏”,查看已损坏内部链接的列表。

要解决链接断开的问题,可以恢复断开的页面。或者实施 301 重定向到网站上的相关替代页面。

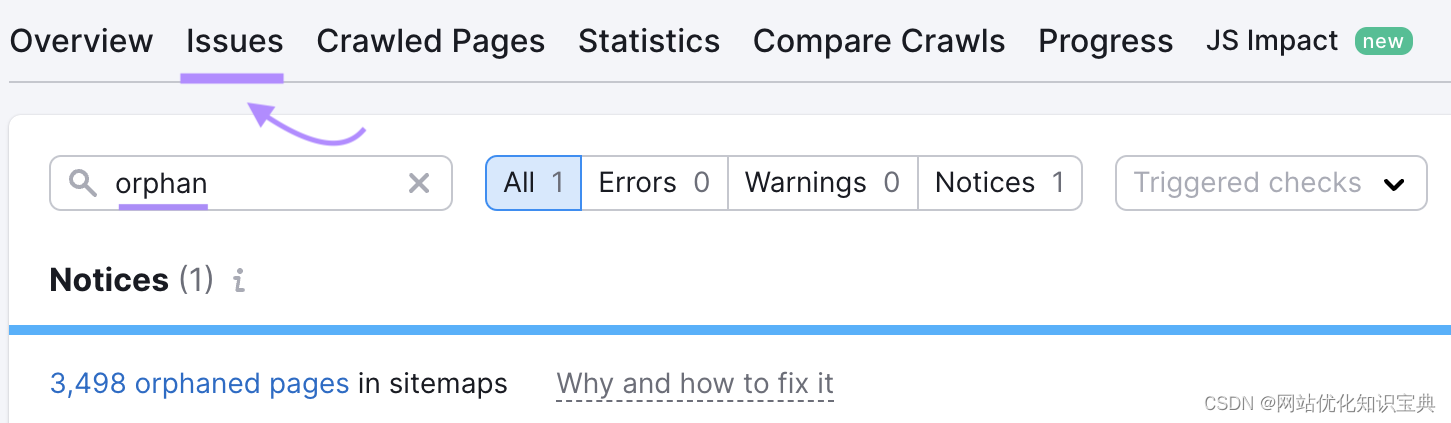

现在要查找孤儿页面,回到问题选项卡,搜索 “孤儿”。

该工具将显示您的网站是否有任何孤儿页面。通过创建指向这些页面的内部链接来解决这个问题。

定期更新和添加新内容

定期更新和添加新内容对网站的可抓取性和可索引性非常有益。

搜索引擎喜欢新鲜的内容。当您定期更新和添加新内容时,就意味着您的网站是活跃的。

这可以鼓励搜索引擎机器人更频繁地抓取您的网站,确保它们捕捉到最新更新。

如果可能,争取定期更新网站内容。

无论是发布新博文还是更新现有博文,这都有助于搜索引擎机器人与您的网站保持互动,并在其索引中保持内容的新鲜度。

避免重复内容

避免重复内容对于提高网站的可抓取性和可索引性至关重要。

重复内容会混淆搜索引擎机器人,浪费抓取资源。

当网站的多个页面上存在相同或非常相似的内容时,搜索引擎可能难以确定要抓取和索引的版本。

因此,请确保网站上的每个页面都有独一无二的内容。避免复制和粘贴其他来源的内容,也不要在多个页面上重复自己的内容。

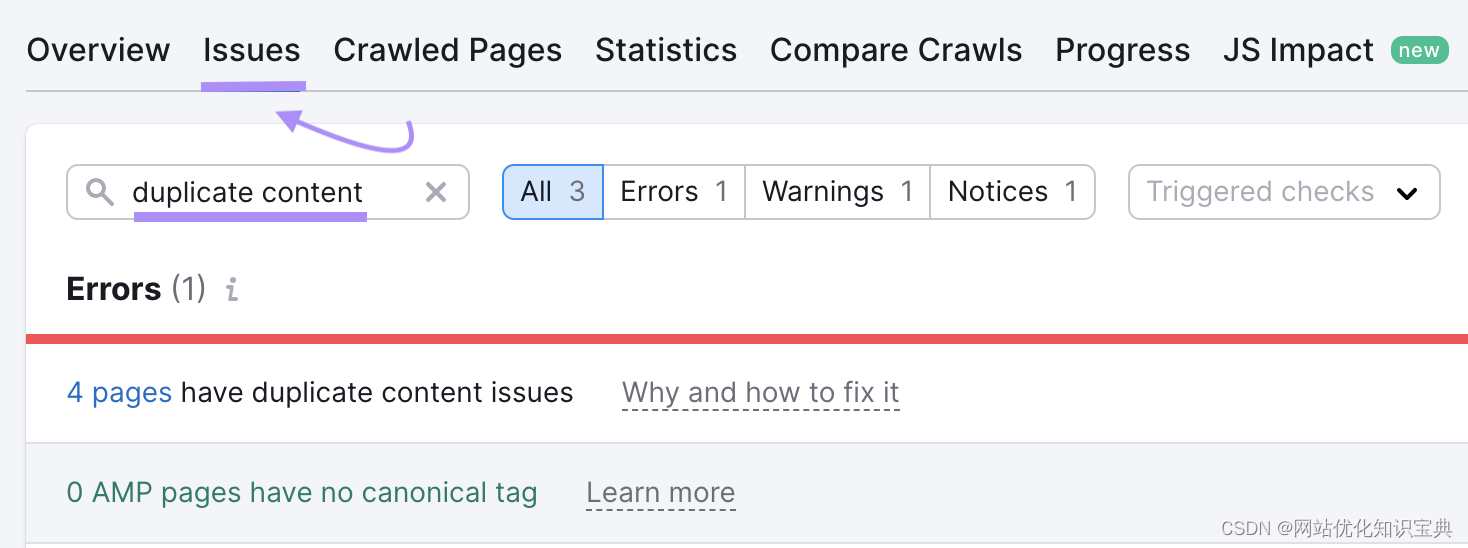

使用 Semrush 的网站审计工具检查网站是否存在重复内容。

在 "问题 "选项卡中,搜索 “重复内容”。

如果发现重复页面,可考虑将其合并为一个页面。并将重复页面重定向到合并后的页面。

或者使用规范标签。规范标签指定了搜索引擎应考虑索引的首选页面。

优化可抓取性和可索引性的工具

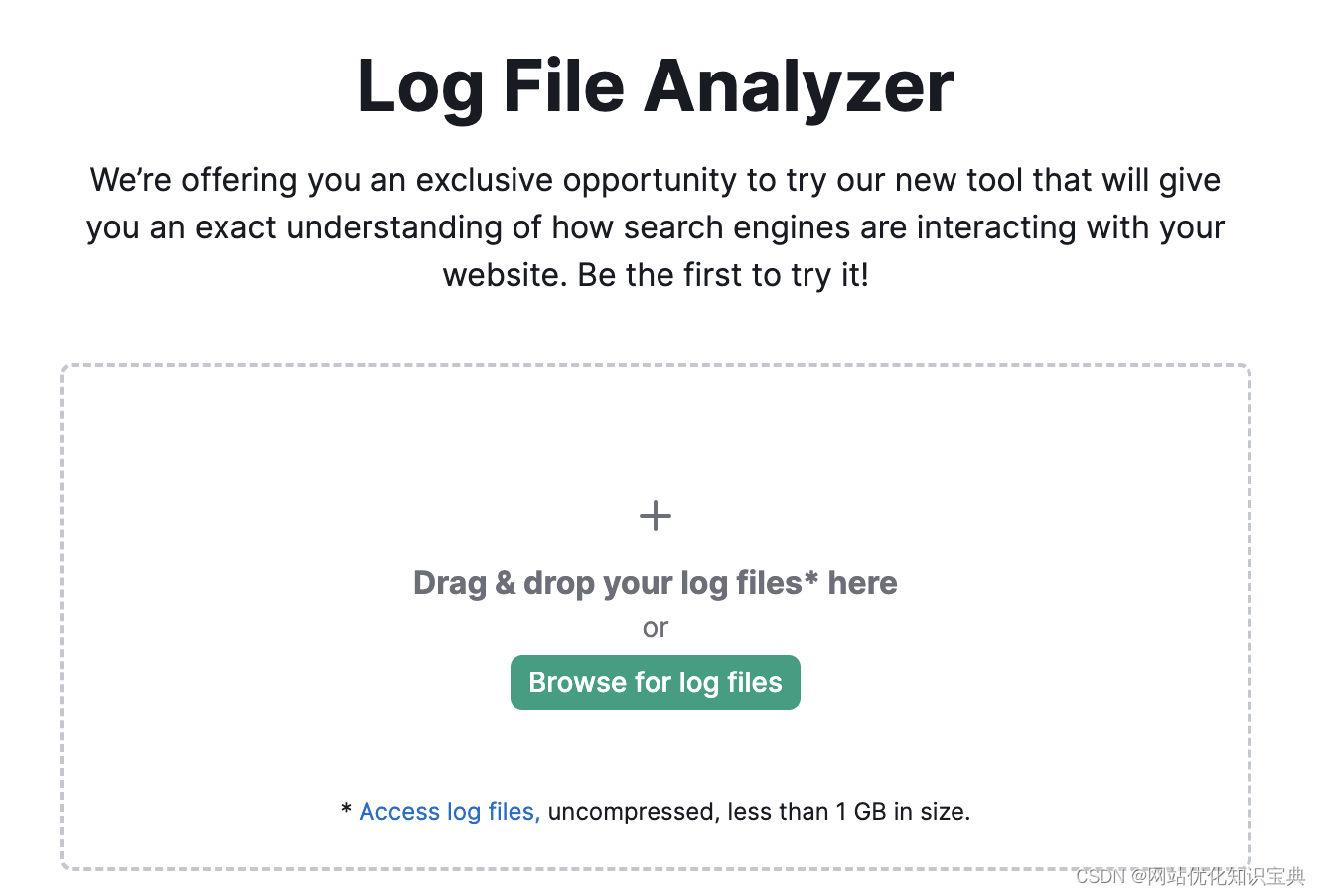

日志文件分析器 Semrush的日志文件分析器可以向您展示谷歌搜索引擎机器人(Googlebot)是如何抓取您的网站的。并帮助您发现它在此过程中可能遇到的任何错误。

首先上传网站的访问日志文件,然后等待工具分析文件。

访问日志文件包含机器人和用户发送到您网站的所有请求的列表。请阅读我们的手册,了解如何查找访问日志文件。

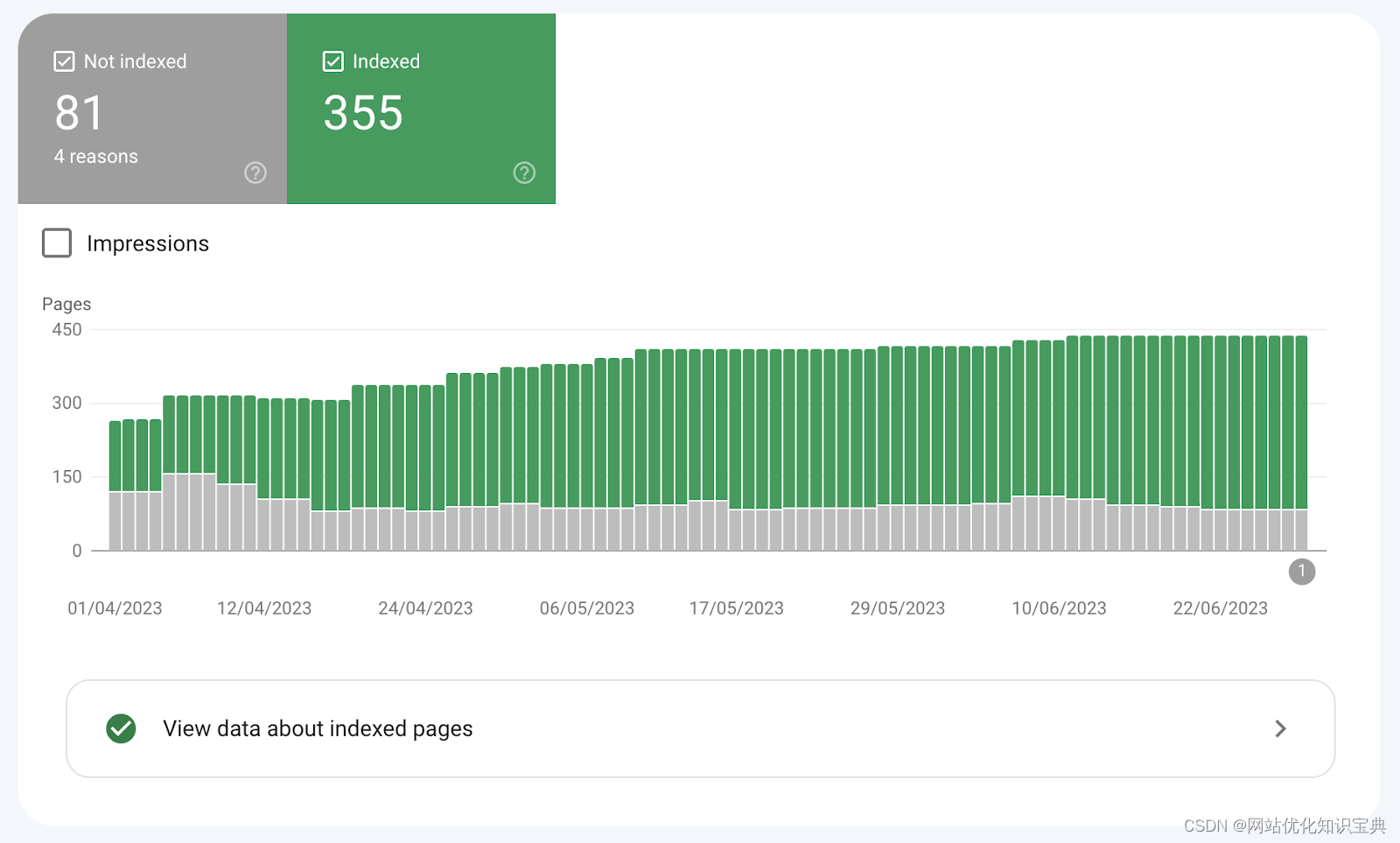

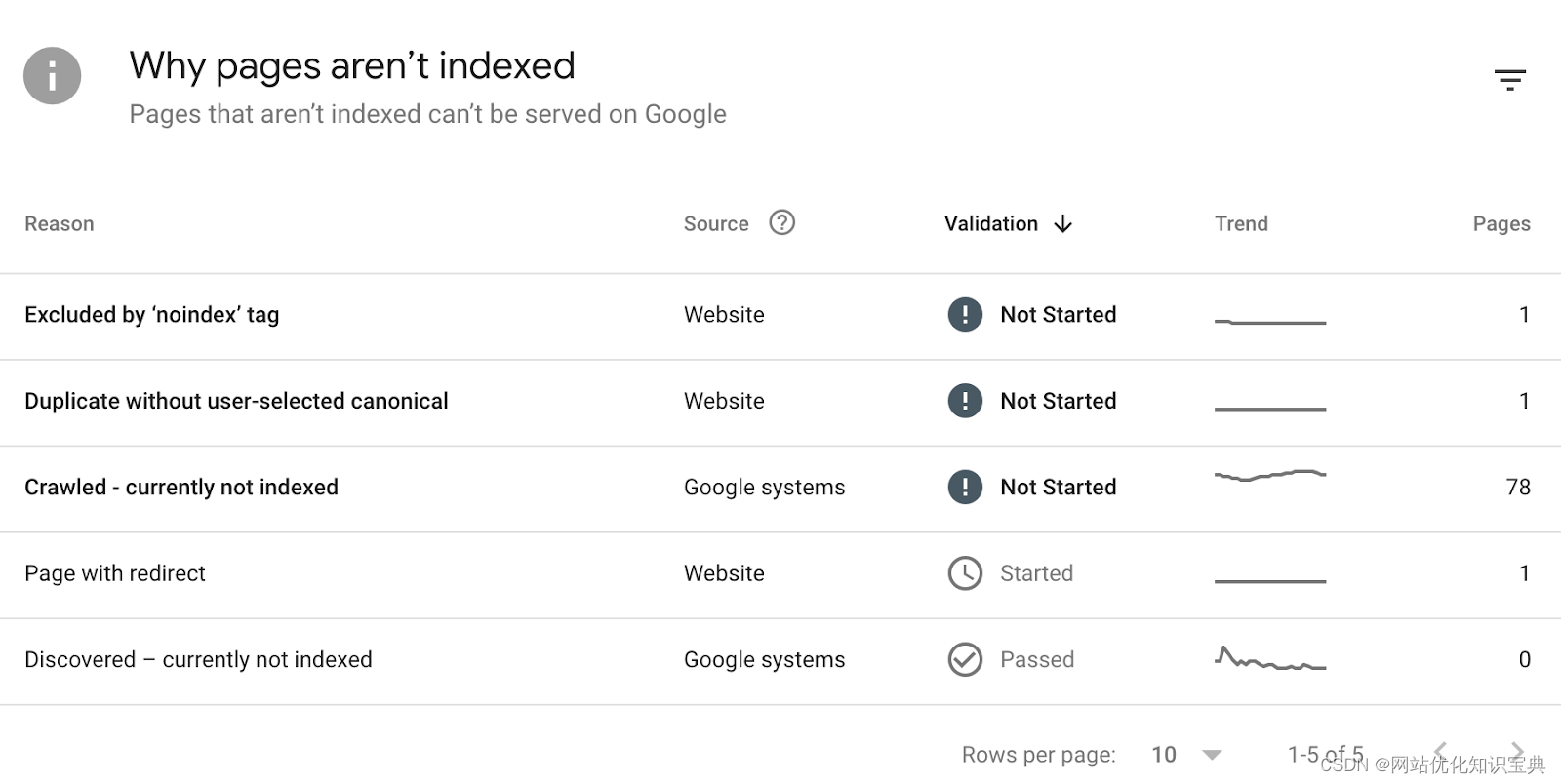

Google Search Console

Google Search Console 是 Google 推出的一款免费工具,可让您监控网站的索引状态。

查看您的所有网站页面是否都被收录。并找出某些网页未被收录的原因。

Site Audit

Site Audit 工具是您优化网站可抓取性和可索引性的最亲密盟友。

该工具可报告各种问题,包括许多影响网站可抓取性和可索引性的问题。

优先考虑可抓取性和可索引性

为搜索引擎优化网站的第一步是确保网站的可抓取性和可索引性。

否则,您的网页将无法显示在搜索结果中。您也不会获得有机流量。

网站审计工具和日志文件分析器可帮助您发现并解决与可抓取性和索引相关的问题。

如果你还有seo的或者需对应的seo的资料可以通过下方的图片扫描联系我,同时可以免费获得以下的seo学习资料

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【力扣每日一题】力扣2865美丽塔I

- 单酿葡萄酒和混酿葡萄酒的区别

- 海外营销推广难?看看这款外贸人强推的海外云手机!

- 基于SSM实现的社区论坛系统(附PPT、设计文档)

- CMake入门教程【基础篇】开关(option)

- 去除Bash 变量中的空白字符 —— 筑梦之路

- linux高级篇基础理论十二( 自动化运维工具Ansible )

- Linux rsh命令教程:远程shell命令的使用和注意事项(附案例详解和注意事项)

- C++ 指向类的指针

- 守护 C 盘,Python 相关库设置