翻译: Streamlit从入门到精通六 实战缓存Cache请求数据

Streamlit从入门到精通 系列:

- 翻译: Streamlit从入门到精通 基础控件 一

- 翻译: Streamlit从入门到精通 显示图表Graphs 地图Map 主题Themes 二

- 翻译: Streamlit从入门到精通 构建一个机器学习应用程序 三

- 翻译: Streamlit从入门到精通 部署一个机器学习应用程序 四

- 翻译: Streamlit从入门到精通 高级用法缓存Cache和Session 五

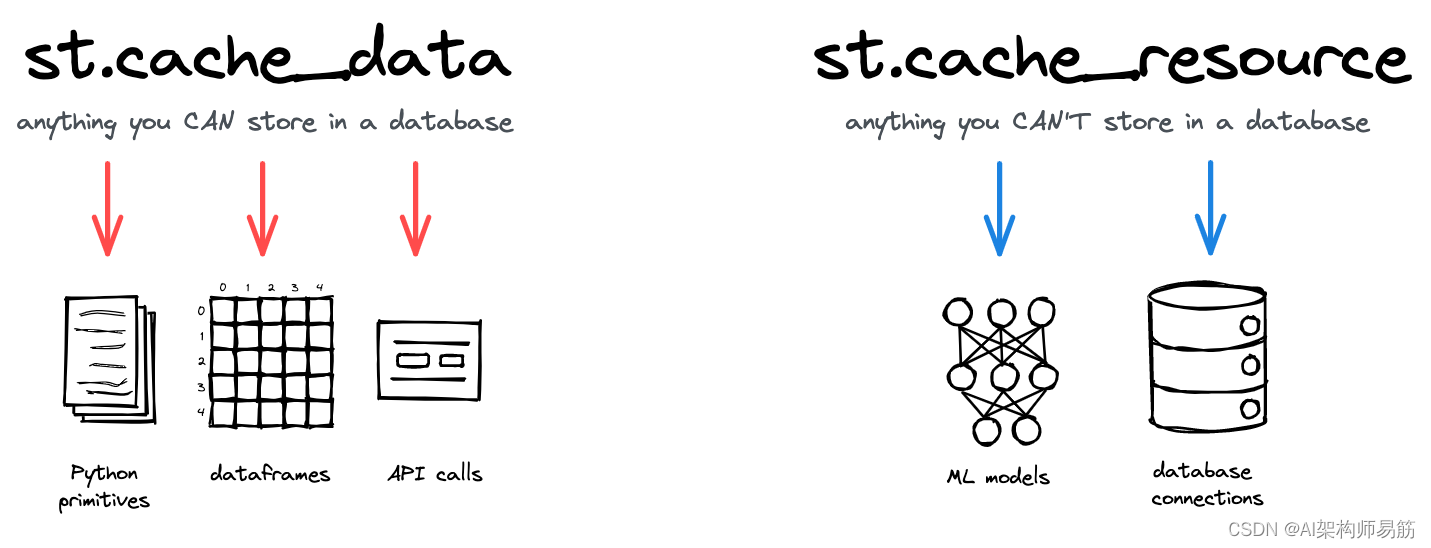

1. 两个缓存装饰器:

st.cache_data是缓存返回数据的计算的推荐方法:从CSV加载DataFrame、转换NumPy数组、查询API或任何其他返回可序列化数据对象的函数(str、int、float、DataFrame、array、list 等)。它会在每次函数调用时创建一个新的数据副本,使其免受突变和竞争条件的影响。st.cache_data的行为是您想要的——所以如果您不确定,请从st.cache_data开始,看看它是否有效!st.cache_resource是缓存全局资源(如 ML 模型或数据库连接)的推荐方法,这些资源是您不想多次加载的不可序列化对象。使用它,您可以在应用程序的所有重新运行和会话之间共享这些资源,而无需复制或复制。请注意,对缓存返回值的任何突变都会直接改变缓存中的对象(更多详细信息见下文)。

2. 基本用法

st.cache_data 是所有返回数据的函数的首选命令,无论是 DataFrames、NumPy 数组、str、int、float 还是其他可序列化类型。对于几乎所有用例来说,这都是正确的命令!

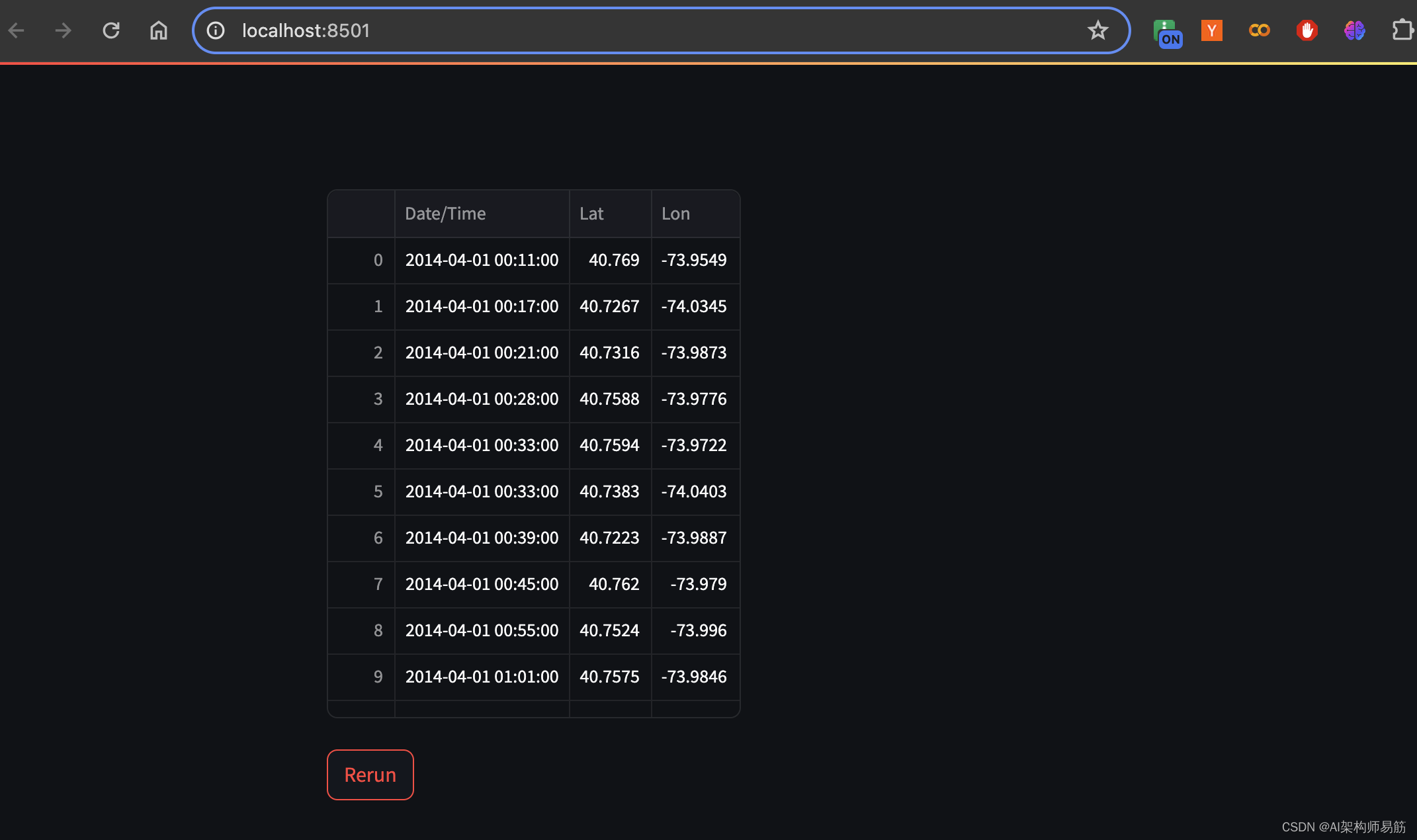

让我们看一个使用 st.cache_data 的例子。假设您的应用将优步拼车数据集(一个 50 MB 的 CSV 文件)从互联网加载到 DataFrame 中:

import streamlit as st

import time

import pandas as pd

def load_data(url):

df = pd.read_csv(url)

return df

df = load_data("https://github.com/plotly/datasets/raw/master/uber-rides-data1.csv")

st.dataframe(df)

st.button("Rerun")

运行 load_data 功能需要 2 到 30 秒,具体取决于您的互联网连接。(提示:如果您的连接速度较慢,请改用此 5 MB 数据集)。如果不进行缓存,则每次加载应用或进行用户交互时都会重新运行下载。点击我们添加的按钮自己试试吧!不是一次很棒的体验…😕

现在让我们在load_data上添加 @st.cache_data 装饰器:

import streamlit as st

import time

import pandas as pd

@st.cache_data # 👈 Add the caching decorator

def load_data(url):

df = pd.read_csv(url)

return df

df = load_data("https://github.com/plotly/datasets/raw/master/uber-rides-data1.csv")

st.dataframe(df)

st.button("Rerun")

再次运行应用。您会注意到,下载速度慢只发生在第一次运行时。随后的每次重播都应该几乎是即时的!💨

2.1 这是如何工作的?

让我们一步一步地了解st.cache_data的行为:

- 在第一次运行时,Streamlit 识别出它从未使用指定的参数值(CSV 文件的 URL)调用过 load_data 函数,因此它运行该函数并下载数据。

- 现在我们的缓存机制变得活跃:返回的 DataFrame 通过 pickle 序列化(转换为字节)并存储在缓存中(与 url 参数的值一起)。

- 在下次运行时,Streamlit 会检查缓存中是否有具有特定 url 的

load_data条目。有一个!因此,它检索缓存的对象,将其反序列化为DataFrame,然后返回它,而不是重新运行函数并再次下载数据。

序列化和反序列化缓存对象的过程会创建原始 DataFrame 的副本。虽然这种复制行为似乎没有必要,但这是我们在缓存数据对象时想要的,因为它有效地防止了突变和并发问题。请阅读下面的“突变和并发问题”部分,以更详细地了解这一点。

Warning警告

st.cache_data隐式使用pickle模块,该模块已知不安全。缓存函数返回的任何内容都会被酸洗和存储,然后在检索时取消酸洗。确保缓存的函数返回受信任的值,因为可能会构造恶意pickle数据,这些数据将在取消pickling期间执行任意代码。切勿在不安全模式下加载可能来自不受信任的来源或可能已被篡改的数据。仅加载您信任的数据。

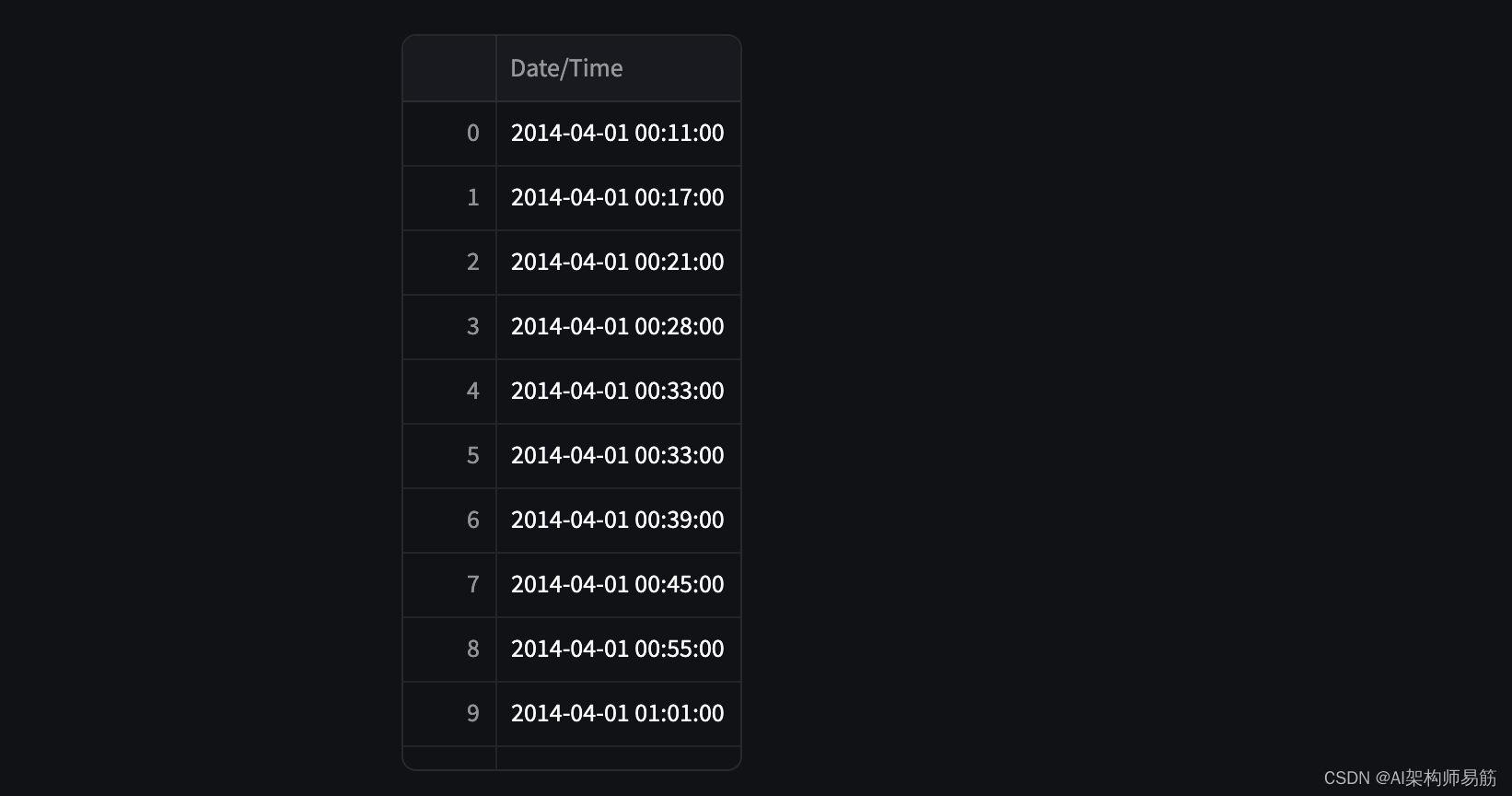

2.2 DataFrame 转换

在上面的示例中,我们已经展示了如何缓存加载 DataFrame。缓存 DataFrame 转换(如 df.filter 或 df.sort_values)也很有用。特别是对于大型 DataFrame,这些操作可能会很慢。

@st.cache_data

def transform(df):

df = df.filter(items=['Date/Time']) # 示例 1:筛选特定列

# df = df.apply(np.sum, axis=0)

return df

df = transform(df)

st.dataframe(df)

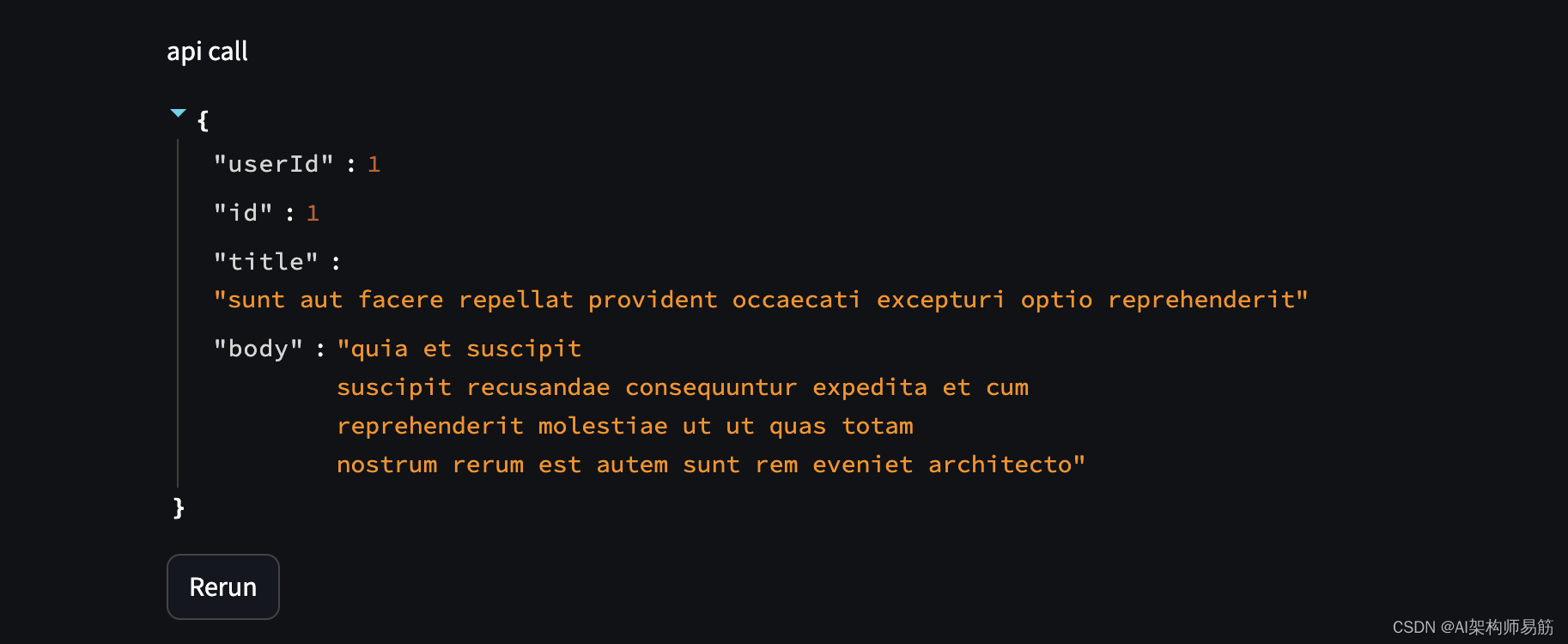

2.3 缓存 API 调用

这样做还可以避免速率限制。

@st.cache_data

def api_call():

response = requests.get('https://jsonplaceholder.typicode.com/posts/1')

return response.json()

api_response = api_call()

print("api call", api_response)

st.write("api call", api_response)

2.4 运行 ML 模型(推理)

运行复杂的机器学习模型可能会占用大量时间和内存。为避免一遍又一遍地重新运行相同的计算,请使用缓存。

@st.cache_data

def run_model(inputs):

return model(inputs)

3. st.cache_resource

st.cache_resource 是缓存“资源”的正确命令,这些资源应该在所有用户、会话和重新运行中全局可用。与st.cache_data相比,它的用例更有限,尤其是在缓存数据库连接和 ML 模型方面。

作为st.cache_resource示例,让我们看一个典型的机器学习应用。第一步,我们需要加载一个 ML 模型。我们使用 Hugging Face 的 transformers 库来做到这一点:

from transformers import pipeline

model = pipeline("sentiment-analysis") # 👈 Load the model

如果我们将此代码直接放入 Streamlit 应用程序中,则该应用程序将在每次重新运行或用户交互时加载模型。重复加载模型会带来两个问题:

- 加载模型需要时间并减慢应用程序的速度。

- 每个会话都从头开始加载模型,这会占用大量内存。

相反,加载一次模型并在所有用户和会话中使用相同的对象会更有意义。这正是st.cache_resource的用例!让我们将其添加到我们的应用程序中,并处理用户输入的一些文本:

from transformers import pipeline

@st.cache_resource # 👈 Add the caching decorator

def load_model():

return pipeline("sentiment-analysis")

model = load_model()

query = st.text_input("Your query", value="I love Streamlit! 🎈")

if query:

result = model(query)[0] # 👈 Classify the query text

st.write(result)

如果运行此应用,你将看到该应用仅调用一次 load_model - 就在应用启动时。后续运行将重用缓存中存储的相同模型,从而节省时间和内存!

3.1 Behavior行为

使用 st.cache_resource 与使用 st.cache_data 非常相似。但是在行为上有一些重要的区别:

- st.cache_resource 不会创建缓存返回值的副本,而是将对象本身存储在缓存中。函数返回值上的所有突变都会直接影响缓存中的对象,因此必须确保来自多个会话的突变不会导致问题。简而言之,返回值必须是线程安全的。(对非线程安全的对象使用 st.cache_resource 可能会导致崩溃或数据损坏。在下面的 Mutation 和并发问题中了解更多信息。)

- 不创建副本意味着缓存的返回对象只有一个全局实例,这可以节省内存,例如使用大型 ML 模型时。用计算机科学术语来说,我们创建一个单例。

- 函数的返回值不需要可序列化。此行为对于本质上不可序列化的类型非常有用,例如数据库连接、文件句柄或线程。无法使用

st.cache_data缓存这些对象。

3.2 Database connections数据库连接

st.cache_resource 对于连接数据库很有用。通常,您要创建一个连接对象,并希望在每个查询中全局重用该对象。每次运行时创建新的连接对象效率很低,并且可能会导致连接错误。这正是 st.cache_resource 可以做的事情,例如,对于 Postgres 数据库:

@st.cache_resource

def init_connection():

host = "hh-pgsql-public.ebi.ac.uk"

database = "pfmegrnargs"

user = "reader"

password = "NWDMCE5xdipIjRrp"

return psycopg2.connect(host=host, database=database, user=user, password=password)

conn = init_connection()

当然,您可以对任何其他数据库执行相同的操作。请参阅我们有关如何将 Streamlit 连接到数据库的指南以获取深入的示例。

3.3 决定使用哪个缓存装饰器

上面的部分展示了每个缓存装饰器的许多常见示例。但在某些边缘情况下,决定使用哪个缓存装饰器并不那么简单。最终,这一切都归结为“数据”和“资源”之间的区别:

- 数据是可序列化的对象(可以通过 pickle 转换为字节的对象),您可以轻松地将其保存到磁盘。想象一下您通常存储在数据库或文件系统中的所有类型 - 基本类型,如 str、int 和 float,还有数组、DataFrame、图像或这些类型的组合(列表、元组、字典等) )。

- 资源是不可序列化的对象,您通常不会将其保存到磁盘或数据库中。它们通常是更复杂的非永久性对象,例如数据库连接、ML 模型、文件句柄、线程等。

从上面列出的类型中,很明显,Python 中的大多数对象都是“数据”。这也是为什么 st.cache_data 是几乎所有用例的正确命令。st.cache_resource是一个更奇特的命令,您应该只在特定情况下使用。

代码

https://github.com/zgpeace/pets-name-langchain/tree/develop

参考

https://docs.streamlit.io/library/advanced-features/caching#basic-usage

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 怎么制作扫码看视频的二维码?扫二维码播放视频怎么做?

- 分享一个idea插件MyBatisX的Bug

- JavaScript中的this>构造函数/原型/垃圾回收机制

- AtCoder ABC194

- [ABC304F] Shift Table(莫比乌斯反演)

- 案例分享:当前高端低延迟视频类产品方案分享(内窥镜、记录仪、车载记录仪、车载环拼、车载后视镜等产品)

- vue element plus 安装

- Java实现IPV4与Long之间的转换

- 机械设计-哈工大课程学习-螺纹连接

- 竞赛保研 基于深度学习的视频多目标跟踪实现