深入了解Transformer:先进语言模型背后的两个强大引擎

Transformer模型的出现对自然语言处理(NLP)领域来说堪称革命性。在Transformer崛起之前,循环神经网络(RNNs)是处理序列数据的标准。然而,Transformer的引入在各种NLP任务中大大超越了RNN的性能,引发了模型生成能力的复兴。

上下文理解的力量

Transformer架构的真正优势在于其自注意力机制。这使得模型能够一次性处理和理解整个输入序列,而不是按顺序逐个处理。其结果是一种无与伦比的能力,能够把握语言的微妙之处,确定每个词与句子中的其他每个词的相关性,而不考虑它们的相对位置。

自注意力机制在整个输入中分配注意力权重,使模型能够辨别谁在对谁做什么,以及特定细节是否与更广泛的上下文相关。这些权重是训练过程的关键部分,如在注意力图中所示,它们在视觉上描绘了句子中词语之间关系的强度。例如,在句子“老师给学生一本书”中,一个注意力图可能突显“书”和“老师”之间以及“书”和“学生”之间的强连接,指示这些实体在与书相关的角色中所起的作用。

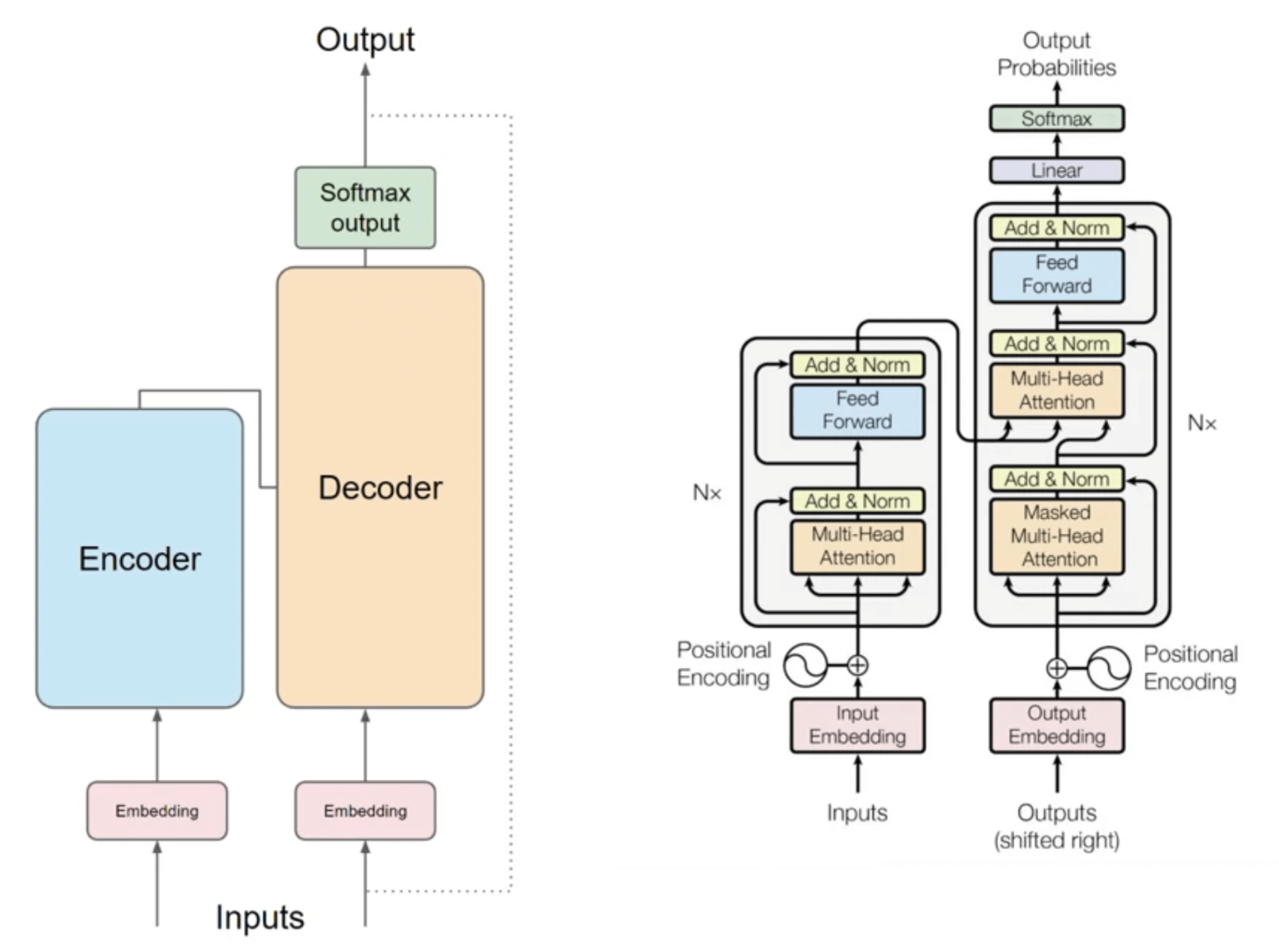

Transformer架构:编码器和解码器

Transformer模型分为两个主要组件:编码器和解码器。Transformer的每个部分都有多个层,两个部分在结构上镜像对称但具有不同的功能。

编码器

编码器的任务是处理输入序列并将其映射成一个包含关于输入的语义和句法信息的抽象连续表示。它通过以下一系列步骤实现:

分词:首先,将输入文本分解成标记。分词可以在单词级别或子词级别进行,从而实现更精细的表示,可以有效处理各种语言和词汇。

Embeddings:然后,通过embeddings将每个标记转换为数值形式,这些embeddings是编码标记含义的高维向量。Embeddings是在训练期间学习的,并且可以捕捉单词之间的语义关系。

位置编码:由于模型并行处理输入,它缺乏有关单词顺序的概念。位置编码被添加到embeddings中,以向模型提供有关序列中标记位置的信息。

自注意力:然后,编码器使用自注意力机制来衡量序列中不同标记的影响。这通过多头注意力的形式多次并行完成,允许模型捕捉语言的各个方面。

前馈网络:最后,从注意机制得到的输出通过前馈神经网络传递,以进一步完善表示。

解码器

另一方面,解码器负责根据传递给它的编码生成输出。它遵循与编码器类似的过程,但包括一个额外的掩码自注意力步骤,以确保对位置的预测只能依赖于其前面位置的已知输出。

掩码自注意力:解码器中的这一步骤防止模型在进行预测时‘窥视’到正确的输出。

交叉注意力:解码器还包括交叉注意力层,关注编码器的输出,将输入序列和部分生成的输出序列的信息结合起来。

输出生成:最后,解码器生成一系列logits,然后通过softmax函数将它们转换为概率,以预测下一个标记。

对大语言模型和生成型人工智能的影响

由于Transformer有效地编码和生成语言的能力,它已成为大语言模型(LLMs)如GPT-3及其后继者的基础。这些模型能够生成连贯的文本,进行语言间翻译,总结内容,回答问题,甚至编写代码。

在生成型人工智能领域,Transformer使得以前难以实现的流畅和连贯的内容创作成为可能。它们在创作艺术作品、设计新颖的蛋白质序列,甚至为训练其他人工智能模型生成合成数据等方面发挥了作用。

结论

Transformer已经从根本上改变了机器理解和生成人类语言的方式。凭借学习语言的复杂模式和生成能够 resonates 与人类读者的文本的能力,Transformer在人工智能领域树立了新的标准。随着我们不断完善和扩展Transformer模型,它们的潜在应用似乎是无限的,为未来带来更复杂的人工智能工具和系统。

参考文献

[1] https://www.aigcfuturelab.com/2024/01/12/deep-dive-into-transformer-model-the-transformative-engine-behind-advanced-language-models/

更多精彩内容,请关注公众号:AI生成未来

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!