Switch Transformers 的模型架构

发布时间:2023年12月20日

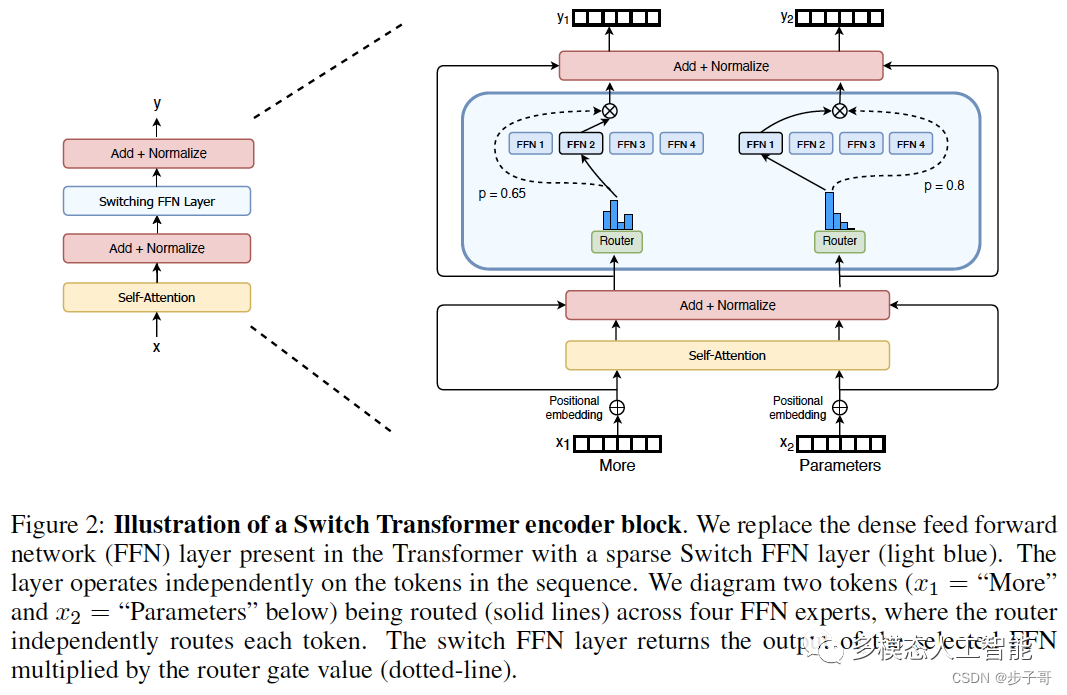

Switch Transformers 的模型架构主要由以下几个部分组成:

-

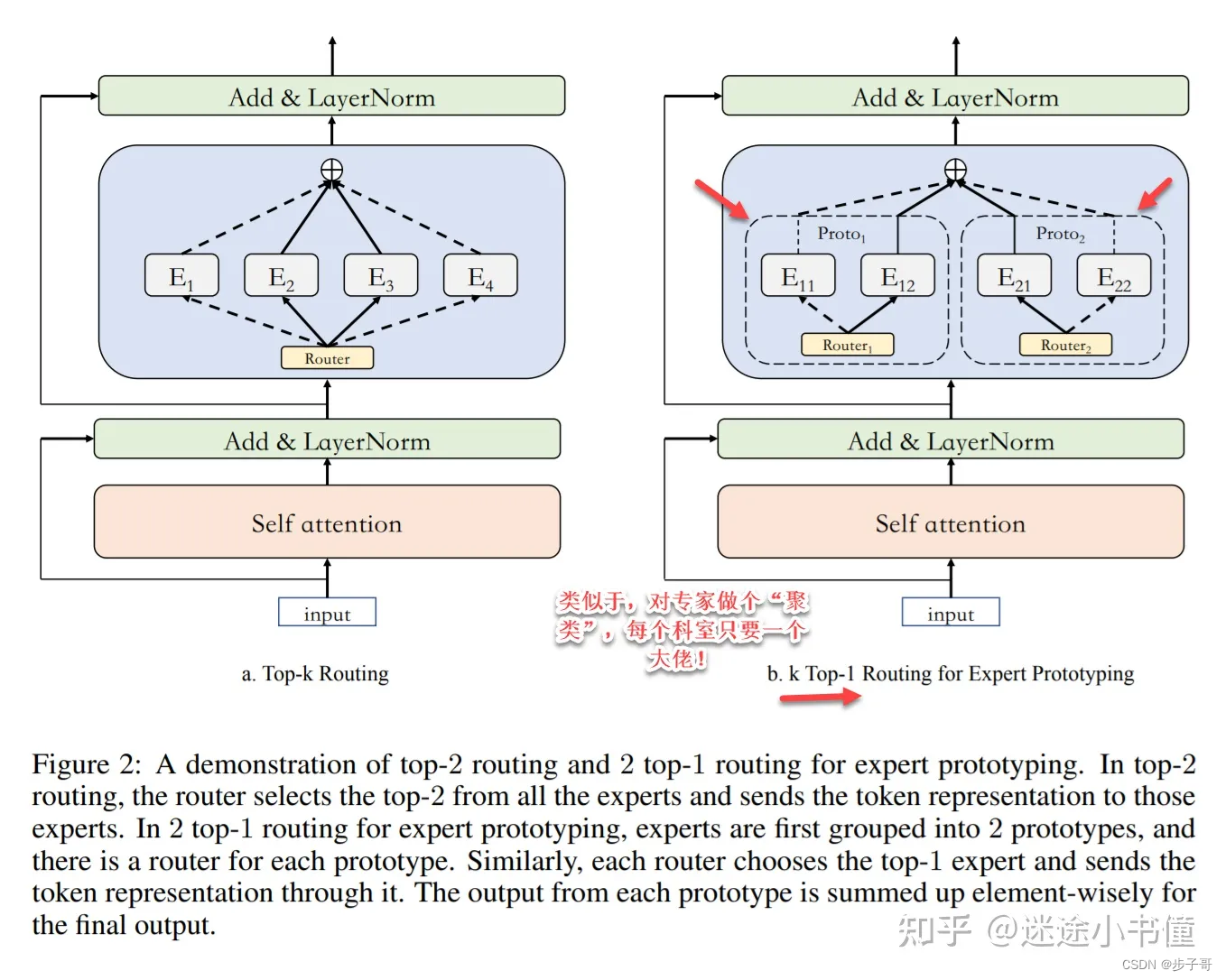

**专家:**Switch Transformers 由多个专家组成,每个专家都具有独立的参数。专家的数量可以根据需要进行调整。

-

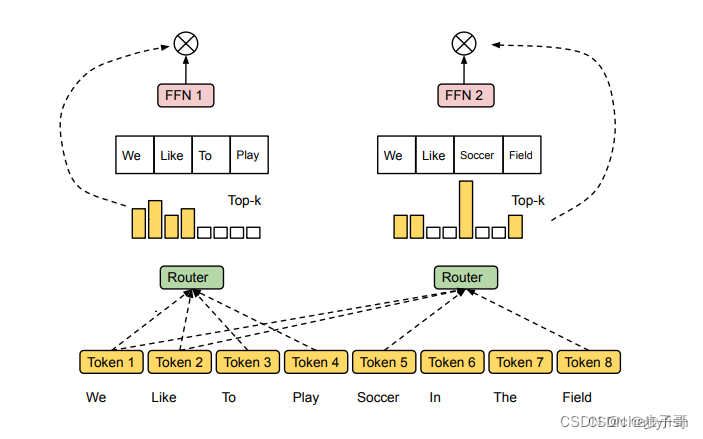

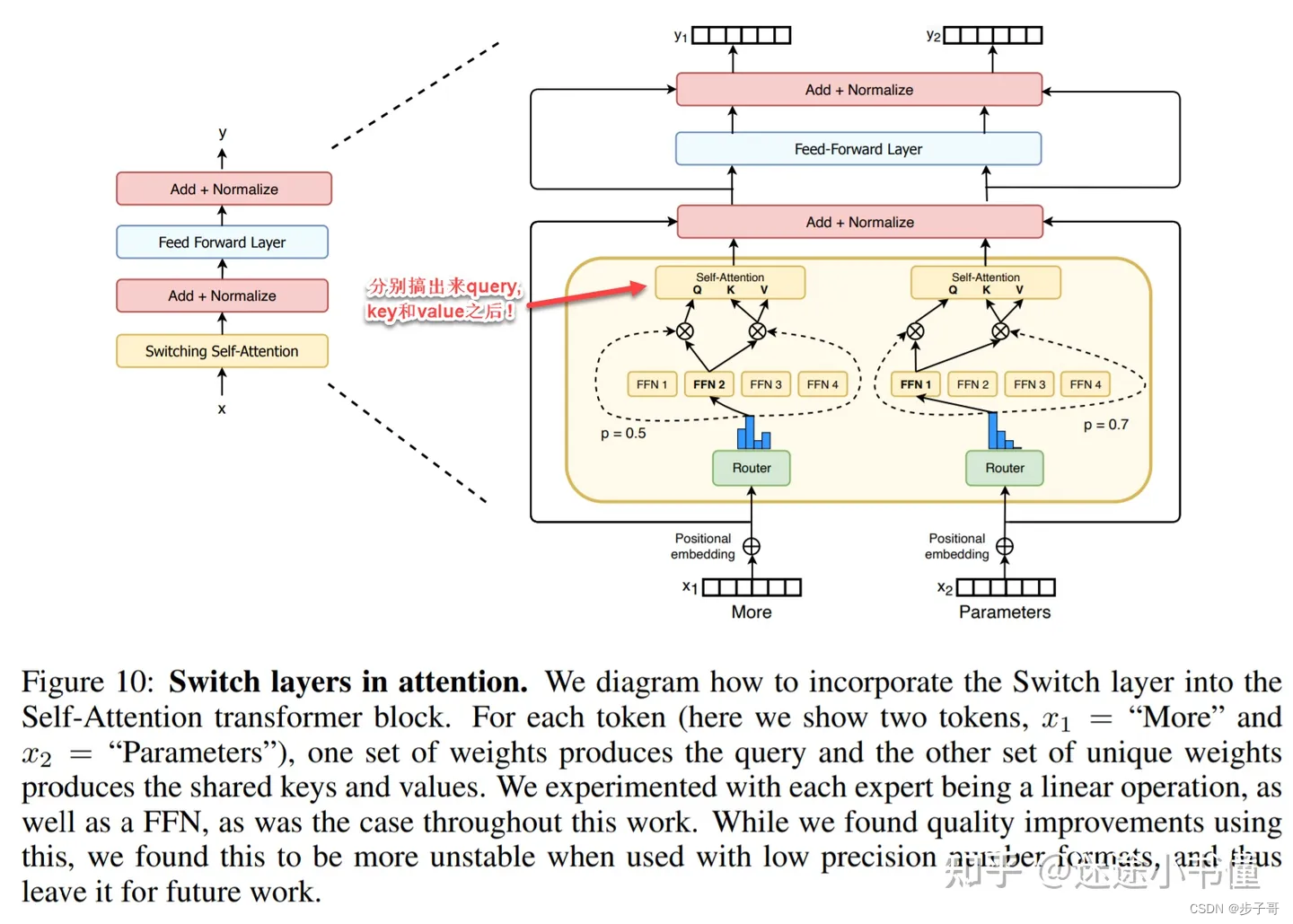

**路由器:**路由器负责根据输入选择合适的专家。路由器可以是简单的门控网络,也可以是更复杂的模型。

-

**注意力模块:**注意力模块用于处理输入和专家参数之间的交互。注意力模块可以是标准的 Transformer 注意力模块,也可以是其他改进后的注意力模块。

Switch Transformers 的模型架构可以概括为以下流程:

- 输入首先会被送到路由器。

- 路由器会根据输入选择合适的专家。

- 选择的专家会处理输入。

- 专家的输出会通过注意力模块与输入进行交互。

- 注意力模块的输出会作为模型的最终输出。

Switch Transformers 的模型架构具有以下几个优点:

- **参数规模可扩展:**Switch Transformers 可以通过增加专家的数量来扩展参数规模。

- **计算效率高:**由于 MoE 的稀疏性技术,Switch Transformers 在实际运算中只会使用与当前输入相关的专家,因此计算效率不会随着参数数量的增加而大幅下降。

- **可并行化:**MoE 技术易于并行化,Switch Transformers 可以更好地利用分布式计算资源。

Switch Transformers 代表了 Transformer 模型发展的一个重要方向,它通过引入稀疏性和 MoE 技术,为提升模型性能和可扩展性提供了新的可能性。

文章来源:https://blog.csdn.net/weixin_36829761/article/details/135066828

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 1215. 小朋友排队(权值树状数组求逆序数)

- PostgreSQL荣获DB-Engines 2023年度数据库

- R语言【base】——apply():在数组边距上应用函数

- 【已确认ISSN号 | JPCS独立出版 | 预计快至3个月EI检索 | 浙江大学、同济大学、西安交通大学支持举办】2024年电气技术与自动化工程国际学术会议 (ETAE 2024)

- 华为设备命令最全大合集(2024新版),赶紧收藏!

- 神经网络:数据预处理知识点

- tcp/ip实现两个手机之间连接同步显示

- XPath语法,爬虫必备技能

- [云原生] Docker 入门指南:镜像、容器、卷和网络解析

- 【Lidar】Open3D点云K-Means聚类算法:基于距离的点云聚类(单木分割)附Python代码