ffmpeg编解码——数据包(packet)概念(如何正确处理数据包中的显示时间戳pts与解码时间戳dts关系?)

文章目录

FFmpeg编解码——数据包(Packet)概念

FFmpeg是一个完全开源的音视频编解码库,它不仅包含了众多的音视频编解码算法,而且还提供了用于音视频处理的工具。本文将主要介绍FFmpeg中关于数据包(Packet)的相关概念和应用。

1. 数据包(Packet)简介

在FFmpeg中,数据包(Packet)是存储压缩编码数据的基本单位。数据包可以包含一个或多个编码帧的数据(也存在多个数据包包含一个编码帧的不同片段的情况)。在音频编码中,通常一个数据包只包含一帧数据;但在视频编码中,由于B帧和P帧的存在,可能会出现一个数据包包含多帧数据的情况。

typedef struct AVPacket {

AVBufferRef *buf;

int64_t pts;

int64_t dts;

uint8_t *data;

int size;

int stream_index;

int flags;

AVPacketSideData *side_data;

int side_data_elems;

} AVPacket;

AVPacket是FFmpeg中定义的数据包结构,其主要字段包括:

buf:指向数据包内存的引用。pts和dts:分别代表显示时间戳和解码时间戳。data和size:指向数据包的数据和大小。stream_index:该数据包属于哪个流。flags:标志位,如关键帧等。side_data和side_data_elems:存储额外的数据和元素数量。

2. 数据包(Packet)在FFmpeg中的应用

数据包在FFmpeg编解码过程中扮演着至关重要的角色。以下是其主要应用:

2.1 从媒体文件读取数据包

在使用FFmpeg从媒体文件读取数据时,我们需要先打开文件,然后循环调用av_read_frame()函数来读取数据包。以下是相关代码:

AVFormatContext *pFormatCtx = avformat_alloc_context();

if(avformat_open_input(&pFormatCtx, filepath, NULL, NULL) != 0){

printf("Couldn't open input stream.\n");

return -1;

}

AVPacket packet;

while(av_read_frame(pFormatCtx, &packet)>=0){

// do something with packet

}

2.2 向媒体文件写入数据包

向媒体文件写入数据也是通过数据包实现的。具体操作是创建一个数据包,然后将编码后的数据填充到数据包中,最后调用av_interleaved_write_frame()或av_write_frame()函数将数据包写入媒体文件。

AVFormatContext *pFormatCtx = NULL;

avformat_alloc_output_context2(&pFormatCtx, NULL, NULL, outfile);

// ...

AVPacket pkt;

av_new_packet(&pkt,data_size);

memcpy(pkt.data,framebuf,data_size);

pkt.stream_index = video_st->index;

ret = av_interleaved_write_frame(pFormatCtx, &pkt);

3. 数据包(Packet)相关问题与解决方案

在实际使用中,可能会遇到一些关于数据包的问题。以下是一些常见问题及其解决方案:

3.1 数据包内存管理

FFmpeg在处理数据包时,会自动分配和释放内存。为了防止内存泄露,我们需要在每次处理完一个数据包后,调用av_packet_unref()函数来释放数据包所占用的内存。

AVPacket pkt;

while(av_read_frame(pFormatCtx, &pkt)>=0){

// do something with packet

av_packet_unref(&pkt);

}

3.2 时间戳处理

在处理音视频同步等问题时,需要正确处理数据包中的pts和dts时间戳。FFmpeg提供了av_packet_rescale_ts()函数,可以用来将数据包中的时间戳从一个时间基准转换到另一个时间基准。

AVPacket pkt;

// ...

av_packet_rescale_ts(&pkt, in_time_base, out_time_base);

4. 如何正确处理数据包中的pts(显示时间戳:Presentation Time Stamp)、dts(解码时间戳:Decoding Time Stamp)关系?

在使用FFmpeg进行音视频编解码时,我们会遇到两个重要的概念:PTS(Presentation Time Stamp)和DTS(Decoding Time Stamp)。这两者都是时间戳,但用途不同。正确理解和处理它们对于实现流畅的播放和准确的音视频同步至关重要。

1. PTS与DTS简介

1.1 PTS (Presentation Time Stamp)

PTS指的是“显示时间戳”,表示何时应该将帧显示出来。也就是说,当媒体播放器读取一个带有PTS的数据包时,它会等待直到PTS指定的时间,然后再显示这一帧。

1.2 DTS (Decoding Time Stamp)

DTS指的是“解码时间戳”,表示何时应该开始解码这一帧。由于B-frames可能依赖于后续的帧,所以需要先解码后续的帧,因此DTS可能较原来稍大(要等待其参考帧解码后,它才能解码)。

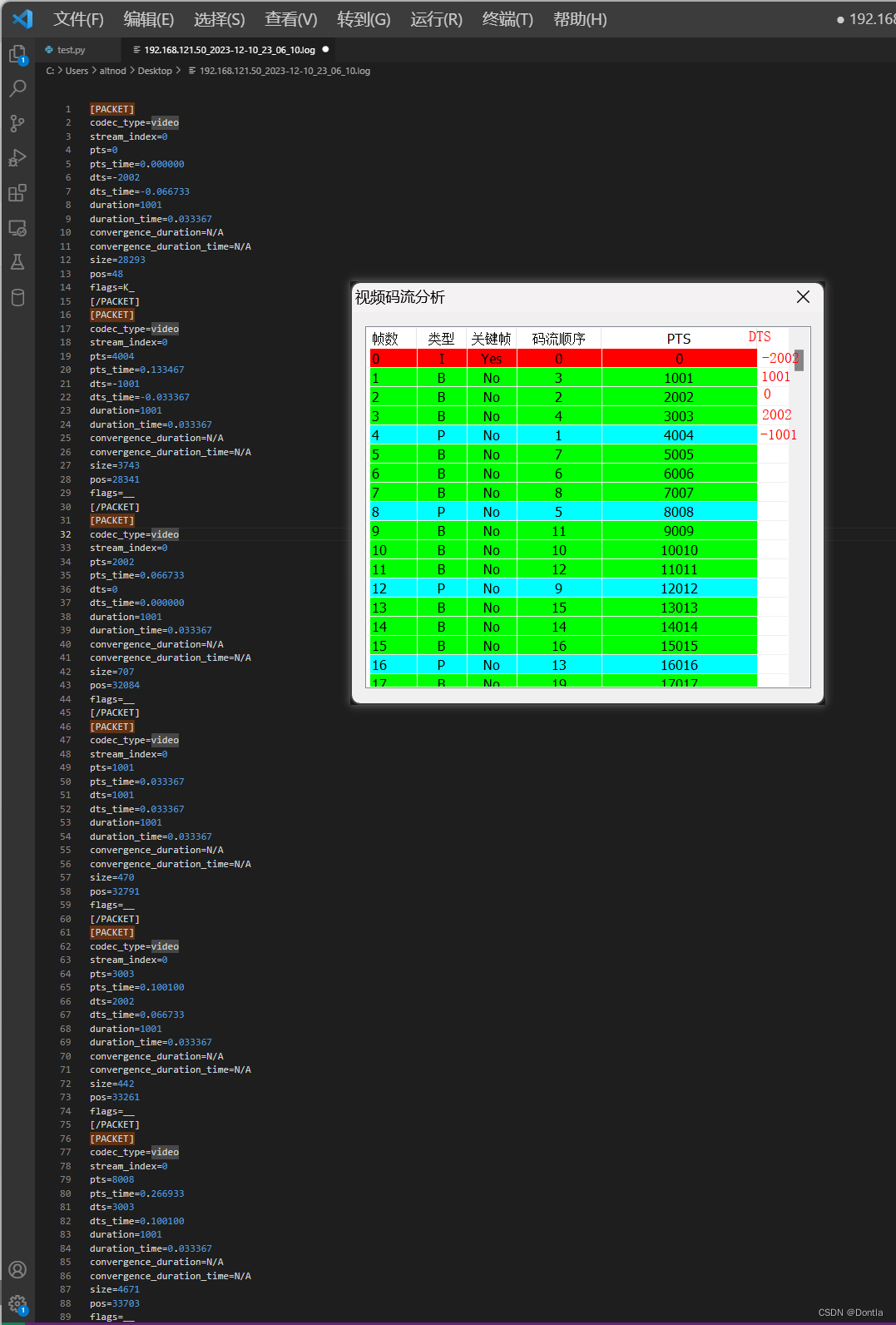

20231210:经过我的初步观察,ffprobe -show_packets xxx显示packets顺序为解码顺序,不是显示顺序,显示顺序是乱的。要看显示顺序,直接看每个packet的pts,由小到大就是显示顺序。

2. PTS与DTS的关系

在没有B-frames的情况下,每一帧的PTS和DTS是相同的,因为解码顺序和显示顺序是相同的。然而,如果存在B-frames,那么解码顺序和显示顺序就可能不同,因此PTS和DTS也可能不同。

对于B-frames,其PTS通常大于前一帧的PTS,但DTS可能小于前一帧的DTS。这是因为B-frames需要依赖其后面的帧来解码,因此需要先解码后面的帧。

如图,第二个B帧,其解码时间戳(0)比第一个B帧的解码时间戳(1001)还要题前:

3. 如何处理PTS和DTS

当从文件中读取数据包时,我们需要确保正确地处理PTS和DTS。下面是一个例子:

AVPacket packet;

while (av_read_frame(format_context, &packet) >= 0) {

// Convert the timestamps from the packet's time_base to the stream's time_base.

packet.pts = av_rescale_q(packet.pts, format_context->streams[packet.stream_index]->time_base, stream->time_base);

packet.dts = av_rescale_q(packet.dts, format_context->streams[packet.stream_index]->time_base, stream->time_base);

// Do something with the packet...

}

在这个例子中,av_rescale_q()函数用于将时间戳从一个时间基准转换到另一个时间基准。这是必要的,因为不同的流可能有不同的时间基准。

另外,在写入数据包到文件时,也需要确保正确地设置PTS和DTS。否则,播放器可能无法正确地播放生成的文件。下面是一个例子:

AVPacket packet;

// Fill the packet...

// Set the PTS and DTS.

packet.pts = next_pts++;

packet.dts = next_dts++;

// Write the packet.

if (av_interleaved_write_frame(format_context, &packet) < 0) {

// Handle the error...

}

在这个例子中,next_pts和next_dts变量用于存储下一个PTS和DTS。每写入一个数据包,就将它们增加1。

总的来说,正确处理PTS和DTS是音视频编解码中非常重要的一步,它可以保证我们得到的结果文件能够被正确地播放。

5. 相关疑问

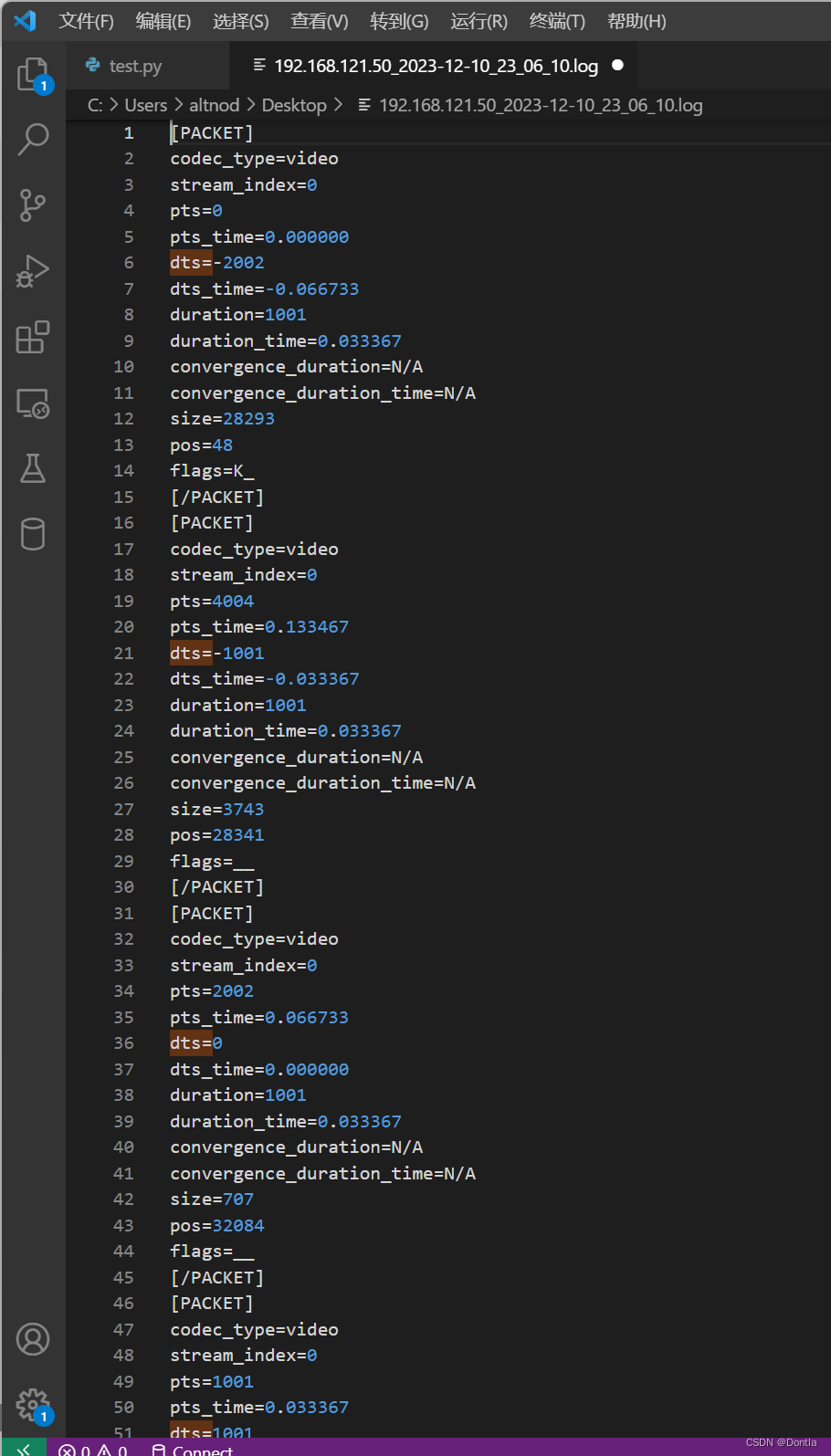

为什么我视频的第一帧I帧的PTS与DTS不一样,PTS为0,DTS为-2002?

解释:

在一些情况下,视频的第一帧(I帧)的PTS(Presentation Time Stamp,显示时间戳)和DTS(Decoding Time Stamp,解码时间戳)可能不同。这主要是由于视频编码中的时间基准设置。

通常情况下,我们期望视频的第一帧I帧的PTS和DTS都为0,因为它是视频播放的起点。然而,在某些视频流中,可能会出现I帧的DTS小于PTS的情况,这主要是为了容纳后续可能出现的B帧。如你所提到的例子,DTS为-2002,这意味着解码器需要在实际播放前提前开始解码。

但这种情况在播放时并不会影响正常观看,因为播放设备会根据PTS进行正确的帧显示。当然,如果你需要对视频进行进一步处理(比如编辑或转码等),那么可能就需要调整时间戳以确保它们从0开始。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【Java数据结构】期末复习-考点大纲,所用资料

- Python3 数字(Number)

- Hive - Select 使用 in 限制范围

- linux-6.0 内核存储栈全景图

- LintCode 980 · Basic Calculator II (计算器,栈好题)

- Gradlew安装配置和使用

- H6201L 150V降压芯片 48V 60V 72V 90V 100V 120V降33V 12V 5V 控制器

- Java进阶之旅第七天

- 「简明教程」轻松掌握 MongDB 流式聚合操作

- ROS仿真R2机器人之安装运行及MoveIt的介绍