使用Prometheus+Alertmanage+Cloud Alert 实现电话告警

发布时间:2024年01月08日

先决条件

1.先决条件Prometheus部署完成,

2.AlertManager部署完成

3.不知道咋部署的参见(Prometheus-Alertmanage钉钉实现告警-CSDN博客)

进入正题

注册ca账号

进入告警首页配置相关配置项

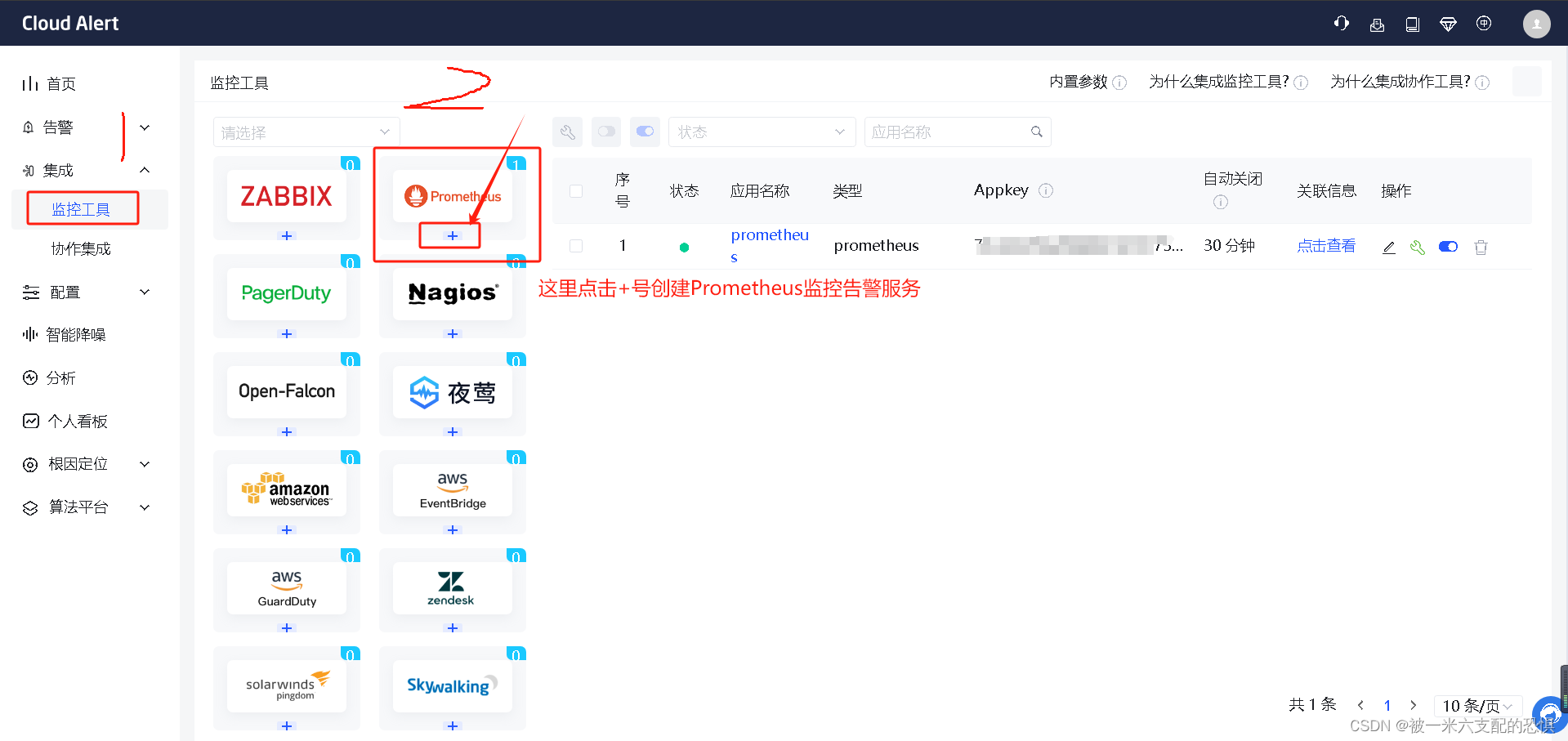

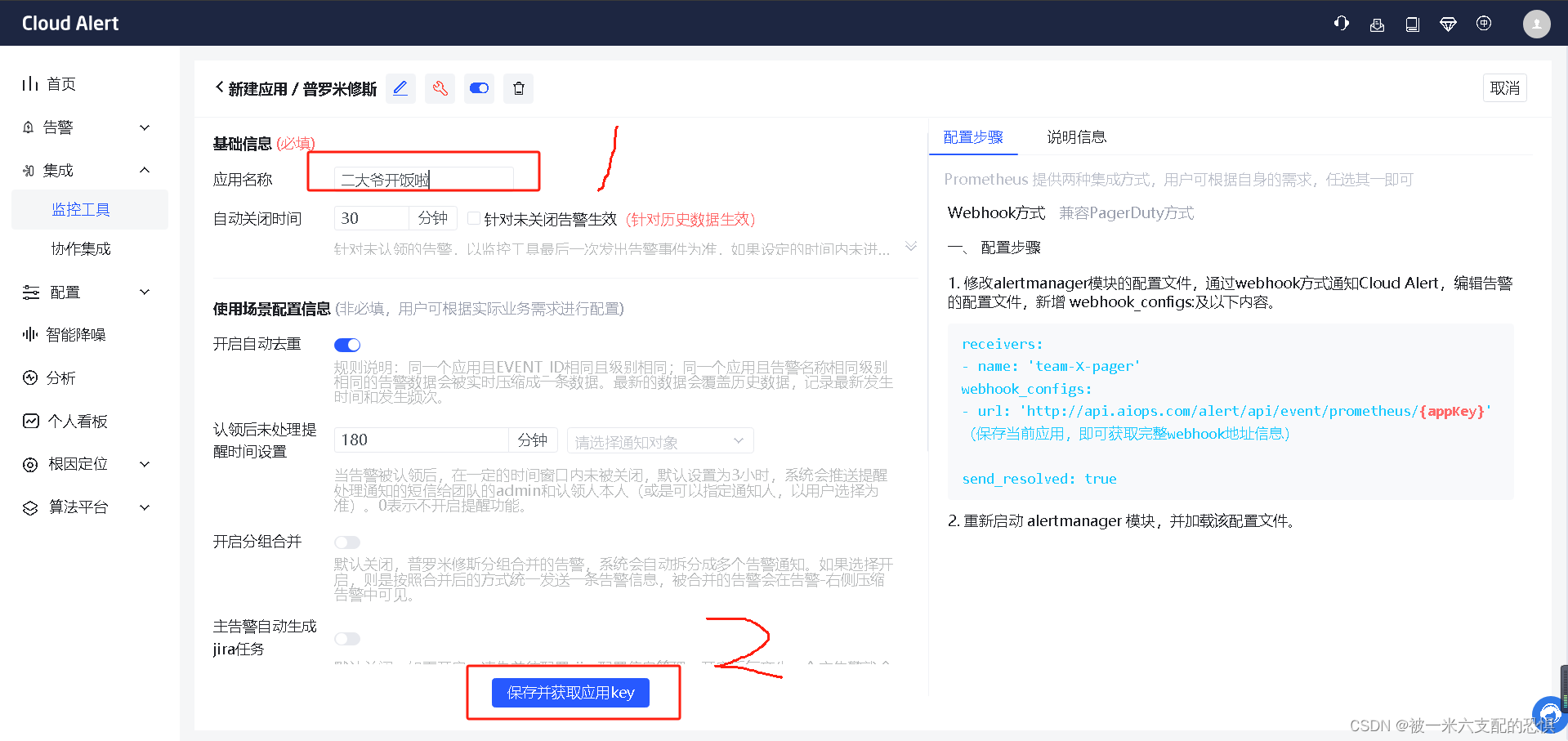

配置Prometheus报警使用的触发器(就是一个网站的token)

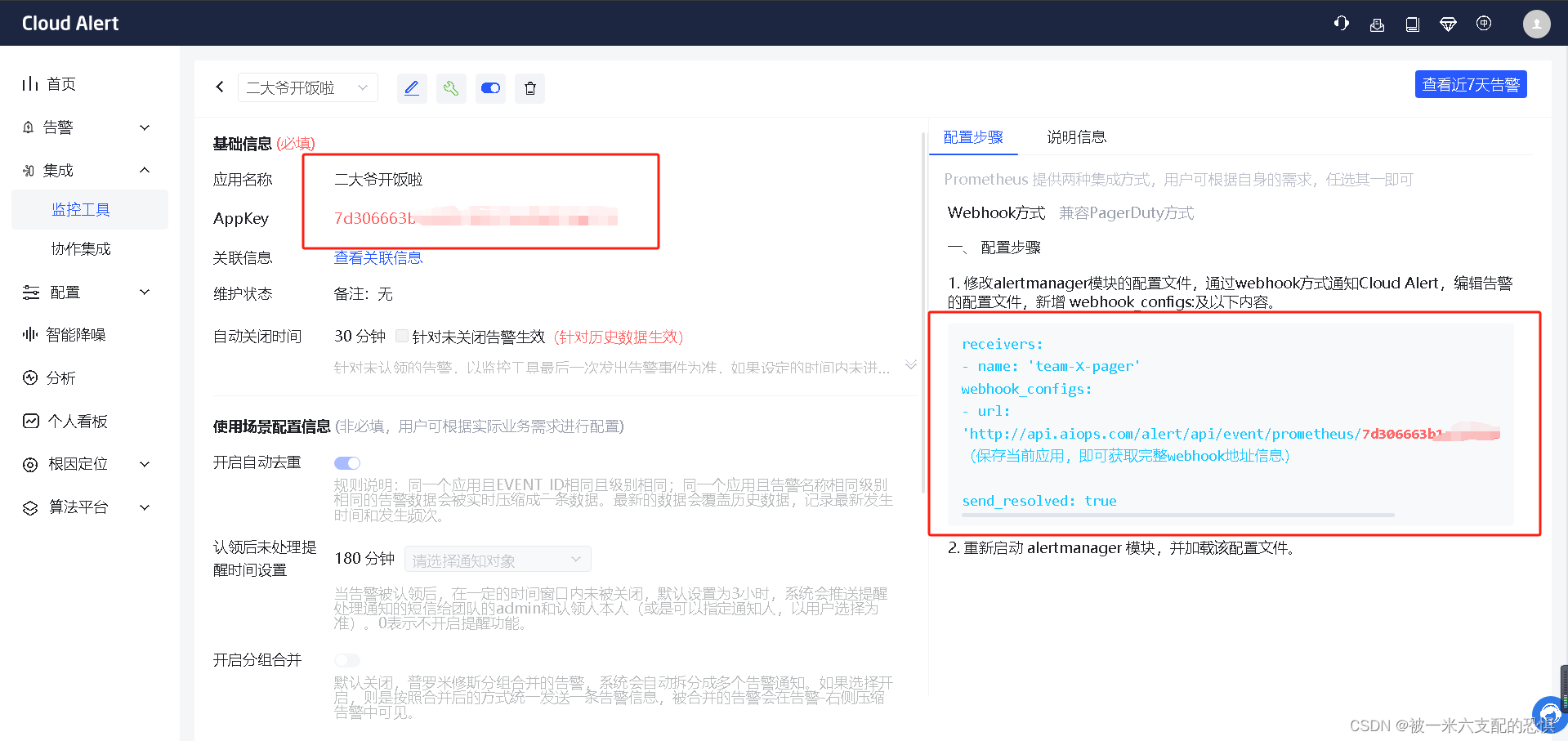

确认并保存生成的token信息

这里说明下,生成的token用于配置Alertmanager的告警配置文件.

将配置配置我呢间中的内容粘贴到Alertmanager-config文件中.

配置Alertmanage告警配置信息

这里注意下复制后的格式和缩进,容易出现yaml错误的情况

[root@node1-prome /zpf/k8s/prometheus/docker-prometheus/alertmanager]$cat config.yml

global:

#163服务器

smtp_smarthost: 'smtp.qq.com:465'

#发邮件的邮箱

smtp_from: '348264747@qq.com'

#发邮件的邮箱用户名,也就是你的邮箱

smtp_auth_username: '348264747@qq.com'

#发邮件的邮箱密码

smtp_auth_password: 'swxuighfghijbiea'

#进行tls验证

smtp_require_tls: false

route:

group_by: ['warn']

# 当收到告警的时候,等待group_wait配置的时间,看是否还有告警,如果有就一起发出去

group_wait: 10s

# 如果上次告警信息发送成功,此时又来了一个新的告警数据,则需要等待group_interval配置的时间才可以发送出去

group_interval: 10s

# 如果上次告警信息发送成功,且问题没有解决,则等待 repeat_interval配置的时间再次发送告警数据

repeat_interval: 10m

# 全局报警组,这个参数是必选的

receiver: 'ca' #这里是匹配告警触发器.要与下面的触发器名称保持一致

receivers:

- name: 'ca'

webhook_configs:

- url: 'http://api.aiops.com/alert/api/event/prometheus/78c652256xxxxxx'

send_resolved: true

inhibit_rules:

- source_match:

severity: 'critical'

target_match:

severity: 'warning'

equal: ['alertname', 'dev', 'instance']

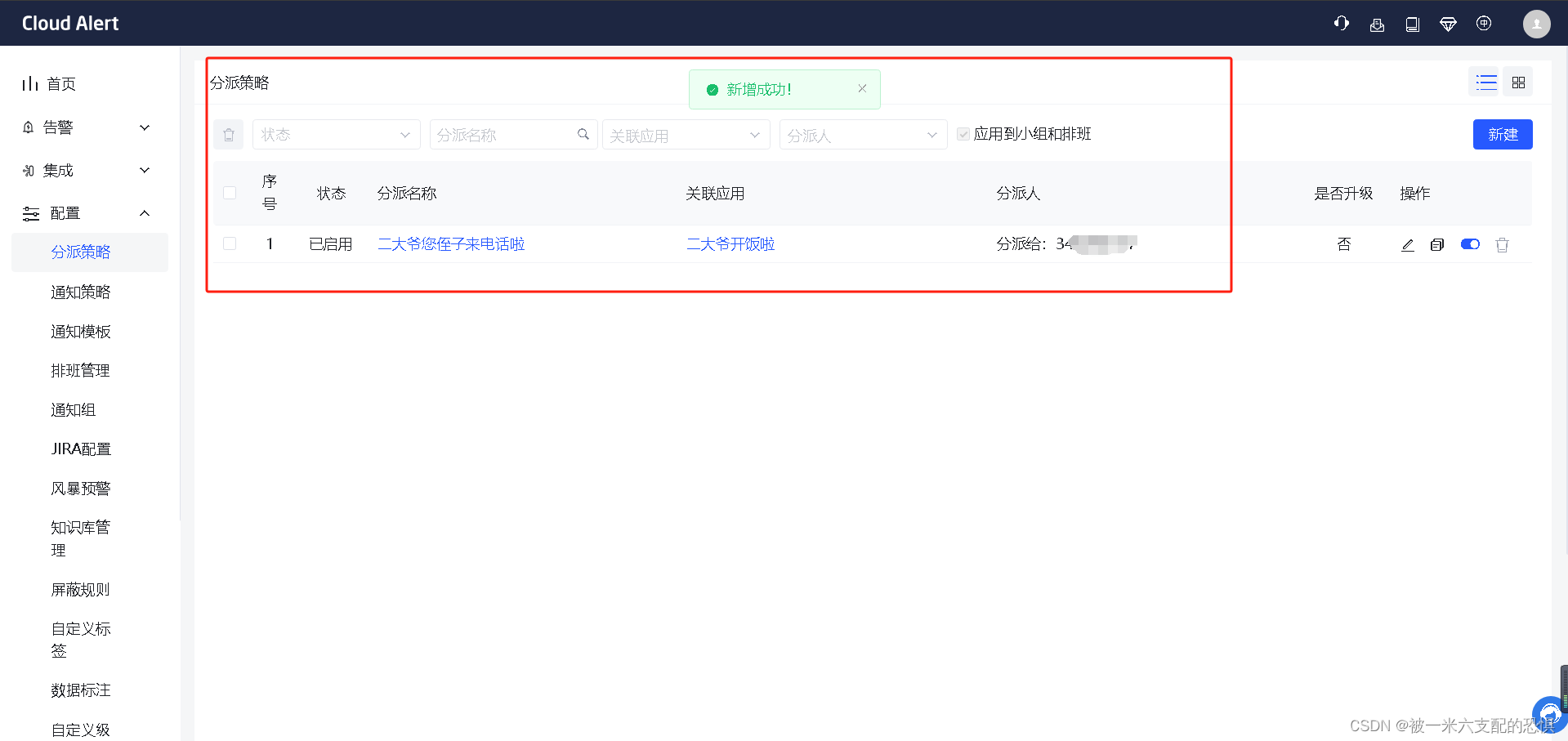

配置ca平台告警分配策略

检查创建结果

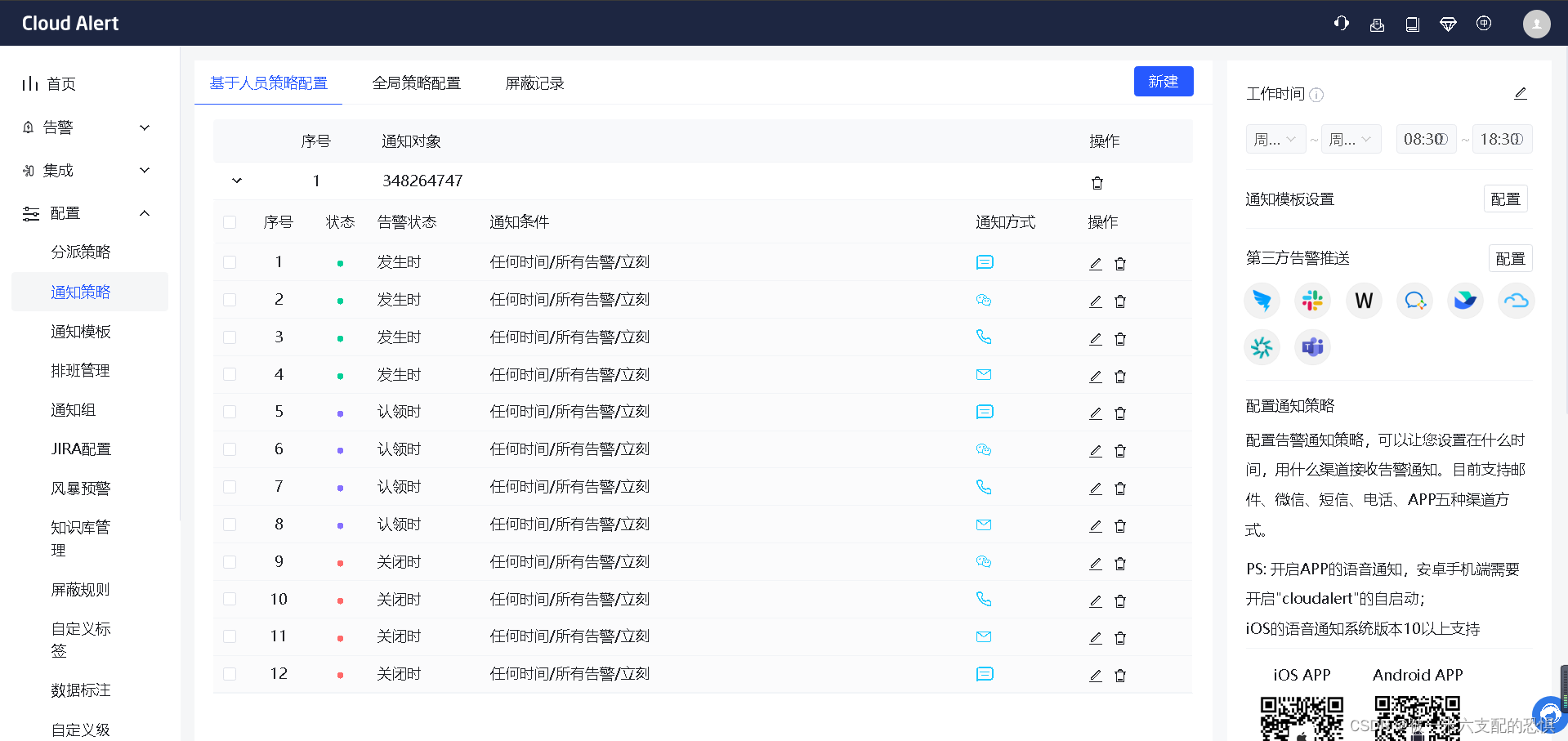

创建告警通知策略

检查通知策略

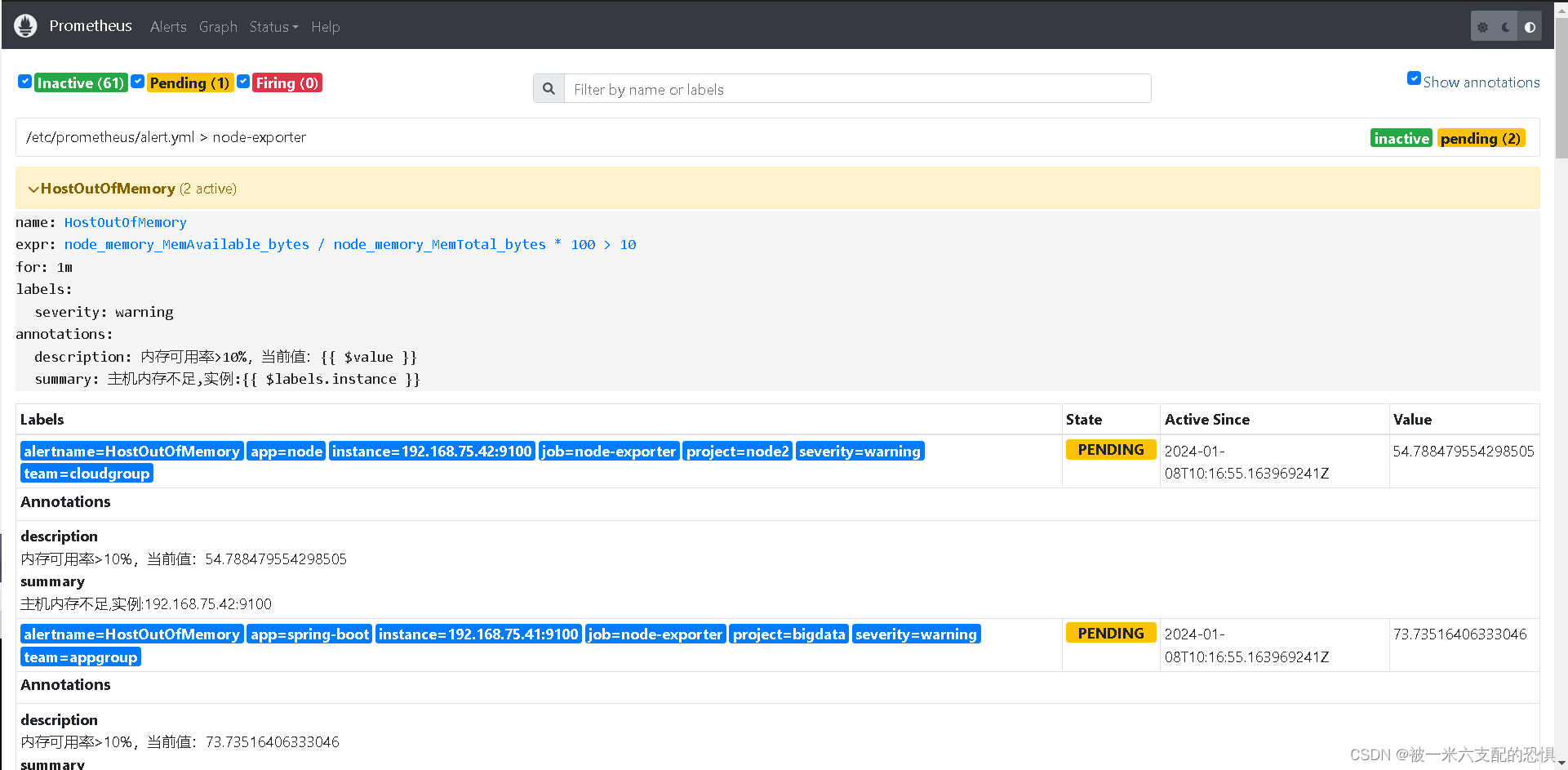

修改监控配置(这里是为了测试报警是否成功)

groups:

- name: node-exporter

rules:

- alert: HostOutOfMemory

expr: node_memory_MemAvailable_bytes / node_memory_MemTotal_bytes * 100 < 10

# expr: node_memory_MemAvailable_bytes / node_memory_MemTotal_bytes * 100 > 10

for: 1m

labels:

severity: warning

annotations:

summary: "主机内存不足,实例:{{ $labels.instance }}"

description: "内存可用率<10%,当前值:{{ $value }}"

# description: "内存可用率>10%,当前值:{{ $value }}"

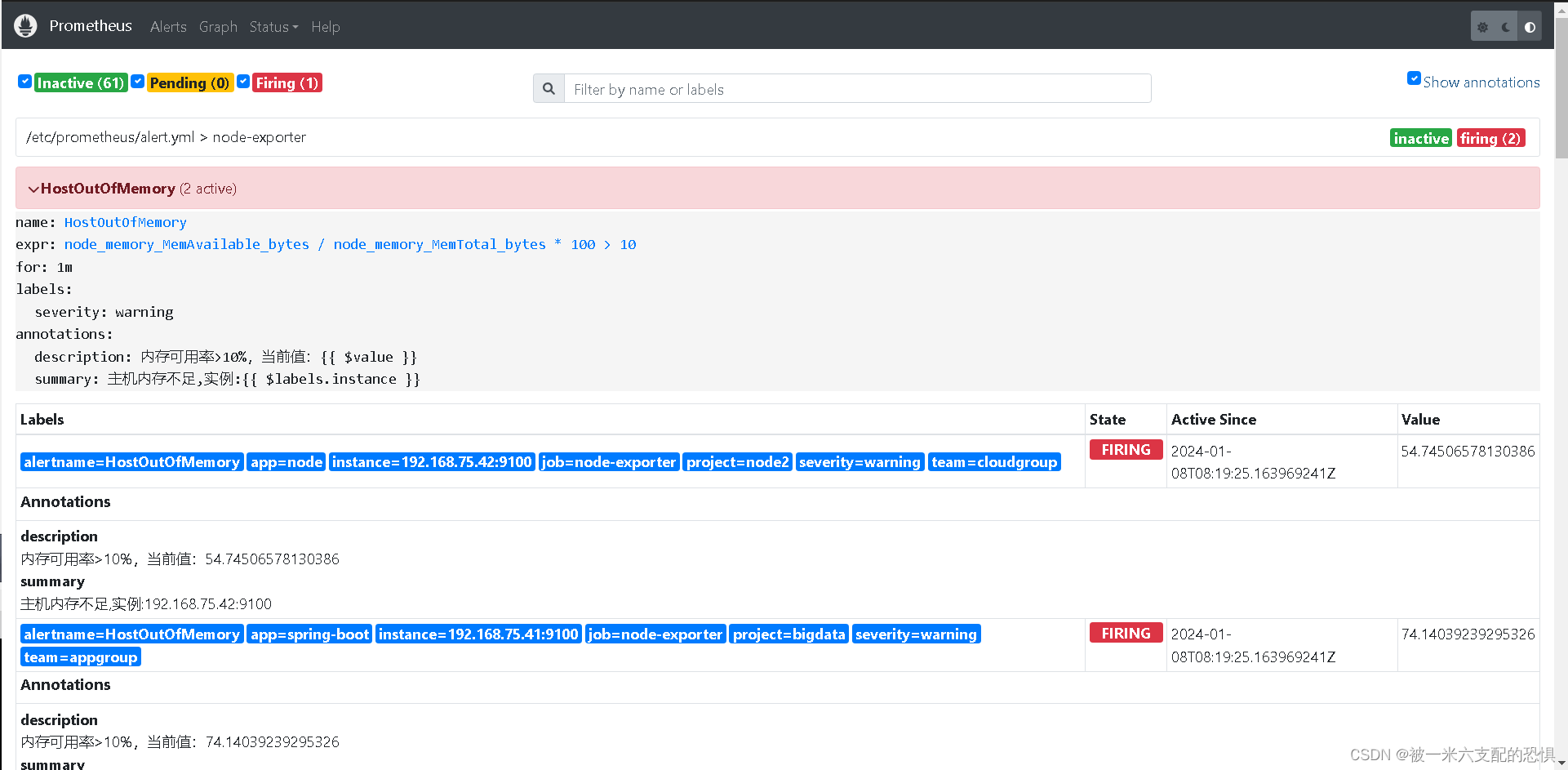

这里将原来的正确告警修改成了错误的.就会出发报警服务.重启Alertmanage+Prometheus

#重启Prometheus

$curl -X POST http://localhost:9090/-/reload

#重启Alertmanage

$curl -X POST http://localhost:9093/-/reload验证告警触发结果

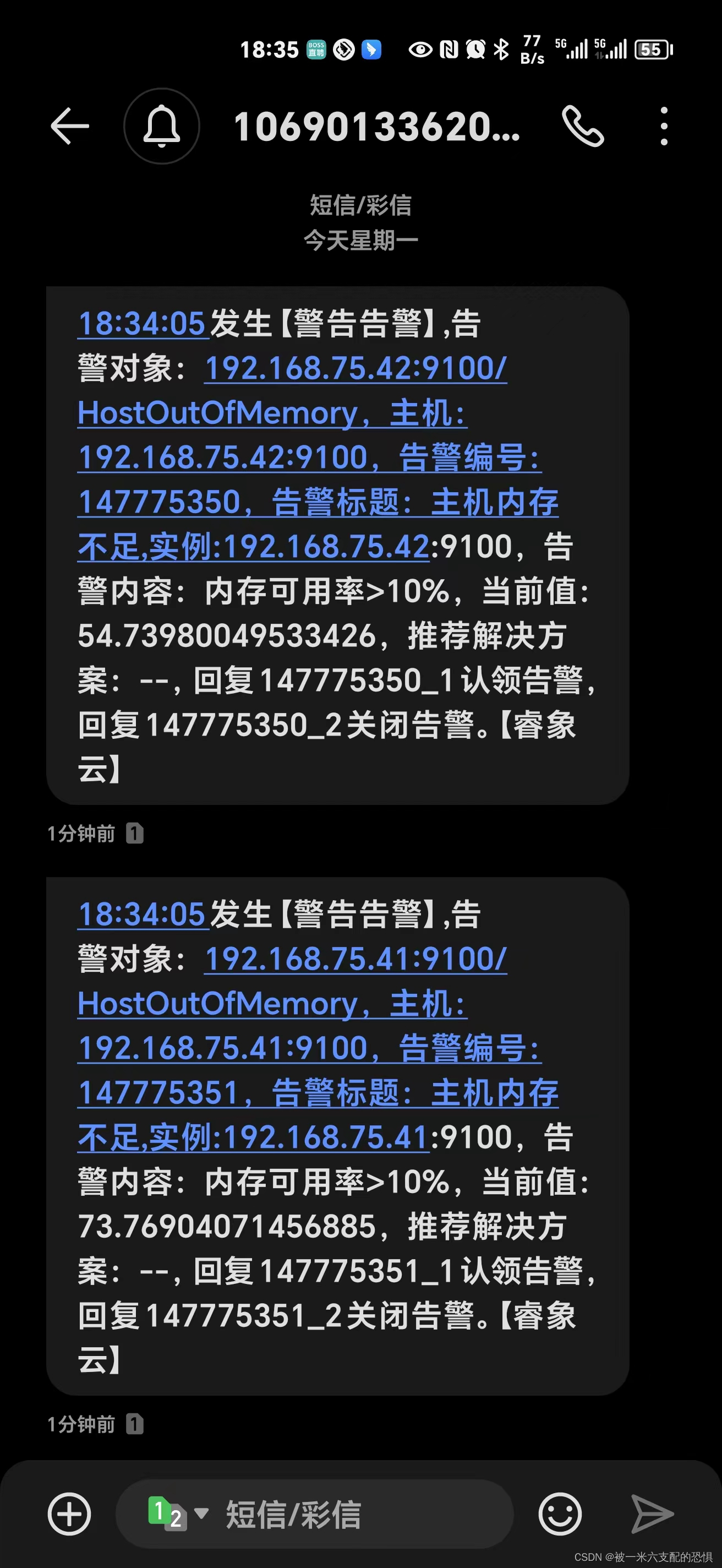

接下来就是最终验证.查看告警是否成功.

Prometheus提示告警.

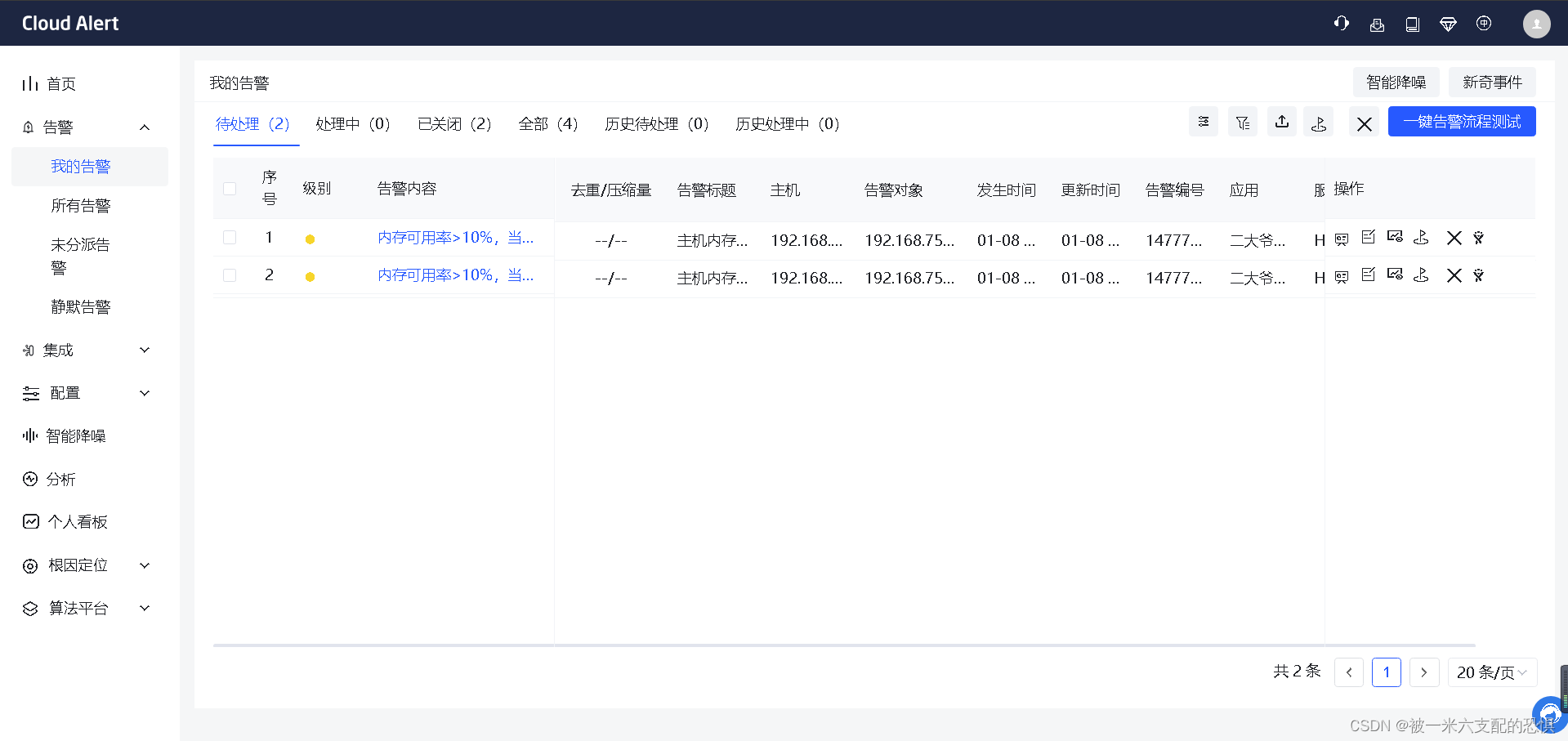

在Cloud ALert上查查看告警情况

手机接收到报警电话

告警发送成功.

完结撒花

文章来源:https://blog.csdn.net/crontab_e/article/details/135460861

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 御云出海记 | 引领泰国数字化基础设施,共推AI应用未来

- python socket编程9 - PyQt6界面实现UDP server/client 多客户端通讯的例子

- Angular管道中处理异步数据

- 服务器使用中容易遇见的问题和处理方法

- PO 发布SAP SProxy->外围系统 WebService

- JC/T 2080-2011 木铝复合门窗检测

- 论文学习记录之SeisInvNet(Deep-Learning Inversion of Seismic Data)

- 希尔排序:排序算法中的调优大师

- 【c++设计模式01】前言1:UML 类图

- 最好用的Redis客户端:RedisInsight安装部署教程, 官方亲儿子真香, 2种安装方式(包含Docker方式), 超详细教程