简单了解【多智能体强化学习(MARL)】

我们的现实生活中有着许多多智能体共同决策的场景,比如多机械臂协同,多个无人机或多个机器人完成某共同目标。下面介绍单智能体强化学习的进化,多智能体强化学习。

含义

多智能体系统中包含 m 个智能体,智能体共享环境,智能体之间会相互影响。一个智能体的动作会改变环境状态,从而影响其余所有智能体。举个例子,股市中的每个自动交易程序就可以看做一个智能体。尽管智能体(自动交易程序)之间不会交流,它们依然会相互影响:一个交易程序的决策会影响股价,从而对其它自动交易程序有利或有害。

多智能体强化学习 (Multi-Agent Reinforcement Learning,MARL) 是指让多个智能体处于相同的环境中,每个智能体独立与环境交互,利用环境反馈的奖励改进自己的策略,以获得更高的回报(即累计奖励)。在多智能体系统中,一个智能体的策略不能简单依赖于自身的观测、动作,还需要考虑到其他智能体的观测、动作。因此,MARL 比单智能体强化学习 (Single-Agent Reinforcement Learning,SARL) 更困难。

?

四种设定

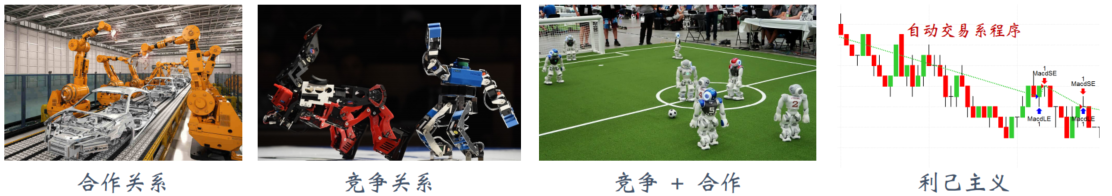

完全合作关系

智能体的利益一致,获得的奖励相同,有共同的目标。

多个工业机器人协同装配汽车。他们的目标是相同的,都希望把汽车装好。假设一共有 m 个智能体,它们在 t 时刻获得的奖励分别是 Rt1, Rt2, · · · , Rtm。

在完全合作关系中,它们的奖励是相同的:

完全竞争关系

一方的收益是另一方的损失。

两个格斗机器人,它们的利益是冲突的,一方的胜利就是另一方的失败。在完全竞争的设定下,双方的奖励是负相关的:对于所有的 t,有 Rt1 ∝ ?Rt2。如果是零和博弈,双方的获得的奖励总和等于 0 :Rt1 = ?Rt2。

合作竞争的混合

智能体分成多个群组;组内的智能体是合作关系,它们的奖励相同;组间是竞争关系,两组的奖励是负相关的。

比如足球机器人:两组是竞争关系,一方的进球是另一方的损失;而组内是合作关系,队友的利益是一致的。

利己主义

一个智能体的动作会改变环境状态,从而让别的智能体受益或者受损。利己主义的意思是智能体只想最大化自身的累计奖励,而不在乎他人收益或者受损。

比如股票自动交易程序可以看做是一个智能体;环境(股市)中有多个智能体。这些智能体的目标都是最大化自身的收益,因此可以看做利己主义。

Remark

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!