为什么深度学习神经网络可以学习任何东西

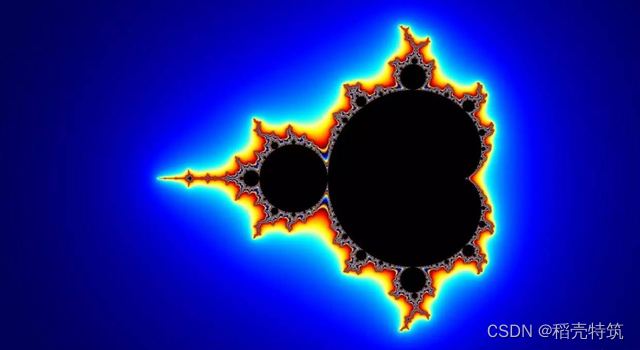

下图你所看到的,是著名的曼德尔布罗特集,我们可以见证这个集合呈现出的复杂形态:

????????要理解神经网络如何学习曼德尔布罗特集,我们首先需要从最基础的数学概念讲起:什么是函数?函数本质上是一个将输入转化为输出的系统,即从数字到数字的映射。在这里,您输入一个x值,系统就会输出一个y值。我们可以在图表上绘制所有x和y值,形成一条连续的线。重要的是,只要知道了这个函数,就可以针对任意输入x计算出对应的输出y。

?????????但如果我们不知道具体的函数形式,仅仅知道某些x和y值,我们是否能对这个未知函数进行反向推理?如果能构造出这样一个函数,我们就可以用它来估算出不在原始数据集中的x值所对应的y值。即便我们的数据包含一些噪声或随机性,我们仍然能够捕捉到数据的整体模式,从而生成接近真实但不完美的y值。我们需要的,就是一个能够近似真实函数的方法。更具体地说,这正是神经网络所做的。

????????在探讨神经网络如何学习的过程中,我们首先遇到了一个基本问题:如果我们不完全知道一个函数的形式,只知道它的部分输入和输出值,我们能否对这个函数进行逆向工程?如果能够构造出这样一个函数,那么我们就可以利用它来估算那些不在原始数据集中的输入值所对应的输出值。即便我们手头的数据存在一些随机噪声,我们依然能够捕捉到其中的整体模式,并生成接近真实的输出值,虽然可能不完美。我们所需的,正是一种能近似真实函数的方法,而这正是神经网络的核心功能。

????????神经网络,从本质上讲,就是一个函数逼近器。它由一系列相互连接的神经元组成,每个神经元都可以接收来自前一层的输入,并产生输出,再传递给下一层。每个神经元的输出不仅仅是输入的简单传递,它是输入经过权重调整、加总并通过激活函数处理后的结果。这些权重和偏差是神经网络学习的关键,它们决定了网络如何响应不同的输入。

????????通过对这些权重和偏差的不断调整,神经网络能够逐渐学习并逼近复杂的函数。这个过程中,网络不断地尝试、出错、调整,最终找到一种方式,使得它的输出尽可能地接近于真实的函数值。这就是神经网络的魔力所在——它能够学习并模拟出极其复杂的数据模式和函数关系。

????????在深入了解神经网络如何逼近复杂函数之前,我们首先要认识到其核心——非线性激活函数,如ReLU。这种激活函数的引入,极大地增强了网络处理复杂任务的能力。神经元通过加权输入和偏置调整,生成输出并传递给下一层,这一过程是网络学习的基础。随着学习的进行,网络不断调整其权重和偏置,逐步形成能够区分不同数据点的决策边界。这不仅显示了网络的强大适应性,也体现了它在处理多样化数据集时的多功能性.

????????在神经网络的学习旅程中,非线性激活函数,发挥着至关重要的作用。这些函数为网络提供了处理复杂问题的必要工具,使得原本只能通过线性组合处理的简单任务得以跨越到处理更高级别的复杂模式。网络通过增加神经元数量,逐步构建能够捕捉复杂数据集的能力,从而有效地逼近所需的目标函数。这一过程不仅揭示了神经网络处理复杂性的能力,而且展现了其学习和逼近目标函数的独特方式。

????????在神经网络的学习过程中,反向传播算法通过逐步调整网络参数来改进函数的逼近效果。尽管神经网络被证明具有普遍的函数逼近能力,能够以任意精度逼近各类函数,但实际应用中仍然面临一些限制。这些限制包括数据量的充足性、网络规模的可行性,以及对已知函数结构的理解程度。尽管如此,神经网络在处理一些对计算机而言极具挑战性的任务上表现出色,特别是在需要直觉和模糊逻辑的领域,如计算机视觉和自然语言处理,神经网络已经彻底改变了这些领域的面貌。

????????一种简单而有力的思考世界的方式,通过结合简单的计算,我们可以让计算机构造任何我们想要的功能,神经网络几乎可以学习任何东西。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!