Baichuan2百川模型部署的bug汇总

发布时间:2024年01月17日

1.4bit的量化版本最好不要在Windows系统中运行,大概原因报错原因是bitsandbytes不支持window,bitsandbytes-windows目前仅支持8bit量化。

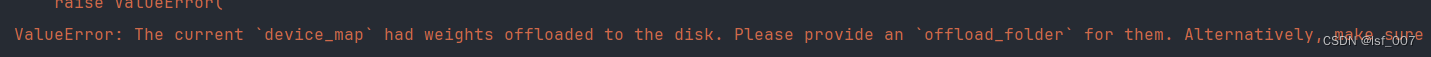

2.

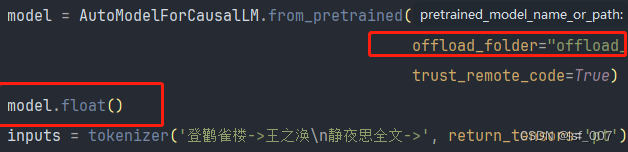

报错原因是机器没有足够的内存和显存,offload_folder设置一个文件夹来保存那些离线加载到硬盘的权重。

ag:需要再cli_demo.py的文件中增加

offload_folder="offload" model.float()

3.安装对应的cuda版本 Python版本 pytorch版本

读者有bug可以在评论区留言,我会尽可能回复解答

文章来源:https://blog.csdn.net/lsf_007/article/details/135643129

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Maxwell&数据同步(增量)

- 一文弄懂vue中样式穿透v-deep

- 【Linux】—— 命名管道详解

- 大语言模型说明书

- 第11章 GUI Page488~489 步骤二十八,二十九 新建画板文件

- 虹科分享丨AR与AI融合加速,医疗护理更便捷!

- 如何在电脑上建立待办事项列表,高效管理每日待办事项?

- comfyUI + animateDiff video2video AI视频生成工作流介绍及实例

- TypeScript基础(四)扩展类型 - 类

- 计算机网络 综合(习题)