腾讯开源AppAgent,手机的大模型智能代理

腾讯研究团队开源了一款基于大语言模型的,用于手机端执行复杂任务的多模态智能代理框架——AppAgent。

据悉,AppAgent的功能与AutoGPT等智能代理类似,不依赖于操作系统的后台访问,而是通过UI界面进行点击、滑动等拟人化操作,与App进行交互操作。

例如,AppAgent可以帮助用户自动填写Gmail内容,并发送邮件。所以,也可以看成手机端的智能RPA(机器人流程自动化)或智能“按键精灵”。

为验证该框架的性能,研究人员在10个不同类别的应用程序上测试了50项任务,涵盖社交媒体、邮件、地图、购物等应用,以及图像编辑等复杂功能。

结果显示, AppAgent适应性强、学习和操作效率高,可以处理不同领域的APP任务。

开源地址:https://github.com/mnotgod96/AppAgent

论文地址: https://arxiv.org/abs/2312.13771

项目地址:https://appagent-official.github.io/

传统的手机助手如Siri,主要是通过系统后端访问和函数调用来实现自动化操作。这种方式有一个很大弊端,就是需要访问用户的隐私、敏感数据,可能会出现很严重的数据安全问题。

而AppAgent采用了一种和RPA类似的方法,通过点击、滑动等模拟方式来操作APP,无需访问任何敏感数据,同时加上了大语言模型的理解和学习能力,使其效果更加出色以及增强适配性。

多种学习模式

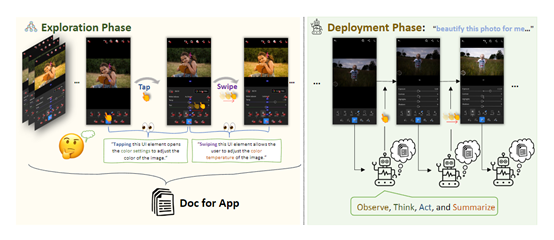

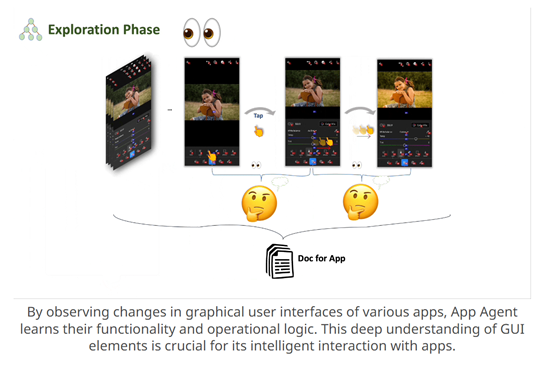

为了增强AppAgent的学习和适配能力,采用了自主探索和观察人类示范两种模式,也是AppAgent的核心模块之一。

1)自主探索,在这个过程中,AppAgent与应用程序进行交互,并尝试执行各种操作,例如,点击按钮、滑动屏幕等。

通过与应用程序的交互,代理能够观察到不同的反馈和结果,并从中学习到如何正确地操作应用程序。这种自主探索的学习方法使代理能够逐步积累知识和经验,建立起一个关于应用程序操作的知识库。

2)观察人类示范,AppAgent会观察人类用户在操作应用程序时的准确行为。通过分析和理解人类的示范行为,代理可以学习到正确的应用程序操作方式。

这种观察人类示范的学习方法使代理能够更快地学习和适应新的应用程序,因为它可以直接借鉴人类用户的经验和技巧。也可以理解成大模型中的,人类反馈强化学习过程。(RLHF)

通过这两种学习模式,AppAgent可以学习到应用程序的界面结构、功能和操作规则。这样的学习方法使得代理能够在不同的应用程序之间执行复杂任务,并在真实世界的环境中展示出高效和熟练的操作能力。

视觉理解

这个模块相当于AppAgent的“眼睛”,主要用于接收和识别UI界面元素。首先根据 XML 信息提取每个界面元素的唯一 ID 或自动生成 ID,然后在截图中用透明数字对界面元素进行标注,可有效提高AppAgent操作应用程序流程的准确性。

此外,视觉理解模块还可以利用机器视觉,进行图片对象和语义特征的提取,例如,识别图片内容、界面控件等,为后续的大脑、执行提供支持。

决策和执行模块

执行模块相当于AppAgent的“四肢”,定义了智能代理与界面交互时的基本操作动作,例如,点击、滑动、长按等拟人化触控操作。

执行模块还定义了“输入文本”和“返回上级页面”等辅助操作。这些操作与各应用程序的界面属性匹配,可以很好地完成用户交互模拟,为整个框架提供了一致清晰地交互规范。

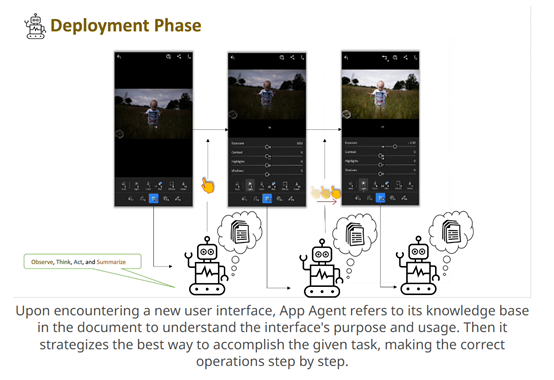

决策模块相当于AppAgent的“大脑”,?在接收到任务指令后,会根据探索文档中的知识库进行任务分析,然后执行。详细流程如下:

1)观察当前界面元素和状态

2)思考下一步应采取的操作

3)执行选择的操作动作

4)总结并记录本轮执行结果

在这个迭代决策过程中,大脑模块会充分利用前面两种学习模式积累的经验,以保证智能代理执行任务的高效性和准确性。

本文素材来源AppAgent论文,如有侵权请联系删除

END

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【数据结构】线性表的知识点全面总结

- windows10 固定电脑IP地址操作说明

- DDR终端匹配电阻的长度多少合适?

- 信息系统应急预案-模板

- 目标检测 - 绘制bounding box

- 【2024年信安第二版教材】信息安全工程师备考资料个人分享版(一)

- c语言笔记_1

- 树莓派ubuntu:默认分辨率太小图形界面中无法修改,如何设置分辨率

- 2007~2016 年税调经纬度及其所处的省市区县乡镇数据

- openal中使用现代C++智能指针管理ffmpeg中裸指针的用法