为什么要多GPU训练神经网络

随着模型的日益复杂和数据规模的不断扩大,多个图形处理单元(GPU)进行数据并行训练已成为提升训练效率和缩短训练时间的关键手段。本文将深入探讨在多GPU环境下进行数据并行训练的原理、实践案例、优化策略以及面临的挑战和最新进展。

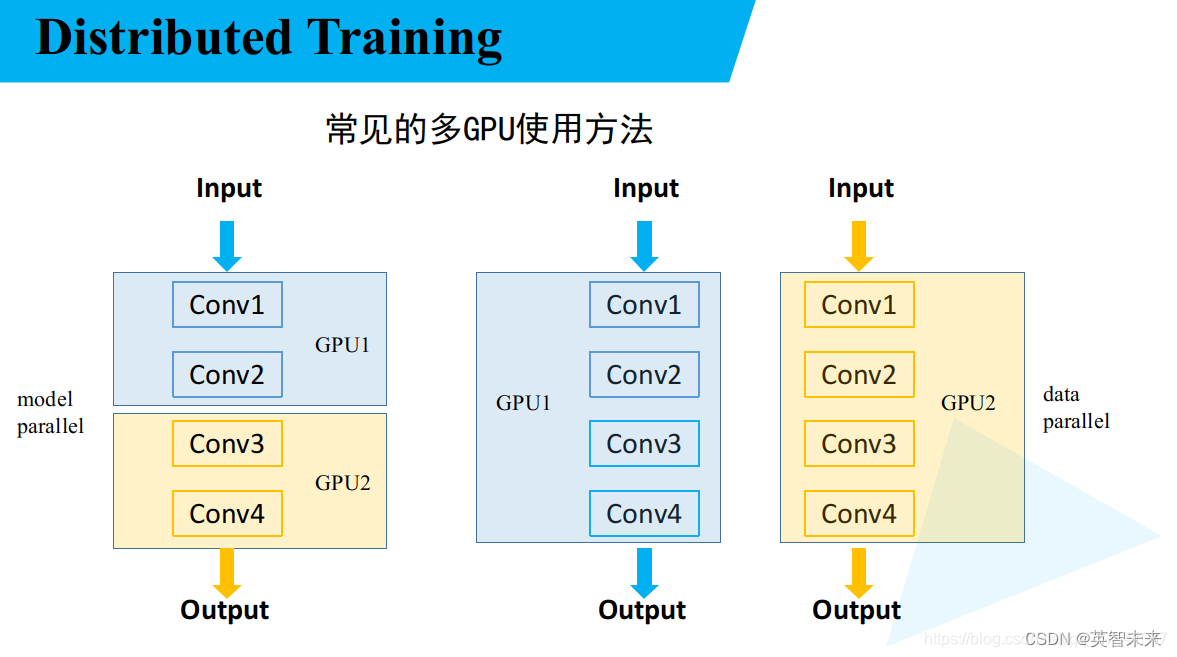

数据并行的核心原理是将大规模的数据集分割成多个小批次,并将它们平行地分配给多个GPU进行处理。这与模型并行不同,后者是将模型本身分割到不同的GPU上。数据并行的优势在于它能有效地利用多个GPU的计算能力,加速神经网络的训练过程。然而,这种方法也带来了诸如数据同步和通信效率等挑战。

在实际应用中,对于如何有效地实施数据并行,有许多值得关注的案例。例如,通过引入一种新的微批次大小搜索算法,优化深度学习中的模型并行。这项技术针对多GPU环境的特点,减少寻找最优微批次大小的开销,并在医学成像领域的U-Net网络上展示了其效果??。

图片来自CSDN

另一个案例涉及图神经网络(GNN)中的数据并行。在GNN的训练过程中,数据并行面临的主要挑战是微批次之间的重叠,导致冗余的数据加载和计算。一些研究聚焦于如何减少这些重叠和优化数据加载过程,以提升在多GPU系统中的训练效率??。

当然,实现高效的数据并行不仅仅是理论上的挑战。在现实世界中,使用深度学习框架如PyTorch和TensorFlow进行多GPU训练同样非常关键。例如,PyTorch提供了丰富的工具和API来支持多GPU训练,这包括但不限于数据并行模块和分布式数据并行模块。TensorFlow则通过Horovod插件实现数据并行,该插件允许轻松扩展现有的TensorFlow代码以支持多GPU训练????。

性能优化是在多GPU环境下进行数据并行训练时的另一项重要议题。例如,弱扩展和强扩展是衡量并行系统性能的两个关键概念。弱扩展涉及到随着处理器数量的增加相应增加问题规模,而强扩展则是在固定问题规模的情况下增加处理器数量。在实际应用中,找到适合特定应用场景的扩展策略至关重要??。

面对这样的技术背景,我们可以认识到,在多GPU数据并行训练中仍然存在着不少挑战。例如,确保数据在不同GPU间的有效同步、减少网络通信带来的延迟、以及如何平衡负载以避免某些GPU过载而其他GPU空闲等问题。同时,随着技术的不断进步,新的研究和方法也在不断地出现,为数据并行带来更多可能性和解决方案。

创建一个模型实例和检测是否有多个GPU,如果没有GPU资源,可以在BayStone平台查看GPU算力资源的租赁价格:baystoneai.com/airesource

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- BFC块级格式化上下文

- 【docker】docker入门与安装

- C语言指针使用常见问题

- HubSpot线索管理系统怎么样?适合哪些企业?

- 【无标题】- 自用代码 优化资源时常用的备份一个目录

- 谷粒商城-商品服务-品牌管理-阿里云云存储+JSR303数字校验+统一异常处理

- 说说集成学习的四种模型

- 【算法分析与设计】两两交换链表中的节点

- kube-apiserver参数详解

- 15个等轴视图设计的电动车汽车无人机等PR剪辑素材视频制作元素