OR-NeRF论文笔记

OR-NeRF论文笔记

文章目录

论文概述

目的:与RO-NeRF的任务一致,均为3d object removal任务。但他支持单个视图上通过用户给的点或文本提示移除3D物体。

方法:通过三维几何和稀疏对应关系将用户注释扩散到所有视图,从而确保了三维一致性并减轻了处理负担。然后,应用最新的二维分割模型 Segment-Anything (SAM) 来预测mask,并使用二维内绘模型(LaMa)来生成颜色监督。最后,我们的算法应用了深度监督和感知损失,以保持对象移除后几何和外观的一致性。

Abstract

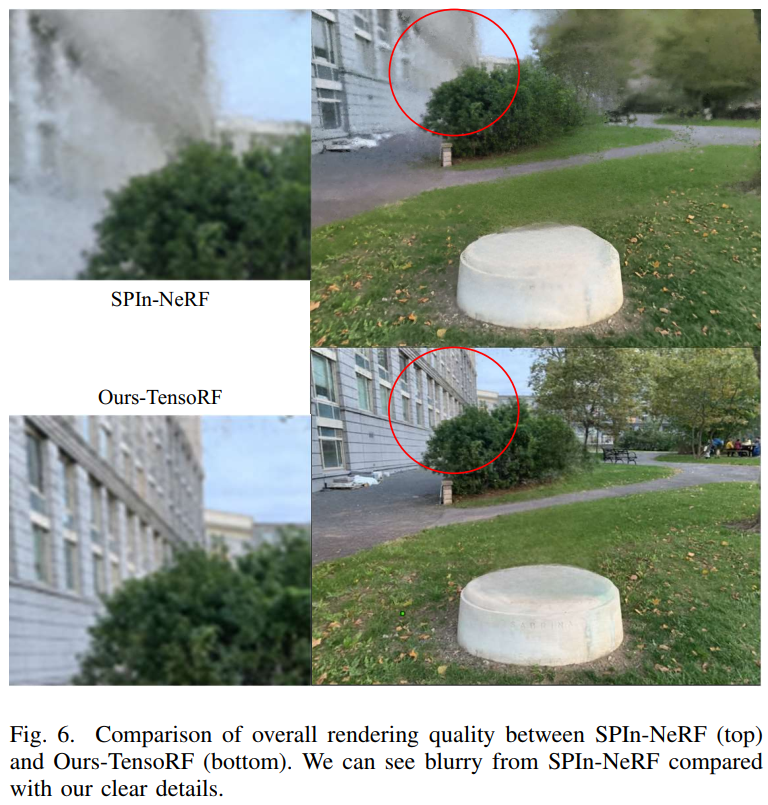

用于新视图合成的神经辐射场(Neural Radiance Fields,NeRF)的出现提高了人们对三维场景编辑的兴趣。编辑的一项基本任务是从场景中移除目标,同时确保视觉合理性和多视图一致性。然而,当前的方法面临着一些挑战,如耗时的对象标记、移除特定目标的能力有限以及移除后的渲染质量受到影响。本文提出了一种名为 ORNeRF 的新型物体移除pipeline,它能在单个视图上通过用户给出的点或文本提示移除三维场景中的物体,与之前的作品相比,能在更短的时间内实现更好的性能。我们的方法通过三维几何和稀疏对应关系将用户注释扩散到所有视图,从而确保了三维一致性并减轻了处理负担。然后,应用最新的二维分割模型 Segment-Anything (SAM) 来预测mask,并使用二维内绘模型(lama)来生成颜色监督。最后,我们的算法应用了深度监督和感知损失,以保持对象移除后几何和外观的一致性。实验结果表明,与之前的研究相比,我们的方法能在更短的时间内实现更好的编辑质量,同时兼顾质量和数量。

1 Introduction

NeRF在重建三维场景方面取得重大成果,最近研究将其功能扩展到三维场景编辑方面,其中一项重要的编辑操作是从三维场景中移除物体。这项任务的实际应用面临一些挑战,主要障碍在于如何准确定位不需要的物体,我们往往很容易对一张图片识别出不需要的物体,但要求用户对每个视图都进行标注是不切实际的。此外,删除后的多视图一致性和内容的合理性也是一个难题。

一些工作尝试解决上述问题,但结果并不令人满意。例如Object-NeRF 和 ObjectSDF对NeRF训练 分解成background和object,从而实现对特定的object进行渲染,然而,由于缺失对移除部分的监督,从而无法确保完成一个合理移除区域。NeRF-Object-Removal(RO-NeRF)和SPIn-NeRF使用了LaMa生成color和depth的先验知识,然后根据这些先验直接进行重建NeRF。虽然这两个方法对编辑质量得到提升,但是,RO-NeRF需要所有视角下的mask作为输入;而SPIn-NeRF使用一系列分割预处理,甚至涉及到网络训练,花大量时间为每个场景生成masks。DFFs应用了预训练的语言模型支持text-prompt编辑,通过从语言模型中提取出的向量特征在训练NeRF中对齐,可以消除对masks的依赖。但是,如果预训练的目标检测器效果不好,它将无法定位移除的区域。

我们提出了一个新的pipeline叫OR-NeRF,支持对单个图像的点和文本prompt,从3D场景中提出物体。优点在于多视角分割任务耗时更少,移除物体任务的效果优于以往方法。具体方法如下:

- Points prompt on a single view to other views: a point projection strategy by using COLMAP sparse reconstruction to find correspondences from 2D points to 3D sparse point cloud, and further projects 3D points to all 2D images with camera parameters.

- Use SAM to predict masks.

- Use 2D inppainting model LaMa to get color priors for the removal area.

- Scene object removal algorithm using TensoRF(backbone) with depth supervision and perceptual loss.

TensoRF is a SOTA model for improving rendering quality considering time and performace trade-off.

Time consuming: Generated at approximately two frames per second on an RTX 3090 GPU.

我们在多样的数据集上测试了多视角分割和场景物体移除的效果。

Contributions:

- A novel pipeline for efficient object removal from 3D scenes, allowing for both points and text prompts on a single image.

- Experimental results demonstrate that our method achieves better editing quality and requires less time for multiview segmentation than previous methods, as evidenced by both quality and quantity analyses.

2 Related Work

- Multiview Segmentation

2D分割被研究的很透彻,但3D场景下的分割往往被忽视,尽管它像3D编辑这样的下游任务有着关键作用。

- 有几个自监督方法被提出,但他们常常产生不准确的masks,很难应对复杂场景。

- 为了应对这些挑战,半监督策略仅需部分标注,或用户提供一些合理的prompt。

- Semantic NeRF传播这部分labels给稠密语义分割,利用一些in-place就地标注,预测语义label并渲染。

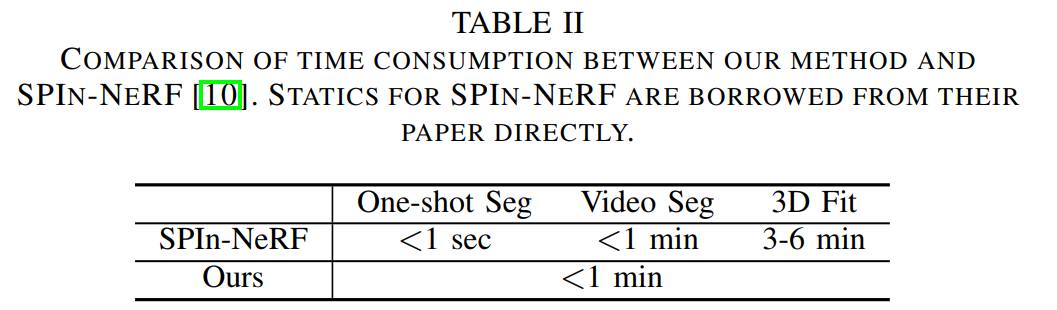

- NeRF和SPIn-NeRF进一步创建了一个完整的pipeline,利用一张图上的points prompt在所有视角生成Masks。它们利用了one-shot分割去预测一个初始的mask,再根据video分割去生成所有视角的masks,通过视图像序列为一个video。最后,他们利用semantic NeRF对masks进行refine。

- 然而,以上提到的方法需要训练网络,消耗过多资源,无法保证一个准确的mask,复杂的框架往往会积累错误

- Scene Object Removal

NeRF有很多3D场景编辑的任务,往往聚焦在多种多样的编辑类型,包括了纹理编辑、几何编辑、物体-中心编辑,如移除物体、甚至是多种操纵方式。

- Object-NeRF和ObjSDF

- 分解了NeRF training为背景和物体两个分支,支持对特定的物体进行渲染(通过设定物体ID)。

- 但是他们会在移除区域生成黑色空洞,因为在训练过程中没有对删除部分的监督/先验知识。

- NeRF-In [37], NeRF-ObjectRemoval [9], and SPIn-NeRF

- 利用了2D inpainting方法LaMa获取移除部分的先验知识,在删除物体后直接由这些先验知识重建场景。

- 虽然实现了更好的渲染效果,但这些方法需要较高的preconditions,例如标注/生成所有视角的masks,这需要依赖昂贵的时间和硬件资源。

- Combine pre-trained language models

- 支持text-prompt的编辑方式,因此不对masks有需求。

- 但是,移除区域的渲染效果很差,因为没有算法学习删除后的pixel value。

3 Background

- NeRF

- SPIn-NeRF

- 用户对一个视角标注一组点。

- 结合一系列系列分割方法获得所有视角下的masks。

- 使用2D inpainting model LaMa进行mask生成color和depth的先验。

- 删除物体后的场景将由改进后的NeRF(depth监督+感知loss)与这些先验直接对其重建。

4 Method

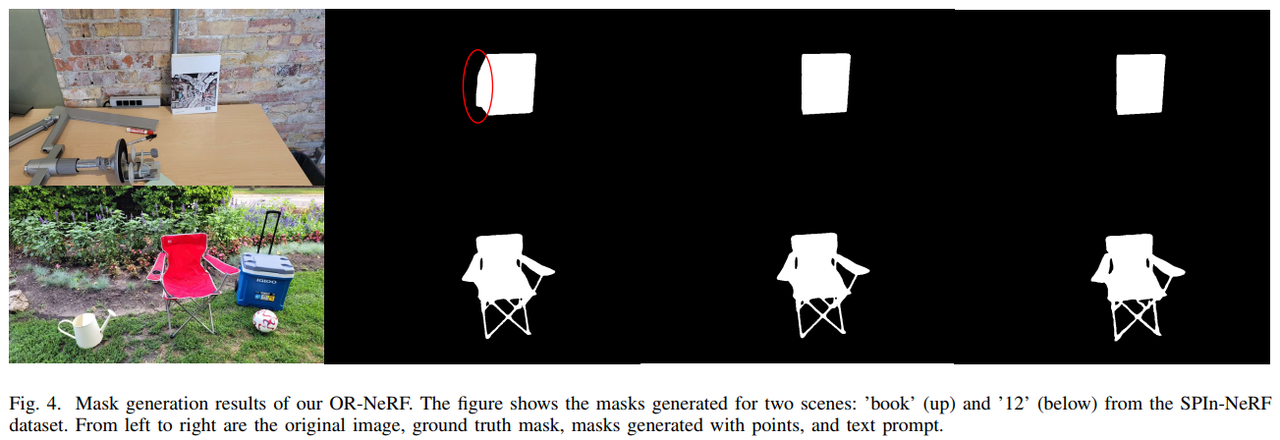

4.1 Multiview Segmentation

[通俗易懂]

4.2 Scene Object Removal

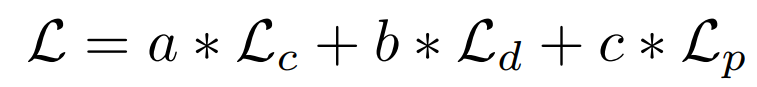

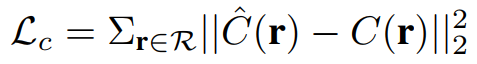

- Color Loss

-

-

R表示训练的批量大小。两个C (r) 分别是GT和rendered的RGB图像的pixels。

-

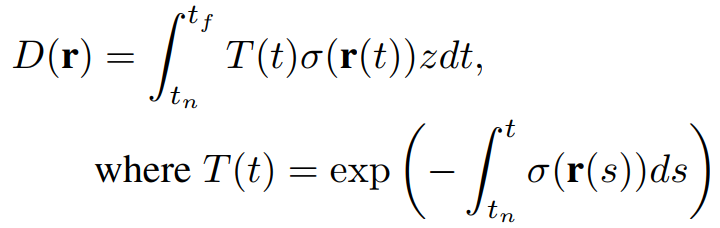

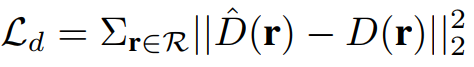

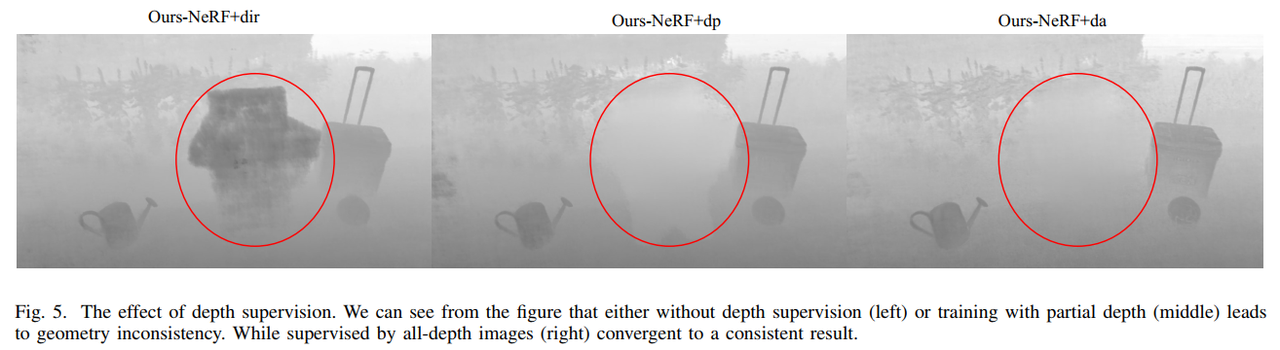

- Depth Loss(geometric consistency)

-

-

-

z表示从当前3D位置到相机位置的距离。

-

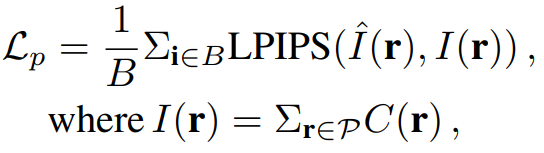

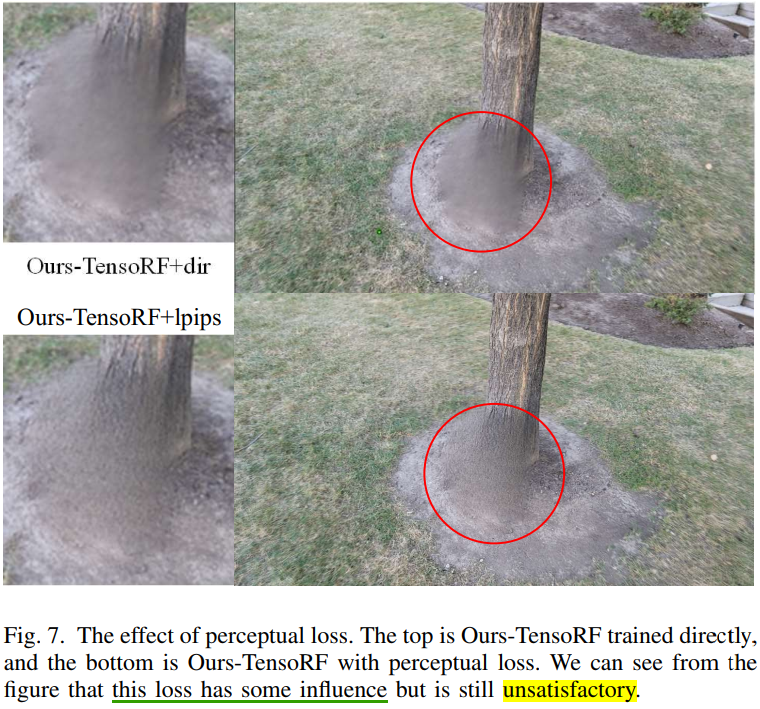

- Perceptual Loss(exhibit inconsistency)

-

-

聚焦于masked区域的perceptual loss。

-

5 Experiments

Datasets

- 从不同的3D重建数据集中选择12个场景,包括了NeRF LLFF data, IBRNet data [51], and LLFF real-world data。场景选择时包含了不同类型的场景和不同的移除操作类型(例如slogans的灵活度很高)。

- 由于3D重建数据集中不包含物体masks的GT,我们将SPIn-NeRF数据集合并,它包含了人工打标的物体masks以及物体移除后的场景。

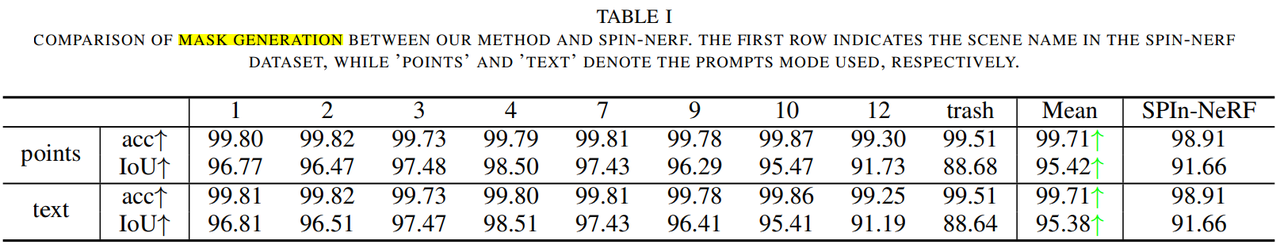

- 对于多视角分割的评估,利用了SPIn-NeRF数据集中所有的10个场景。

- 对于场景物体移除的评估,利用了SPIn-NeRF数据集中的8个场景(删除两个重复场景,确保物体的布局多样化)

Metrics

- 多视图分割任务的指标

- Acc(pixel-wise accuracy):预测类别正确的像素数占总像素数的比例。

- IoU(intersection over union):交并比。

- 3D场景物体移除任务的指标(与移除后的GT对比)

- PSNR(peak signalto-noise ratio):峰值信噪比

- LPIPS(learned perceptual image patch similarity):感知图像块相似性

- FID(Frechet inception distance):FID 分数

Multiview Segmentation

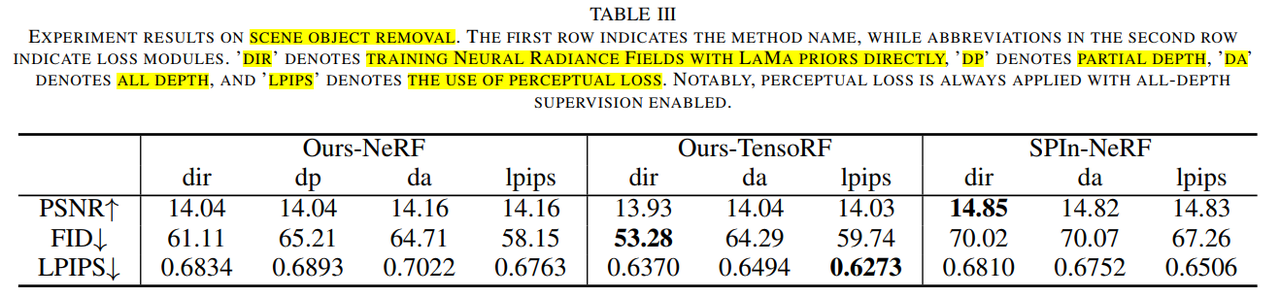

Scene Object Removal

- dir:直接用LaMa先验训练NeRF

- dp:部分深度

- da:全部深度

- lpips:全部深度+使用感知损失

6 Conclusion

- 针对3D场景下的物体移除任务,提出了一个新的pipeline OR-NeRF,支持对单个视角的点/文本prompt。

- 强调了方法在渲染质量和时间消耗上的优势。

- 缺点是inpainting model的能力,更鲁棒的2D图像修复技术,例如基于diffusion的方法能够实现更合理的物体修复结果。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- <四>Python的判断语句和循环语句

- 移动端 h5-table react版本支持虚拟列表

- MILP加速运算技巧——模型对称性的预处理

- C语言:被5整除问题

- 算法导论复习 (九) 基本图算法

- 人性的弱点:如何交友并影响他人

- LDAP密码加密字符串生成器slappasswd命令的详细使用方法

- C++共享和保护——(5)编译预处理命令

- Linux——搭建KVM环境

- shopee最新选品:Shopee平台上的最新选品策略和方法